ホームページ >テクノロジー周辺機器 >AI >Transformer は脳を模倣し、脳画像の予測において 42 モデルを上回っており、感覚と脳の間の伝達もシミュレートできます。

Transformer は脳を模倣し、脳画像の予測において 42 モデルを上回っており、感覚と脳の間の伝達もシミュレートできます。

- 王林転載

- 2023-04-11 21:16:211246ブラウズ

多くの AI アプリケーション モデルでは、モデル構造:

Transformer について言及する必要があります。

従来の CNN と RNN を放棄し、完全にアテンション メカニズムで構成されています。

Transformer は、さまざまな AI アプリケーション モデルに記事や詩を書く機能を提供するだけでなく、マルチモーダルな側面でも優れています。

特に ViT (Vision Transformer) のリリース後、CV と NLP の間のモデルの壁が壊れ、1 つの Transformer モデルだけがマルチモーダル タスクを処理できます。

(これを読んだ後では、それがどれほど強力であるかは誰にもわかりません)

Transformer はもともと言語タスク用に設計されましたが、脳を模倣するという大きな可能性も秘めています。

いいえ、サイエンス ライターが Transformer がどのように脳をモデル化するかについてブログを書きました。

彼はカンカンに来たとき何と言ったでしょうか?

トランスフォーマー: 脳の働きをする

まず、その進化の過程を整理する必要があります。

トランスフォーマー メカニズムは 5 年前に初めて登場しましたが、これほど強力なパフォーマンスを発揮できるのは主にセルフ アテンション メカニズムによるものです。

Transformer がどのように脳を模倣するかについては、読み続けてください。

2020 年、オーストリアのコンピューター科学者 Sepp Hochreiter の研究チームは、Transformer を使用してホップフィールド ニューラル ネットワーク (記憶検索モデル、HNN) を再編成しました。

実際、ホップフィールド ニューラル ネットワークは 40 年前に提案されており、研究チームが数十年を経てこのモデルを再構成することにした理由は次のとおりです:

まず、このネットワークは A に従います。一般規則: 同時に活動しているニューロンは、互いに強い接続を確立します。

第二に、ホップフィールド ニューラル ネットワークは、メモリを取得するプロセスとトランスフォーマーのセルフ アテンション メカニズムの実装に一定の類似点があります。

そこで研究チームは、より多くの記憶を保存したり検索したりできるように、ニューロン間のより良い接続を確立するために HNN を再編成しました。

再編成のプロセスは、簡単に言うと、Transformer のアテンション メカニズムを HNN に統合し、元の不連続な HNN が連続状態になるようにすることです。

△出典: Wikipedia

再編成されたホップフィールド ネットワークは、元の入力データの保存とアクセスを可能にするレイヤーとしてディープ ラーニング アーキテクチャに統合できます。 、中間結果など。

したがって、ホップフィールド自身と MIT ワトソン人工知能研究所のドミトリー クロトフは両方とも次のように述べています:

Transformer に基づくホップフィールド ニューラル ネットワークは生物学的に合理的です。

これは脳の仕組みにある程度似ていますが、いくつかの点で十分正確ではありません。

そこで、計算神経科学者のウィッティントンとベーレンスは、ホッホライターの方法を採用し、再編成されたホップフィールド ネットワークにいくつかの修正を加え、脳内の神経発火パターンの複製などの神経科学タスクにおけるモデルのパフォーマンスをさらに向上させました。)パフォーマンス。

△Tim Behrens (左) James Whittington (右) 出典: quantamagazine

簡単に言うと、エンコードとデコード中に、モデルはもはや代わりにメモリを線形シーケンスとしてエンコードする場合、メモリを高次元空間の座標としてエンコードします。

具体的には、TEM (Tolman-Eichenbaum Machine) をモデルに導入します。

TEM は、海馬の空間ナビゲーション機能を模倣するために構築された連想記憶システムです。

空間的および非空間的構造知識を一般化し、空間的および連想記憶課題で観察されるニューロンのパフォーマンスを予測し、海馬と嗅内皮質における再マッピング現象を説明することができます。

非常に多くの機能を持つTEMとTransformerを統合してTEM-transformer (TEM-t)を形成します。

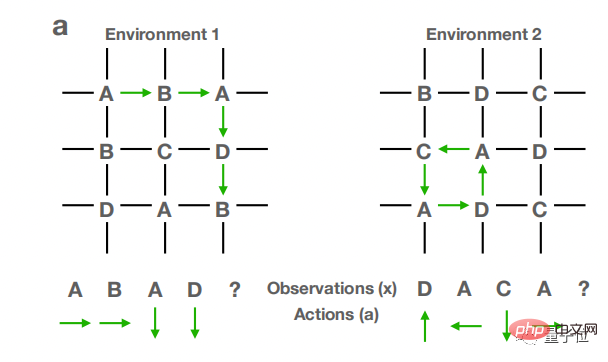

次に、TEM-t モデルを複数の異なる空間環境で学習させます。環境の構造は次の図に示すようになります。

TEM-t には、Transformer の Self-attention メカニズムがまだ残っています。このようにして、モデルの学習結果を新しい環境に転送し、新しい空間構造を予測するために使用できます。

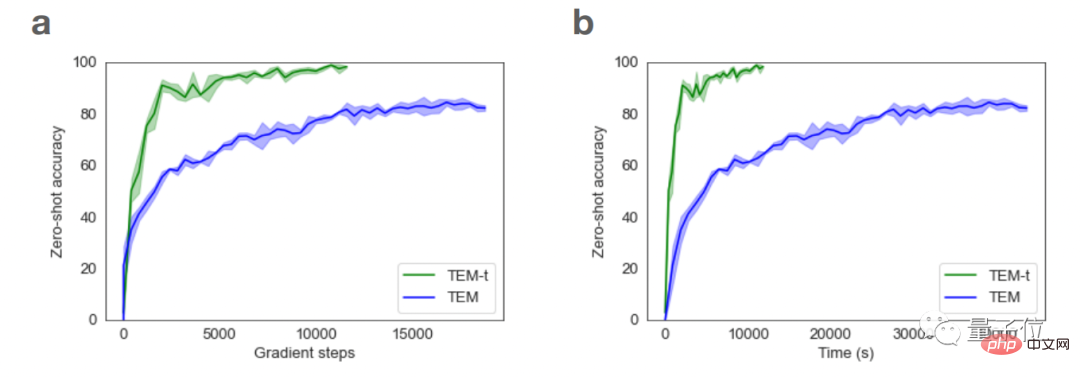

研究では、TEM と比較して、TEM-t は神経科学タスクの実行においてより効率的であり、より少ない学習サンプルでより多くの問題を処理できることも示しています。

Transformer は、脳パターンの模倣においてますます深みを増しており、言い換えれば、Transformer パターンの開発は、脳機能の動作原理の理解を常に促進するものでもあります。

それだけでなく、いくつかの側面では、Transformer は脳の他の機能についての理解を向上させることもできます。

Transformer は脳の理解に役立ちます

たとえば、計算神経科学者の Martin Schrimpf は昨年、43 の異なるニューラル ネットワーク モデルを分析して、人間の神経活動測定への影響を観察しました。 機能的磁気 共鳴の予測力画像(fMRI)および皮質脳波検査(EEG)レポート。

その中でも、Transformer モデルは、画像処理で見られるほぼすべての変化を予測できます。

振り返ってみると、Transformer モデルから対応する脳の機能の動作を予測することもできるかもしれません。

さらに、コンピュータ科学者のYujin Tang氏とDavid Ha氏は最近、Transformerモデルを通じて意識的に大量のデータをランダムかつ無秩序に送信できるモデルを設計し、人体がどのように感覚観察を脳に伝達するかをシミュレートしました。 . .

このトランスフォーマーは人間の脳に似ており、無秩序な情報の流れをうまく処理できます。

Transformer モデルは改良を続けていますが、正確な脳モデルへの小さな一歩にすぎず、最終的に到達するにはさらに詳細な研究が必要です。

Transformer が人間の脳を模倣する方法について詳しく知りたい場合は、以下のリンクをクリックしてください~

参考リンク:

[1]https:// www.quantamagazine.org /how-ai-transformers-mimic-parts-of-the-brain-20220912/

[2]https://www.pnas.org/doi/10.1073/pnas.2105646118

[3]https://openreview.net/forum?id=B8DVo9B1YE0

以上がTransformer は脳を模倣し、脳画像の予測において 42 モデルを上回っており、感覚と脳の間の伝達もシミュレートできます。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。