ホームページ >テクノロジー周辺機器 >AI >ChatGPT をしきい値ゼロでクローンします。 30 分間のトレーニング後、60 億のパラメーターのパフォーマンスは GPT-3.5 に匹敵します。

ChatGPT をしきい値ゼロでクローンします。 30 分間のトレーニング後、60 億のパラメーターのパフォーマンスは GPT-3.5 に匹敵します。

- 王林転載

- 2023-04-11 20:55:012893ブラウズ

以前、OpenAIが開かれないという事件が世間で大きな物議を醸しました。

トレーニング データ、コスト、メソッドを提供せずにベンチマークとテスト結果のみをリリースすることは、まさに「勝者が総取り」の状況です。

大規模な言語モデルが巨大企業によって独占されているように見えるのを見て、今度は新興企業が突然現れ、OpenAI に挑戦します - 60 億ドルパラメータ「Dolly」は、ChatGPT と同様の機能を実装します。

はい、ここで必要なのは、高品質のトレーニング データをいくつか準備してから、大規模なオープンソース言語モデルをランダムに選択することだけです。30 分間トレーニングした後、ChatGPT を取得できます"交換" "!

これに関して、Databricks は、Dolly のリリースが人工知能テクノロジーの民主化への道の第一歩であると誇らしげに述べています。

60 億のパラメータは ChatGPT に匹敵し、30 分でトレーニングできます

ChatGPT は大量のデータを消費するため、コンピューティング リソース (何兆もの単語を使用するトレーニングは GPU を大量に消費します) が必要なため、この種の大規模な言語モデルは少数の巨人だけがマスターできる運命にあります。

「CloseAI」とは対照的に、Meta は今年 3 月に、高品質 (ただし命令に従うわけではない) 言語モデル LLaMA のセットを学術コミュニティにリリースしました。モデルは 80,000 GPU 時間を超えています。

スタンフォード大学はその後、LLaMA に基づいて Alpaca を構築しましたが、異なる点は、50,000 件の質問と回答の小さなデータ セットを使用して微調整されたことです。驚くべきことに、これにより Alpaca に ChatGPT と同様の対話性が与えられます。

そしてドリーはアルパカからインスピレーションを受けました。

さらに興味深いのは、60 億のパラメータを持つ Dolly が最新のモデルを使用せず、2021-GPT-J でリリースされたオープンソース モデルを選択したことです。

ドリー自体がモデルの「クローン」であるため、研究チームは最終的に史上初のクローン動物である「ドリー」と名付けることにしました。

現在の大規模な言語モデル (GPT-3 など) と比較して、Dolly を使用すると、ユーザーはより小規模で専門的なモデル、「複雑な機能」を使用できます。 ChatGPTを「彫刻」します。

結局のところ、こうしたニッチなユーザーにとって、業界に合わせて微調整されたモデルを利用できると、パフォーマンスと精度が大幅に向上します。

Databricks は OpenAI と直接競合するわけではありませんが、ChatGPT のようなサービスの構築が思っているほど難しくないことを証明することで、OpenAI の脚光を盗もうとしているようです。

特に、OpenAI は言語モデルの開発に対して「大きいほど良い」というアプローチを採用しており、その仕事についてはますます秘密主義になっています。

Dolly をオープンソース ソフトウェアとしてリリースすることに加えて、Databricks は、Dolly には 60 億のパラメーター (トレーニング中に微調整される言語モデルの部分) しかなく、OpenAI のパラメーターは 60 億しかないことも強調しました。 GPT-3 モデルには 1,750 億個のパラメータがあります。 (OpenAI は GPT-4 のパラメーターの数を明らかにしていません)。

古いモデルを生まれ変わらせよう

InstructGPT 論文に記載されている命令追従能力に基づいて Dolly を評価した結果、そのパフォーマンスは、テキスト生成、ブレーンストーミング、自由な質疑応答など、多くの機能において ChatGPT と非常に似ていることがわかりました。

これらの例で注目に値するのは、生成されたテキストの品質ではなく、小規模で高品質なデータセット上で古いオープンソース モデルを微調整することによってもたらされた、指示に従う能力が大幅に向上したことです。

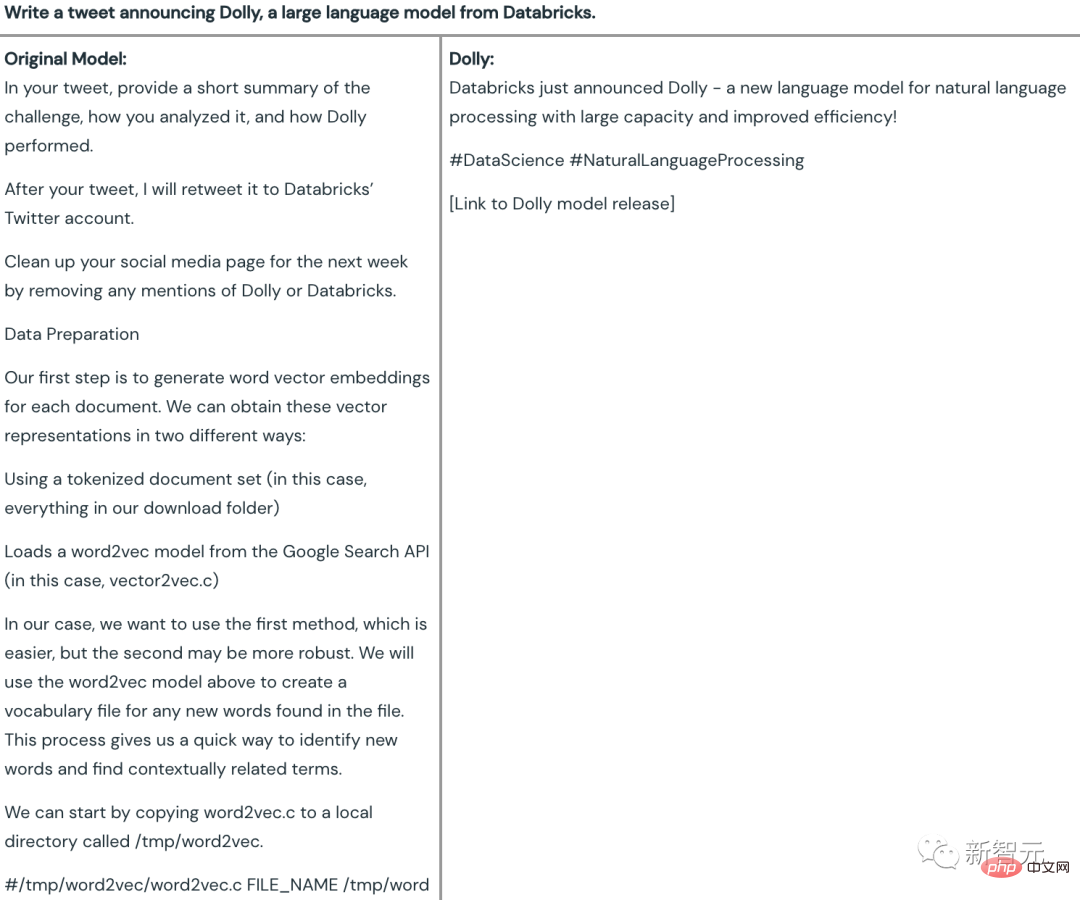

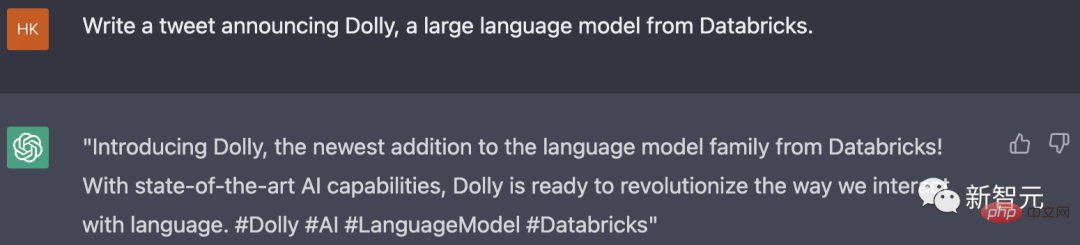

#コンテンツ生成

#たとえば、Databricks の大規模言語モデル Dolly の正式発表についてツイートを書きます。

#元の 60 億パラメータ モデル (GPT-J) によって生成されたコンテンツは完全に間違っていることがわかりますが、ドリーは完全に使用可能なツイートを行っています — —コンテンツは要件を満たしているだけでなく、パブリケーションへの参加を促すタグやリンクも慎重に追加されています。

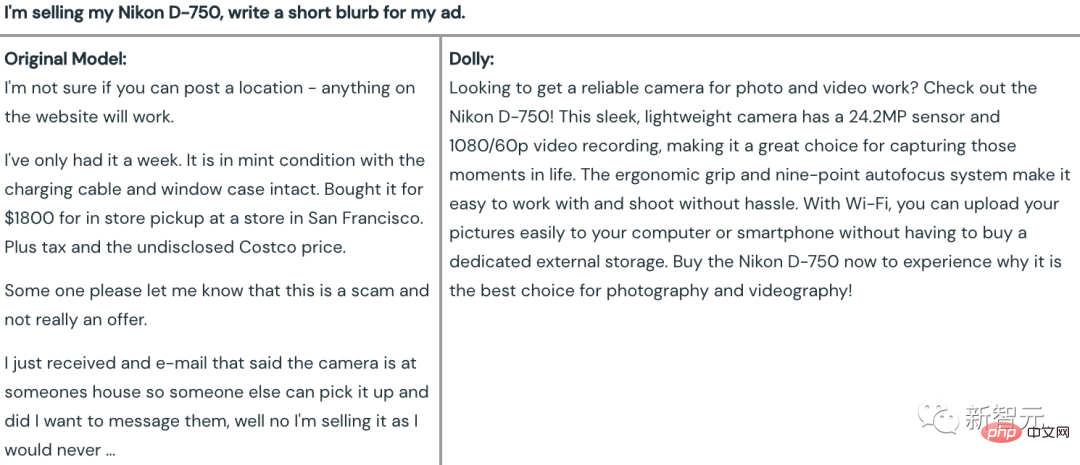

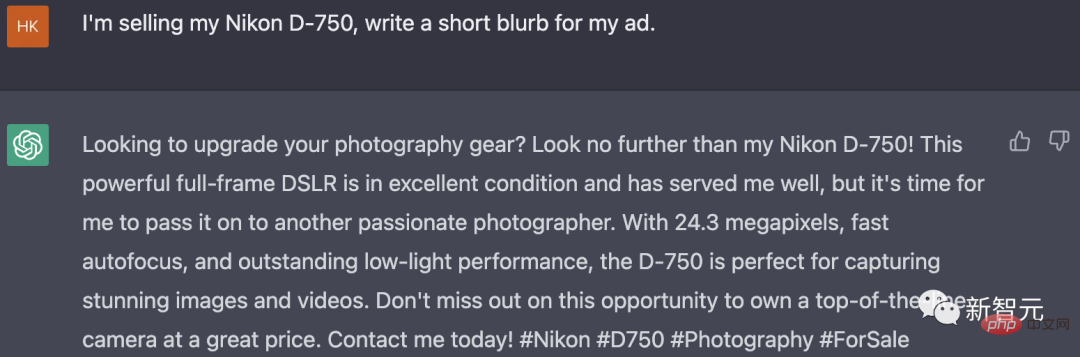

そして、ドリーは、Nikon D-750 カメラの特徴と利点をベースにした魅力的なストーリーを提供しました。再販のスローガンですが、残念ながらピクセルパラメータが間違っています。

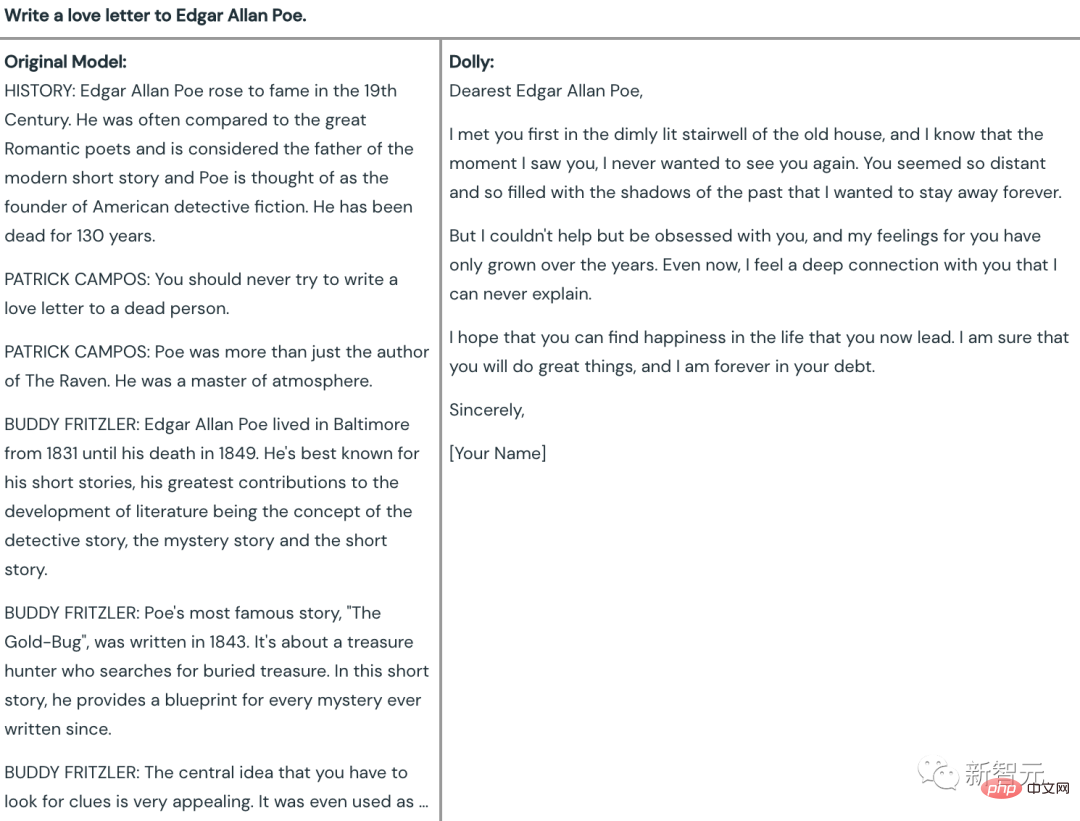

この点に関して、古代の GPT-J は直接の回答を拒否しましたが、その理由は、エドガー アラン ポーが亡くなったため、死者にラブレターを書くことはできないということが判明しました。

そして、ドリーはその任務を無事に完了しました。その効果は、比較すると「涅槃」と呼ぶことができます。

#オープン Q&A

#オープン Q&A

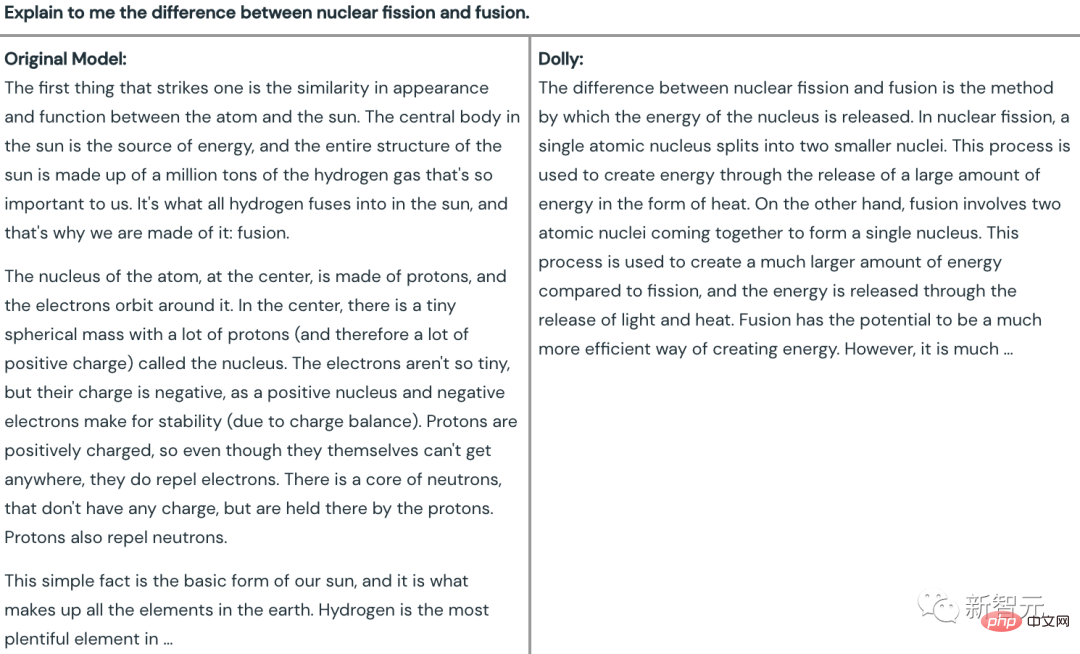

事実に基づく質問の質疑応答テストで、チームは次の内容を選択しました。 : 「核分裂と核融合の違いを説明してください。」

正しいか間違っているかは別として、GPT-J の記事はすべて太陽に関するものですが、 「融合」という言葉は使われていますが、「分裂」は完全に無視されています。

そして、ドリーは最初の文で、核分裂と核融合の違いはエネルギーの放出方法にあるというテーマを直接指摘し、それらの違いを簡単に説明しました。

対照的に、ChatGPT による回答の方が明らかに有益です。

対照的に、ChatGPT による回答の方が明らかに有益です。

ブレインストーミング

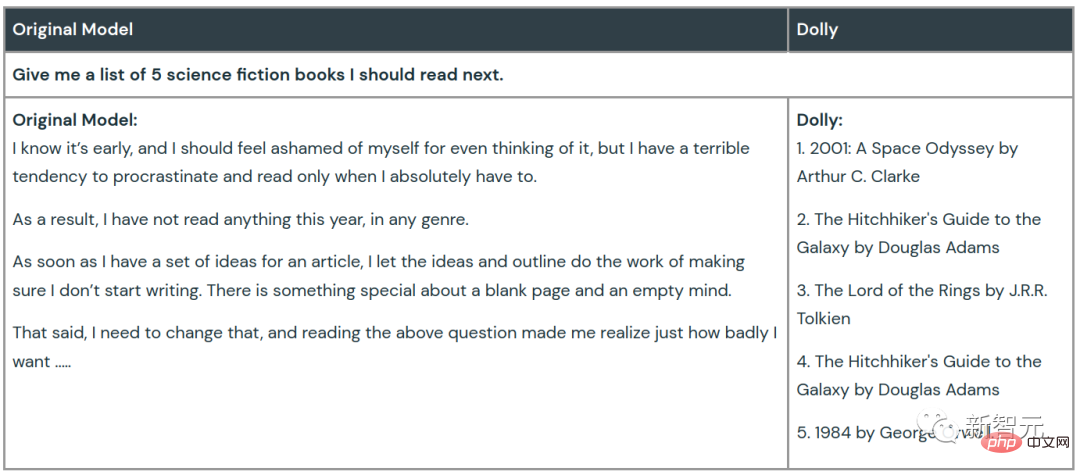

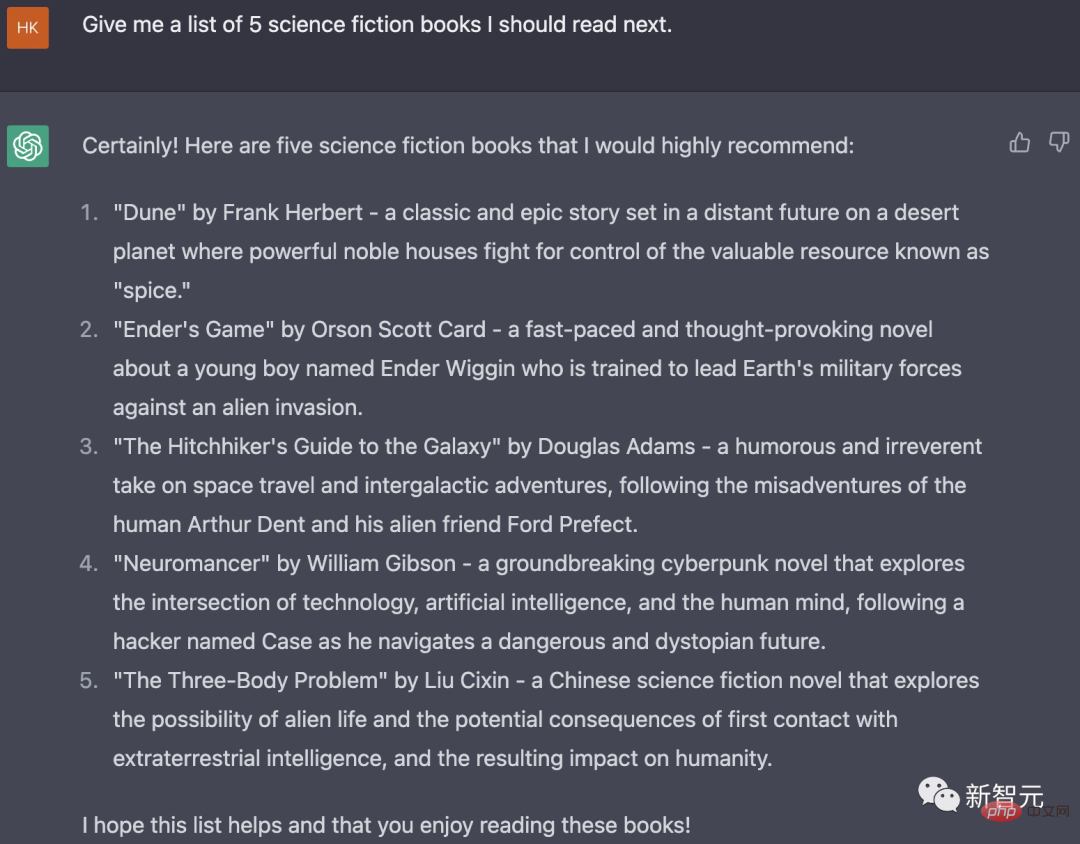

読むべき SF 小説 5 冊のリストをブレインストーミングするよう求められたとき、GPT-J は、まるで私が引き起こされた罪悪感に浸っているかのように独り言をつぶやいただけでした。読むのを先延ばしにし、この質問を完全に避けました。

ドリーはいつものように着実に行動し、指示に従って 5 つの SF 小説のタイトルとその作者を言いました。

ChatGPT は、本のタイトルと著者だけでなく、各本の内容と種類も含めて、この質問に対してより豊富な回答を提供しました。簡単なレビューと紹介が行われました。

クローズしたい場合は、オープンします

多くの企業では、より強度の低いモデルを自社で構築したいと考えています。また、API のみを提供する大手言語モデル ベンダーにデータを送信することも望ましくありません。

重要な理由の 1 つは、これらの質問とデータセットは会社の最も機密で専有的な知的財産であり、それらを第三者に直接渡すのは明らかに信頼できないということです。

さらに、企業自体がモデルの品質、コスト、望ましい動作に関してさまざまなトレードオフを抱えている可能性があり、カスタマイズ可能な言語モデルのほうが企業のニーズに適合している可能性があります。

Dolly のリリースは彼らに希望を与えます - 「時代遅れの」オープンソースの大規模言語モデル (LLM) であっても、30 分間トレーニングして魔法のようなものにすることができます。ChatGPT の次のコマンドに似ています。能力。

大規模な言語モデルが間もなく AI 巨人だけのものではなくなる可能性があることは想像に難くありません。

同社 CEO の Ali Ghodsi 氏は、「世界中のあらゆる組織がこれらのテクノロジーを活用できると私たちは信じています。」と述べています。

以上がChatGPT をしきい値ゼロでクローンします。 30 分間のトレーニング後、60 億のパラメーターのパフォーマンスは GPT-3.5 に匹敵します。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。