近年、強化学習 (RL) は深層学習によって急速に発展しており、ゲームからロボット工学に至るまでの分野におけるさまざまなブレークスルーにより、複雑で大規模な RL アルゴリズムとシステムの設計に対する人々の関心が刺激されています。ただし、既存の RL 研究では一般に、エージェントが新しいタスクに直面したときにゼロから学習できるため、事前に取得した事前知識を使用して意思決定を支援することが困難であり、その結果、高い計算オーバーヘッドが発生します。

教師あり学習の分野では、事前トレーニング パラダイムが、転送可能な事前知識を取得する効果的な方法として検証されています。大規模なデータセットで事前トレーニングすることにより、ネットワークはモデルはさまざまな下流タスクに迅速に適応できます。同様のアイデアが RL でも試行されており、特に「ジェネラリスト」エージェントに関する最近の研究 [1, 2] は、GPT-3 [3] のようなものが RL 分野でも誕生する可能性があるのではないかと人々に疑問に思わせています。モデル。

しかし、RL 分野での事前トレーニングの適用は、上流タスクと下流タスクの大きな違い、事前トレーニング データを効率的に取得して活用する方法、効果的な伝達などの問題により、RL における事前トレーニング パラダイムの適用の成功が妨げられています。同時に、以前の研究で考慮された実験設定と方法には大きな違いがあり、研究者が現実のシナリオで適切な事前トレーニングモデルを設計することが困難になっています。

RL 分野における事前トレーニングの発展と将来の発展の方向性を整理するために、上海交通大学とテンセントの研究者は、さまざまな設定および解決すべき問題の下での既存の RL 事前トレーニング セグメンテーション手法について検討するためにレビューします。

# #RL 事前トレーニングの概要強化学習 (RL) は、逐次的な意思決定のための一般的な数学的形式を提供します。 RL アルゴリズムとディープ ニューラル ネットワークを通じて、データ駆動型の方法で学習し、指定された報酬関数を最適化するエージェントは、さまざまな分野のさまざまなアプリケーションで人間のパフォーマンスを超えるパフォーマンスを達成しました。ただし、RL は特定のタスクを解決するのに効果的であることが証明されていますが、サンプル効率と一般化能力が依然として現実世界での RL の適用を妨げる 2 つの大きな障害となっています。 RL 研究における標準的なパラダイムは、エージェントが自身または他者によって収集された経験から学習し、単一タスクのランダムな初期化を通じてニューラル ネットワークを最適化するというものです。対照的に、人間の場合、世界についての事前知識は意思決定のプロセスに大きく役立ちます。タスクが以前に見たタスクに関連している場合、人間は、最初から学習することなく、すでに学習した知識を再利用して新しいタスクにすぐに適応する傾向があります。したがって、人間と比較して、RL エージェントはデータ効率が低く、過剰適合する傾向があります。

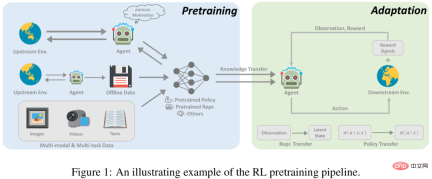

ただし、機械学習の他の分野における最近の進歩では、大規模な事前トレーニングから構築された事前知識の活用が積極的に推奨されています。幅広いデータで大規模にトレーニングすることにより、大規模な基礎モデルをさまざまな下流タスクに迅速に適応させることができます。この事前トレーニングと微調整のパラダイムは、コンピューター ビジョンや自然言語処理などの分野で効果的であることが証明されています。ただし、事前トレーニングは RL 分野に大きな影響を与えていません。このアプローチは有望ですが、大規模な RL 事前トレーニングの原則を設計するには多くの課題に直面しています。 1) ドメインとタスクの多様性、2) 限られたデータソース、3) 下流タスクの解決の難しさへの迅速な適応。これらの要因は RL の固有の特性から生じるものであり、研究者による特別な考慮が必要です。

事前トレーニングには RL にとって大きな可能性があり、この研究はこの方向に興味がある人にとっての出発点として役立ちます。この記事では、研究者らは深層強化学習に関する既存の事前トレーニング作業の体系的なレビューを実施しようと試みています。

近年、深層強化学習の事前トレーニングにはいくつかの画期的な進歩がありました。まず、AlphaGo では、専門家のデモンストレーションに基づく事前トレーニング (教師あり学習を使用して専門家がとった行動を予測する) が使用されています。教師なしの大規模事前トレーニングを追求するため、教師なし RL の分野が急速に成長しています。これにより、エージェントは報酬信号なしで環境とのインタラクションから学習できるようになります。さらに、オフライン強化学習 (オフライン RL) の急速な発展により、研究者はラベルなしの次善のオフライン データを事前トレーニングに使用する方法をさらに検討するようになりました。最後に、マルチタスクおよびマルチモーダル データに基づくオフライン トレーニング方法により、一般的な事前トレーニング パラダイムへの道がさらに開かれます。

オンライン事前トレーニング

これまで、RL の成功は、緻密で適切に設計された報酬関数によって達成されていました。多くの分野で大きな進歩を遂げてきた従来の RL パラダイムは、大規模な事前トレーニングに拡張する際に 2 つの重要な課題に直面します。まず、RL エージェントは過剰適合しやすく、複雑なタスク報酬で事前トレーニングされたエージェントが、これまで見たことのないタスクで優れたパフォーマンスを達成するのは困難です。さらに、報酬関数の設計は通常非常に費用がかかり、多くの専門知識が必要となるため、実際には間違いなく大きな課題です。

報酬信号を使用しないオンライン事前トレーニングは、人間の関与なしに普遍的な事前知識と教師付き信号を学習するための利用可能なソリューションとなる可能性があります。オンライン事前トレーニングは、人間の監督なしで環境との対話を通じて事前知識を獲得することを目的としています。事前トレーニング段階では、エージェントは長時間環境と対話することができますが、外部報酬を受け取ることはできません。このソリューションは教師なし RL とも呼ばれ、近年研究者によって積極的に研究されています。

エージェントが監視信号なしで環境から事前知識を取得するように動機付けるために、成熟した方法は、エージェントがそれを促す固有の報酬を設計することです。エージェントは、さまざまな情報を収集することで、それに応じて報酬メカニズムを設計します。経験や応用可能なスキルの習得。これまでの研究では、固有の報酬と標準的な RL アルゴリズムを使用したオンライン事前トレーニングを通じて、エージェントが下流のタスクに迅速に適応できることが示されています。

オフライン事前トレーニング

オンライン事前トレーニングは人間の監督なしでも良好な事前トレーニング結果を達成できますが、大規模な場合は-規模のアプリケーションでは、オンライン事前トレーニングはまだ制限されています。結局のところ、オンラインでのやり取りは、大規模で多様なデータセットでトレーニングする必要性とある程度相互排他的です。この問題を解決するために、データ収集と事前トレーニングのリンクを切り離し、他のエージェントや人間から収集した履歴データを事前トレーニングに直接使用したいと考えることがよくあります。

#実行可能な解決策は、オフライン強化学習です。オフライン強化学習の目的は、オフライン データから報酬を最大化する RL ポリシーを取得することです。基本的な課題は、分布シフトの問題、つまりトレーニング データとテスト中に見られるデータの間の分布の違いです。既存のオフライン強化学習手法は、関数近似を使用する際にこの課題を解決する方法に焦点を当てています。たとえば、ポリシー制約メソッドは、データセットに見られないアクションの実行を回避するために、学習されたポリシーを明示的に要求します。また、値正則化メソッドは、値関数を何らかの形式の下限に適合させることによって、値関数の過大評価の問題を軽減します。ただし、オフラインでトレーニングされた戦略が、オフライン データセットでは見られない新しい環境に一般化できるかどうかは、まだ調査されていません。

おそらく、RL ポリシーの学習を回避し、代わりにオフライン データを使用して、下流タスクの収束速度や最終パフォーマンスに有益な事前知識を学習することができます。さらに興味深いことに、私たちのモデルが人間の監視なしでオフライン データを活用できれば、大量のデータから恩恵を受ける可能性があります。この論文では、研究者はこの設定をオフライン事前トレーニングと呼び、エージェントはオフライン データから重要な情報 (適切な表現や行動の事前分布など) を抽出できます。

#総合エージェント向け

#総合エージェント向け

以上が深層強化学習の事前トレーニング、オンラインおよびオフラインの調査を体系的にレビューするだけで十分です。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ほとんどが使用されています10 Power BIチャート - 分析VidhyaApr 16, 2025 pm 12:05 PM

ほとんどが使用されています10 Power BIチャート - 分析VidhyaApr 16, 2025 pm 12:05 PMMicrosoft PowerBIチャートでデータ視覚化の力を活用する 今日のデータ駆動型の世界では、複雑な情報を非技術的な視聴者に効果的に伝えることが重要です。 データの視覚化は、このギャップを橋渡しし、生データを変換するi

AIのエキスパートシステムApr 16, 2025 pm 12:00 PM

AIのエキスパートシステムApr 16, 2025 pm 12:00 PMエキスパートシステム:AIの意思決定力に深く飛び込みます 医療診断から財務計画まで、あらゆることに関する専門家のアドバイスにアクセスできることを想像してください。 それが人工知能の専門家システムの力です。 これらのシステムはプロを模倣します

3人の最高の雰囲気コーダーがこのAI革命をコードで分解するApr 16, 2025 am 11:58 AM

3人の最高の雰囲気コーダーがこのAI革命をコードで分解するApr 16, 2025 am 11:58 AMまず第一に、これがすぐに起こっていることは明らかです。さまざまな企業が、現在AIによって書かれているコードの割合について話しており、これらは迅速なクリップで増加しています。すでに多くの仕事の移動があります

滑走路AIのGen-4:AIモンタージュはどのように不条理を超えることができますかApr 16, 2025 am 11:45 AM

滑走路AIのGen-4:AIモンタージュはどのように不条理を超えることができますかApr 16, 2025 am 11:45 AM映画業界は、デジタルマーケティングからソーシャルメディアまで、すべてのクリエイティブセクターとともに、技術的な岐路に立っています。人工知能が視覚的なストーリーテリングのあらゆる側面を再構築し始め、エンターテイメントの風景を変え始めたとき

5日間のISRO AI無料コースを登録する方法は? - 分析VidhyaApr 16, 2025 am 11:43 AM

5日間のISRO AI無料コースを登録する方法は? - 分析VidhyaApr 16, 2025 am 11:43 AMISROの無料AI/MLオンラインコース:地理空間技術の革新へのゲートウェイ インド宇宙研究機関(ISRO)は、インドのリモートセンシング研究所(IIRS)を通じて、学生と専門家に素晴らしい機会を提供しています。

AIのローカル検索アルゴリズムApr 16, 2025 am 11:40 AM

AIのローカル検索アルゴリズムApr 16, 2025 am 11:40 AMローカル検索アルゴリズム:包括的なガイド 大規模なイベントを計画するには、効率的なワークロード分布が必要です。 従来のアプローチが失敗すると、ローカル検索アルゴリズムは強力なソリューションを提供します。 この記事では、Hill ClimbingとSimulについて説明します

OpenaiはGPT-4.1でフォーカスをシフトし、コーディングとコスト効率を優先しますApr 16, 2025 am 11:37 AM

OpenaiはGPT-4.1でフォーカスをシフトし、コーディングとコスト効率を優先しますApr 16, 2025 am 11:37 AMこのリリースには、GPT-4.1、GPT-4.1 MINI、およびGPT-4.1 NANOの3つの異なるモデルが含まれており、大規模な言語モデルのランドスケープ内のタスク固有の最適化への動きを示しています。これらのモデルは、ようなユーザー向けインターフェイスをすぐに置き換えません

プロンプト:ChatGptは偽のパスポートを生成しますApr 16, 2025 am 11:35 AM

プロンプト:ChatGptは偽のパスポートを生成しますApr 16, 2025 am 11:35 AMChip Giant Nvidiaは、月曜日に、AI Supercomputersの製造を開始すると述べました。これは、大量のデータを処理して複雑なアルゴリズムを実行できるマシンを初めて初めて米国内で実行します。発表は、トランプSI大統領の後に行われます

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

SublimeText3 Linux 新バージョン

SublimeText3 Linux 最新バージョン

AtomエディタMac版ダウンロード

最も人気のあるオープンソースエディター

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

VSCode Windows 64 ビットのダウンロード

Microsoft によって発売された無料で強力な IDE エディター