ホームページ >テクノロジー周辺機器 >AI >ジェフ・ディーンの大規模マルチタスク学習SOTAが批判され、再現するには6万ドルかかる

ジェフ・ディーンの大規模マルチタスク学習SOTAが批判され、再現するには6万ドルかかる

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-09 10:31:08991ブラウズ

2021 年 10 月に、Jeff Dean は新しい機械学習アーキテクチャである Pathways を紹介する記事を個人的に書きました。

目的は非常にシンプルで、AI が数万のタスクにまたがり、さまざまな種類のデータを理解し、同時に非常に高い効率でそれを達成できるようにすることです。

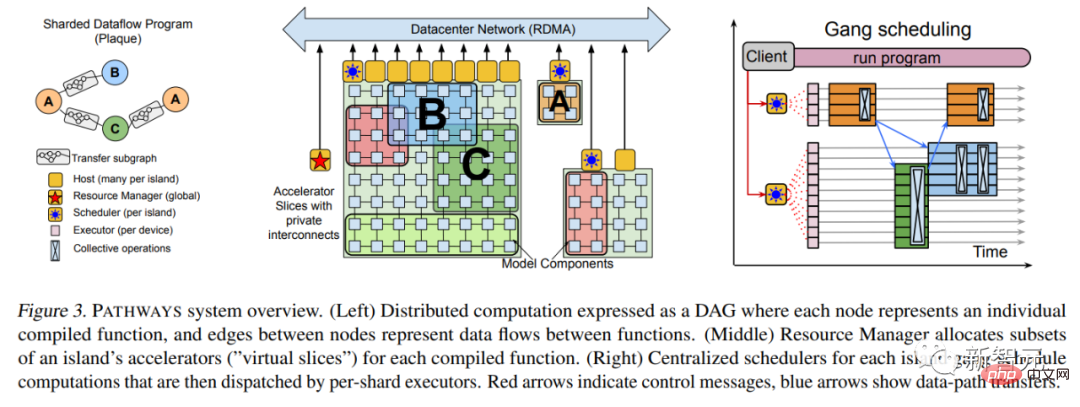

半年以上後の 2022 年 3 月、ジェフ ディーンはついに Pathways の論文を発表しました。

紙のリンク: https://arxiv.org/abs/2203.12533

には、多くの技術情報が追加されます。詳細、最も基本的なシステム アーキテクチャなど。

2022 年 4 月、Google は Pathways の PaLM 言語モデルを使用して出現し、複数の自然言語処理タスクの SOTA を次々と突破しました。この Transformer 言語には 5,400 億のパラメータがあります。このモデルは「力は奇跡を起こすことができる」ことを再び証明しました。

この論文では、強力な Pathways システムの使用に加えて、PaLM のトレーニングでは 6,144 TPU v4 が使用され、7,800 億トークンの高品質データセットと一定の割合が使用されることが紹介されています。そのうちの非英語多言語コーパス。

論文アドレス: https://arxiv.org/abs/2204.02311

最近、Jeff Dean による新しい研究により、 Pathways についてのみんなの推測がさらにかき乱されます。

Pathways パズルのもう 1 つのピースが組み立てられましたか?

この論文の著者は 2 人だけです。有名な Jeff Dean とイタリア人エンジニアの Andrea Gesmundo です。

興味深いのは、ゲスムンドが非常に控えめなだけでなく、2日前にイマージェンを爆破したばかりのジェフ・ディーンがTwitterでまったく言及していないことです。

これを読んだ後、一部のネチズンは、これが次世代 AI アーキテクチャ Pathways のコンポーネントである可能性があると推測しました。

論文アドレス: https://arxiv.org/abs/2205.12755

この記事のアイデア

新しいタスクを大規模な実行システムに動的に組み込むことにより、スパース マルチタスク機械学習モデルの断片を使用して新しいタスクの品質を向上させることができます。関連するタスク間で自動的に共有される モデルのフラグメント。

このアプローチにより、各タスクの品質が向上し、収束時間、トレーニング インスタンスの数、エネルギー消費などの点でモデルの効率が向上します。この記事で提案する機械学習の問題フレームワークは、標準的なマルチタスクおよび継続的学習の形式化を一般化および統合したものとみなすことができます。

このフレームワークの下では、タスクセットがどれほど大きくても、共同で解決できます。

さらに、時間の経過とともに、新しいタスクを継続的に追加することでタスク セットを拡張できます。トレーニング前のタスクと下流のタスクの区別もなくなりました。

新しいタスクが追加されると、システムは既存の知識と表現を新しいモデルの機能と組み合わせて、新しい各タスクの高品質レベルを達成する方法を模索するためです。新しいタスクを解決する際に学習した知識と表現は、今後のタスクで使用したり、既存のタスクの学習を継続したりすることもできます。

この方法は、「ミューテーション マルチタスク ネットワーク」または µ2Net と呼ばれます。 (μ=Mutation)

大規模連続学習実験用の2種類の突然変異モデル

簡単に言うと、複数のタスクを共同で解決するための大規模なマルチタスク ネットワークを生成することです。各タスクの品質と効率が向上するだけでなく、新しいタスクを動的に追加することでモデルを拡張することもできます。

前のタスクからの学習を通じて、より多くの知識がシステムに蓄積されるほど、後続のタスクに対するソリューションの品質が高くなります。

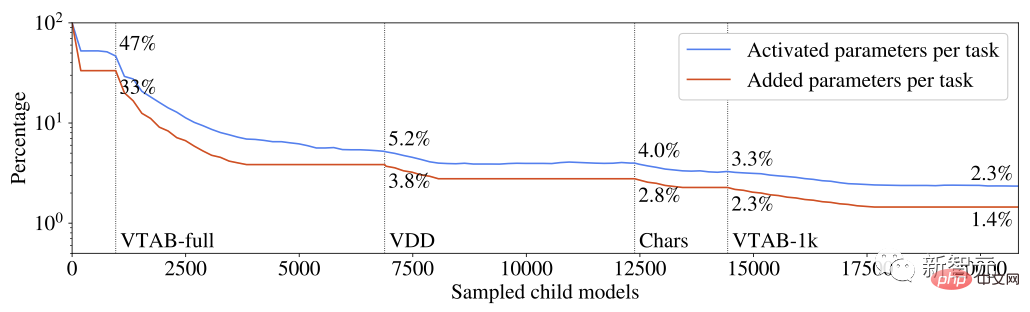

さらに、各タスクに新たに追加されるパラメータを減らすという点で、新しいタスクを解決する効率を継続的に向上させることができます。生成されたマルチタスク モデルはまばらにアクティブ化され、モデルにはタスクベースのルーティング メカニズムが統合されており、モデルが拡張しても各タスクの計算コストの増加は制限されることが保証されます。

各タスクのアクティブ化および増加したパラメータは、マルチタスク システム パラメータの総数の割合を占めます

学習済み各タスクからの知識は、複数のタスクで再利用できる部分に分割されます。実験によれば、このチャンク化手法により、壊滅的な忘却、勾配干渉、負の転送など、マルチタスクおよび継続学習モデルに共通する問題が回避されます。

タスク ルート スペースの探索と各タスクの事前知識の最も関連性の高いサブセットの特定は、探索とエクスプロイトのバランスを動的に調整するように設計された進化的アルゴリズムによって導かれます。メタパラメータを手動で調整する必要があります。同じ進化ロジックを使用して、ハイパーパラメーター マルチタスク モデル コンポーネントを動的に調整します。

「突然変異ネットワーク」と呼ばれていますが、この突然変異をどのように説明しますか?

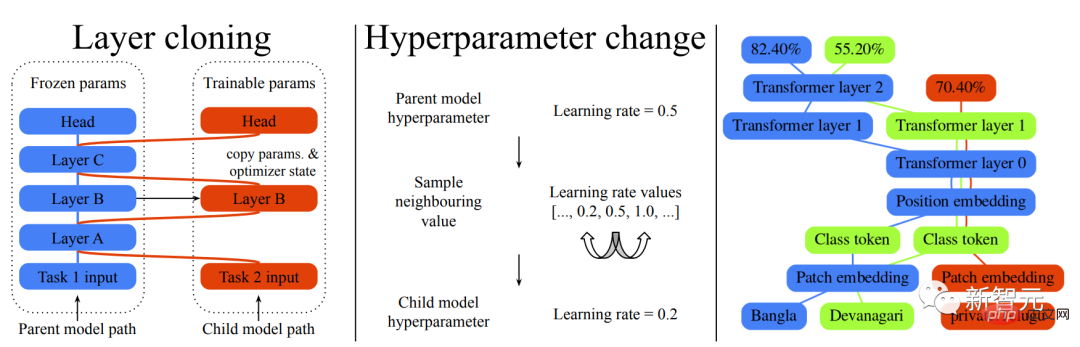

ディープ ニューラル ネットワークは、多くの場合、アーキテクチャとハイパーパラメータによって定義されます。この記事のアーキテクチャは、一連のニューラル ネットワーク層で構成されています。各層は入力ベクトルを可変次元の出力ベクトルにマッピングし、オプティマイザーの構成やデータ前処理などのネットワーク インスタンス化の詳細はハイパーパラメーターによって決定されます。

したがって、ここで説明した変異も、レイヤー クローン変異とハイパーパラメーター変異の 2 つのカテゴリに分類されます。

レイヤー クローン ミューテーションは、子モデルによってトレーニングできる親モデル レイヤーのコピーを作成します。親モデルのレイヤーがクローン作成用に選択されていない場合、既存のモデルの不変性を確保するために、現在の状態がフリーズされ、子モデルと共有されます。

ハイパーパラメータのミューテーションは、親レイヤーから子レイヤーに継承された構成を変更するために使用されます。各ハイパーパラメータの新しい値は、有効な値のセットから引き出すことができます。数値ハイパーパラメータの場合、有効な値のセットはリストとして並べ替えられ、増分変更制約を適用するためにサンプリングは隣接する値に制限されます。

実際の効果を見てみましょう:

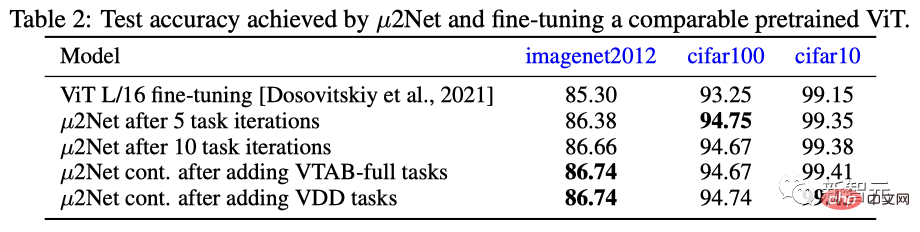

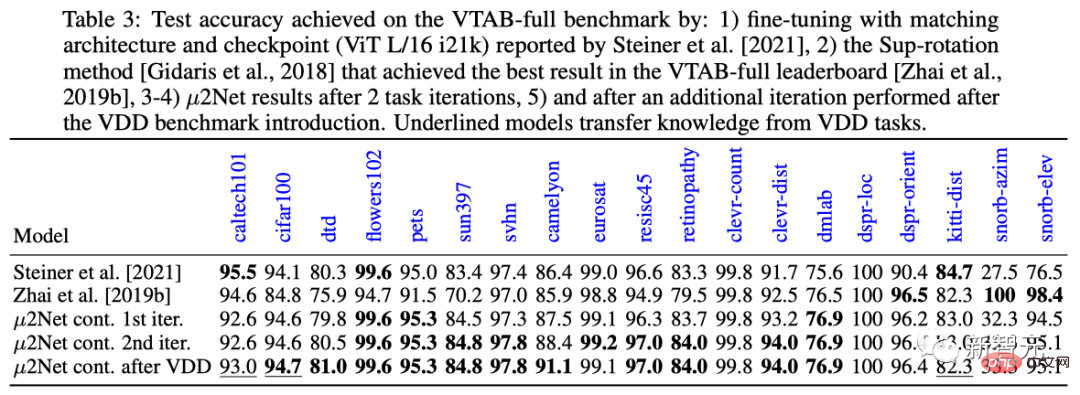

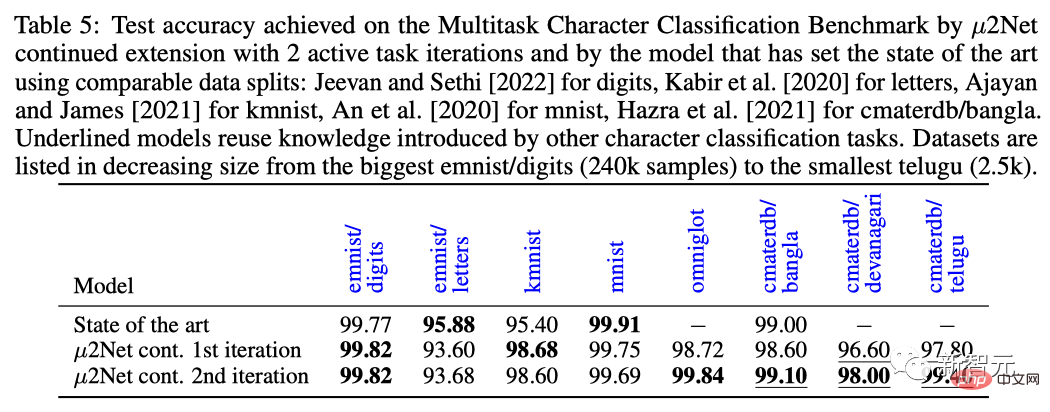

ImageNet 2012、cifar100、cifar10 の 3 つのデータ セットでは、 μ2Net は 5 タスク反復後のパフォーマンスと 10 回のタスク反復後のパフォーマンスは、現在最も多用途で最高のパフォーマンスを誇る ViT の事前トレーニング済み微調整モデルを上回りました。

タスクの拡張に関しては、VTAB-full および VDD 連続学習タスクを追加した後、μ2Net のパフォーマンスがさらに向上しました。cifar10 データセットでの VDD 連続学習タスクのパフォーマンスは達成されました。 99.43 % の最良の結果。

マルチタスク文字分類ベンチマーク タスクでは、タスクを 2 回繰り返した後、μ2Net はほとんどのデータ セットの SOTA レベルを更新し、データ セット サイズは 2.5k から 2.5k までの範囲でした。 240k サンプル サイズはさまざまです。

簡単に言うと、このアーキテクチャでは、モデルが学習するタスクが増えるほど、システムが学習する知識も増え、新しいタスクの解決が容易になります。

たとえば、ViT-L アーキテクチャ (3 億 700 万のパラメーター) は、1,308 億 7,000 万のパラメーターを備えたマルチタスク システムに進化し、69 のタスクを解決できます。

さらに、システムが成長するにつれて、パラメーターのアクティブ化がまばらになるため、各タスクの計算量とメモリ使用量が一定に保たれます。実験によると、各タスクに追加されるパラメータの平均数は 38% 減少しますが、マルチタスク システムは各タスクの合計パラメータの 2.3% のみをアクティブにします。

もちろん、現時点では、これは単なるアーキテクチャと予備実験にすぎません。

ネチズン: 紙はとても良いですが...

紙は素晴らしいですが、買わない人もいるようですそれ。

皇帝の新しい服を公開するのが大好きな一部のネチズンは、もう愛を信じないと言いながら reddit に投稿しました...ああ、「一流の研究所/研究機関が作成した AI 論文」 「。」

ID「Mr. Acurite」のネットユーザーは、これらの論文のデータとモデルの演算結果を当然信じていると述べました。

しかし、ジェフ ディーン教師によるこの論文を例に挙げてみましょう。18 ページの論文では、特に複雑な進化的畳み込みとマルチタスク学習アルゴリズムについて説明しています。これは強力で、目で見てわかります。とてもよかったです。

ただし、2 つの点を指摘しなければなりません:

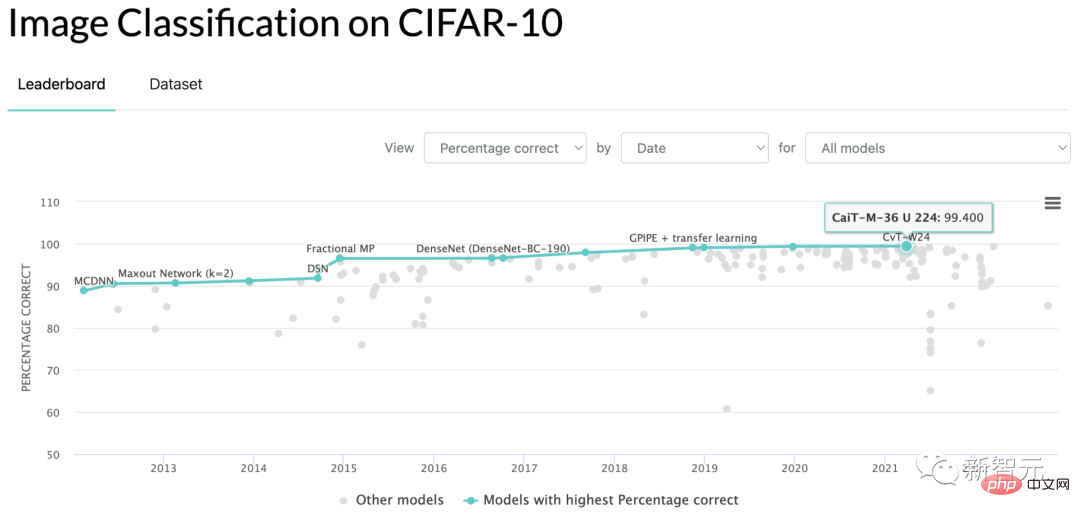

第一に、ジェフ ディーンが論文で提案したことは、彼の方が優れていることを証明しています。ランニング スコアの結果は、CIFAR-10 ベンチマーク テストの精度が 99.43 であり、現在の SOTA の 99.40... という表現よりも優れています。

#2 番目に、この文書の最後には、TPU 実行アルゴリズムを使用して最終結果を取得するための所要時間の表があり、合計 17,810 時間かかります。

Google で働いていない人が論文の結果を再現したいと考え、市場価格 1 時間あたり 3.22 米ドルで TPU をレンタルして再度実行すると、コストは次のようになります。 57,348ドル。 ############それはどういう意味ですか?日刊紙であってもコンピテンシーの基準を設定する必要がありますか?

もちろん、このアプローチは現在、Google や OpenAI などの大手企業を含む (ただしこれらに限定されない) 業界のトレンドになっています。全員が現状を改善するためのいくつかのアイデアと、前処理された大量のデータとベンチマークをモデルに注ぎ込みます。

そして、実行結果が対戦相手の結果よりもパーセンテージで小数点以下 2 桁でも数値的に高ければ、研究者は自信を持って論文タイトルを新しい行に追加できます。履歴書!

これを行うことで、学術界と産業界にどのような本当の推進力が与えられるのでしょうか?普通の大学院生には結論を検証するためにお金をかける余裕はありませんし、一般の企業はプロジェクトでそのような退屈なベンチマークを使用することはできません。

同じ文ですが、どういう意味ですか?

これは AI の世界で許容される快適ゾーンでしょうか?少数の大企業、時にはトップクラスの学校が、私にはお金があってやりたいことが何でもできると毎日誇示しているのに、あなたはお金がないのに遅れをとらなければならないのですか?

このまま続けるのであれば、別のコンピュータ サイエンス ジャーナルを創刊し、コンシューマー グレードのスタンドアロン グラフィックス カードで 8 時間以内に結果を再現できる論文を集めたほうがよいでしょう。

スレッドでは、論文の課題を抱えた大学院生らが次々と不満を漏らしていた。

ID が「サポート ベクター マシン」であるネットユーザーは、自分は小さな研究室で実践者をしているが、その勢いのせいで、研究を続ける意欲をほぼ完全に失ったと述べています。ディープラーニングです。

なぜなら、私自身の研究室の予算では、これらの巨大企業と比較する方法がなく、最終的なパフォーマンスを示すベンチマーク結果を生み出すことができないからです。

新しい理論的アイデアを持っていたとしても、審査を通過できる論文を書くことは困難です。それは、現在の論文査読者は大手メーカーの能力に起因する「美麗画像バイアス」が生じており、論文のテストに使用されている画像も見栄えが良くなく、すべてが無駄になっているからです。

巨大メーカーがダメだというわけではなく、GPTやDALL-Eなどのプロジェクトは本当に画期的です。しかし、自分のマシンが動作しない場合、なぜ興奮する必要があるのでしょうか?

博士課程の学生である別のネチズンが現れ、「サポート ベクター マシン」をサポートするために投稿にコメントしました。

博士課程の学生は 2 年前にフロー モデルに関する論文を提出しました。この論文は主にサンプリング可能なデータの潜在的な空間を発見することに焦点を当てており、データの品質には影響を与えませんでした。モデルの画像生成。

その結果、論文の採点者からの批判的なコメントは「生成された画像は GAN で生成された画像ほど良くない」というものでした。

ID 名「Uday」を持つ別の大学院生も、2021 年の会議に提出した論文に対する採点者の批判的なコメントは「データが十分に派手ではない」だったと述べました。

##人力は金に勝てないというのは、まさに世界的な風潮であり、東洋も西洋も同じ心理学であり、道教の思想でもあります。中国と外国は壊れていない。

しかし、河東で30年、河西で30年も経てば、アルゴリズムと普遍資本化の草の根実装が、ガレージスタートアップがIBMを倒すという第二の奇跡をもたらすかもしれない。

以上がジェフ・ディーンの大規模マルチタスク学習SOTAが批判され、再現するには6万ドルかかるの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。