ホームページ >テクノロジー周辺機器 >AI >今年の英語大学入学試験では、CMU が再構築事前トレーニングを使用して GPT3 を大幅に上回る 134 点の高得点を達成しました

今年の英語大学入学試験では、CMU が再構築事前トレーニングを使用して GPT3 を大幅に上回る 134 点の高得点を達成しました

- PHPz転載

- 2023-04-09 10:21:051759ブラウズ

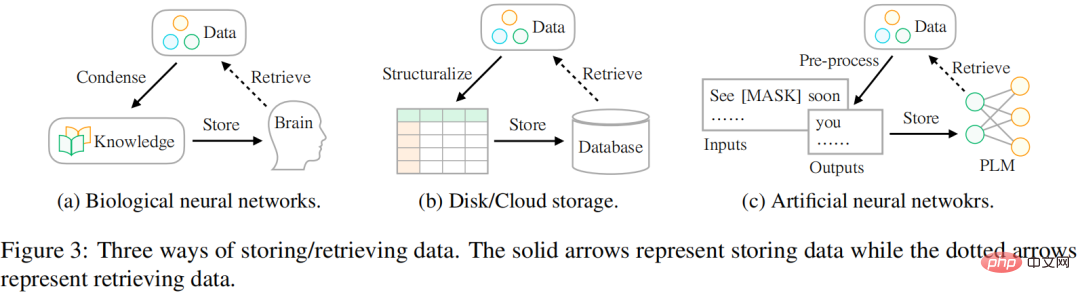

データの保存方法は、生物学的ニューラル ネットワークから人工ニューラル ネットワークへと変化しています。実際、最も一般的な状況は、データを保存するために脳を使用することです。今日利用できるデータの量が増え続けるにつれて、人々はハードドライブやクラウドストレージなどのさまざまな外部デバイスを使用してデータを保存しようとしています。深層学習テクノロジーの台頭により、人工ニューラル ネットワークを使用して情報をデータに保存する、別の有望なストレージ テクノロジーが登場しました。

研究者らは、データ ストレージの最終的な目標は人間の生活により良いサービスを提供することであり、データへのアクセス方法もストレージ方法と同様に重要であると考えています。ただし、データの保存方法とアクセス方法には違いがあります。歴史的に、人々は世界に存在する情報をより有効に活用するために、このギャップを埋めるのに苦労してきました。図 3 に示すように:

- 生物学的ニューラル ネットワーク (人間の脳など) に関して、人間は幼い頃からカリキュラム (つまり知識) 教育を受けます。これにより、複雑で変化する生活に対処するための特定のデータを抽出できるようになります。

- 外部デバイス ストレージの場合、通常、特定のパターン (テーブルなど) に従ってデータを構造化し、特殊な言語 (SQL など) を使用してデータベースから必要な情報を効率的に取得します。

- 人工ニューラル ネットワーク ベースのストレージの場合、研究者は自己教師あり学習を活用して大規模なコーパス (つまり、事前トレーニング) からのデータを保存し、そのネットワークをさまざまな下流タスク (感情分類など) に使用します。 。

CMU の研究者らは、モデル パラメーターの最適化を導くための事前トレーニング シグナルとして機能するさまざまな種類の情報を含むデータにアクセスする新しい方法を提案しました。この研究では、信号の単位で構造化された方法でデータが表示されます。これは、データベースを使用してデータを保存するシナリオに似ています。データはまずテーブルまたは JSON 形式に構造化されるため、必要な正確な情報は SQL などの特殊な言語を通じて取得できます。

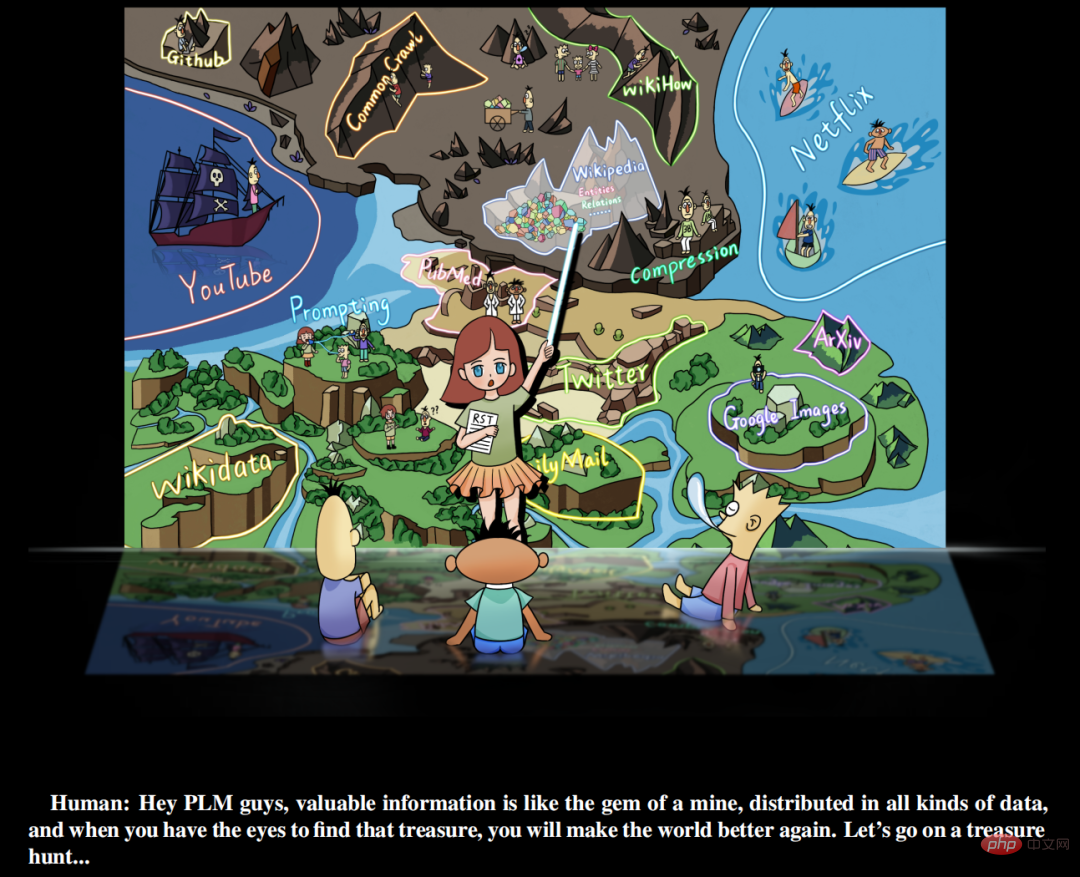

さらに、この研究では、貴重な信号が手動で管理された教師付きデータセットに単に存在するのではなく、世界中のあらゆる種類のデータに豊富に存在すると考えています。研究者が行う必要があるのは、(a) データを特定することです ( b) 統一言語を使用してデータを再編成します。 (c) 事前にトレーニングされた言語モデルにデータを統合して保存します。この研究では、この学習パラダイムを再構造化事前トレーニング (RST) と呼んでいます。研究者らはこのプロセスを「鉱山での宝探し」に例えている。 Wikipedia などのさまざまなデータ ソースは、宝石が豊富な鉱山に相当します。これらには、ハイパーリンクの名前付きエンティティなど、モデルの事前トレーニング用のシグナルを提供できる豊富な情報が含まれています。優れた事前トレーニング済みモデル (PLM) は、下流タスクのさまざまなニーズに基づいて正確な情報を提供するために、データ内のさまざまな信号の構成を明確に理解する必要があります。

論文アドレス: https://arxiv.org/pdf/2206.11147.pdf

暫定版トレーニング言語モデルの宝探し

この研究は、データの役割を再強調し、モデルの事前トレーニングと下流の微調整を考慮した、自然言語処理タスク学習の新しいパラダイム、すなわち RST を提案します。データの役割としてのタスク ストレージとアクセス手順これに基づいて、この研究は単純な原則を実現します。つまり、優れたストレージメカニズムは、大量のデータをキャッシュする能力を備えているだけでなく、アクセスの利便性も考慮する必要があるということです。

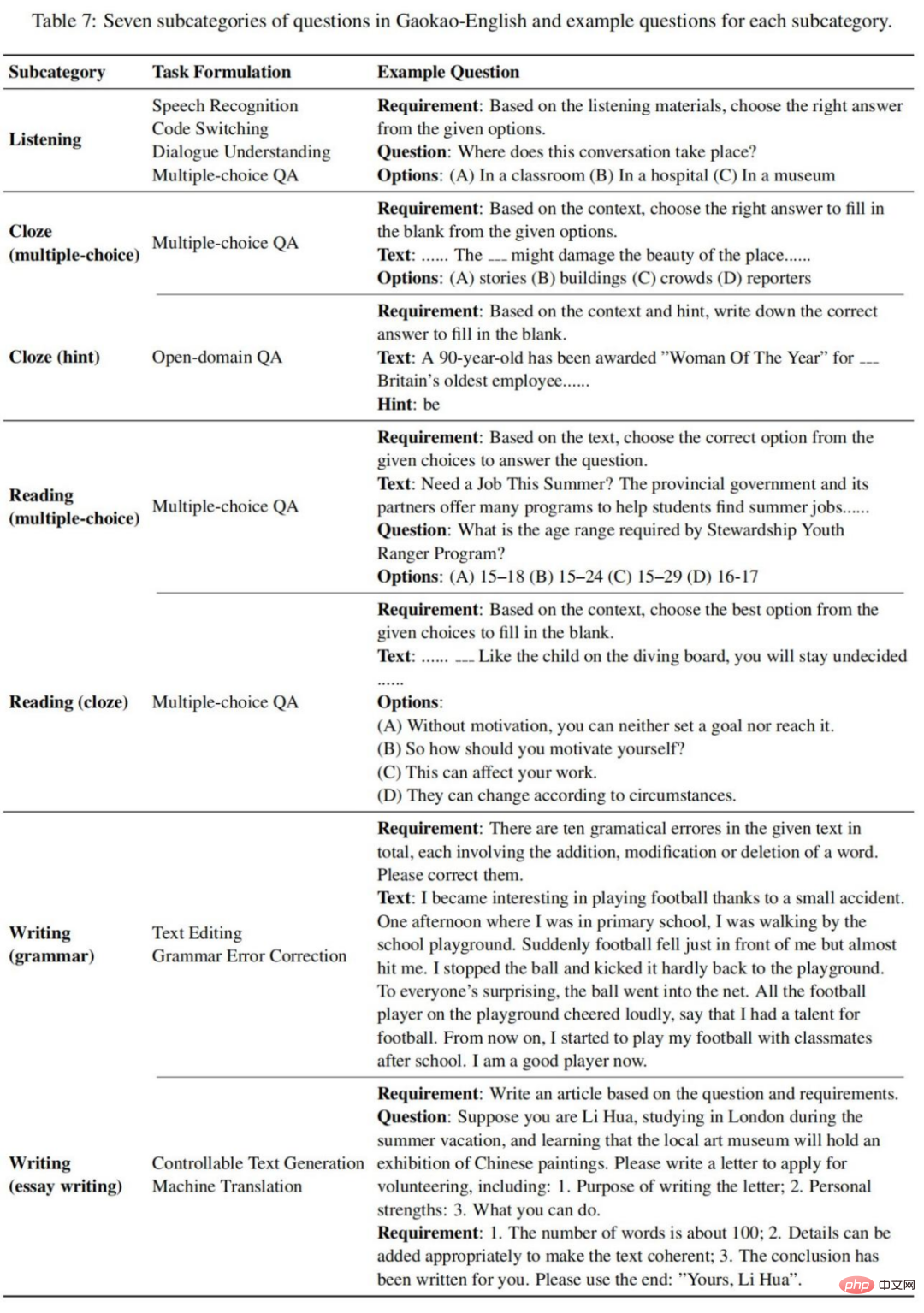

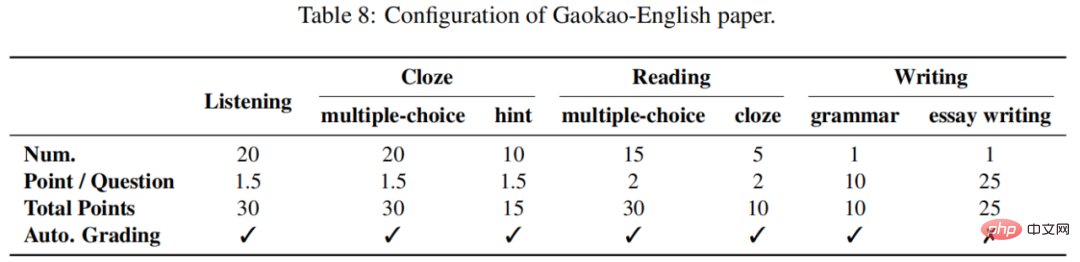

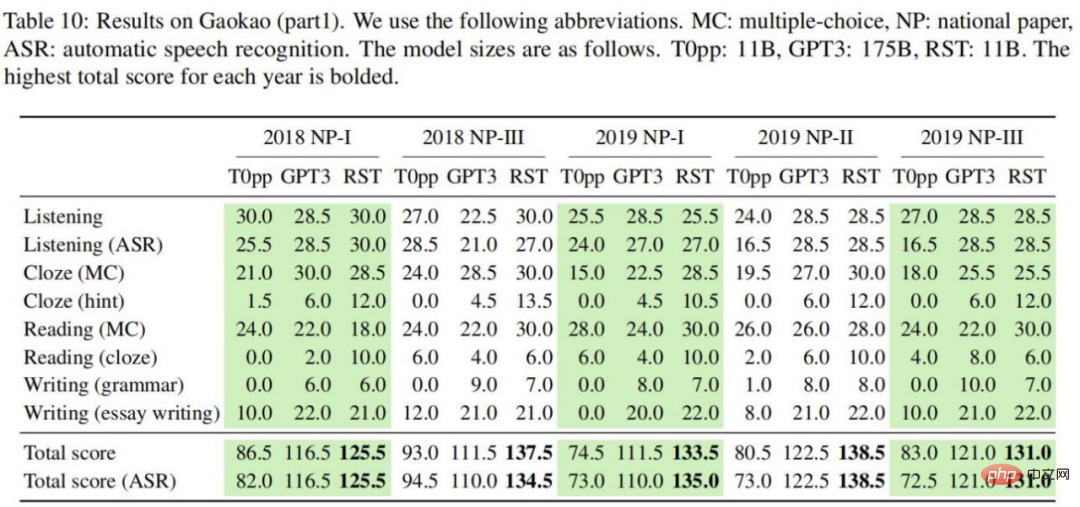

いくつかのエンジニアリング上の課題を克服した後、この研究では、再構成されたデータ (元のデータではなくさまざまな貴重な情報で構成された) を事前トレーニングすることでこれを達成しました。実験では、RST モデルが、さまざまな NLP タスク (分類、情報抽出、事実検索、テキスト生成など) からの 52/55 の一般的なデータセットに対して、既存の最高のシステム (T0 など) よりも大幅に優れているだけでなく、下流タスクの微調整は必要ありません。また、毎年何百万人もの学生が受験する中国で最も権威のある大学入学試験の英語試験でも優れた成績を収めています。

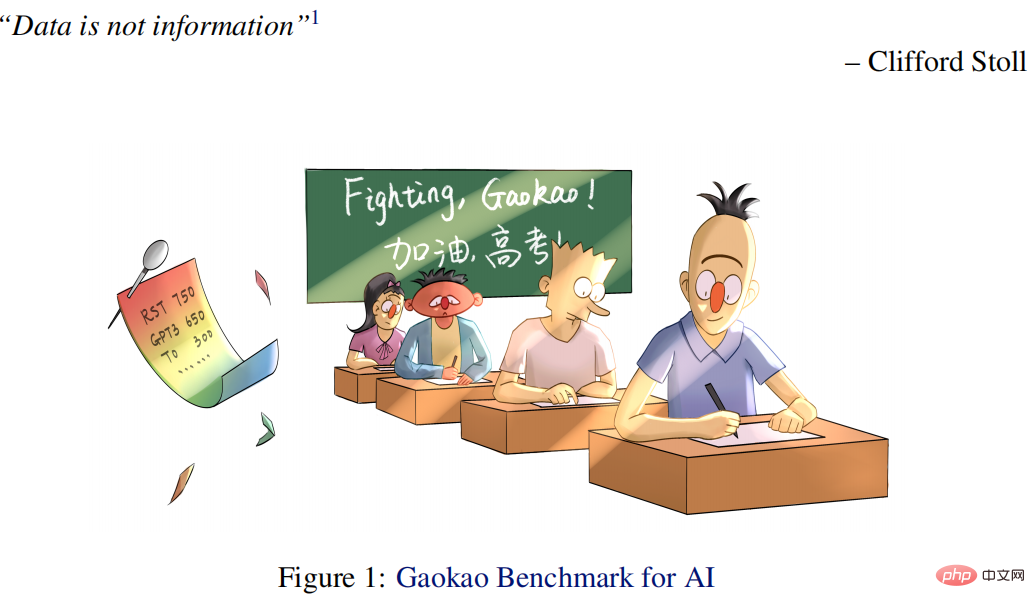

具体的には、この記事で提案する大学入試AI (Qin) は、1/16 パラメータを使用した場合、学生の平均スコアよりも 40 ポイント高く、GPT3 よりも 15 ポイント高いです。特別秦は、2018年の英語テストで138.5点(150点満点)という高得点を獲得した。

さらに、この研究は Gaokao Benchmark オンライン提出プラットフォームもリリースしました。これには、2018 年から 2021 年から現在までの 10 件の注釈付き英語試験問題が含まれており (毎年拡張されます)、より多くの AI モデルが大学入学に参加できるようになります。この研究はまた、人間と AI の競争のための比較的レベルの高いテストベッドを確立し、私たちが自分たちの立ち位置をよりよく理解するのに役立ちます。また、先日(2022.06.08)の2022年度大学入試英語試験では、AIシステムが134点という好スコアをマークしたのに対し、GPT3は108点にとどまった。

この研究の主な貢献は以下のとおりです:

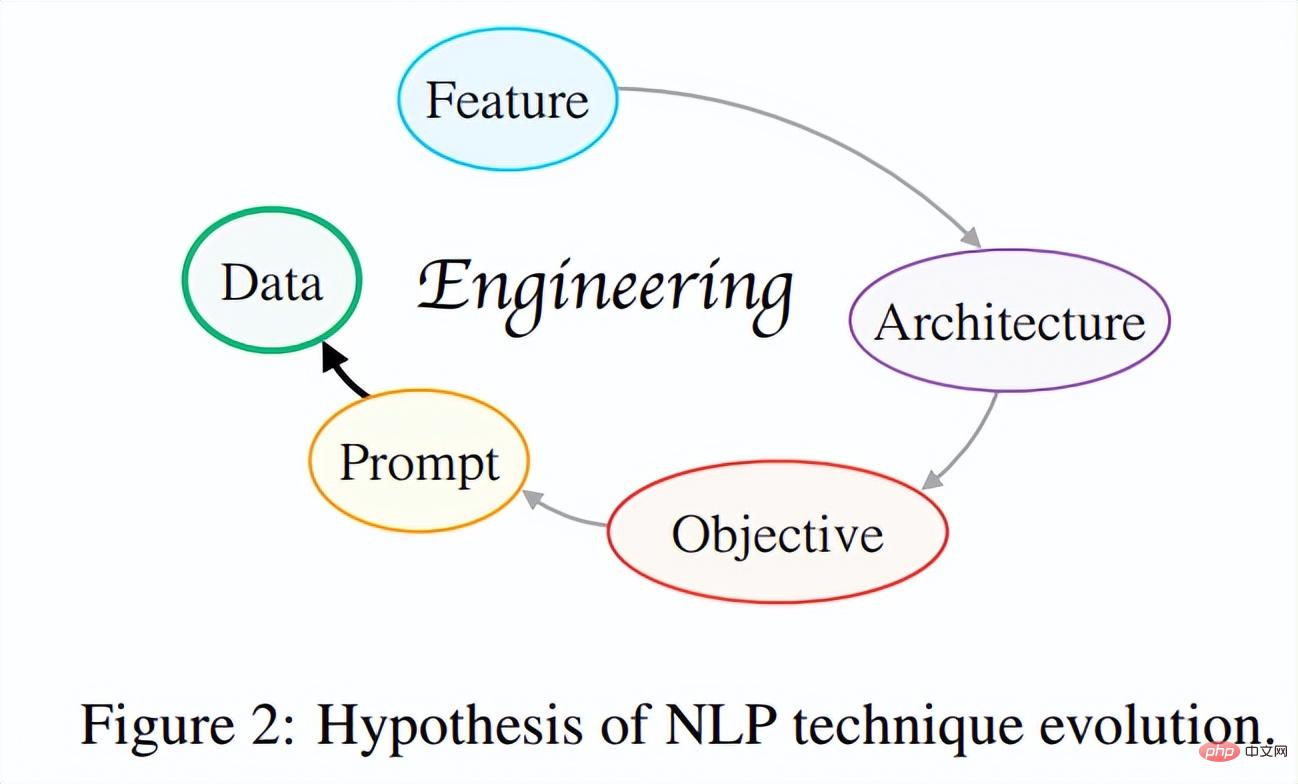

(1) NLP 手法の進化仮説を提案します。この研究は、現代の NLP テクノロジーの発展の間の本質的なつながりを探ることにより、全体的な観点から「NLP テクノロジー進化仮説」を確立することを試みます。つまり、この仮説の核となる考え方は、テクノロジーの反復は常に、開発者がより少ない作業で済むだけで、より優れた、より汎用性の高いシステムを設計できるような方向に発展するということです。

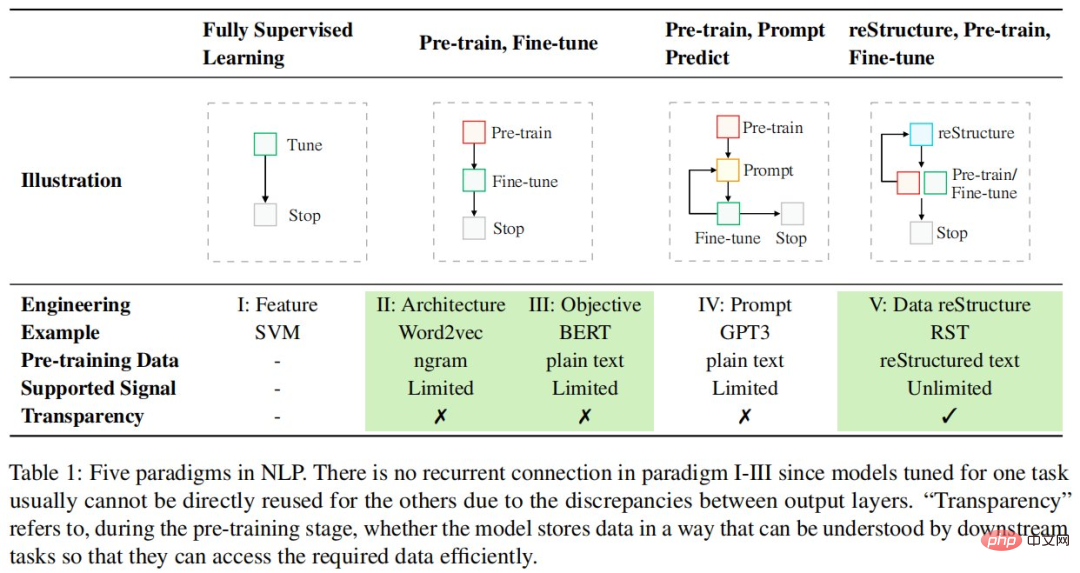

これまで、NLP テクノロジーの進化は、図 2 に示すように複数回の反復を経て、フィーチャー エンジニアリング → アーキテクチャ エンジニアリング → ターゲット エンジニアリング → プロンプト エンジニアリングに向かって進んでいます。より実践的で効果的なデータ中心のエンジニアリングへの移行。研究者らは、将来的には、より多くの科学研究者がこの問題について批判的に考え、技術進歩の中核となる原動力を把握し、学術発展の「漸進的」な道筋を見つけ、より科学的に意味のある研究を行うようになることを期待している。

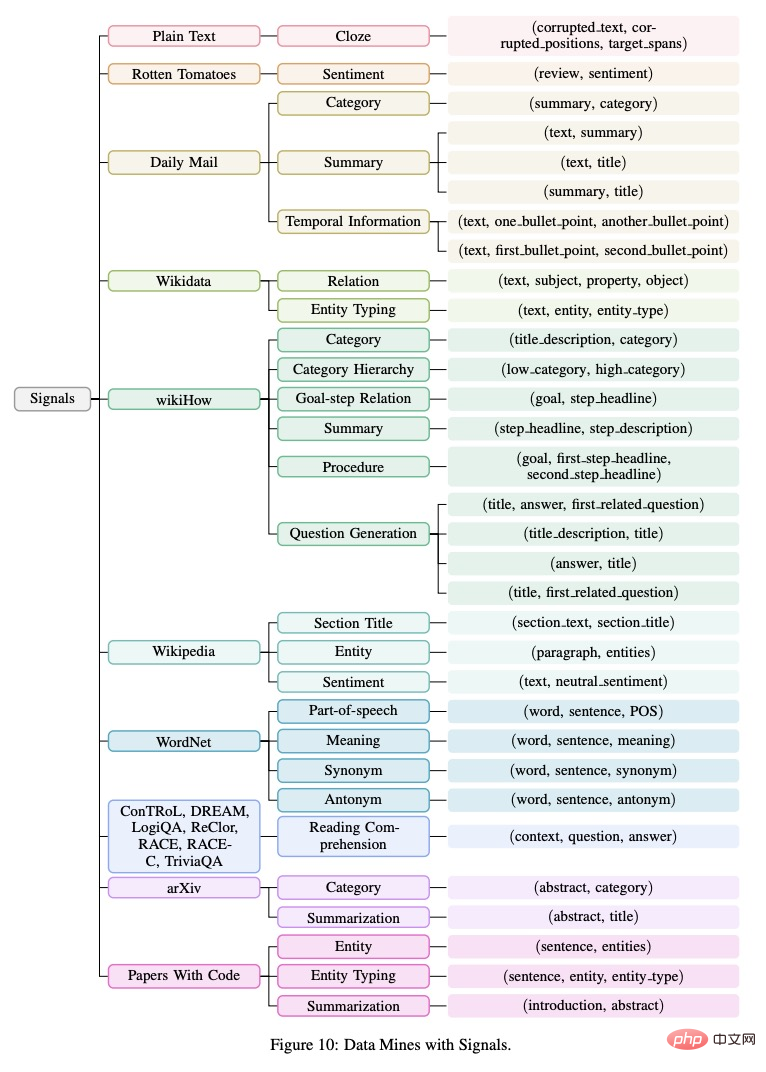

(2) 進化仮説に基づく新しいパラダイム: 再構築された事前トレーニング 。このパラダイムは、モデルの事前トレーニング/微調整をデータ ストレージ/アクセス プロセスとして扱い、優れたストレージ メカニズムによって目的のデータに簡単にアクセスできるようにする必要があると主張します。このような新しいパラダイムにより、この研究では、10 のデータ ソース (Wikipedia など) から世界中の 26 の異なるタイプのシグナル (文章のエンティティなど) を統合することができました。これに基づいてトレーニングされた一般モデルは、55 の NLP データ セットを含むさまざまなタスクに対して強力な一般化機能を実現しました。

(3) 大学入試に使用されるAI。上記のパラダイムに基づいて、この研究では、特に大学入学試験の英語試験タスクに使用される AI システム - Qin - を開発しました。世界初のディープラーニングによる大学入試英語人工知能システムです。秦氏は大学入試問題で長年にわたり優れた成績を収めており、一般人より40点も高く、GPT-3の1/16のパラメータのみを使用してGPT-3より15点も高い成績を収めている。特に2018年の英語試験問題では、QINは138.5点(150点満点)の高得点を獲得し、リスニング、読解ともに満点を獲得した。

(4) 豊富なリソース。 (1) 人間の知能の実現における既存の AI テクノロジーの進歩を追跡するために、この研究では新しいベンチマークである Gaokao ベンチマークが発表されました。現実世界のシナリオにおけるさまざまな実践的なタスクと領域の包括的な評価を提供するだけでなく、AI システムを人間と直接比較できるように、人間のパフォーマンス スコアも提供します。 (2) この研究では、ExplainaBoard (Liu et al., 2021b) を使用して Gaokao Benchmark のインタラクティブなリーダーボードを設定し、より多くの AI システムが簡単に Gaokao Benchmark に参加し、自動的にスコアを取得できるようにします。 (3) すべてのリソースは GitHub で見つけることができます。

さらに、大学入学試験の英語テスト課題における AI の成功は、研究者に多くの新しいアイデアをもたらしました。AI テクノロジーは教育に力を与え、教育と教育における一連の問題の解決に役立ちます。

たとえば、(a) 教師による採点の自動化を支援し、(b) 生徒が課題に関する質問に答えて詳細に説明できるよう支援し、(c) さらに重要なことに、教育の公平性を促進し、ほとんどの家庭が教育にアクセスできるようにします。同じ品質のサービス。この研究は、世界中からの 26 の異なる信号を初めて統合された方法で統合したもので、教師ありデータと教師なしデータを区別しようとするのではなく、自然が私たちに与える情報をどれだけ多く、どのように利用できるかに焦点を当てています。さまざまな NLP タスクからの 50 以上のデータセットに対する優れたパフォーマンスは、データ中心の事前トレーニングの価値を示し、将来のさらなる探索を刺激します。

トレーニング前のリファクタリング

NLP タスクを解決するためのパラダイムは急速に変化しており、現在も続いています。次の表に、NLP の 5 つのパラダイムを示します。

既存のモデル中心の設計パラダイムとは異なり、この研究では、既存のデータを最大限に活用するためにデータの観点からさらに考えています。具体的には、この研究ではデータストレージとアクセスの観点を採用しており、事前トレーニング段階をデータストレージプロセスとみなし、事前トレーニングモデルに基づく下流タスク(感情分類など)をデータアクセスプロセスと見なしています。そして、優れたデータストレージメカニズムにより、保存されたデータへのアクセスが容易になるはずだと主張しています。

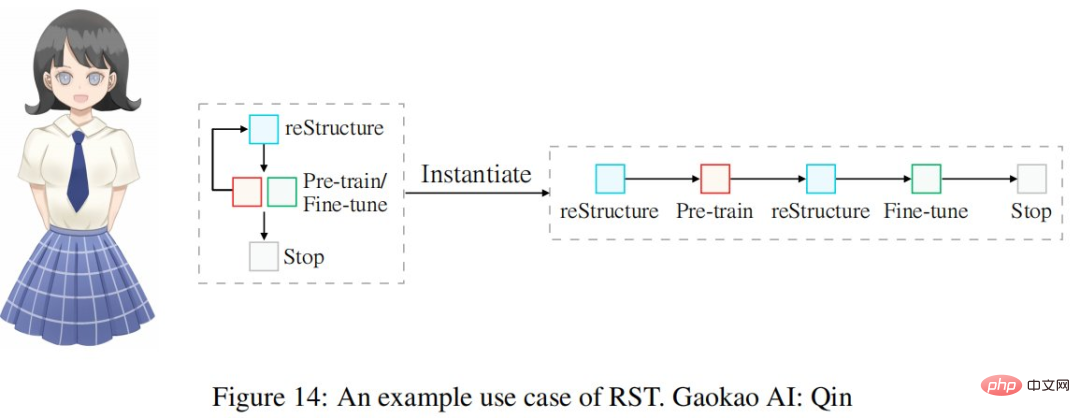

この目標を達成するために、この研究ではデータをさまざまな信号で構成されるオブジェクトとして扱い、優れた事前トレーニング モデルは (1) 可能な限り多くの信号タイプをカバーし、(2) ダウンストリームで提供される信号を提供する必要があると考えています。ミッションで必要な場合にこれらの信号に正確にアクセスするメカニズム。一般に、この新しいパラダイムは、再構築、事前トレーニング、微調整の 3 つのステップで構成されます。

再構築、事前トレーニング、微調整の新しいパラダイムはデータの重要性を強調しており、研究者はデータ処理により多くのエンジニアリングエネルギーを投資する必要があります。

再構築プロジェクト

シグナル定義

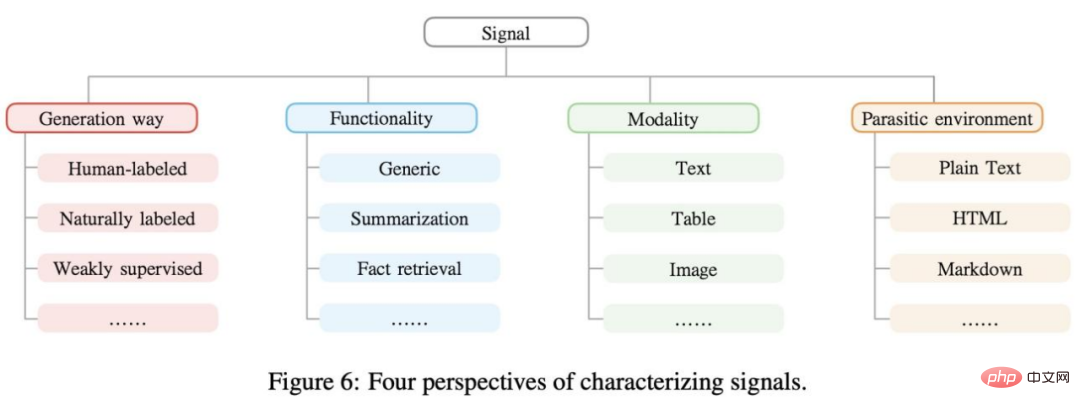

シグナルは、機械学習モデルの監視を提供できるデータ内に存在する有用な情報であり、n タプルとして表現されます。たとえば、「モーツァルトはザルツブルクで生まれました」、「モーツァルト」、および「ザルツブルク」は固有表現認識の信号と考えることができます。通常、信号は、以下の図 6 に示すように、さまざまな観点からクラスター化できます。

データ マイニング

実世界のデータには、さまざまな種類のシグナルが含まれています。事前トレーニングを再構築することで、これらのシグナルを最大限に活用できるようになります。この研究では、以下の図 10 に示すように、収集された信号 (n タプル) を樹形図に整理しました。

信号抽出

調査の次のステップは信号の抽出と処理で、これにはデータ マイニング、データ クリーニング、データ クリーニングなどのさまざまな手法から生データを取得することが含まれます。データの正規化。既存の手法は、(1)ルールベースと(2)機械学習ベースの2種類に大別されます。この研究では、主にルールベースの信号抽出戦略に焦点を当てており、よりカバー率の高い手法については将来の研究に残しています。

信号再構成

さまざまなデータ マイニングからさまざまな信号を抽出した後、次の重要なステップは、それらを固定形式に統合して、事前トレーニング中に変換できるようにすることです。モデル内で一貫して。プロンプト手法 (Brown et al., 2020; Liu et al., 2021d) はこの目標を達成でき、原則として、適切なプロンプト設計を使用すれば、ほぼすべてのタイプの信号を言語モデル スタイルに統合できます。

調査では、信号を一般信号とタスク関連信号の 2 つの大きなカテゴリに分類しました。前者には基本的な言語知識が含まれており、すべての下流タスクにある程度役立ちますが、後者は一部の特定の下流タスクに役立ちます。

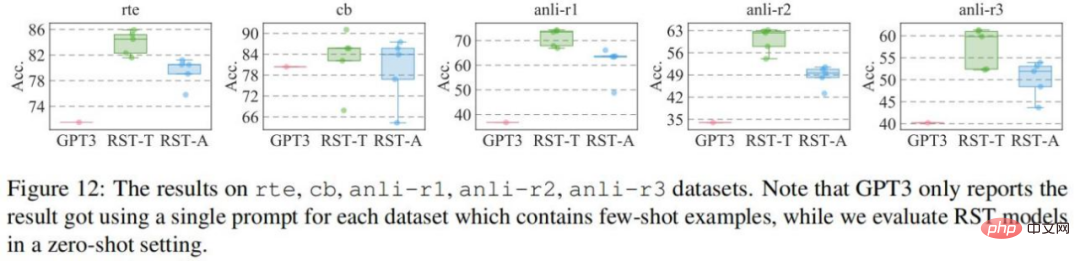

一般的に使用される 55 の NLP データセットでの実験

研究は 55 のデータセットで評価され、それぞれ GPT3 および T0pp と比較されます。 GPT3 との比較結果を図に示します。cb データセットを除く 4 つのデータセットでは、RST-All と RST-Task の両方が GPT3 の少数ショット学習よりも優れたゼロショット パフォーマンスを示しています。さらに、cb データ セットはこれらのデータ セットの中で最も小さく、検証セットにサンプルが 56 個しかないため、このデータ セットでのさまざまなプロンプトのパフォーマンスは大きく変動します。

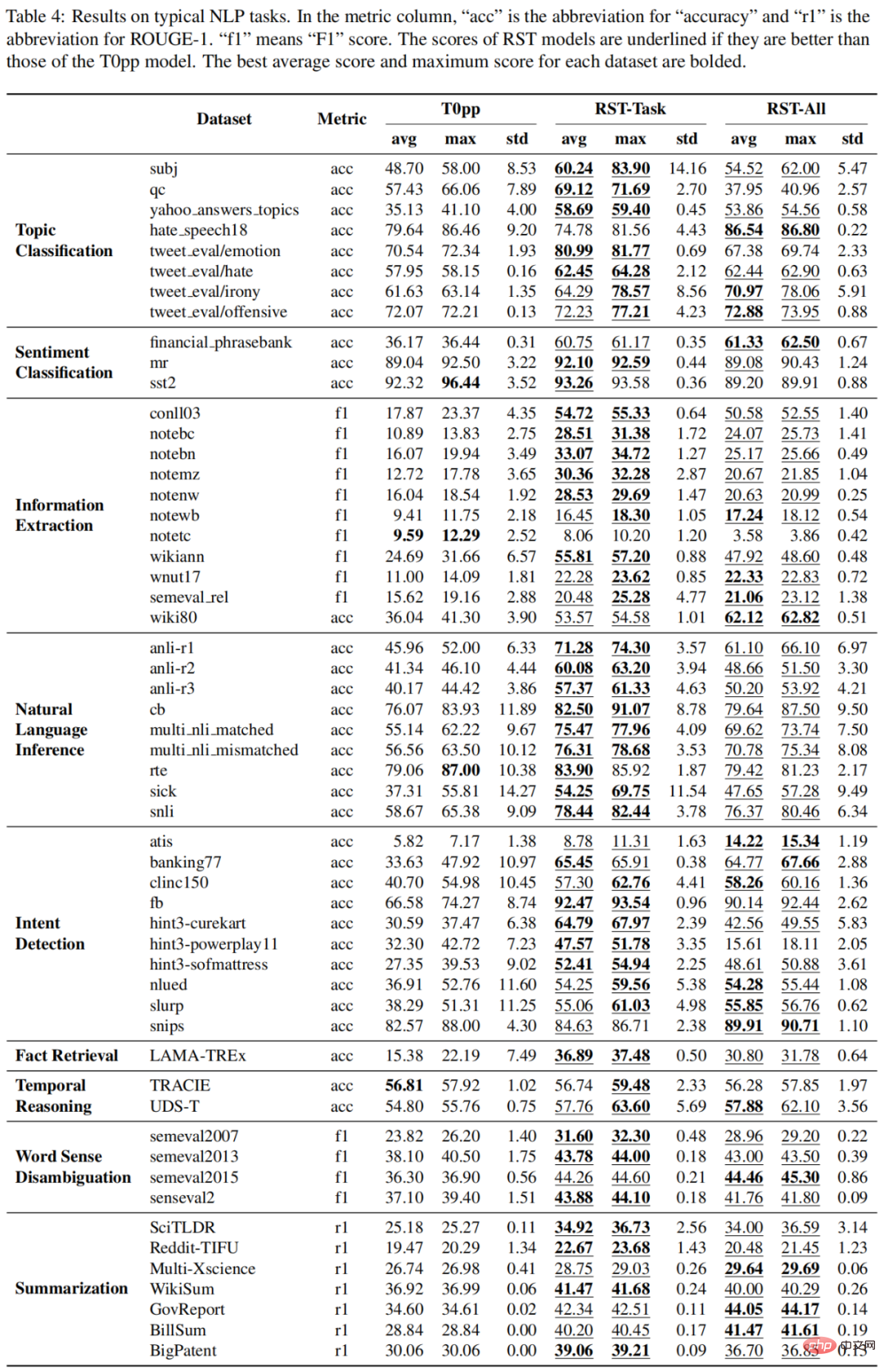

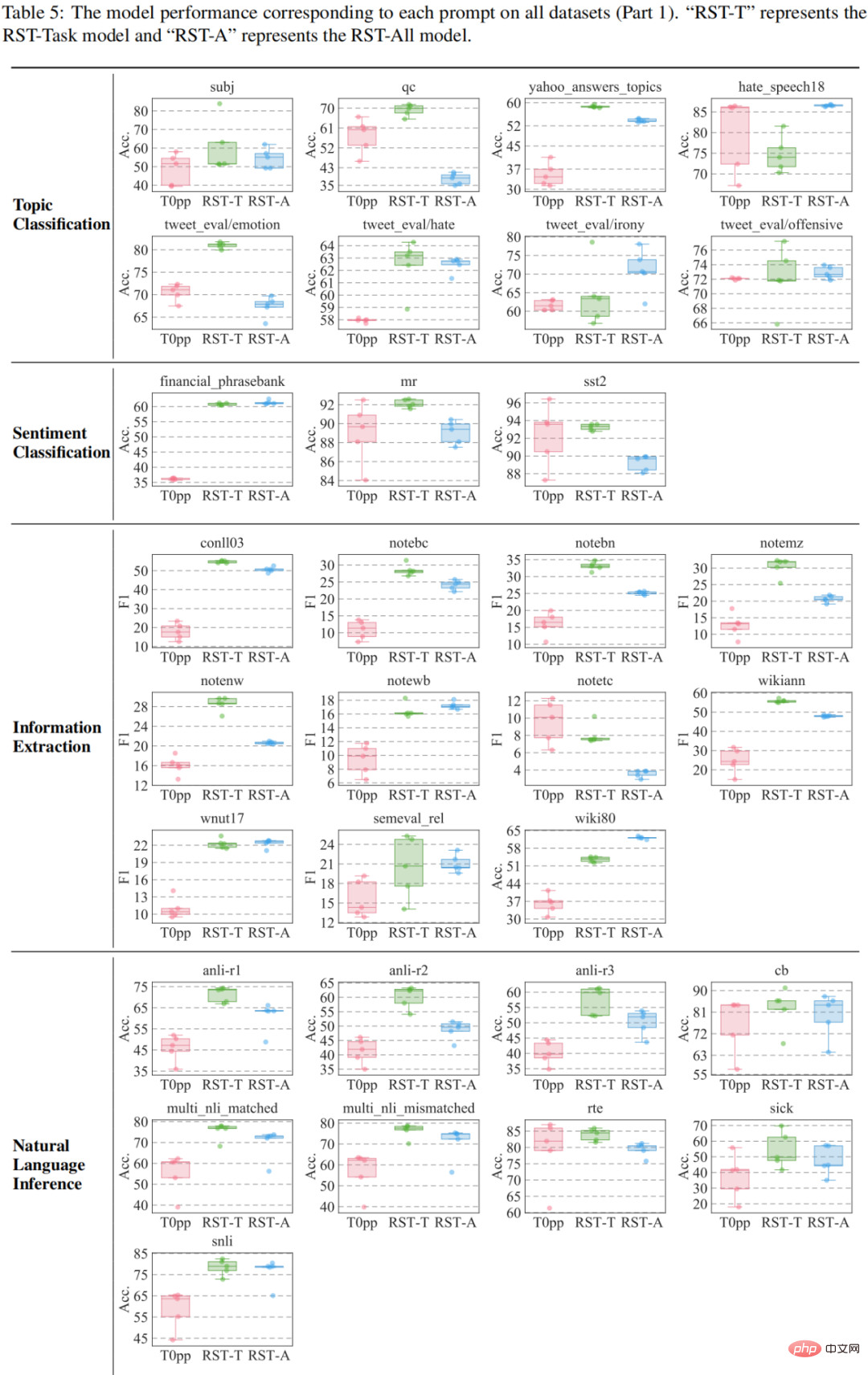

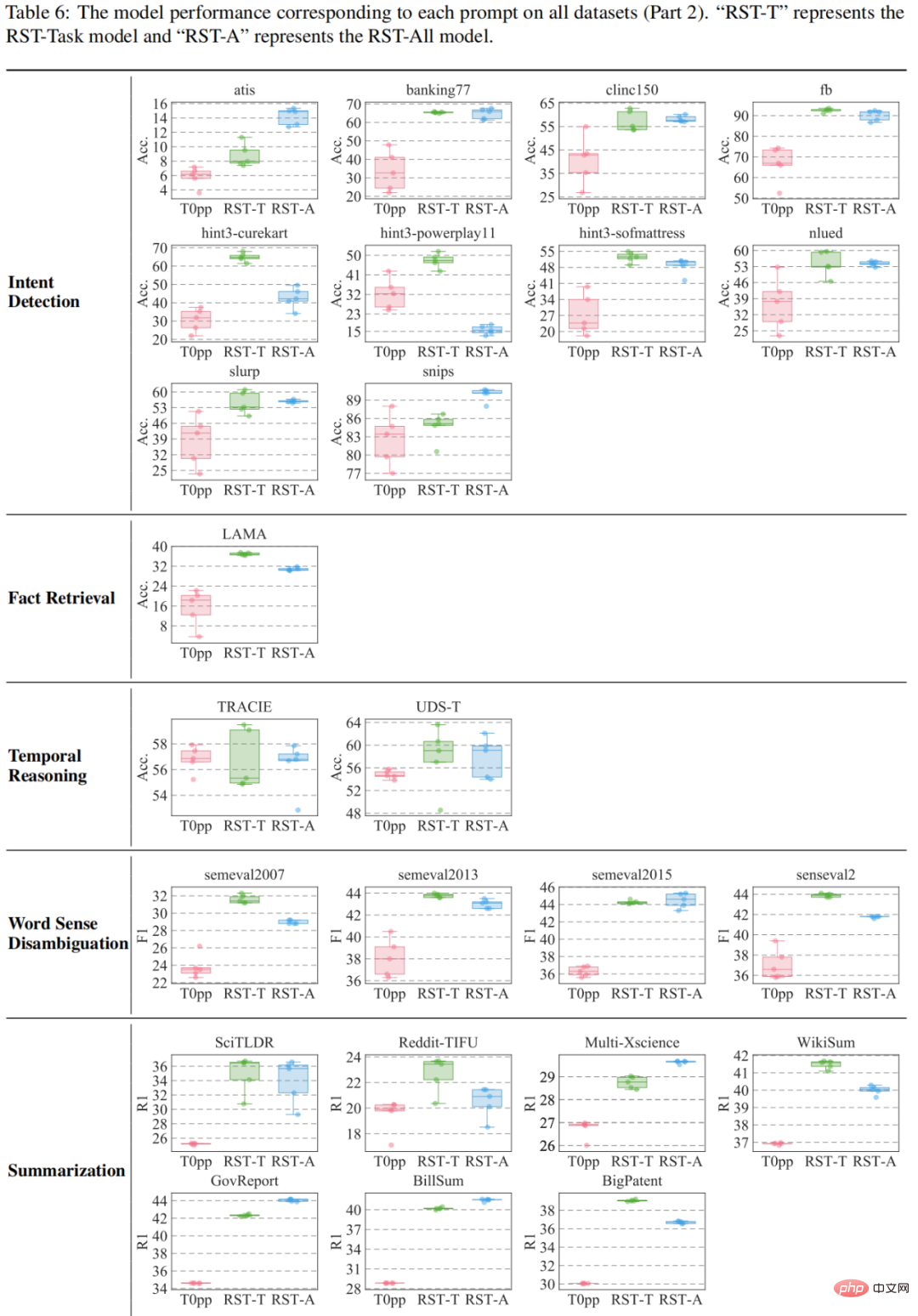

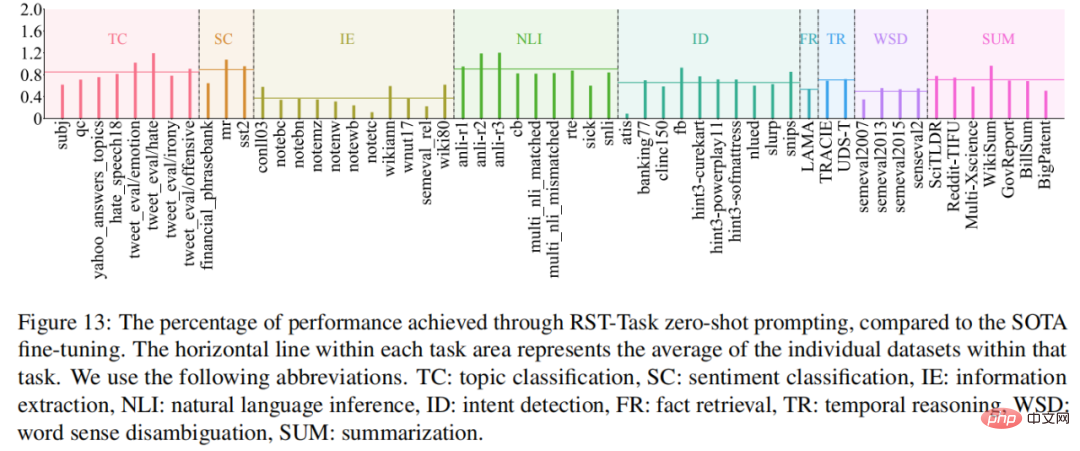

と T0pp の比較結果を表 4-6 に示します。たとえば、55 の測定の平均パフォーマンスでは、RST-All は 49 データセットで T0pp を上回り、47/55 のサンプルで最大パフォーマンスで勝利します。さらに、55 データセットの平均パフォーマンス テストでは、RST-Task は 52 データセットで T0pp を上回り、50/55 のサンプルで T0pp を上回りました。これは、再構成学習の優位性を示しています。

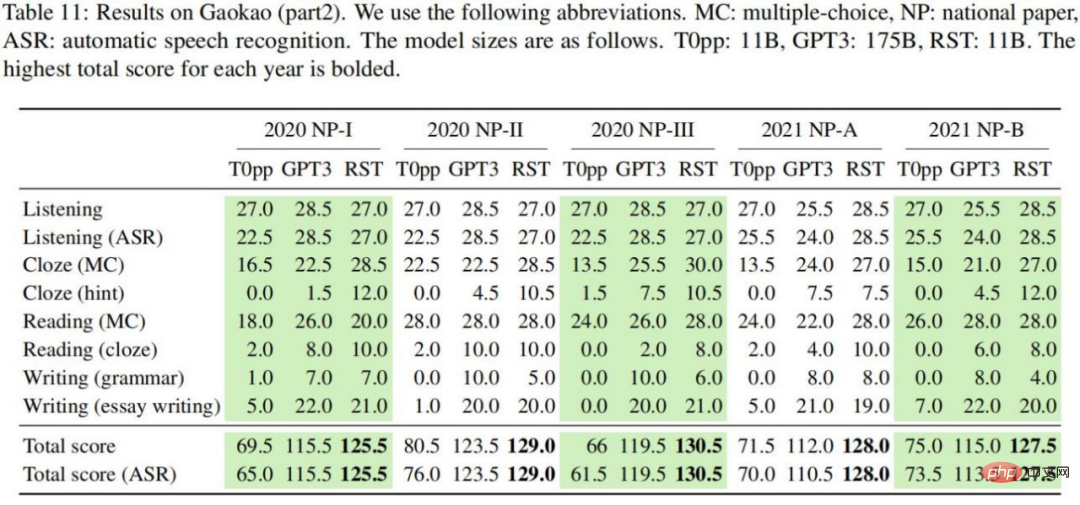

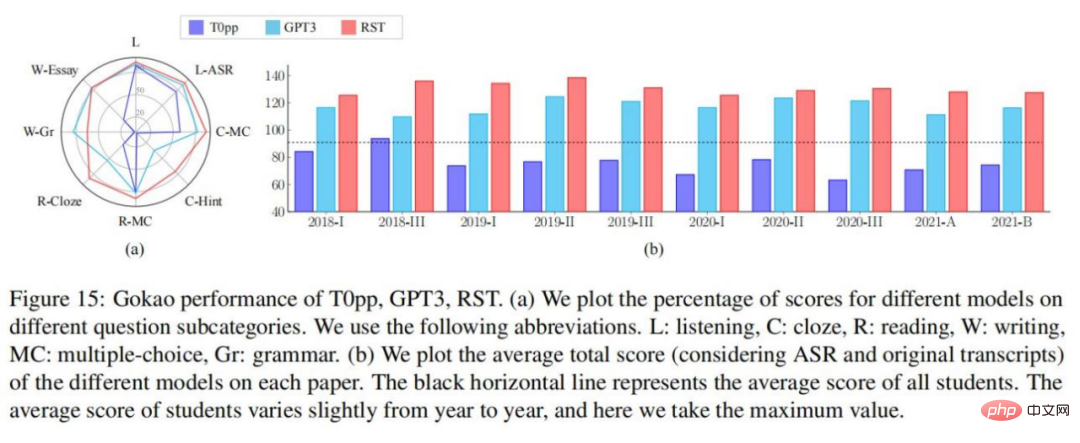

実験結果を表 10-11 に示します。次の結論を導き出すことができます: 各英語の試験問題では、RST が 2 セットのリスニング テストで最高の合計スコアを達成し、平均スコアは 130.6 点でした。 T0pp の場合 比較すると、RST のパフォーマンスは、同じモデル サイズの T0pp よりもはるかに優れています。すべての設定において、RST によって得られる合計スコアは T0pp より平均 54.5 ポイント高く、最大の差は 69 ポイント (合計スコアの 46%) です。GPT3 と比較して、RST は 16 倍のモデル サイズで有意な結果を達成できます。小さいほど良い結果が得られます。考慮したすべての設定において、RST で得られた合計スコアは、T0pp よりも平均 14.0 ポイント高く、最大 26 ポイント (合計スコアの 17%) でした。T0pp の場合、ゴールドとスピーチツーを使用して取得されたリスニング スコアは、 -テキストのトランスクリプトは、平均 4.2 ポイントと大幅に異なりました。比較すると、GPT3 と RST はそれぞれ 0.6 と 0.45 であり、T0pp のパフォーマンスがテキストの品質に影響されることを示しています。

以上が今年の英語大学入学試験では、CMU が再構築事前トレーニングを使用して GPT3 を大幅に上回る 134 点の高得点を達成しましたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。