データ セットをトレーニング セットに分解すると、モデルを理解するのに役立ちます。これは、モデルを新しい未知のデータに一般化する方法にとって非常に重要です。モデルが過剰適合している場合、新しい未確認のデータに対して適切に一般化できない可能性があります。したがって、良い予測はできません。

適切な検証戦略を持つことは、適切な予測を作成し、AI モデルのビジネス価値を活用するための最初のステップです。この記事では、一般的なデータ分割戦略をいくつかまとめました。

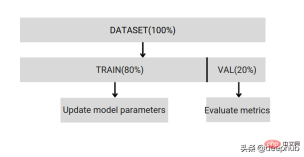

単純なトレーニングとテストの分割

データセットをトレーニングと検証の 2 つの部分に分割し、80% のトレーニングと 20% の検証を使用します。これは、Scikit のランダム サンプリングを使用して行うことができます。

まず、ランダム シードを修正する必要があります。修正しないと、同じデータ分割を比較できず、デバッグ中に結果を再現できません。データセットが小さい場合、検証分割がトレーニング分割と相関関係がないという保証はありません。データのバランスが取れていない場合、同じ分割比は得られません。

したがって、単純な分割は開発とデバッグに役立つだけです。実際のトレーニングは十分に完璧ではないため、次の分割方法はこれらの問題を解決するのに役立ちます。

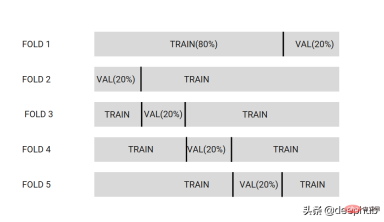

K 分割相互検証

データセットを k 個のパーティションに分割します。以下の画像では、データセットは 5 つのパーティションに分割されています。

#1 つのパーティションを検証データ セットとして選択し、他のパーティションをトレーニング データ セットとして選択します。これにより、異なるパーティションのセットごとにモデルがトレーニングされます。

最終的に、K 個の異なるモデルが取得され、これらのモデルは、後で推論および予測するときに統合手法を使用して一緒に使用されます。

K は通常 [3,5,7,10,20] に設定されます。

低バイアスのモデルのパフォーマンスを確認したい場合は、より高い K [20] を使用します。変数選択用のモデルを構築している場合は、低い k [3,5] を使用すると、モデルの分散が小さくなります。

利点:

- モデル予測を平均化することにより、同じ分布から抽出された目に見えないデータに対するモデルのパフォーマンスを向上させることができます。

- これは、優れた製品モデルを取得するために広く使用されている方法です。

- さまざまな統合手法を使用して、データ セット内の各データの予測を作成し、これらの予測を使用してモデルを改善できます。これは OOF (アウトフォールド予測) と呼ばれます。

質問:

- 不均衡なデータセットがある場合は、Stratified-kFold を使用します。

- すべてのデータセットでモデルを再トレーニングした場合、そのパフォーマンスを k-Fold でトレーニングされたモデルと比較することはできません。このモデルはデータセット全体ではなく、k-1 でトレーニングされるためです。

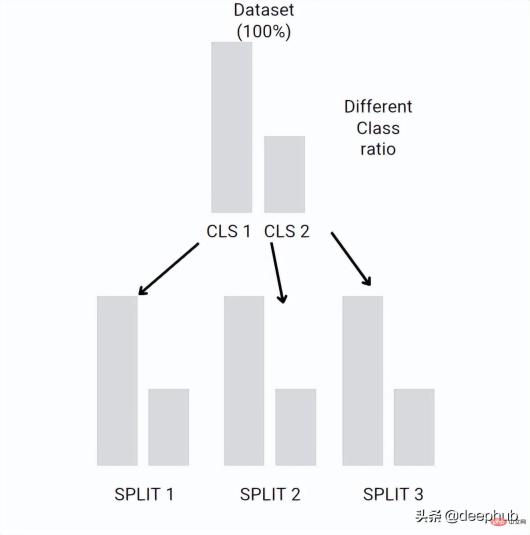

Stratified-kFold

は、各フォールド内の異なるクラス間の比率を保持できます。データセットが不均衡な場合、たとえば、Class1 には 10 個のサンプルがあり、Class2 には 100 個のサンプルがあります。 Stratified-kFold は、元のデータセットと同じ比率で各折り畳み分類を作成します。

この考え方は K 分割交差検証と似ていますが、各折り畳みの比率は元のデータセットと同じです。

各分割では、クラス間の初期比率が保持されます。データセットが大きい場合、K 分割の相互検証でも比率が維持される可能性がありますが、これは確率的であるのに対し、Stratified-kFold は決定論的であり、小さなデータセットで使用できます。

ブートストラップとサブサンプリング

ブートストラップとサブサンプリングは K 分割交差検証に似ていますが、固定された分割はありません。データセットからいくつかのデータをランダムに選択し、他のデータを検証として使用し、

#Bootstrap=交互サンプリングを n 回繰り返します。これについては、以前の記事で詳しく紹介しました。 彼をいつ使用するか?ブートストラップとサブサンプリングは、推定メトリック誤差の標準誤差が大きい場合にのみ使用できます。これは、データセット内の外れ値が原因である可能性があります。 概要通常、機械学習では、k 分割交差検証が開始点として使用されます。データセットが不均衡な場合は、Stratified-kFold が使用されます。外れ値が多い場合は、ブートストラップまたはその他の方法が使用可能 データ分割の改善。以上がデータセットを正しく分割するにはどうすればよいでしょうか? 3 つの一般的な方法のまとめの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

顔を抱きしめます' S 7BモデルオリンピックコダーはClaude 3.7を破っていますか?Apr 23, 2025 am 11:49 AM

顔を抱きしめます' S 7BモデルオリンピックコダーはClaude 3.7を破っていますか?Apr 23, 2025 am 11:49 AMFaceのOlympiccoder-7Bを抱き締める:強力なオープンソースコード推論モデル 優れたコードに焦点を当てた言語モデルを開発するための競争は激化しており、顔を抱き締めることは、恐るべき競争相手との競争に参加しました:Olympiccoder-7B、製品

4つの新しいジェミニ機能は、見逃す余裕がありますApr 23, 2025 am 11:48 AM

4つの新しいジェミニ機能は、見逃す余裕がありますApr 23, 2025 am 11:48 AMAIが質問に答えるだけでなく、AIができることを望んでいる人は何人いますか?私は自分が持っていることを知っています、そして最近、私はそれがどのように変容しているかに驚いています。 aiチャットボットはもうチャットするだけでなく、作成することです。

Camundaは、エージェントAIオーケストレーションの新しいスコアを作成しますApr 23, 2025 am 11:46 AM

Camundaは、エージェントAIオーケストレーションの新しいスコアを作成しますApr 23, 2025 am 11:46 AMSmart AIは、エンタープライズソフトウェアプラットフォームとアプリケーションのあらゆるレベルのレベルに統合され始めているため(強力なコアツールと信頼性の低いシミュレーションツールの両方があることを強調する必要があります)、これらのエージェントを管理するための新しいインフラストラクチャ機能のセットが必要です。 ドイツのベルリンに拠点を置くプロセスオーケストレーション会社であるCamundaは、Smart AIが適切な役割を果たし、新しいデジタル職場での正確なビジネス目標とルールと一致するのに役立つと考えています。同社は現在、組織がAIエージェントのモデル化、展開、管理を支援するように設計されたインテリジェントオーケストレーション機能を提供しています。 実用的なソフトウェアエンジニアリングの観点から、これはどういう意味ですか? 確実性と非決定的プロセスの統合 同社は、鍵はユーザー(通常はデータサイエンティスト、ソフトウェア)を許可することだと言いました

キュレーションされたエンタープライズAIエクスペリエンスに価値はありますか?Apr 23, 2025 am 11:45 AM

キュレーションされたエンタープライズAIエクスペリエンスに価値はありますか?Apr 23, 2025 am 11:45 AM次の'25年にGoogle Cloudに参加して、GoogleがどのようにAIの製品を区別するかを見たいと思っていました。 エージェントスペース(ここで説明)とカスタマーエクスペリエンススイート(ここで説明)に関する最近の発表は、ビジネス価値を強調し、

ぼろきれに最適な多言語埋め込みモデルを見つける方法は?Apr 23, 2025 am 11:44 AM

ぼろきれに最適な多言語埋め込みモデルを見つける方法は?Apr 23, 2025 am 11:44 AM検索拡張生成(RAG)システムのための最適な多言語埋め込みモデルの選択 今日の相互接続された世界では、効果的な多言語AIシステムを構築することが最重要です。 REには、堅牢な多言語埋め込みモデルが重要です

ムスク:オースティンのロボタキシスは、10,000マイルごとに介入が必要ですApr 23, 2025 am 11:42 AM

ムスク:オースティンのロボタキシスは、10,000マイルごとに介入が必要ですApr 23, 2025 am 11:42 AMテスラのオースティンロボタキシローンチ:マスクの主張を詳しく見る Elon Muskは最近、テキサス州オースティンでのテスラの今後のRobotaxi発売を発表しました。当初、安全上の理由で10〜20台の車両の小さな艦隊を展開し、迅速な拡大を計画しました。 h

AI'の衝撃的なピボット:作業ツールからデジタルセラピストやライフコーチまでApr 23, 2025 am 11:41 AM

AI'の衝撃的なピボット:作業ツールからデジタルセラピストやライフコーチまでApr 23, 2025 am 11:41 AM人工知能の適用方法は予期しない場合があります。当初、私たちの多くは、それが主にコードの作成やコンテンツの作成など、創造的で技術的なタスクに使用されていると思うかもしれません。 ただし、Harvard Business Reviewによって報告された最近の調査では、そうではないことが示されています。ほとんどのユーザーは、仕事だけでなく、サポート、組織、さらには友情のために人工知能を求めています! 報告書は、AIアプリケーションの最初のケースは治療と交際であると述べています。これは、その24時間年中無休の可用性と匿名の正直なアドバイスとフィードバックを提供する能力が非常に価値があることを示しています。 一方、マーケティングタスク(ブログの作成、ソーシャルメディアの投稿の作成、広告コピーなど)は、一般的な使用リストではるかに低くランク付けされています。 なぜこれがなぜですか?研究の結果とそれがどのように続くかを見てみましょう

企業はAIエージェントの採用に向けて競い合っていますApr 23, 2025 am 11:40 AM

企業はAIエージェントの採用に向けて競い合っていますApr 23, 2025 am 11:40 AMAIエージェントの台頭は、ビジネス環境を変えています。 Cloud Revolutionと比較して、AIエージェントの影響は指数関数的に大きく、知識作業に革命をもたらすことを約束していると予測されています。 人間の意思決定-makiをシミュレートする能力

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

VSCode Windows 64 ビットのダウンロード

Microsoft によって発売された無料で強力な IDE エディター

MinGW - Minimalist GNU for Windows

このプロジェクトは osdn.net/projects/mingw に移行中です。引き続きそこでフォローしていただけます。 MinGW: GNU Compiler Collection (GCC) のネイティブ Windows ポートであり、ネイティブ Windows アプリケーションを構築するための自由に配布可能なインポート ライブラリとヘッダー ファイルであり、C99 機能をサポートする MSVC ランタイムの拡張機能が含まれています。すべての MinGW ソフトウェアは 64 ビット Windows プラットフォームで実行できます。

mPDF

mPDF は、UTF-8 でエンコードされた HTML から PDF ファイルを生成できる PHP ライブラリです。オリジナルの作者である Ian Back は、Web サイトから「オンザフライ」で PDF ファイルを出力し、さまざまな言語を処理するために mPDF を作成しました。 HTML2FPDF などのオリジナルのスクリプトよりも遅く、Unicode フォントを使用すると生成されるファイルが大きくなりますが、CSS スタイルなどをサポートし、多くの機能強化が施されています。 RTL (アラビア語とヘブライ語) や CJK (中国語、日本語、韓国語) を含むほぼすべての言語をサポートします。ネストされたブロックレベル要素 (P、DIV など) をサポートします。

PhpStorm Mac バージョン

最新(2018.2.1)のプロフェッショナル向けPHP統合開発ツール

SublimeText3 英語版

推奨: Win バージョン、コードプロンプトをサポート!