ホームページ >バックエンド開発 >Python チュートリアル >Python クローラーとはどういう意味ですか?

Python クローラーとはどういう意味ですか?

- silencementオリジナル

- 2019-05-14 17:29:0551414ブラウズ

Python クローラーとは、Python Web クローラーを指し、Web スパイダーや Web ロボットとも呼ばれます。これは、特定のルールに従って World Wide Web 情報を自動的にキャプチャするプログラムまたはスクリプトです。他のものは一般的には使用されません。別名アリ、自動インデクサ、エミュレータ、またはワーム。

簡単に言えば、インターネットはサイトとネットワーク機器で構成される大きなネットワークであり、私たちはブラウザを通じてサイトにアクセスし、サイトにはHTML、JS、および CSS コード ブラウザに返されると、これらのコードはブラウザによって解析およびレンダリングされ、リッチでカラフルな Web ページが目の前に表示されます。

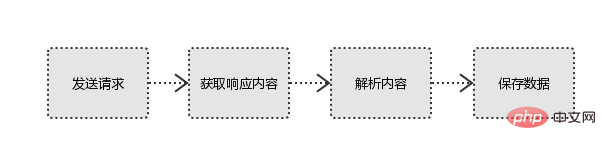

インターネットを例に挙げると、大きな蜘蛛の巣にデータが格納され、蜘蛛の巣の各ノードにデータが保存されます。Python クローラーは小さな蜘蛛で、

自身の獲物 (データ) をネットワークに沿って巡回します。 Web サイトへのリクエスト、取得リソース後の有用なデータを分析して抽出するプログラム;

技術的な観点から、プログラムを通じてサイトをリクエストするブラウザの動作をシミュレートし、HTML コード/JSON データをクロールします。 /バイナリ データ (写真、ビデオ) がサイトから返されます。ローカル エリアに移動し、必要なデータを抽出し、

Python クローラーの基本原則

# を使用してそれを保存します。

以上がPython クローラーとはどういう意味ですか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。