導入

知識が豊富であるが、時には具体的/情報に基づいた応答がない場合、または複雑な質問に直面したときに流fluentに応答しない友人と交流しているとします。ここで私たちがしていることは、現在大規模な言語モデルに存在する見通しに似ています。それらは非常に役立ちますが、配信された構造化された答えの品質と関連性は満足のいくものまたはニッチかもしれません。

この記事では、関数呼び出しや検索の高等世代(RAG)などの将来のテクノロジーがLLMを強化する方法を探ります。より信頼性の高い意味のある会話体験を作成する可能性について説明します。これらのテクノロジーがどのように機能するか、彼らの利点、そして彼らが直面する課題を学びます。私たちの目標は、さまざまなシナリオでLLMのパフォーマンスを向上させるための知識とスキルの両方を装備することです。

この記事は、Datahack Summit 2024で、構造化された出力と機能呼び出しを備えたLLMSの強化に関するAyush Thakurが行った最近の講演に基づいています。

学習成果

- 大規模な言語モデルの基本的な概念と制限を理解します。

- 構造化された出力と関数呼び出しがLLMSのパフォーマンスをどのように強化できるかを学びます。

- LLMSの改善における検索された生成(RAG)の原則と利点を探ります。

- LLMを効果的に評価する際の重要な課題とソリューションを特定します。

- OpenaiモデルとLlamaモデル間の関数呼び出し機能を比較します。

目次

- 導入

- LLMSとは何ですか?

- LLMとの対話:プロンプト

- LLMアプリケーションはモデル開発とどのように異なりますか?

- LLMSを使用した関数呼び出し

- 関数呼び出し:微調整

- LLMSのrag(検索された生成)

- LLMSの評価

- LLMSの出力の制約のある生成

- より構造化された出力のための温度を下げる

- LLMの推論の一連の推論

- OpenaiとLlamaを呼び出す関数

- アプリケーションのLLMSを見つける

- 結論

- よくある質問

LLMSとは何ですか?

大規模な言語モデル(LLM)は、大規模なデータセットに基づいて自然言語を理解し生成するように設計された高度なAIシステムです。 GPT-4やLlamaなどのモデルは、ディープラーニングアルゴリズムを使用してテキストを処理および作成します。これらは多目的で、言語翻訳やコンテンツの作成などのタスクを処理します。膨大な量のデータを分析することにより、LLMは言語パターンを学び、この知識を適用して自然なサウンドの応答を生成します。彼らはテキストを予測し、論理的にフォーマットし、異なる分野で幅広いタスクを実行できるようにします。

LLMSの制限

LLMSの制限を調査しましょう。

- 一貫性のない精度:それらの結果は、特に複雑な状況に対処する場合、特に期待ほど信頼できない場合があります。

- 真の理解の欠如:彼らは合理的に聞こえるかもしれないが、実際には洞察の欠如のために間違った情報やスピンオフになる可能性があるテキストを作成するかもしれません。

- トレーニングデータの制約:生成する出力は、トレーニングデータによって抑制されます。これは、バイアスまたはギャップを含む場合があります。

- 静的な知識ベース: LLMには、リアルタイムで更新されない静的な知識ベースがあり、現在または動的な情報を必要とするタスクの効果が低下します。

LLMSの構造化された出力の重要性

ここで、LLMSの構造化された出力の重要性を検討します。

- 強化された一貫性:構造化された出力は、明確で組織化された形式を提供し、提示された情報の一貫性と関連性を向上させます。

- 使いやすさの向上:特に正確なデータプレゼンテーションが必要なアプリケーションでは、情報を解釈と利用しやすくします。

- 整理されたデータ:構造化された形式は、情報を論理的に整理するのに役立ちます。これは、レポート、要約、またはデータ駆動型の洞察を生成するのに有益です。

- あいまいさの低下:構造化された出力の実装は、あいまいさを減らし、生成されたテキストの全体的な品質を向上させるのに役立ちます。

LLMとの対話:プロンプト

大規模な言語モデル(LLMS)のプロンプトには、いくつかの重要なコンポーネントを使用してプロンプトを作成することが含まれます。

- 指示:LLMがすべきことの明確な指令。

- コンテキスト:背景情報または応答を通知する前にトークン。

- 入力データ:LLMが処理する必要があるメインコンテンツまたはクエリ。

- 出力インジケーター:目的の形式または応答のタイプを指定します。

たとえば、感情を分類するには、「食べ物は大丈夫だと思う」などのテキストを提供し、LLMにニュートラル、ネガティブ、またはポジティブな感情に分類するように依頼します。

実際には、プロンプトにはさまざまなアプローチがあります。

- 入出力:データを直接入力して出力を受信します。

- Chain of Thiness(Cot) :一連のステップを通じてLLMに推論するよう奨励して、出力に到達します。

- COT(COT-SC)との自己整合性:複数の推論パスを使用し、結果の結果を集計して、多数票を通じて精度を向上させます。

これらの方法は、LLMの応答を改善し、出力がより正確で信頼性の高いものになるようにするのに役立ちます。

LLMアプリケーションはモデル開発とどのように異なりますか?

以下の表を調べて、LLMアプリケーションがモデル開発とどのように異なるかを理解しましょう。

| モデル開発 | LLMアプリ | |

| モデル | アーキテクチャはウェイトとバイアスを節約しました | 関数の構成、API、&config |

| データセット | 巨大で、しばしばラベル付けされています | 人間は生成され、しばしば標識されていません |

| 実験 | 高価で長期的な最適化 | 安価で高周波相互作用 |

| トラッキング | メトリック:損失、精度、アクティベーション | アクティビティ:完了、フィードバック、コード |

| 評価 | 目的とスケジュール可能 | 主観的で、人間の入力が必要です |

LLMSを使用した関数呼び出し

LLMSを使用した関数呼び出しには、レスポンス生成プロセスの一部として、大規模な言語モデル(LLMS)が事前定義された関数またはコードスニペットを実行できるようにします。この機能により、LLMは標準テキスト生成を超えて特定のアクションまたは計算を実行できます。関数呼び出しを統合することにより、LLMは外部システムと対話したり、リアルタイムデータを取得したり、複雑な操作を実行したりすることで、さまざまなアプリケーションで有効性と有効性を拡大できます。

関数呼び出しの利点

- インタラクティブ性の強化:関数呼び出しにより、LLMは外部システムと動的に対話し、リアルタイムデータの取得と処理を促進できます。これは、ライブデータクエリや現在の条件に基づくパーソナライズされた応答など、最新情報を必要とするアプリケーションに特に役立ちます。

- 汎用性の向上:関数を実行することにより、LLMSは、計算の実行からデータベースへのアクセスと操作まで、より広範な範囲のタスクを処理できます。この汎用性により、多様なユーザーニーズに対処し、より包括的なソリューションを提供するモデルの能力が向上します。

- 精度の向上:関数呼び出しにより、LLMは出力の精度を改善できる特定のアクションを実行できます。たとえば、外部関数を使用して生成する情報を検証または濃縮し、より正確で信頼できる応答につながることができます。

- 合理化されたプロセス: LLMSへの関数呼び出しを統合すると、繰り返しタスクを自動化し、手動介入の必要性を減らすことにより、複雑なプロセスを合理化できます。この自動化により、より効率的なワークフローと応答時間が短縮される可能性があります。

現在のLLMSによる関数呼び出しの制限

- 限られた統合機能:現在のLLMは、多様な外部システムまたは機能とシームレスに統合される際に課題に直面する可能性があります。この制限により、さまざまなデータソースと対話したり、複雑な操作を効果的に実行する能力を制限したりできます。

- セキュリティとプライバシーの懸念:機能呼び出しは、特にLLMSが機密または個人データと相互作用する場合、セキュリティとプライバシーのリスクを導入できます。潜在的な脆弱性を軽減するには、堅牢な保護と安全な相互作用を確保することが重要です。

- 実行制約: LLMSによる機能の実行は、リソースの制限、処理時間、互換性の問題などの要因によって制約される場合があります。これらの制約は、関数呼び出し機能のパフォーマンスと信頼性に影響を与える可能性があります。

- 管理の複雑さ:関数呼び出し機能の管理と維持は、LLMSの展開と操作に複雑さを加えることができます。これには、取り扱いエラー、さまざまな機能との互換性の確保、呼び出される関数の更新または変更の管理が含まれます。

関数呼び出しはPydanticを満たします

Pydanticオブジェクトは、関数呼び出しのスキーマを定義および変換するプロセスを簡素化し、いくつかの利点を提供します。

- 自動スキーマ変換:PydanticオブジェクトをLLMSの準備ができたスキーマに簡単に変換します。

- 強化されたコード品質:Pydanticは、タイプのチェック、検証、および制御フローを処理し、クリーンで信頼できるコードを確保します。

- 堅牢なエラー処理:エラーと例外を管理するための組み込みメカニズム。

- フレームワークの統合:インストラクター、マーヴィン、ラングチェーン、Llamaindexなどのツールは、構造化された出力にPydanticの機能を利用しています。

関数呼び出し:微調整

ニッチタスクを呼び出す関数の強化には、特定のデータキュレーションのニーズを処理するための小さなLLMSを微調整することが含まれます。特別なトークンやロラの微調整などのテクニックを活用することにより、機能の実行を最適化し、特殊なアプリケーションのモデルのパフォーマンスを向上させることができます。

データキュレーション:効果的な関数呼び出しのための正確なデータ管理に焦点を当てます。

- シングルターンの強制通話:簡単な1回限りの関数実行を実装します。

- 並列呼び出し:同時関数呼び出しを使用する効率を活用します。

- ネストされた呼び出し:ネストされた関数実行と複雑な相互作用を処理します。

- マルチターンチャット:シーケンシャル関数呼び出しで拡張ダイアログを管理します。

特別なトークン:カスタムトークンを使用して、機能の開始と終了をマークして、より良い統合を行います。

モデルトレーニング:基礎効果のために高品質のデータでトレーニングされた命令ベースのモデルから始めます。

Lora微調整:Lora微調整を採用して、管理可能でターゲットを絞った方法でモデルのパフォーマンスを向上させます。

これは、2週間にわたってNVIDIA(NVDA)とApple(AAPL)の株価をプロットするリクエストを示しており、その後、株式データを取得する関数呼び出しが続きます。

LLMSのrag(検索された生成)

検索された生成(RAG)は、検索技術と生成方法を組み合わせて、大規模な言語モデル(LLM)のパフォーマンスを改善します。 RAGは、生成モデル内に検索システムを統合することにより、出力の関連性と品質を向上させます。このアプローチにより、生成された応答がより文脈的に豊富で、実際に正確になることが保証されます。外部の知識を組み込むことにより、RAGは純粋に生成されるモデルのいくつかの制限に対処し、精度と最新の情報を必要とするタスクに対してより信頼性の高い情報に基づいた出力を提供します。生成と検索の間のギャップを埋め、モデル全体の効率を改善します。

ぼろきれの仕組み

重要なコンポーネントは次のとおりです。

- ドキュメントローダー:ドキュメントの読み込みと、処理のためのテキストとメタデータの両方の抽出を担当します。

- チャンク戦略:埋め込みのために、より大きなテキストが小さく、管理可能な部分(チャンク)に分割される方法を定義します。

- 埋め込みモデル:これらのチャンクを数値ベクトルに変換して、効率的な比較と検索を行います。

- Retriever :クエリに基づいて最も関連性の高いチャンクを検索し、応答生成にどれだけ優れているか、正確であるかを判断します。

- ノードパーサーとポストプロセス:フィルタリングとしきい値を処理し、高品質のチャンクのみが前進するようにします。

- 応答シンセサイザー:多くの場合、マルチターンまたはシーケンシャルLLMコールを使用して、検索されたチャンクからコヒーレントな応答を生成します。

- 評価:システムは、精度、事実性をチェックし、応答の幻覚を減らし、実際のデータを確実に反映します。

この画像は、RAGシステムが検索と生成を組み合わせて正確なデータ駆動型の回答を提供する方法を表しています。

- 検索コンポーネント: RAGフレームワークは、関連するドキュメントまたはデータが事前に定義された知識ベースまたは検索エンジンから取得される検索プロセスから始まります。このステップでは、入力クエリまたはコンテキストを使用してデータベースを照会して、最も適切な情報を識別します。

- コンテキスト統合:関連するドキュメントが取得されると、生成モデルのコンテキストを提供するために使用されます。取得した情報は入力プロンプトに統合され、LLMが実際のデータと関連するコンテンツによって通知される応答を生成するのを支援します。

- 生成コンポーネント:生成モデルは濃縮された入力を処理し、検索された情報を組み込んで応答を生成します。この応答は、追加のコンテキストから恩恵を受け、より正確でコンテキスト的に適切な出力につながります。

- 洗練:いくつかの実装では、生成された出力は、さらに処理または再評価されることで洗練される場合があります。このステップにより、最終的な応答が取得された情報と一致し、品質基準を満たすことが保証されます。

LLMSでRAGを使用することの利点

- 精度の向上:外部の知識を組み込むことにより、RAGは生成された出力の事実上の精度を向上させます。検索コンポーネントは、最新かつ関連する情報を提供するのに役立ち、誤ったまたは時代遅れの応答を生成するリスクを減らします。

- コンテキスト関連の強化: RAGを使用すると、LLMは、外部ソースから取得された特定の情報を活用することにより、より文脈的に関連する応答を生成できます。これにより、ユーザーのクエリまたはコンテキストに適した出力が発生します。

- 知識のカバレッジの増加: RAGを使用すると、LLMSはトレーニングデータを超えて幅広い知識にアクセスできます。この拡張されたカバレッジは、モデルの事前に訓練された知識にあまり表現されていない可能性のあるニッチまたは専門的なトピックに関するクエリに対処するのに役立ちます。

- ロングテールクエリのより良い取り扱い: RAGは、ロングテールクエリまたは珍しいトピックの処理に特に効果的です。関連するドキュメントを取得することにより、LLMSは、あまり一般的でない、または高度に具体的なクエリであっても、有益な応答を生成できます。

- ユーザーエクスペリエンスの強化:検索と生成の統合により、より堅牢で有用な応答が提供され、ユーザーエクスペリエンス全体が向上します。ユーザーは、一貫性があるだけでなく、関連する最新の情報にも基づいた回答を受け取ります。

LLMSの評価

大規模な言語モデル(LLMS)を評価することは、さまざまなタスクにわたる有効性、信頼性、および適用性を確保するための重要な側面です。適切な評価は、長所と短所を特定し、改善をガイドし、LLMがさまざまなアプリケーションに必要な基準を満たすことを保証します。

LLMアプリケーションにおける評価の重要性

- 正確性と信頼性を保証します。パフォーマンス評価は、LLMがテキスト生成、要約、質問への回答などのタスクをどの程度よく、一貫して完成させるかを理解するのに役立ちます。そして、私は教室でより全体的なアプローチを推進することに賛成していますが、この方法で特定のフィードバックは、医学や法律などの分野で、非常に特定のタイプのアプリケーションに非常に依存して非常に価値があります。

- ガイドモデルの改善:評価を通じて、開発者はLLMが不足する可能性のある特定の領域を特定できます。このフィードバックは、モデルのパフォーマンスを改良、トレーニングデータの調整、または全体的な有効性を高めるためのアルゴリズムの変更に重要です。

- ベンチマークに対する測定パフォーマンス:確立されたベンチマークに対するLLMSを評価すると、他のモデルや以前のバージョンとの比較が可能になります。このベンチマークプロセスは、モデルのパフォーマンスを理解し、改善の領域を特定するのに役立ちます。

- 倫理的で安全な使用を保証します。LLMSが倫理原則を尊重する程度と安全性に関する基準を決定することに関与しています。これは、バイアス、不要なコンテンツ、およびテクノロジーの責任ある使用を侵害する可能性のあるその他の要因を特定するのに役立ちます。

- 実世界のアプリケーションをサポートする:このため、LLMが実際にどのように機能するかを理解するために、適切かつ徹底的な評価が必要です。これには、さまざまなタスクの解決、さまざまなシナリオで動作し、現実世界のケースで貴重な結果を生み出す際のパフォーマンスを評価することが含まれます。

LLMの評価における課題

- 評価メトリックの主観性:関連性や一貫性の人間の判断など、多くの評価メトリックは主観的です。この主観性により、モデルのパフォーマンスを一貫して評価することが困難になり、結果の変動につながる可能性があります。

- 微妙な理解を測定することの難しさ:複雑または微妙なクエリを理解するLLMの能力を評価することは、本質的に困難です。現在のメトリックは、高品質の出力に必要な理解の深さを完全に捉えていない場合があり、不完全な評価につながる可能性があります。

- スケーラビリティの問題: LLMSの評価は、これらの構造が拡大し、より複雑になるにつれてますます高価になります。また、包括的な評価は時間がかかり、テストプロセスを妨げることができる多くの計算能力が必要であることに注意することも重要です。

- バイアスと公平性の懸念:バイアスが異なる形状や形をとることができるため、LLMSをバイアスと公平性について評価するのは容易ではありません。さまざまな人口統計や状況にわたって精度を確実に保つために、厳密で精巧な評価方法が不可欠です。

- 言語の動的な性質:言語は絶えず進化しており、正確または関連する情報を構成するものは時間とともに変化する可能性があります。評価者は、モデルの動的な性質を考えると、現在のパフォーマンスだけでなく、進化する言語の傾向への適応性についてもLLMSを評価する必要があります。

LLMSの出力の制約のある生成

制約された生成には、LLMに特定の制約またはルールを順守する出力を生成するように指示することが含まれます。このアプローチは、特定の形式の精度と順守が必要な場合に不可欠です。たとえば、法的文書や正式なレポートなどのアプリケーションでは、生成されたテキストが厳格なガイドラインと構造に従うことが重要です。

出力テンプレートの事前定義、コンテンツの境界の設定、またはLLMの応答をガイドするための迅速なエンジニアリングを使用することにより、制約のある生成を実現できます。これらの制約を適用することにより、開発者はLLMの出力が関連性があるだけでなく、必要な基準にも準拠していることを保証でき、無関係またはトピック外の応答の可能性を減らします。

より構造化された出力のための温度を下げる

LLMSの温度パラメーターは、生成されたテキストのランダム性のレベルを制御します。温度を下げると、より予測可能で構造化された出力が得られます。温度がより低い値(0.1〜0.3など)に設定されると、モデルの応答生成はより決定的になり、より高い確率の単語やフレーズを支持します。これにより、よりコヒーレントで、予想される形式と整合する出力につながります。

データの概要や技術文書など、一貫性と精度が重要なアプリケーションの場合、温度を下げることで、応答の方が少なく構造化されます。逆に、温度が高いほど、より多くの変動性と創造性が導入されます。これは、形式と明確さへの厳密な順守を必要とするコンテキストではあまり望ましくない可能性があります。

LLMの推論の一連の推論

チェーンの思考推論は、人間の推論プロセスと同様に、論理的な一連のステップに従うことにより、LLMSが出力を生成することを奨励するテクニックです。この方法では、複雑な問題を小さくて管理しやすいコンポーネントに分解し、各ステップの背後にある思考プロセスを明確にすることが含まれます。

一連の思考推論を採用することにより、LLMSはより包括的で十分に熟した応答を生み出すことができます。これは、問題解決または詳細な説明を含むタスクに特に役立ちます。このアプローチは、生成されたテキストの明確さを高めるだけでなく、モデルの推論プロセスの透明な見解を提供することにより、応答の精度を検証するのにも役立ちます。

OpenaiとLlamaを呼び出す関数

機能呼び出し機能は、OpenaiのモデルとMetaのLlamaモデル間で異なります。 GPT-4などのOpenAIのモデルは、APIを介して高度な関数を呼び出す機能を提供し、外部機能やサービスとの統合を可能にします。この機能により、モデルは、コマンドの実行やデータベースのクエリなど、単なるテキスト生成を超えたタスクを実行できます。

一方、MetaのLlamaモデルには、実装と範囲が異なる可能性がある独自の関数呼び出しメカニズムがあります。両方のタイプのモデルが機能呼び出しをサポートしますが、統合、パフォーマンス、および機能の詳細はさまざまです。これらの違いを理解することは、外部システムまたは特殊な機能ベースの操作との複雑な相互作用を必要とするアプリケーションに適切なモデルを選択するために重要です。

アプリケーションのLLMSを見つける

アプリケーションに適切な大手言語モデル(LLM)を選択するには、その機能、スケーラビリティ、および特定のデータと統合のニーズをどの程度満たすかを評価する必要があります。

Baichuan、Chatglm、Deepseek、InternLM2などのさまざまなシリーズのさまざまな大手言語モデル(LLMS)のパフォーマンスベンチマークを参照するのは良いことです。ここ。コンテキストの長さと針数に基づいてパフォーマンスを評価します。これは、特定のタスクに対してどのLLMSを選択するかのアイデアを取得するのに役立ちます。

アプリケーションに適した大型言語モデル(LLM)を選択するには、モデルの機能、データ処理要件、統合の可能性などの要因を評価することが含まれます。モデルのサイズ、微調整オプション、特殊な機能のサポートなどの側面を考慮してください。これらの属性をアプリケーションのニーズに合わせると、最適なパフォーマンスを提供し、特定のユースケースに合わせるLLMを選択するのに役立ちます。

LMSYSチャットボットアリーナリーダーボードは、人間のペアワイズ比較を通じて大規模な言語モデル(LLM)をランキングするためのクラウドソーシングプラットフォームです。ブラッドリーテリーモデルを使用して、さまざまなカテゴリのパフォーマンスを評価する投票に基づいてモデルのランキングを表示します。

結論

要約すると、LLMSは、関数呼び出しや検索の高まり(RAG)などの進歩とともに進化しています。これらは、構造化された出力とリアルタイムデータの取得を追加することにより、能力を向上させます。 LLMは大きな可能性を示していますが、精度とリアルタイムの更新の制限は、さらなる改良の必要性を強調しています。制約された生成、温度の低下、一連の思考の推論などの手法は、その出力の信頼性と関連性を高めるのに役立ちます。これらの進歩は、LLMをさまざまなアプリケーションでより効果的かつ正確にすることを目的としています。

OpenaiモデルとLlamaモデルでの関数呼び出しの違いを理解することは、特定のタスクに適したツールを選択するのに役立ちます。 LLMテクノロジーが進むにつれて、これらの課題に取り組み、これらの技術を使用することが、異なるドメインでパフォーマンスを向上させるための鍵となります。これらの区別を活用すると、さまざまなアプリケーションでの有効性が最適化されます。

よくある質問

Q1。 LLMSの主な制限は何ですか?A. LLMは、多くの場合、正確性、リアルタイムの更新に苦労し、トレーニングデータによって制限され、信頼性に影響を与える可能性があります。

Q2。検索された世代(RAG)はLLMSにどのように利益をもたらしますか?A. RAGは、リアルタイムデータの検索を組み込み、生成された出力の精度と関連性を改善することにより、LLMSを強化します。

Q3。 LLMSのコンテキストでの関数呼び出しとは何ですか?A.関数呼び出しにより、LLMはテキスト生成中に特定の関数またはクエリを実行し、複雑なタスクを実行し、正確な結果を提供する能力を向上させることができます。

Q4。温度の低下はLLM出力にどのように影響しますか?A. LLMSの温度を下げると、テキスト生成のランダム性を低下させることにより、より構造化された予測可能な出力が得られ、より明確でより一貫した応答につながります。

Q5。 LLMSの推論のチェーンとは何ですか?A.一連の思考推論には、情報を順次処理して論理的で一貫した議論または説明を構築し、LLM出力の深さと明確さを強化することが含まれます。

以上が構造化された出力と関数呼び出しでLLMを強化しますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

7強力なAIは、すべてのプロジェクトマネージャーが今習得する必要があるプロンプトをプロンプトしますMay 08, 2025 am 11:39 AM

7強力なAIは、すべてのプロジェクトマネージャーが今習得する必要があるプロンプトをプロンプトしますMay 08, 2025 am 11:39 AMChatGptのようなチャットボットによって例示される生成AIは、プロジェクトマネージャーにワークフローを合理化し、プロジェクトが予定外で予算内に留まることを保証する強力なツールを提供します。 ただし、正しいプロンプトを作成するのに効果的な使用のヒンジ。 正確、詳細

AI自体の有益な支援を介して、とらえどころのないAGIの不明確な意味を定義するMay 08, 2025 am 11:37 AM

AI自体の有益な支援を介して、とらえどころのないAGIの不明確な意味を定義するMay 08, 2025 am 11:37 AM人工一般情報(AGI)を定義するという課題は重要です。 AGIの進捗状況の主張は、しばしば明確なベンチマークを欠いており、定義は事前に決定された研究の方向に合うように調整されています。この記事では、定義への新しいアプローチを探ります

IBMは、2025が生成AIにおけるWatsonx.dataの役割を紹介していると考えていますMay 08, 2025 am 11:32 AM

IBMは、2025が生成AIにおけるWatsonx.dataの役割を紹介していると考えていますMay 08, 2025 am 11:32 AMIBM WATSONX.DATA:エンタープライズAIデータスタックの合理化 IBMは、Watsonx.Dataを、正確でスケーラブルな生成AIソリューションの提供を加速することを目的とした企業向けの重要なプラットフォームとして位置付けています。 これは、Complを簡素化することによって達成されます

ヒューマノイドロボットマシンの台頭が近づいています。May 08, 2025 am 11:29 AM

ヒューマノイドロボットマシンの台頭が近づいています。May 08, 2025 am 11:29 AMAIおよび材料科学のブレークスルーに促進されたロボット工学の急速な進歩は、ヒューマノイドロボットの新しい時代を導く態勢が整っています。 何年もの間、産業自動化が主な焦点でしたが、ロボットの能力は急速に経験しています

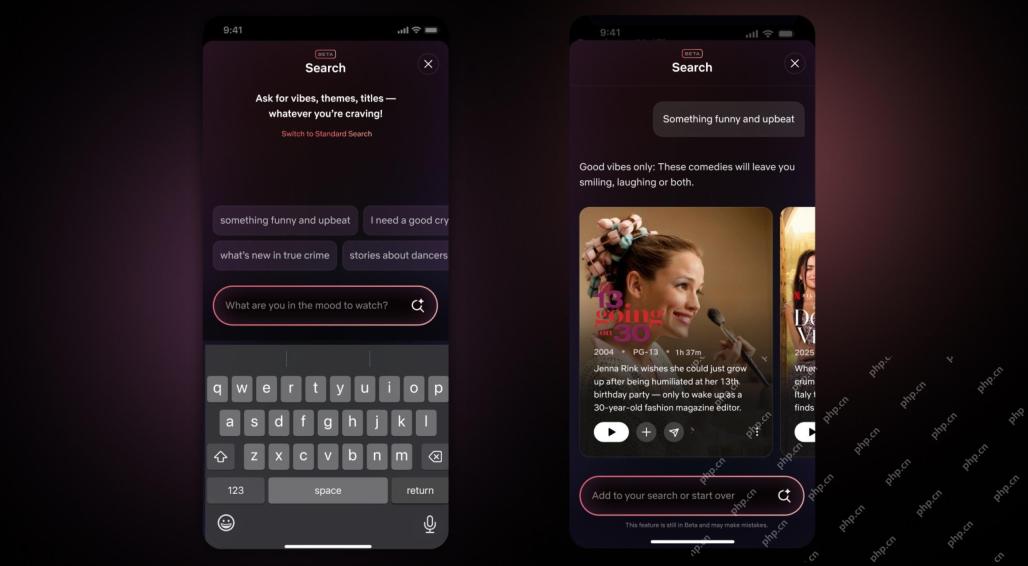

Netflix Revamps Interface - AI検索ツールとTiktokのようなデザインのデビューMay 08, 2025 am 11:25 AM

Netflix Revamps Interface - AI検索ツールとTiktokのようなデザインのデビューMay 08, 2025 am 11:25 AM10年以内のNetflixインターフェイスの最大のアップデート:よりスマートでパーソナライズされた、採用される多様なコンテンツ Netflixは、10年でユーザーインターフェイスの最大の改良を発表しました。新しい外観だけでなく、各ショーに関する情報をさらに追加し、「アンビエント」やより柔軟な構造を理解するための曖昧な概念を理解できるよりスマートなAI検索ツールを紹介し、新興ビデオゲーム、ライブイベント、スポーツイベント、その他の新しいタイプのコンテンツにおいてよりよく示すことができます。 トレンドに対応するために、モバイルの新しい垂直ビデオコンポーネントにより、ファンはトレーラーやクリップをスクロールしたり、完全なショーを見たり、他の人とコンテンツを共有したりすることが容易になります。これは、無限のスクロールと非常に成功した短いビデオWebサイトTIを思い出させます

AGIのずっと前:あなたに挑戦する3つのAIマイルストーンMay 08, 2025 am 11:24 AM

AGIのずっと前:あなたに挑戦する3つのAIマイルストーンMay 08, 2025 am 11:24 AM人工知能における一般的な知能(AGI)の議論の高まりにより、人工知能が人間の知能を上回ると何が起こるかについて多くの人が考えるようになりました。この瞬間が近いか遠いかは、あなたが尋ねる人に依存しますが、私たちが焦点を当てるべき最も重要なマイルストーンであるとは思いません。どの以前のAIマイルストーンがすべての人に影響を与えますか?どんなマイルストーンが達成されましたか?ここに私が起こったと思う3つのことがあります。 人工知能は人間の弱点を上回ります 2022年の映画「社会的ジレンマ」で、人道技術センターのトリスタン・ハリスは、人工知能が人間の弱点を上回っていることを指摘しました。これはどういう意味ですか?これは、人工知能が人間を使用することができたことを意味します

Transunionのプラットフォーム変換とAIの野望に関するVenkat AchantaMay 08, 2025 am 11:23 AM

Transunionのプラットフォーム変換とAIの野望に関するVenkat AchantaMay 08, 2025 am 11:23 AMTransunionのCTOであるRanganath Achantaは、2021年後半にNeustarの買収に続いて会社に入社して以来、重要な技術的変革を主導しました。

AIへの信頼が跳ね上がると、生産性が続きますMay 08, 2025 am 11:11 AM

AIへの信頼が跳ね上がると、生産性が続きますMay 08, 2025 am 11:11 AMBuilding Trustは、ビジネスでのAIの採用を成功させるために最重要です。 これは、ビジネスプロセス内の人間の要素を考えると特に当てはまります。 従業員は、他の人と同様に、AIとその実装に関する懸念を抱いています。 デロイトの研究者はSCです

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

SublimeText3 Linux 新バージョン

SublimeText3 Linux 最新バージョン

WebStorm Mac版

便利なJavaScript開発ツール

ZendStudio 13.5.1 Mac

強力な PHP 統合開発環境

MantisBT

Mantis は、製品の欠陥追跡を支援するために設計された、導入が簡単な Web ベースの欠陥追跡ツールです。 PHP、MySQL、Web サーバーが必要です。デモおよびホスティング サービスをチェックしてください。

SublimeText3 中国語版

中国語版、とても使いやすい