GPTやLlamaなどの大規模な言語モデル(LLM)は、スマートチャットボットの作成から複雑なコードスニペットの生成まで、言語タスクの処理方法に革命をもたらしました。顔を抱きしめるなどのクラウドプラットフォームは、これらのモデルの使用を簡素化しますが、場合によっては、独自のコンピューターでLLMをローカルに実行することがより賢明な選択です。なぜ?プライバシーが大きくなるため、特定のニーズに合わせてカスタマイズを可能にし、コストを大幅に削減できます。 LLMをローカルに実行すると、完全なコントロールが得られ、自分の条件でその力を活用できます。

いくつかの簡単なステップで、OllamaとHugging Faceを使用してシステムでLLMを実行する方法を見てみましょう!

次のビデオでは、プロセスを段階的に説明しています。

1分でローカルにLLMを実行する方法[初心者フレンドリー]

OllamaとHugging Faceビデオリンクを使用します

- ディラン(@Dylan Ebert )2025年1月6日

LLMをローカルに実行する手順

ステップ1:オラマをダウンロードします

まず、ブラウザで「Ollama」を検索し、システムにダウンロードしてインストールします。

ステップ2:最高のオープンソースLLMを見つけます

次に、「Face LLMランキング」を検索して、トップオープンソース言語モデルのリストを見つけます。

ステップ3:デバイスに基づいてモデルをフィルタリングします

リストが表示されたら、フィルターを適用して、セットアップに最適なモデルを見つけます。例えば:

- 家庭用消費者グレードのデバイスを選択してください。

- 非公式または未検証のモデルを避けるために、公式プロバイダーのみを選択します。

- ラップトップにローエンドGPUが付属している場合は、エッジデバイス用に設計されたモデルを選択してください。

QWEN/QWEN2.5-35Bなどのトップランクモデルをクリックします。画面の右上隅で、[このモデルを使用]をクリックします。ただし、ここではオプションとしてオラマを見つけることができません。

これは、OllamaがGGUFと呼ばれる特別な形式を使用しているためです。これは、モデルのより小さく、高速で定量的なバージョンです。

(注:量子化は品質をわずかに低下させますが、現地での使用に適しています。)

GGUF形式でモデルを取得します。

- ランキングの「定量化された」セクションに移動します。ここに約80のモデルがあります。これらのモデルをほとんどのダウンロードで並べ替えます。

Bartowskiなどの名前に「GGUF」のモデルを探してください。これは良い選択です。

- このモデルを選択し、[Ollamaでこのモデルを使用]をクリックします。

- 定量設定の場合は、GPU RAMよりも1〜2GB小さいファイルサイズを選択するか、Q5_K_Mなどの推奨オプションを選択します。

ステップ5:ダウンロードしてモデルの使用を開始します

お好みのモデルに提供されているコマンドをコピーし、端末に貼り付けます。 「Enter」キーを押して、ダウンロードが完了するのを待ちます。

ダウンロードが完了したら、他のLLMと同じようにモデルとのチャットを開始できます。シンプルで楽しい!

それでおしまい!これで、デバイスでローカルで強力なLLMを実行しています。これらの手順が以下のコメントセクションで機能するかどうかを教えてください。

以上が1分でLLMSをローカルに実行する方法は?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

LM Studioを使用してLLMをローカルに実行する方法は? - 分析VidhyaApr 19, 2025 am 11:38 AM

LM Studioを使用してLLMをローカルに実行する方法は? - 分析VidhyaApr 19, 2025 am 11:38 AM自宅で大規模な言語モデルを簡単に実行する:LM Studioユーザーガイド 近年、ソフトウェアとハードウェアの進歩により、パーソナルコンピューターで大きな言語モデル(LLM)を実行することが可能になりました。 LM Studioは、このプロセスを簡単かつ便利にするための優れたツールです。この記事では、LM Studioを使用してLLMをローカルに実行する方法に飛び込み、重要なステップ、潜在的な課題、LLMをローカルに配置することの利点をカバーします。あなたが技術愛好家であろうと、最新のAIテクノロジーに興味があるかどうかにかかわらず、このガイドは貴重な洞察と実用的なヒントを提供します。始めましょう! 概要 LLMをローカルに実行するための基本的な要件を理解してください。 コンピューターにLM Studiをセットアップします

Guy Periは、データ変換を通じてMcCormickの未来のフレーバーを支援しますApr 19, 2025 am 11:35 AM

Guy Periは、データ変換を通じてMcCormickの未来のフレーバーを支援しますApr 19, 2025 am 11:35 AMGuy Periは、McCormickの最高情報およびデジタルオフィサーです。彼の役割からわずか7か月後ですが、ペリは同社のデジタル能力の包括的な変革を急速に進めています。データと分析に焦点を当てている彼のキャリアに焦点が当てられています

迅速なエンジニアリングの感情の連鎖は何ですか? - 分析VidhyaApr 19, 2025 am 11:33 AM

迅速なエンジニアリングの感情の連鎖は何ですか? - 分析VidhyaApr 19, 2025 am 11:33 AM導入 人工知能(AI)は、言葉だけでなく感情も理解し、人間のタッチで反応するように進化しています。 この洗練された相互作用は、AIおよび自然言語処理の急速に進む分野で重要です。 th

データサイエンスワークフローのための12のベストAIツール-AnalyticsVidhyaApr 19, 2025 am 11:31 AM

データサイエンスワークフローのための12のベストAIツール-AnalyticsVidhyaApr 19, 2025 am 11:31 AM導入 今日のデータ中心の世界では、競争力と効率の向上を求める企業にとって、高度なAIテクノロジーを活用することが重要です。 さまざまな強力なツールにより、データサイエンティスト、アナリスト、開発者が構築、Deplを作成することができます。

AV BYTE:OpenAIのGPT-4O MINIおよびその他のAIイノベーションApr 19, 2025 am 11:30 AM

AV BYTE:OpenAIのGPT-4O MINIおよびその他のAIイノベーションApr 19, 2025 am 11:30 AM今週のAIの風景は、Openai、Mistral AI、Nvidia、Deepseek、Hugging Faceなどの業界の巨人からの画期的なリリースで爆発しました。 これらの新しいモデルは、TRの進歩によって促進された電力、手頃な価格、アクセシビリティの向上を約束します

PerplexityのAndroidアプリにはセキュリティの欠陥が感染しているとレポートApr 19, 2025 am 11:24 AM

PerplexityのAndroidアプリにはセキュリティの欠陥が感染しているとレポートApr 19, 2025 am 11:24 AMしかし、検索機能を提供するだけでなくAIアシスタントとしても機能する同社のAndroidアプリは、ユーザーをデータの盗難、アカウントの買収、および悪意のある攻撃にさらす可能性のある多くのセキュリティ問題に悩まされています。

誰もがAIの使用が上手になっています:バイブコーディングに関する考えApr 19, 2025 am 11:17 AM

誰もがAIの使用が上手になっています:バイブコーディングに関する考えApr 19, 2025 am 11:17 AM会議や展示会で何が起こっているのかを見ることができます。エンジニアに何をしているのか尋ねたり、CEOに相談したりできます。 あなたが見ているところはどこでも、物事は猛烈な速度で変化しています。 エンジニア、および非エンジニア 違いは何ですか

Rocketpyを使用したロケットの起動シミュレーションと分析-AnalyticsVidhyaApr 19, 2025 am 11:12 AM

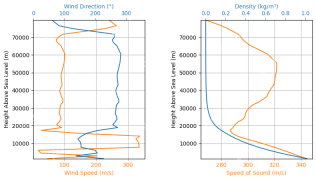

Rocketpyを使用したロケットの起動シミュレーションと分析-AnalyticsVidhyaApr 19, 2025 am 11:12 AMRocketpy:A包括的なガイドでロケット発売をシミュレートします この記事では、強力なPythonライブラリであるRocketpyを使用して、高出力ロケット発売をシミュレートすることをガイドします。 ロケットコンポーネントの定義からシミュラの分析まで、すべてをカバーします

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

SublimeText3 Linux 新バージョン

SublimeText3 Linux 最新バージョン

Dreamweaver Mac版

ビジュアル Web 開発ツール

ZendStudio 13.5.1 Mac

強力な PHP 統合開発環境

SecLists

SecLists は、セキュリティ テスターの究極の相棒です。これは、セキュリティ評価中に頻繁に使用されるさまざまな種類のリストを 1 か所にまとめたものです。 SecLists は、セキュリティ テスターが必要とする可能性のあるすべてのリストを便利に提供することで、セキュリティ テストをより効率的かつ生産的にするのに役立ちます。リストの種類には、ユーザー名、パスワード、URL、ファジング ペイロード、機密データ パターン、Web シェルなどが含まれます。テスターはこのリポジトリを新しいテスト マシンにプルするだけで、必要なあらゆる種類のリストにアクセスできるようになります。

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)