TIIのファルコン3:オープンソースの革新的な飛躍

TIIのAIの再定義の野心的な追求は、Advanced Falcon 3モデルで新たな高みに達します。 この最新のイテレーションは、新しいパフォーマンスベンチマークを確立し、オープンソースAIの機能を大幅に進めます。

Falcon 3の軽量アーキテクチャは、人間技術の相互作用に革命をもたらします。小型デバイスでのシームレスなパフォーマンスは、優れたコンテキスト処理と相まって、高度なAIの大きなブレークスルーを表しています。 このモデルのトレーニングデータは、印象的な14兆トークン(ダブルファルコン2の5.5兆を超える)に拡張され、その卓越したパフォーマンスと効率に貢献しています。主要な機能と改善

- パフォーマンスと効率の向上:

- FALCON 3のアーキテクチャは、速度とリソース利用の大幅な改善を実現します。 スケーラブルなモデルサイズ: さまざまなサイズ(1b、3b、7b、および10bパラメーター)で利用可能、多様なアプリケーションに柔軟性を提供します。

- 高度なテキスト生成:テキスト生成における例外的な機能、微妙なコンテキストの理解とタスク固有のアプリケーションを含む。

- 将来のマルチモーダル機能:マルチモーダル機能の計画された統合(画像、ビデオ、音声処理)は、画期的な進歩を約束します。

- この記事は、データサイエンスブログの一部です 目次

FALCON 3モデルのバリエーション アーキテクチャデザイン

パフォーマンスベンチマーク Multimodal Future(2025)

- マルチモーダルアプリケーションの例

- Falcon 3-7Bの使用

- を使用しています アプリケーションと制限

- 結論

- よくある質問

- FALCON 3モデルのバリエーション

- Falcon 3は、会話アプリケーションのベースと指示バージョンを備えたいくつかのサイズ(1b、3b、7b、および10bパラメーター)で提供されています。 TIIは、標準のAPIおよびライブラリサポート、および量子化モデル(INT4、INT8、および1.5 BISNET)の可用性を通じて幅広い互換性を確保しています。 モデルは多くの一般的な言語をサポートしていますが、英語、フランス語、ポルトガル語、スペイン語でも専門的なバージョンを利用できます。

- アーキテクチャデザイン

FALCON 3は、効率的なクエリ注意グループ化のためにFlash Atterness 2を利用してデコーダーのみのアーキテクチャを採用しています。 この最適化されたアーキテクチャは、メモリの使用量を最小限に抑え、推論中の効率を最大化します。 131Kトークン(ダブルファルコン2)をサポートすると、長いコンテキストと多様なタスクの取り扱いに優れています。 その固有の効率は、リソースに制約のある環境でも効果的な動作を可能にします。

パフォーマンスベンチマーク

Falcon 3は、さまざまなベンチマークで他の小さなLLMを上回り、顔を抱きしめ、堅牢な機能でQwenのパフォーマンスを超えるようなオープンソースの代替品を上回ります。 指示バージョンはグローバルにリードし、適応性を実証し、会話およびタスク固有のアプリケーションで優れています。 スケーラブルでリソース効率の高いデザインは、優れたベンチマークスコアに貢献しています。 2025年のマルチモーダル機能

TIIのロードマップには、マルチモーダル機能を備えたFalcon 3の拡大、画像、ビデオ、音声処理の統合が含まれます。これにより、テキストベースの画像とビデオ生成、音声からテキスト、テキスト間の機能が可能になります。 この拡張は、研究者、開発者、および企業に大きな利益をもたらします

マルチモーダル機能の例潜在的なマルチモーダルアプリケーションには、視覚的な質問への回答、音声処理、画像からテキスト、テキストからイメージへの変換(検索アプリケーションに役立つ)、画像セグメンテーション、および生成AI。 Falcon 3-7Bの使用次のコードスニペットは、テキスト生成のためにFalcon 3-7B指示モデルを使用して示すものです:

ライブラリのインポート:

モデルの読み込みと初期化:

テキスト処理と生成:

import torch from transformers import AutoModelForCausalLM, AutoTokenizer

model_id = "tiiuae/Falcon3-7B-Instruct-1.58bit"

model = AutoModelForCausalLM.from_pretrained(model_id, torch_dtype=torch.bfloat16).to("cuda")

tokenizer = AutoTokenizer.from_pretrained(model_id)

アプリケーションと制限

Falcon 3は、拡張コンテキストハンドリング(32Kトークン)、複雑な数学的問題解決(特に10Bベースモデル)、およびコード習熟度に優れています。 ただし、現在の言語サポートは限られており(英語、スペイン語、フランス語、ドイツ語)、マルチモーダル機能はまだ開発中です。input_prompt = "Explain the concept of reinforcement learning in simple terms:"

inputs = tokenizer(input_prompt, return_tensors="pt").to("cuda")

output = model.generate(**inputs, max_length=200, num_return_sequences=1, temperature=0.7, top_p=0.9, top_k=50, do_sample=True)

generated_text = tokenizer.decode(output[0], skip_special_tokens=True)

print(generated_text)

結論

Falcon 3は、オープンソースAIに対するTIIのコミットメントを紹介し、高性能、汎用性、効率を提供します。 その高度な機能とマルチモーダル拡張の可能性は、フィールドでの大きな進歩となっています。 キーテイクアウェイ

Falcon 2と比較した優れたコンテキスト処理

リソース効率の良い設計と簡単な統合。 さまざまなドメインにわたる汎用性の高いアプリケーション。

リソース

A.軽量設計、高度なトークン化、拡張コンテキスト処理。

q2。 Falcon 3は、他のオープンソースLLMと比較していますか? q3。 FALCON 3のいくつかのアプリケーションは何ですか?A.テキスト生成、複雑な問題解決、およびコード生成。

(注:ブラケットを交換しますhttps://www.php.cn/https://www.php.cn/https://www.php.cn/https://www.php.cn/link/2bec63f5d312303621583b97f F7C68BF/2BEC63F5D312303621583B97F7C68BF/2BEC63F5D312303621583B97FF7C68BF/2BEC63F5D312303621583B97F7C68BFS実際にhttps://www.php.cn/https://www.php.cn/https://www.php.cn/https://www.php.cn/link/2bec63f5d312303621583b97f F7C68BF/2BEC63F5D312303621583B97F7C68BF/2BEC63F5D312303621583B97FF7C68BF/2BEC63F5D312303621583B97F7C68BFS関連するリソースに

よくある質問

以上がFalcon 3-7Bの指示の使用方法は?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

7強力なAIは、すべてのプロジェクトマネージャーが今習得する必要があるプロンプトをプロンプトしますMay 08, 2025 am 11:39 AM

7強力なAIは、すべてのプロジェクトマネージャーが今習得する必要があるプロンプトをプロンプトしますMay 08, 2025 am 11:39 AMChatGptのようなチャットボットによって例示される生成AIは、プロジェクトマネージャーにワークフローを合理化し、プロジェクトが予定外で予算内に留まることを保証する強力なツールを提供します。 ただし、正しいプロンプトを作成するのに効果的な使用のヒンジ。 正確、詳細

AI自体の有益な支援を介して、とらえどころのないAGIの不明確な意味を定義するMay 08, 2025 am 11:37 AM

AI自体の有益な支援を介して、とらえどころのないAGIの不明確な意味を定義するMay 08, 2025 am 11:37 AM人工一般情報(AGI)を定義するという課題は重要です。 AGIの進捗状況の主張は、しばしば明確なベンチマークを欠いており、定義は事前に決定された研究の方向に合うように調整されています。この記事では、定義への新しいアプローチを探ります

IBMは、2025が生成AIにおけるWatsonx.dataの役割を紹介していると考えていますMay 08, 2025 am 11:32 AM

IBMは、2025が生成AIにおけるWatsonx.dataの役割を紹介していると考えていますMay 08, 2025 am 11:32 AMIBM WATSONX.DATA:エンタープライズAIデータスタックの合理化 IBMは、Watsonx.Dataを、正確でスケーラブルな生成AIソリューションの提供を加速することを目的とした企業向けの重要なプラットフォームとして位置付けています。 これは、Complを簡素化することによって達成されます

ヒューマノイドロボットマシンの台頭が近づいています。May 08, 2025 am 11:29 AM

ヒューマノイドロボットマシンの台頭が近づいています。May 08, 2025 am 11:29 AMAIおよび材料科学のブレークスルーに促進されたロボット工学の急速な進歩は、ヒューマノイドロボットの新しい時代を導く態勢が整っています。 何年もの間、産業自動化が主な焦点でしたが、ロボットの能力は急速に経験しています

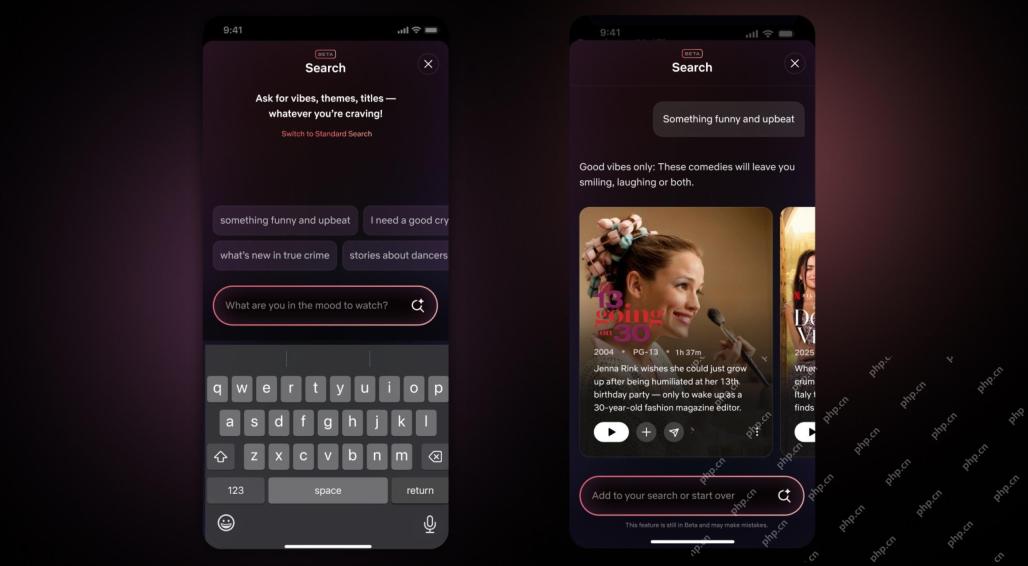

Netflix Revamps Interface - AI検索ツールとTiktokのようなデザインのデビューMay 08, 2025 am 11:25 AM

Netflix Revamps Interface - AI検索ツールとTiktokのようなデザインのデビューMay 08, 2025 am 11:25 AM10年以内のNetflixインターフェイスの最大のアップデート:よりスマートでパーソナライズされた、採用される多様なコンテンツ Netflixは、10年でユーザーインターフェイスの最大の改良を発表しました。新しい外観だけでなく、各ショーに関する情報をさらに追加し、「アンビエント」やより柔軟な構造を理解するための曖昧な概念を理解できるよりスマートなAI検索ツールを紹介し、新興ビデオゲーム、ライブイベント、スポーツイベント、その他の新しいタイプのコンテンツにおいてよりよく示すことができます。 トレンドに対応するために、モバイルの新しい垂直ビデオコンポーネントにより、ファンはトレーラーやクリップをスクロールしたり、完全なショーを見たり、他の人とコンテンツを共有したりすることが容易になります。これは、無限のスクロールと非常に成功した短いビデオWebサイトTIを思い出させます

AGIのずっと前:あなたに挑戦する3つのAIマイルストーンMay 08, 2025 am 11:24 AM

AGIのずっと前:あなたに挑戦する3つのAIマイルストーンMay 08, 2025 am 11:24 AM人工知能における一般的な知能(AGI)の議論の高まりにより、人工知能が人間の知能を上回ると何が起こるかについて多くの人が考えるようになりました。この瞬間が近いか遠いかは、あなたが尋ねる人に依存しますが、私たちが焦点を当てるべき最も重要なマイルストーンであるとは思いません。どの以前のAIマイルストーンがすべての人に影響を与えますか?どんなマイルストーンが達成されましたか?ここに私が起こったと思う3つのことがあります。 人工知能は人間の弱点を上回ります 2022年の映画「社会的ジレンマ」で、人道技術センターのトリスタン・ハリスは、人工知能が人間の弱点を上回っていることを指摘しました。これはどういう意味ですか?これは、人工知能が人間を使用することができたことを意味します

Transunionのプラットフォーム変換とAIの野望に関するVenkat AchantaMay 08, 2025 am 11:23 AM

Transunionのプラットフォーム変換とAIの野望に関するVenkat AchantaMay 08, 2025 am 11:23 AMTransunionのCTOであるRanganath Achantaは、2021年後半にNeustarの買収に続いて会社に入社して以来、重要な技術的変革を主導しました。

AIへの信頼が跳ね上がると、生産性が続きますMay 08, 2025 am 11:11 AM

AIへの信頼が跳ね上がると、生産性が続きますMay 08, 2025 am 11:11 AMBuilding Trustは、ビジネスでのAIの採用を成功させるために最重要です。 これは、ビジネスプロセス内の人間の要素を考えると特に当てはまります。 従業員は、他の人と同様に、AIとその実装に関する懸念を抱いています。 デロイトの研究者はSCです

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

mPDF

mPDF は、UTF-8 でエンコードされた HTML から PDF ファイルを生成できる PHP ライブラリです。オリジナルの作者である Ian Back は、Web サイトから「オンザフライ」で PDF ファイルを出力し、さまざまな言語を処理するために mPDF を作成しました。 HTML2FPDF などのオリジナルのスクリプトよりも遅く、Unicode フォントを使用すると生成されるファイルが大きくなりますが、CSS スタイルなどをサポートし、多くの機能強化が施されています。 RTL (アラビア語とヘブライ語) や CJK (中国語、日本語、韓国語) を含むほぼすべての言語をサポートします。ネストされたブロックレベル要素 (P、DIV など) をサポートします。

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

Safe Exam Browser

Safe Exam Browser は、オンライン試験を安全に受験するための安全なブラウザ環境です。このソフトウェアは、あらゆるコンピュータを安全なワークステーションに変えます。あらゆるユーティリティへのアクセスを制御し、学生が無許可のリソースを使用するのを防ぎます。

SublimeText3 英語版

推奨: Win バージョン、コードプロンプトをサポート!