QWEN2.5-MAX:費用対効果の高い人間のような推論の大規模な言語モデル

AIの風景は、DeepSeek、Mistral Small 3、QWEN2.5 Maxなどの強力で費用対効果の高いモデルで賑わっています。 特に、QWEN2.5-MAXは、いくつかのベンチマークでDeepSeek V3を上回ることさえ、強力な専門家(MOE)モデルとして波を作っています。高度なアーキテクチャと大規模なトレーニングデータセット(最大18兆トークン)は、パフォーマンスの新しい標準を設定しています。この記事では、QWEN2.5-MAXのアーキテクチャ、その競争上の利点、およびDeepseek V3に匹敵する可能性について説明します。また、QWEN2.5モデルをローカルで実行することもガイドします

キーQWEN2.5モデル機能:

- 多言語のサポート:29を超える言語をサポートします。

- 拡張コンテキスト:最大128Kトークンまでの長いコンテキストを処理します 機能の強化された機能:

- コーディング、数学、指示のフォロー、および構造化されたデータ理解の大幅な改善。 目次:

キーQWEN2.5モデル機能

- ollama

- でqwen2.5を使用します qwen2.5:7b推論

- QWEN2.5-CODER:3B推論

- 結論

- オラマとローカルにqwen2.5を実行してください:

curl -fsSL https://ollama.com/install.sh | sh

7Bパラメーターモデル(約4.7 GB)を使用します。限られたリソースを持つユーザーが小規模なモデルを利用できます。

qwen2.5:7b推論:

qwen2.5:7b推論:

コマンドはモデルをダウンロードします。 これに似た出力が表示されます:

ollama pull qwen2.5:7b

その後、モデルを実行します:pull

<code>pulling manifest pulling 2bada8a74506... 100% ▕████████████████▏ 4.7 GB ... (rest of the output) ... success</code>

ollama run qwen2.5:7b例:

の例

30ワードでベクトルデータベースを定義します

プロンプト:

<code>Vector databases efficiently store and query numerical arrays (vectors), often using approximations for fast similarity searches in large datasets.</code>(ctrl dを押して終了する)

注:ローカルランモデルには、リアルタイムアクセスとWeb検索機能がありません。 たとえば、

<code>Popular vector databases include Pinecone, Weaviate, Milvus, ChromaDB, and Amazon Aurora Vectorstore.</code>

プロンプト:今日の日付は何ですか?

qwen2.5-coder:3b推論:

同じプロセスに従って、<code>Today's date is unavailable. My knowledge is not updated in real-time.</code>コマンドの代わりに

コーディングプロンプトの例:qwen2.5-coder:3b

プロンプト:fibonacciシーケンスのPythonコードを提供します

(出力:FibonacciシーケンスのPythonコードがここに表示されます)プロンプト:

Python関数を使用してシンプルな計算機を作成します。(出力:簡単な計算機のPythonコードがこちらに表示されます)

結論: このガイドは、Ollamaを使用してQWEN2.5モデルをローカルに実行する方法を示しています。QWEN2.5-MAXの強度を強調しています。 ローカルの実行はセキュリティを改善しますが、リアルタイムの情報アクセスを犠牲にします。 QWEN2.5は、効率、セキュリティ、パフォーマンスの間の魅力的なバランスを提供し、さまざまなAIアプリケーションのDeepSeek V3の強力な代替手段となっています。 Google Colab経由のQWEN2.5-MAXへのアクセスの詳細については、別のリソースで入手できます。

以上がQWEN2.5モデルを3分でローカルに実行するにはどうすればよいですか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

7強力なAIは、すべてのプロジェクトマネージャーが今習得する必要があるプロンプトをプロンプトしますMay 08, 2025 am 11:39 AM

7強力なAIは、すべてのプロジェクトマネージャーが今習得する必要があるプロンプトをプロンプトしますMay 08, 2025 am 11:39 AMChatGptのようなチャットボットによって例示される生成AIは、プロジェクトマネージャーにワークフローを合理化し、プロジェクトが予定外で予算内に留まることを保証する強力なツールを提供します。 ただし、正しいプロンプトを作成するのに効果的な使用のヒンジ。 正確、詳細

AI自体の有益な支援を介して、とらえどころのないAGIの不明確な意味を定義するMay 08, 2025 am 11:37 AM

AI自体の有益な支援を介して、とらえどころのないAGIの不明確な意味を定義するMay 08, 2025 am 11:37 AM人工一般情報(AGI)を定義するという課題は重要です。 AGIの進捗状況の主張は、しばしば明確なベンチマークを欠いており、定義は事前に決定された研究の方向に合うように調整されています。この記事では、定義への新しいアプローチを探ります

IBMは、2025が生成AIにおけるWatsonx.dataの役割を紹介していると考えていますMay 08, 2025 am 11:32 AM

IBMは、2025が生成AIにおけるWatsonx.dataの役割を紹介していると考えていますMay 08, 2025 am 11:32 AMIBM WATSONX.DATA:エンタープライズAIデータスタックの合理化 IBMは、Watsonx.Dataを、正確でスケーラブルな生成AIソリューションの提供を加速することを目的とした企業向けの重要なプラットフォームとして位置付けています。 これは、Complを簡素化することによって達成されます

ヒューマノイドロボットマシンの台頭が近づいています。May 08, 2025 am 11:29 AM

ヒューマノイドロボットマシンの台頭が近づいています。May 08, 2025 am 11:29 AMAIおよび材料科学のブレークスルーに促進されたロボット工学の急速な進歩は、ヒューマノイドロボットの新しい時代を導く態勢が整っています。 何年もの間、産業自動化が主な焦点でしたが、ロボットの能力は急速に経験しています

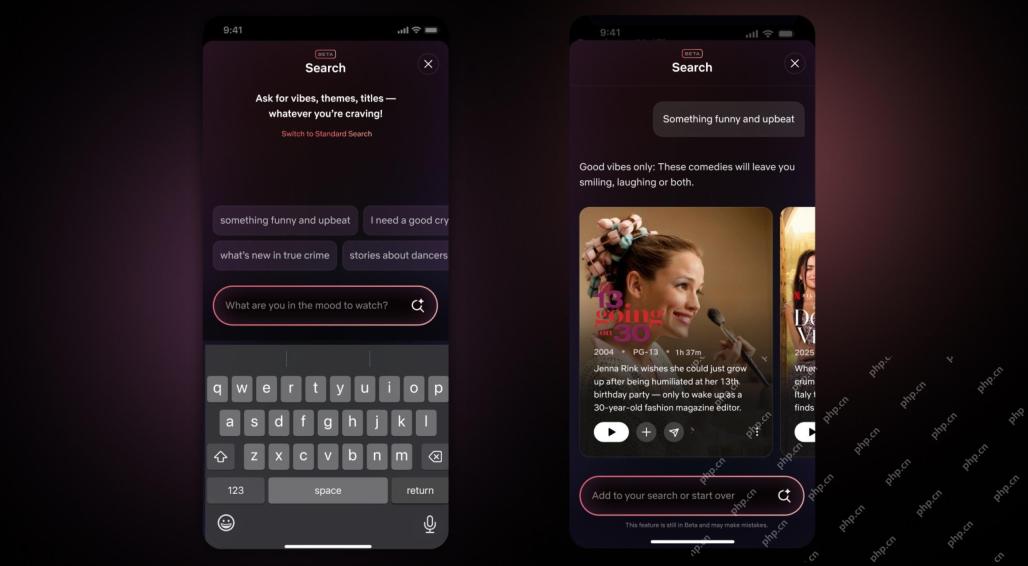

Netflix Revamps Interface - AI検索ツールとTiktokのようなデザインのデビューMay 08, 2025 am 11:25 AM

Netflix Revamps Interface - AI検索ツールとTiktokのようなデザインのデビューMay 08, 2025 am 11:25 AM10年以内のNetflixインターフェイスの最大のアップデート:よりスマートでパーソナライズされた、採用される多様なコンテンツ Netflixは、10年でユーザーインターフェイスの最大の改良を発表しました。新しい外観だけでなく、各ショーに関する情報をさらに追加し、「アンビエント」やより柔軟な構造を理解するための曖昧な概念を理解できるよりスマートなAI検索ツールを紹介し、新興ビデオゲーム、ライブイベント、スポーツイベント、その他の新しいタイプのコンテンツにおいてよりよく示すことができます。 トレンドに対応するために、モバイルの新しい垂直ビデオコンポーネントにより、ファンはトレーラーやクリップをスクロールしたり、完全なショーを見たり、他の人とコンテンツを共有したりすることが容易になります。これは、無限のスクロールと非常に成功した短いビデオWebサイトTIを思い出させます

AGIのずっと前:あなたに挑戦する3つのAIマイルストーンMay 08, 2025 am 11:24 AM

AGIのずっと前:あなたに挑戦する3つのAIマイルストーンMay 08, 2025 am 11:24 AM人工知能における一般的な知能(AGI)の議論の高まりにより、人工知能が人間の知能を上回ると何が起こるかについて多くの人が考えるようになりました。この瞬間が近いか遠いかは、あなたが尋ねる人に依存しますが、私たちが焦点を当てるべき最も重要なマイルストーンであるとは思いません。どの以前のAIマイルストーンがすべての人に影響を与えますか?どんなマイルストーンが達成されましたか?ここに私が起こったと思う3つのことがあります。 人工知能は人間の弱点を上回ります 2022年の映画「社会的ジレンマ」で、人道技術センターのトリスタン・ハリスは、人工知能が人間の弱点を上回っていることを指摘しました。これはどういう意味ですか?これは、人工知能が人間を使用することができたことを意味します

Transunionのプラットフォーム変換とAIの野望に関するVenkat AchantaMay 08, 2025 am 11:23 AM

Transunionのプラットフォーム変換とAIの野望に関するVenkat AchantaMay 08, 2025 am 11:23 AMTransunionのCTOであるRanganath Achantaは、2021年後半にNeustarの買収に続いて会社に入社して以来、重要な技術的変革を主導しました。

AIへの信頼が跳ね上がると、生産性が続きますMay 08, 2025 am 11:11 AM

AIへの信頼が跳ね上がると、生産性が続きますMay 08, 2025 am 11:11 AMBuilding Trustは、ビジネスでのAIの採用を成功させるために最重要です。 これは、ビジネスプロセス内の人間の要素を考えると特に当てはまります。 従業員は、他の人と同様に、AIとその実装に関する懸念を抱いています。 デロイトの研究者はSCです

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

SecLists

SecLists は、セキュリティ テスターの究極の相棒です。これは、セキュリティ評価中に頻繁に使用されるさまざまな種類のリストを 1 か所にまとめたものです。 SecLists は、セキュリティ テスターが必要とする可能性のあるすべてのリストを便利に提供することで、セキュリティ テストをより効率的かつ生産的にするのに役立ちます。リストの種類には、ユーザー名、パスワード、URL、ファジング ペイロード、機密データ パターン、Web シェルなどが含まれます。テスターはこのリポジトリを新しいテスト マシンにプルするだけで、必要なあらゆる種類のリストにアクセスできるようになります。

Safe Exam Browser

Safe Exam Browser は、オンライン試験を安全に受験するための安全なブラウザ環境です。このソフトウェアは、あらゆるコンピュータを安全なワークステーションに変えます。あらゆるユーティリティへのアクセスを制御し、学生が無許可のリソースを使用するのを防ぎます。

SublimeText3 Linux 新バージョン

SublimeText3 Linux 最新バージョン

SublimeText3 英語版

推奨: Win バージョン、コードプロンプトをサポート!

AtomエディタMac版ダウンロード

最も人気のあるオープンソースエディター