検索された世代(RAG)でチャンキングの力を解き放つ:深いダイビング

大量のテキストデータを効率的に処理することは、堅牢かつ効果的な検索充電(RAG)システムを構築するために重要です。 この記事では、さまざまなチャンキング戦略を検討します。これは、AI搭載アプリケーションのパフォーマンスを最適化し、パフォーマンスを向上させるために不可欠です。 さまざまなアプローチを掘り下げ、それらの長所と短所を強調し、実用的な例を提供します。

目次

- ぼろきれは何ですか?

- チャンキングの重要性

- ラグアーキテクチャとチャンク

- の理解 RAGシステムとの一般的な課題

- 最適なチャンキング戦略の選択

- 文字ベースのテキストチャンキング

- langchainを使用した再帰文字テキストの分割

- ドキュメント固有のチャンキング(HTML、Python、JSONなど) LangchainとOpenaiでのセマンティックチャンキング

- エージェントチャンキング(LLM駆動型チャンキング)

- セクションベースのチャンキング

- 強化された検索のためのコンテキストチャンキング 長距離コンテキストを維持するための後期チャンキング

- 結論

- ぼろきれは何ですか?

-

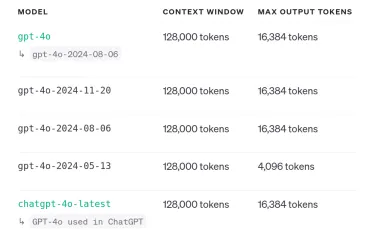

チャンクは、大規模なテキストドキュメントをより小さく、より管理しやすいユニットに分割するプロセスです。 言語モデルにはコンテキストウィンドウが制限されているため、これはRAGシステムにとって不可欠です。 チャンクは、関連情報がこれらの制限内に残り、信号対雑音比を最大化し、モデルのパフォーマンスを改善することを保証します。 目標は、データを分割するだけでなく、そのプレゼンテーションをモデルに最適化して、検索性と精度を強化することです。

なぜチャンキングが重要なのですか?

Chromaの共同設立者であるAnton Troynikovは、コンテキストウィンドウ内の無関係なデータがアプリケーションの有効性を大幅に低下させることを強調しています。 チャンクは次のとおりです

なぜチャンキングが重要なのですか?

Chromaの共同設立者であるAnton Troynikovは、コンテキストウィンドウ内の無関係なデータがアプリケーションの有効性を大幅に低下させることを強調しています。 チャンクは次のとおりです

コンテキストウィンドウの制限を克服する:

サイズの制限のために重要な情報が失われないようにします。信号対雑音比の改善:は、無関係なコンテンツをフィルターし、モデルの精度を向上させます。

検索効率の向上:

関連情報のより速く、より正確な検索を促進します。- タスク固有の最適化:特定のアプリケーションニーズに合わせて戦略を調整することができます(例えば、要約対質問アンウェー)。

- ragアーキテクチャとチャンキング

- チャンキング:生データは、より小さく、意味のあるチャンクに分割されます 埋め込み:

- チャンクはベクトル埋め込みに変換されます。 検索&生成:

- 関連するチャンクはユーザークエリに基づいて取得され、LLMは取得された情報を使用して応答を生成します。 RAGシステムの課題

- 生成の難しさ: 幻覚、無関係またはバイアス出力。

- 統合の問題: 取得した情報を一貫して組み合わせるのが難しい。

- 適切なチャンキング戦略の選択

RAGアーキテクチャには、3つの重要な段階が含まれます

RAGシステムはいくつかの課題に直面しています:

検索の問題:- 関連情報の取得または不完全な取得。

理想的なチャンキング戦略は、コンテンツタイプ、埋め込みモデル、および予想されるユーザークエリのいくつかの要因に依存します。 コンテンツの構造と密度、埋め込みモデルのトークンの制限、およびユーザーが尋ねる可能性のある質問の種類を考慮してください。

1。キャラクターベースのテキストチャンキングこの単純な方法は、意味の意味に関係なく、文字カウントに基づいてテキストを固定サイズのチャンクに分割します。 簡単ですが、多くの場合、文の構造とコンテキストを混乱させます。 Pythonを使用した例:

2。 langchain

text = "Clouds come floating into my life..." chunks = [] chunk_size = 35 chunk_overlap = 5 # ... (Chunking logic as in the original example)を使用した再帰文字テキストの分割 このアプローチは、複数のセパレーター(たとえば、ダブルニューライン、シングルニューライン、スペースなど)を使用してテキストを再帰的に分割し、ターゲット文字サイズに最適化するために小さなチャンクをマージします。 キャラクターベースのチャンクよりも洗練されており、より良いコンテキストの保存を提供します。 Langchainを使用した例:

3。ドキュメント固有のチャンキング

# ... (LangChain installation and code as in the original example)この方法は、形式固有のセパレータを使用して、さまざまなドキュメント形式(HTML、Python、Markdownなど)にチャンクを適応させます。 これにより、チャンクがドキュメントの固有の構造を尊重することが保証されます。 PythonとMarkdownにLangchainを使用した例は、元の応答で提供されています。

4。 LangchainとOpenaiでのセマンティックチャンキング

セマンティックチャンキングは、セマンティックの意味に基づいてテキストを分割し、文の埋め込みなどのテクニックを使用して自然なブレークポイントを識別します。 このアプローチは、各チャンクが一貫したアイデアを表すことを保証します。ラングチェーンとオープン埋め込みを使用した例:

5。エージェントチャンキング(LLM駆動型チャンキング)

エージェントチャンキングはLLMを使用してテキスト内の自然なブレークポイントを識別し、より文脈的に関連するチャンクをもたらします。 このアプローチは、LLMの言語とコンテキストの理解を活用して、より意味のあるセグメントを作成します。 OpenAI APIを使用した例:

text = "Clouds come floating into my life..." chunks = [] chunk_size = 35 chunk_overlap = 5 # ... (Chunking logic as in the original example)

6。セクションベースのチャンキング

この方法では、ドキュメントの固有の構造(見出し、サブヘディング、セクション)を活用して、チャンクを定義します。これは、研究論文やレポートなどの適切に構造化されたドキュメントに特に効果的です。 トピックベースのチャンキングにPymupdfと潜在ディリクレの割り当て(LDA)を使用した例:

# ... (LangChain installation and code as in the original example)

7。コンテキストチャンキング

コンテキストチャンキングは、各チャンク内のセマンティックコンテキストの保存に焦点を当てています。 これにより、取得された情報が一貫性があり、関連することが保証されます。 LangChainとカスタムプロンプトを使用した例:

# ... (OpenAI API key setup and code as in the original example)

8。遅いチャンキング

ドキュメント全体に埋め込みを生成するまで、後期チャンキングはチャンキングを遅らせます。これにより、長距離のコンテキスト依存関係が保持され、埋め込みと検索の精度が向上します。 Jina Embeddingsモデルを使用した例:

# ... (OpenAI API key setup and code as in the original example)

結論

効果的なチャンキングは、高性能のRAGシステムを構築するために最も重要です。チャンキング戦略の選択は、情報検索の品質と生成された応答の一貫性に大きな影響を与えます。 データの特性とアプリケーションの特定の要件を慎重に検討することにより、開発者はRAGシステムのパフォーマンスを最適化するために最も適切なチャンキング方法を選択できます。 各チャンク内のコンテキストの完全性と関連性の維持を常に優先することを忘れないでください。

以上がRAGシステム用の8種類のチャンキング-AnalyticsVidhyaの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

7強力なAIは、すべてのプロジェクトマネージャーが今習得する必要があるプロンプトをプロンプトしますMay 08, 2025 am 11:39 AM

7強力なAIは、すべてのプロジェクトマネージャーが今習得する必要があるプロンプトをプロンプトしますMay 08, 2025 am 11:39 AMChatGptのようなチャットボットによって例示される生成AIは、プロジェクトマネージャーにワークフローを合理化し、プロジェクトが予定外で予算内に留まることを保証する強力なツールを提供します。 ただし、正しいプロンプトを作成するのに効果的な使用のヒンジ。 正確、詳細

AI自体の有益な支援を介して、とらえどころのないAGIの不明確な意味を定義するMay 08, 2025 am 11:37 AM

AI自体の有益な支援を介して、とらえどころのないAGIの不明確な意味を定義するMay 08, 2025 am 11:37 AM人工一般情報(AGI)を定義するという課題は重要です。 AGIの進捗状況の主張は、しばしば明確なベンチマークを欠いており、定義は事前に決定された研究の方向に合うように調整されています。この記事では、定義への新しいアプローチを探ります

IBMは、2025が生成AIにおけるWatsonx.dataの役割を紹介していると考えていますMay 08, 2025 am 11:32 AM

IBMは、2025が生成AIにおけるWatsonx.dataの役割を紹介していると考えていますMay 08, 2025 am 11:32 AMIBM WATSONX.DATA:エンタープライズAIデータスタックの合理化 IBMは、Watsonx.Dataを、正確でスケーラブルな生成AIソリューションの提供を加速することを目的とした企業向けの重要なプラットフォームとして位置付けています。 これは、Complを簡素化することによって達成されます

ヒューマノイドロボットマシンの台頭が近づいています。May 08, 2025 am 11:29 AM

ヒューマノイドロボットマシンの台頭が近づいています。May 08, 2025 am 11:29 AMAIおよび材料科学のブレークスルーに促進されたロボット工学の急速な進歩は、ヒューマノイドロボットの新しい時代を導く態勢が整っています。 何年もの間、産業自動化が主な焦点でしたが、ロボットの能力は急速に経験しています

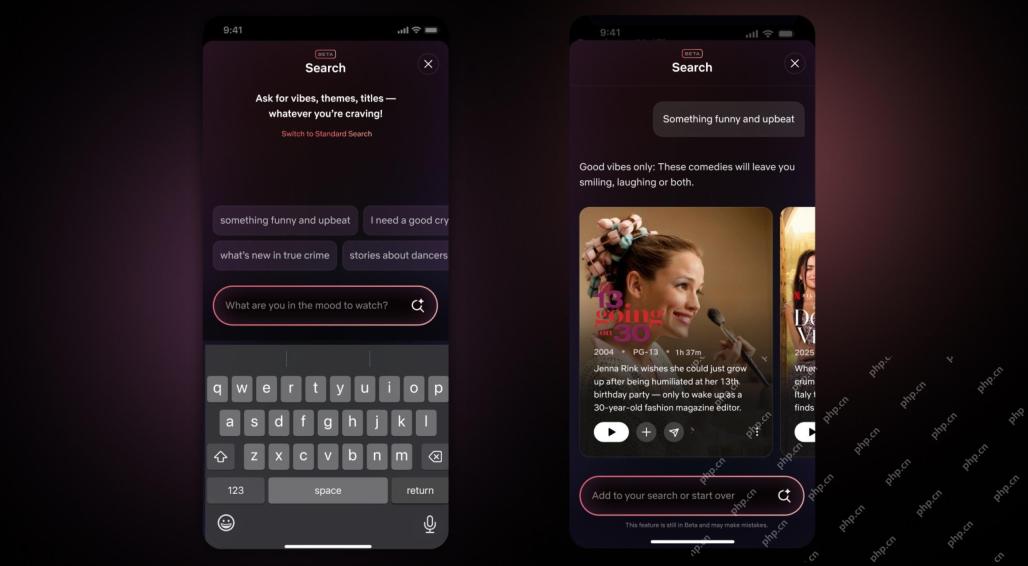

Netflix Revamps Interface - AI検索ツールとTiktokのようなデザインのデビューMay 08, 2025 am 11:25 AM

Netflix Revamps Interface - AI検索ツールとTiktokのようなデザインのデビューMay 08, 2025 am 11:25 AM10年以内のNetflixインターフェイスの最大のアップデート:よりスマートでパーソナライズされた、採用される多様なコンテンツ Netflixは、10年でユーザーインターフェイスの最大の改良を発表しました。新しい外観だけでなく、各ショーに関する情報をさらに追加し、「アンビエント」やより柔軟な構造を理解するための曖昧な概念を理解できるよりスマートなAI検索ツールを紹介し、新興ビデオゲーム、ライブイベント、スポーツイベント、その他の新しいタイプのコンテンツにおいてよりよく示すことができます。 トレンドに対応するために、モバイルの新しい垂直ビデオコンポーネントにより、ファンはトレーラーやクリップをスクロールしたり、完全なショーを見たり、他の人とコンテンツを共有したりすることが容易になります。これは、無限のスクロールと非常に成功した短いビデオWebサイトTIを思い出させます

AGIのずっと前:あなたに挑戦する3つのAIマイルストーンMay 08, 2025 am 11:24 AM

AGIのずっと前:あなたに挑戦する3つのAIマイルストーンMay 08, 2025 am 11:24 AM人工知能における一般的な知能(AGI)の議論の高まりにより、人工知能が人間の知能を上回ると何が起こるかについて多くの人が考えるようになりました。この瞬間が近いか遠いかは、あなたが尋ねる人に依存しますが、私たちが焦点を当てるべき最も重要なマイルストーンであるとは思いません。どの以前のAIマイルストーンがすべての人に影響を与えますか?どんなマイルストーンが達成されましたか?ここに私が起こったと思う3つのことがあります。 人工知能は人間の弱点を上回ります 2022年の映画「社会的ジレンマ」で、人道技術センターのトリスタン・ハリスは、人工知能が人間の弱点を上回っていることを指摘しました。これはどういう意味ですか?これは、人工知能が人間を使用することができたことを意味します

Transunionのプラットフォーム変換とAIの野望に関するVenkat AchantaMay 08, 2025 am 11:23 AM

Transunionのプラットフォーム変換とAIの野望に関するVenkat AchantaMay 08, 2025 am 11:23 AMTransunionのCTOであるRanganath Achantaは、2021年後半にNeustarの買収に続いて会社に入社して以来、重要な技術的変革を主導しました。

AIへの信頼が跳ね上がると、生産性が続きますMay 08, 2025 am 11:11 AM

AIへの信頼が跳ね上がると、生産性が続きますMay 08, 2025 am 11:11 AMBuilding Trustは、ビジネスでのAIの採用を成功させるために最重要です。 これは、ビジネスプロセス内の人間の要素を考えると特に当てはまります。 従業員は、他の人と同様に、AIとその実装に関する懸念を抱いています。 デロイトの研究者はSCです

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

Dreamweaver Mac版

ビジュアル Web 開発ツール

WebStorm Mac版

便利なJavaScript開発ツール

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 英語版

推奨: Win バージョン、コードプロンプトをサポート!

MinGW - Minimalist GNU for Windows

このプロジェクトは osdn.net/projects/mingw に移行中です。引き続きそこでフォローしていただけます。 MinGW: GNU Compiler Collection (GCC) のネイティブ Windows ポートであり、ネイティブ Windows アプリケーションを構築するための自由に配布可能なインポート ライブラリとヘッダー ファイルであり、C99 機能をサポートする MSVC ランタイムの拡張機能が含まれています。すべての MinGW ソフトウェアは 64 ビット Windows プラットフォームで実行できます。