AIxivコラムは、当サイトが学術的・技術的な内容を掲載するコラムです。過去数年間で、このサイトの AIxiv コラムには 2,000 件を超えるレポートが寄せられ、世界中の主要な大学や企業のトップ研究室がカバーされ、学術交流と普及を効果的に促進しています。共有したい優れた作品がある場合は、お気軽に寄稿するか、報告のために当社までご連絡ください。提出メール: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com

Wu Yi、清華大学学際情報研究所助教授、元 OpenAI 常勤研究員、研究分野には強化学習が含まれる、大規模モデルのアライメント、人間とコンピューターの相互作用、ロボット学習など。スチュアート・ラッセル教授に師事し、2019年にカリフォルニア大学バークレー校で博士号を取得、2014年に清華大学学際情報研究所(ヤオクラス)を卒業。代表的な著作には、NIPS2016 の最優秀論文、Value Iteration Network、マルチエージェント深層強化学習の分野で最も引用された論文、MADDPG アルゴリズム、などがあります。 大規模なモデルを人間の指示や意図によりよく従わせるにはどうすればよいでしょうか?大規模なモデルに優れた推論機能を持たせるにはどうすればよいでしょうか?大型モデルでの幻覚を回避するにはどうすればよいですか?これらの問題を解決できるかどうかは、大規模モデルを真に広く利用可能にし、さらには超知能を実現するための最も重要な技術的課題です。これらの最も困難な課題は、Wu Yi チームの長期的な研究焦点でもあり、大規模モデルのアライメント技術 (アライメント) によって克服されるべき問題です。 アライメント技術において、最も重要なアルゴリズムフレームワークは、人間のフィードバックに基づく強化学習 (RLHF、人間のフィードバックからの強化学習) です。 RLHFは、大規模モデルの出力に対する人間の嗜好フィードバックに基づいて人間のフィードバックに基づいて報酬関数(報酬モデル)を学習し、さらに大規模モデルに対して強化学習トレーニングを実行して、大規模モデルが応答の品質を区別できるように学習します。反復を繰り返して、モデル機能の向上を達成します。現在、OpenAI の GPT モデルや Anthropic の Claude モデルなど、世界で最も強力な言語モデルは、RLHF トレーニングの重要性を重視しています。 OpenAI と Anthropic は、大規模モデルの調整のための大規模 PPO アルゴリズムに基づいた RLHF トレーニング システムも社内で開発しました。 しかし、PPOアルゴリズムの複雑なプロセスと高いコンピューティングパワーの消費のため、アメリカのAI企業の大規模なRLHFトレーニングシステムは、PPOアルゴリズムは非常に優れていますが、これまでオープンソース化されていませんでした。学術界における強力な調整作業では、複雑な手法が使用されることはほとんどありません。PPO アルゴリズムは RLHF 研究に使用され、一般的には、より単純で直接的な、SFT (教師あり微調整) や DPO (直接ポリシー最適化) などの調整アルゴリズムが使用されます。トレーニングシステムに対する要件が低くなります。 それでは、単純な位置合わせアルゴリズムのほうが確実にうまく機能するのでしょうか? ICML 2024 で Wu Yi のチームによって発表された著作「Is DPO Superior to PPO for LLM Alignment? A Comprehensive Study」では、DPO および PPO アルゴリズムの特性について注意深く議論し、RLHF アルゴリズムの効果を向上させるための重要なポイントを指摘しました。この研究では、独自に開発した大規模 RLHF トレーニング システムに基づいて、Wu Yi のチームは PPO アルゴリズムとパラメータの少ないオープンソース モデルを初めて使用し、クローズドソースの大規模コード生成タスク CodeContest を上回りました。最も困難な課題として認識されているモデル AlphaCode 41B。

関連する結果は、ICML 2024 の口頭発表として受理され、OpenAI や人間的。

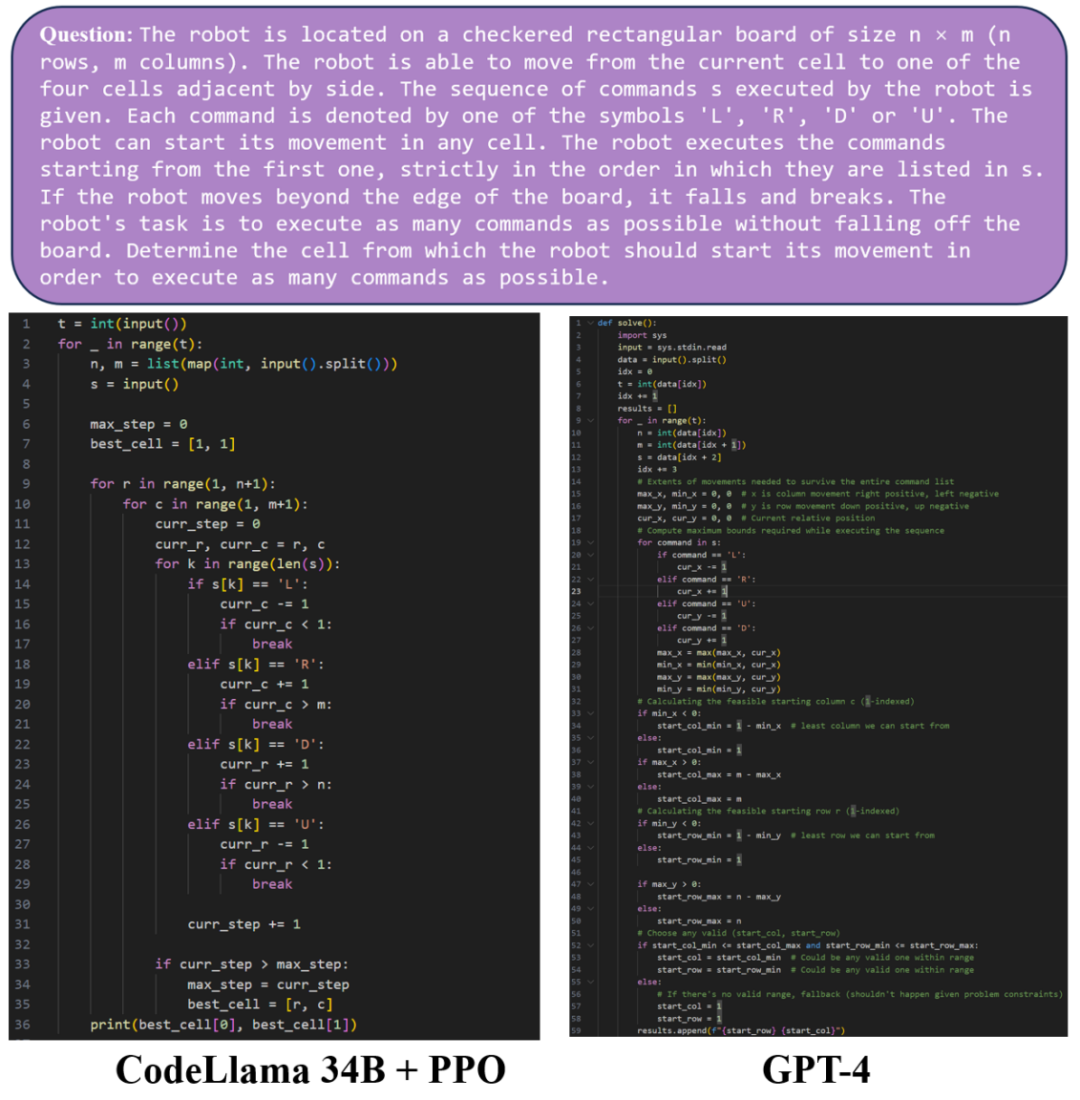

次に、GPT-4 と PPO アルゴリズムでトレーニングされた CodeLlama 34B モデルのコード生成効果を比較してみましょう。例 1 では、PPO アルゴリズムでトレーニングされた CodeLlama 34B モデルと GPT-4 モデルが生成されます。同等の品質のコード。

例 2 では、PPO アルゴリズムによってトレーニングされた CodeLlama 34B モデルと GPT-4 モデルの両方が、完全で実行可能な Python コードを生成できることがわかります。ただし、この例では、GPT-4 が間違ったコードを生成し、テスト データを正しく出力できませんでした。 PPO アルゴリズムによってトレーニングされた CodeLlama 34B モデルによって生成されたコードは、テストに合格できます。

ICML 2024 のこの論文では、研究チームは DPO と PPO アルゴリズムの特徴を詳細に議論し、DPO と PPO の機能を向上させるための重要なポイントを指摘しました。

- 論文のタイトル: LLM アライメントに関して DPO は PPO より優れているか? 論文のアドレス: https://arxiv.org/pdf/2404.10719

PPO と比較して、DPO はトレーニングにオンライン サンプリング データではなくオフライン データを使用します。分析後、DPO アルゴリズムにより、トレーニングされたモデルはトレーニング データ分布外の出力を優先し、場合によっては予測できない応答が生成されます。

そこで、DPO アルゴリズムの機能を向上させるために、研究チームは 2 つの主要なテクノロジーをまとめました:

RLHF トレーニングの前に追加の SFT トレーニングを実行する、およびオフライン データの代わりにオンライン サンプリング データを使用する

。 追加の SFT トレーニングを使用すると、ベース モデルと参照モデルがデータセット内の分布にさらに偏り、一方、オンライン サンプリングを使用する DPO アルゴリズムの効果が大幅に向上することが実験により示されています。反復トレーニング用のデータは着実に改善されており、そのパフォーマンスは基本的な DPO アルゴリズムよりもはるかに優れています。

DPO を除き、この論文では、PPO の機能を最大化するための 3 つの重要なポイントも要約しています:

大きなバッチサイズを使用する (大規模)バッチ サイズ)

- を使用し、指数移動平均 (参照モデルの指数移動平均) を使用して参照モデルを更新します。

研究チームは、PPO アルゴリズムを使用して、対話タスク Safe-RLHF/HH-RLHF とコード生成タスク APPS/CodeContest で SOTA の結果を達成することに成功しました。

研究チームは、対話タスクにおいて、3 つの重要なポイントを組み合わせた PPO アルゴリズムが、DPO アルゴリズムやオンライン サンプリング DPO アルゴリズム DPO-Iter よりも大幅に優れていることを発見しました。

コード生成タスクAPPSとCodeContestでは、オープンソースモデルCode Llama 34Bに基づいたPPOアルゴリズムも最強レベルに達し、CodeContestの以前のSOTAであるAlphaCode 41Bを上回りました。

より良い結果を伴う大規模モデルのアライメントを達成するには、高効率のトレーニング システムが不可欠です。Wu Yi のチームは大規模な強化学習トレーニングを実現するための長期的な蓄積があり、独自の分散強化学習フレームワークを構築しました。 。

- NeurIPS 2022 協力型マルチエージェント ゲームにおける PPO の驚くべき効果 [1]: 協力型シナリオでのマルチエージェント トレーニングをサポートするためのマルチエージェント用の強化学習並列トレーニング フレームワーク MAPPO を提案し、オープンソース化しました。マルチエージェントの分野で多くの研究で使用されており、現在の論文での引用数は 1,000 を超えています。

- ICLR 2024 Scaling Distributed Reinforcement Learning to Over Ten Thousand Cores [2]: 強化学習用の分散トレーニング フレームワークを提案。これは数万コアまで簡単に拡張でき、加速率は OpenAI の大規模強化を超えます。学習システムの迅速化。

- ReaLHF: パラメーターの再割り当てによる大規模言語モデルの RLHF トレーニングの最適化 [3]: 最近、Wu Yi のチームは分散型 RLHF トレーニング フレームワーク ReaLHF をさらに実装しました。 Wu Yi チームの ICML 口頭論文は、ReaLHF システムに基づいて作成されました。 ReaLHF システムは長い時間をかけて開発され、最適なパフォーマンスを達成するために多くの細部に磨きをかけてきました。以前のオープンソースの作業と比較して、ReaLHF は、事前トレーニングよりも複雑なシナリオである RLHF で線形に近いスケーラビリティを実現でき、128 個の A100 GPU で RLHF トレーニング関連作業を安定かつ迅速に実行できます。オープンソース化されています: https://github.com/openpsi-project/ReaLHF

大規模な言語モデルのコーディング機能の向上に加えて、Wu Yi のチームはさまざまな強化学習アルゴリズムや大規模な言語モデルも使用しています。モデルの組み合わせにより、さまざまな複雑な LLM エージェントが実現され、人間との複雑なインタラクションを実行できます。 MiniRTS で強化学習を使用して、人間の指示に従い、最適な意思決定を行うことができる言語エージェントを作成します [4]。

ウェアウルフで戦略多様化強化学習戦略をトレーニングし、大規模モデルの意思決定能力を向上させます [5]。

Overcooked ゲームでは、小さなモデルと大きなモデルを組み合わせて、リアルタイムのフィードバックを提供できる協調的な言語エージェントを実装します [6]。

強化学習によって訓練されたロボット制御戦略と大規模言語モデルの推論機能を組み合わせることで、ロボットは一連の複雑なタスクを実行できるようになります[7]。

大規模モデルが実際に何千もの家庭に導入されるためには、学者や大規模モデルの実践者にとって、優れたオープンソースの研究と論文が間違いなく実験コストと開発を大幅に削減することも期待されています。テクノロジーの発展により、人間に役立つさらに大きなモデルが登場するでしょう。 [1] Yu、Chao、Akash Velu、Eugene Vinitsky、Jiaxuan Gao、Yu Wang、Alexandre Bayen、Yi Wu 「マルチエージェント協力ゲームにおける ppo の驚くべき有効性」。 [2] Mei、Zhiyu、Wei Fu、Guangju Wang、Huanchen Zhang、および Yi Wu「SRL: 分散強化学習を 1 万コア以上に拡張する」[3] Mei、Zhiyu、 Wei Fu、Kaiwei Li、Guangju Wang、Huanchen Zhang、Yi Wu「ReaLHF: パラメーターの再割り当てによる大規模言語モデルの最適化された RLHF トレーニング」[4] Xu、Shusheng、Huaijie Wang、Jiaxuan Gao、 Yutao Ouyang、Chao Yu、および Yi Wu。「物理的に現実的なロボットの動作と制御の言語ガイドによる生成。」[5] Xu、Zelai、Chao Yu、Fei Fang、Yu Wang、および Yi Wu。 「人狼ゲームでの戦略的プレイのための強化学習を備えた言語エージェント。」[6] Liu、Jijia、Chao Yu、Jiaxuan Gao、Yuqing Xie、Qingmin Liao、Yi Wu、Yu Wang「Llm-リアルタイムの人間と AI の調整のための強化された階層型言語エージェント。"[7] Ouyang、Yutao、Jinhan Li、Yunfei Li、Zhongyu Li、Chao Yu、Koushil Sreenath、および Yi Wu。" Long-horizon大規模な言語モデルを備えた四足歩行ロボットの移動と操作。」以上がICML 2024 口頭 | DPO は PPO よりも LLM に適しているか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。