Maison >Périphériques technologiques >IA >WizardLM-2, qui est « très proche de GPT-4 », a été retiré en urgence par Microsoft. Quelle est l'histoire intérieure ?

WizardLM-2, qui est « très proche de GPT-4 », a été retiré en urgence par Microsoft. Quelle est l'histoire intérieure ?

- PHPzavant

- 2024-04-30 16:40:12656parcourir

Il y a quelque temps, Microsoft a commis sa propre erreur : il a largement ouvert WizardLM-2, puis l'a retiré proprement peu de temps après.

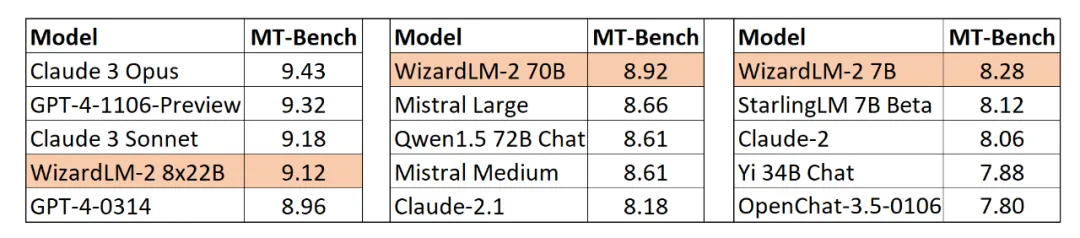

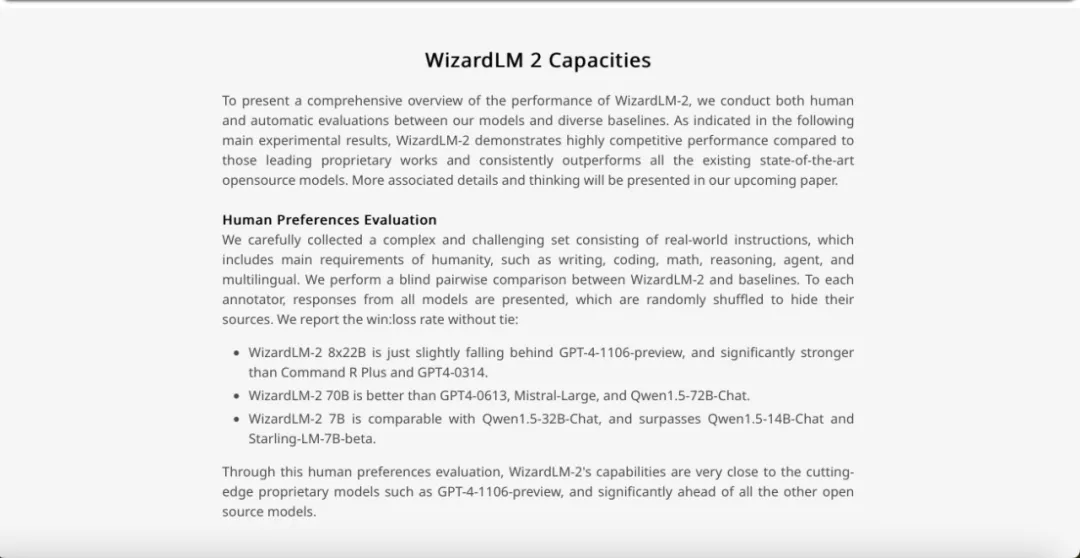

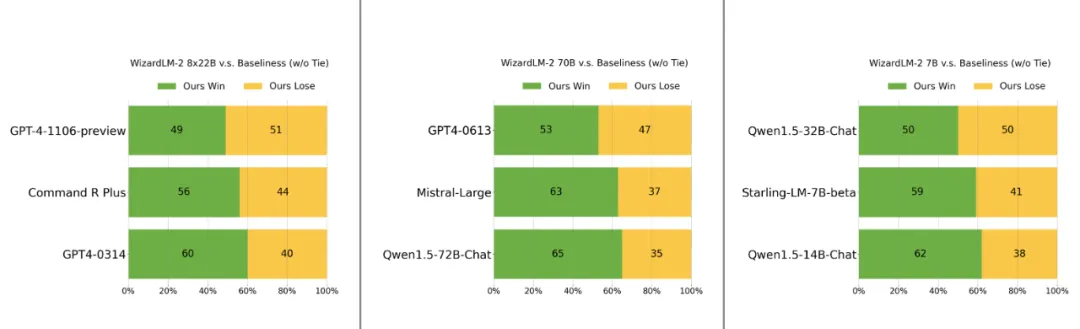

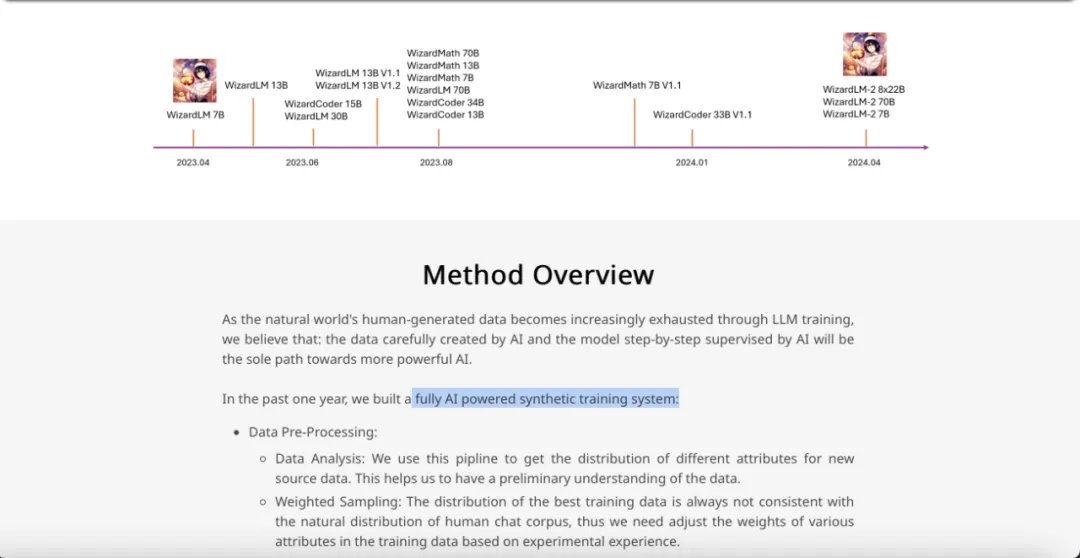

Informations de version actuellement disponibles pour WizardLM-2, un grand modèle open source « vraiment comparable à GPT-4 » avec des performances améliorées en matière de chat complexe, multilingue, d'inférence et d'agence.

La série comprend trois modèles : WizardLM-2 8x22B, WizardLM-2 70B et WizardLM-2 7B. Parmi eux :

- WizardLM-2 8x22B est le modèle le plus avancé et le meilleur LLM open source basé sur une évaluation interne pour des tâches très complexes.

- WizardLM-2 70B possède des capacités d'inférence de haut niveau et constitue le premier choix à cette échelle.

- WizardLM-2 7B est le plus rapide, avec des performances comparables aux principaux modèles open source existants qui sont 10 fois plus grands.

De plus, grâce à l'évaluation des préférences humaines, les capacités de WizardLM-28x22B "ne sont que légèrement en retard par rapport à l'aperçu GPT-4-1106, mais nettement supérieures à celles de CommandRPlus et GPT4-0314

".

Est-ce que cela deviendra une autre étape importante de l'open source comme LLaMa 3 ?

Alors que tout le monde était occupé à télécharger le modèle, l'équipe a soudainement tout retiré : blog, GitHub, HuggingFace ont tous obtenu 404.

Source de l'image : https://wizardlm.github.io/WizardLM2/

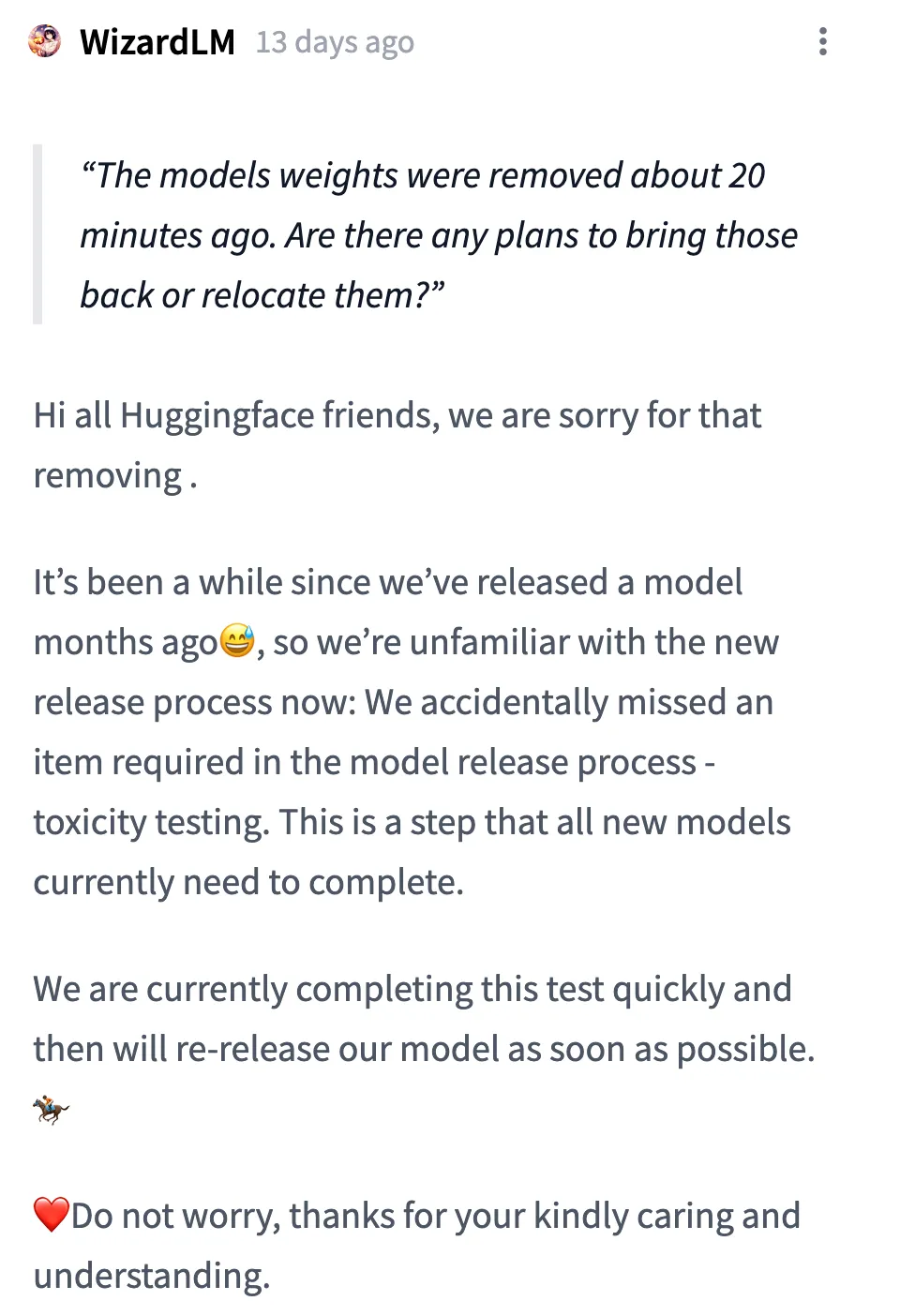

L'explication de l'équipe est :

Bonjour à tous les amis de Huggingface ! Désolé, nous avons supprimé le modèle. Cela fait un moment que nous n'avons pas publié de modèle il y a quelques mois, nous ne sommes donc pas familiers avec le nouveau processus de publication : nous avons accidentellement oublié un élément nécessaire dans le processus de publication du modèle : les tests de toxicité. C’est une étape que tous les nouveaux modèles doivent actuellement franchir.

Nous terminons actuellement ce test rapidement et rééditerons notre modèle dès que possible. Ne vous inquiétez pas, merci de votre sollicitude et de votre compréhension.

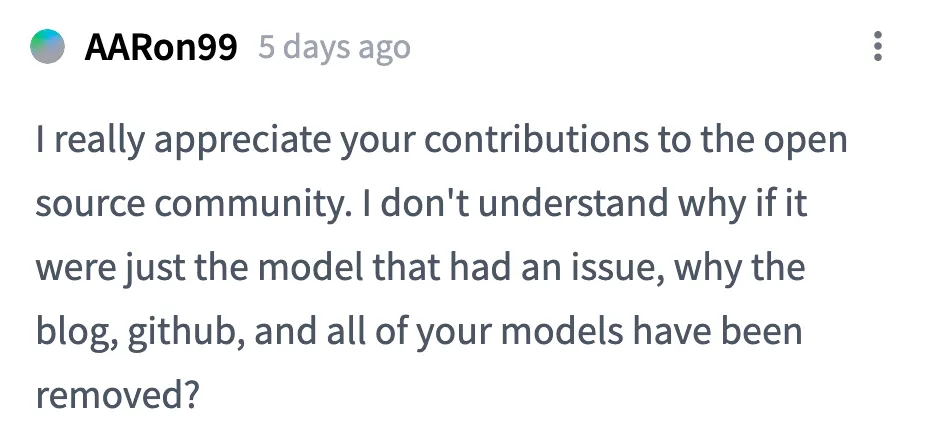

Mais l'attention et les discussions de la communauté de l'IA sur WizardLM-2 ne se sont pas arrêtées. Il y a plusieurs doutes :

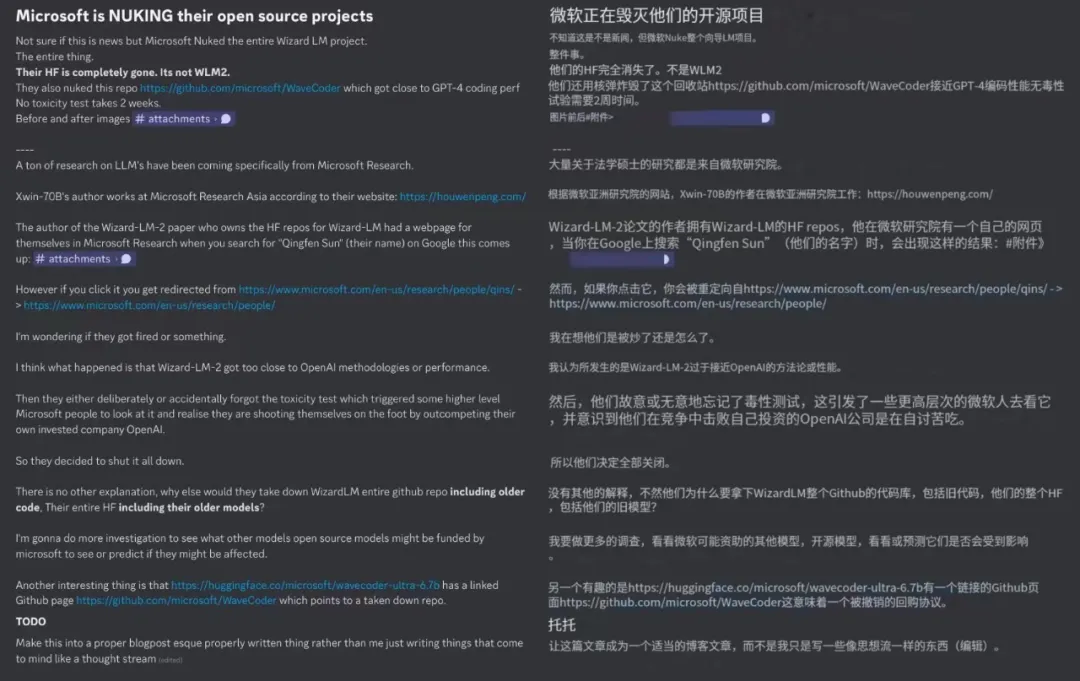

Premièrement, les projets open source supprimés ne sont pas seulement WizardLM-2, l'équipe Tous les travaux de la série Wizard ont disparu, y compris les précédents WizardMath et WizardCoder.

Deuxièmement, certaines personnes se sont demandé pourquoi le blog avait également été supprimé lorsque les poids des modèles étaient supprimés ? S’il manque juste la partie test, il n’est pas nécessaire de la retirer complètement.

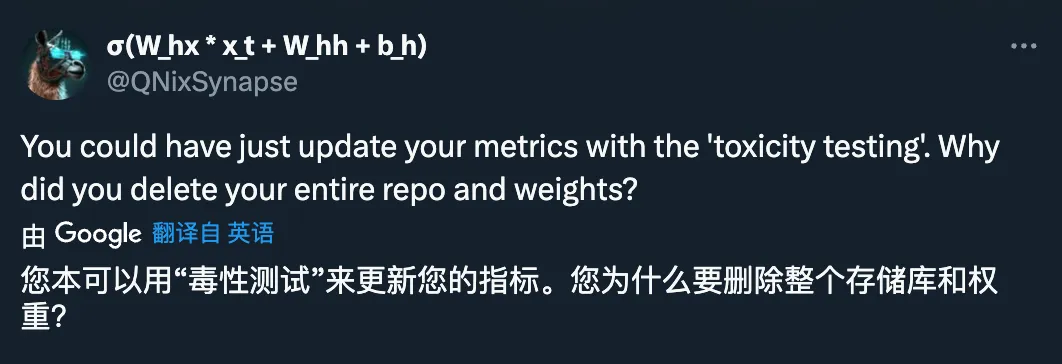

L'explication de l'équipe est : « Selon la réglementation en vigueur, quelle est la réglementation spécifique ? Personne ne le sait encore.

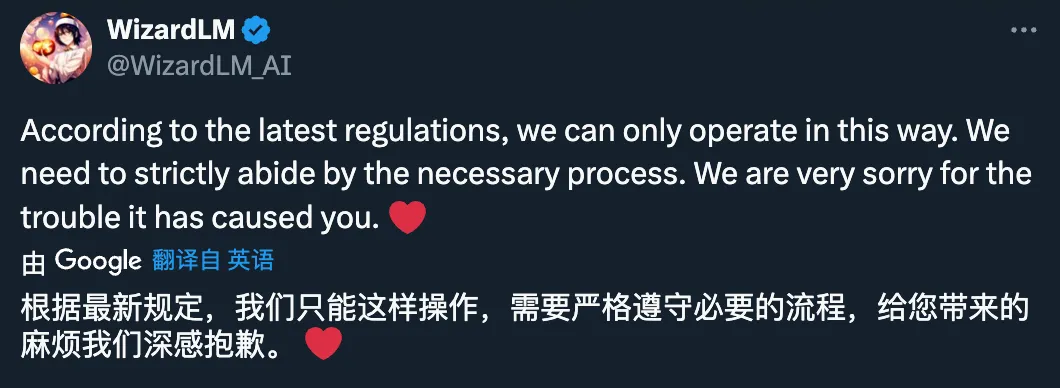

Troisièmement, il y a également des spéculations selon lesquelles l'équipe derrière WizardLM a été licenciée et le retrait du projet de la série Wizard a également été forcé.

Cependant, cette spéculation a été démentie par l'équipe :

Source : https://x.com/_Mira___Mira_/status/1783716276944486751

Source photo : https ://x.com/DavidFSWD/status/1783682898786152470

Et maintenant on cherche le nom de l'auteur, et il n'a pas complètement disparu du site officiel de Microsoft :

Source : https://www .microsoft.com/en-us/research/people/qins/

Quatrièmement, certaines personnes pensent que Microsoft a retiré ce modèle open source, d'une part parce que les performances sont trop proches de GPT-4, et d'autre part à cause des problèmes techniques. feuille de route avec OpenAI " Crash".

Quel est l'itinéraire spécifique ? Nous pouvons jeter un œil aux détails techniques de la page du blog originale.

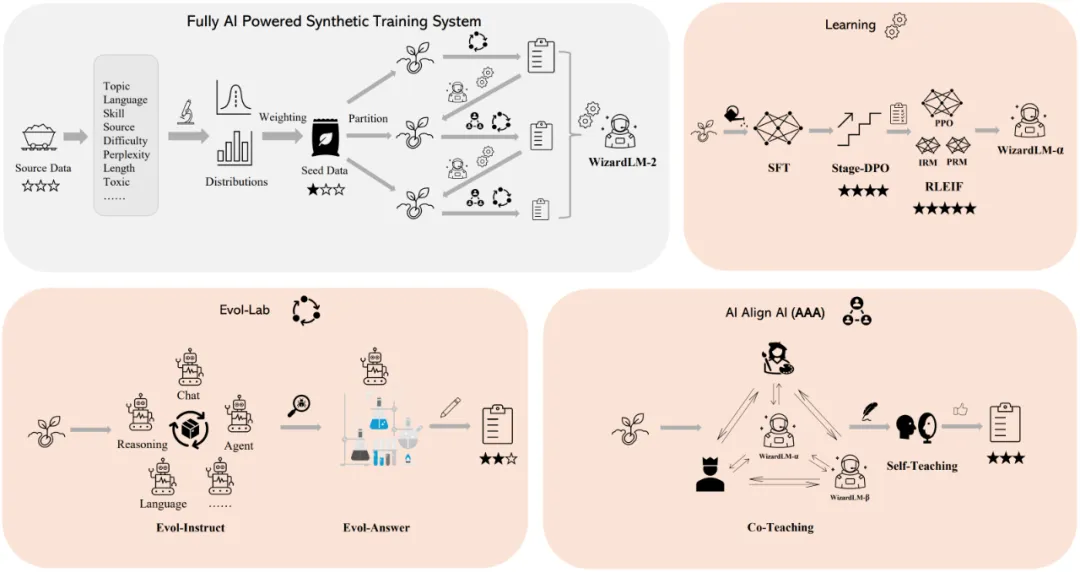

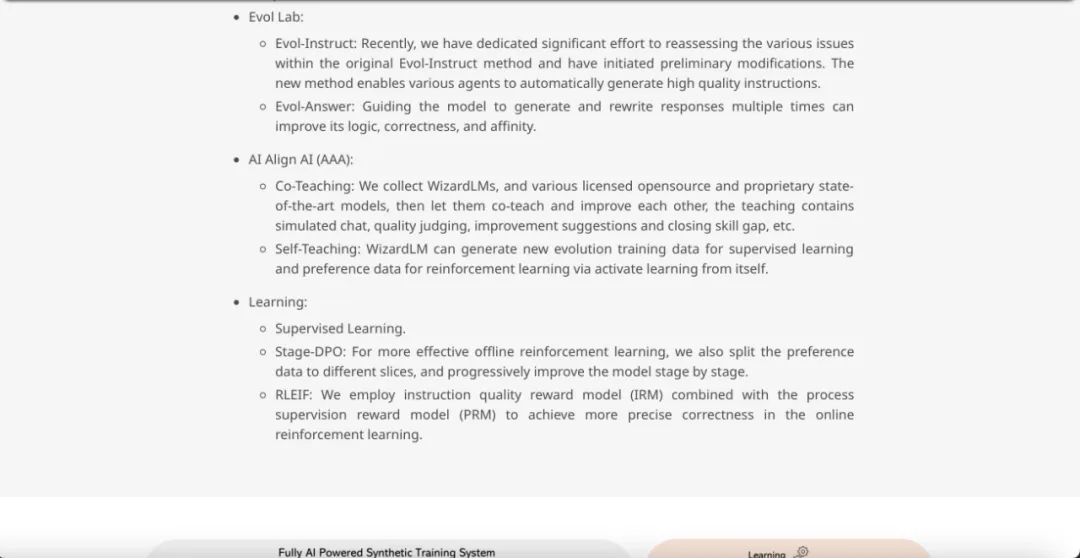

L'équipe a déclaré que grâce à la formation LLM, les données générées par l'homme dans la nature sont de plus en plus épuisées, et que les données soigneusement créées par l'IA et les modèles supervisés par l'IA étape par étape seront le seul moyen d'obtenir une IA plus puissante.

Au cours de la dernière année, l'équipe Microsoft a construit un système de formation synthétique entièrement alimenté par l'intelligence artificielle, comme le montre la figure ci-dessous.

est grossièrement divisé en plusieurs sections :

Prétraitement des données :

- Analyse des données : Utilisez ce pipeline pour obtenir la distribution des différents attributs des nouvelles données sources, ce qui aide à avoir une compréhension préliminaire des données.

- Échantillonnage pondéré : la distribution des données d'entraînement optimales est souvent incompatible avec la distribution naturelle du corpus de discussion humaine. Il est nécessaire d'ajuster le poids de chaque attribut dans les données d'entraînement en fonction de l'expérience expérimentale.

Evol Lab :

- Evol-Instruct : De nombreux efforts ont été déployés pour réévaluer divers problèmes liés à la méthode Evol-Instruct originale et les réorganiser. Modifications initiales , la nouvelle méthode permet à divers agents de générer automatiquement des instructions de haute qualité.

- Evol-Answer : guidez le modèle pour générer et réécrire des réponses plusieurs fois, ce qui peut améliorer sa logique, son exactitude et son affinité.

AI Align AI (AAA) :

- Co-enseignement : collectez WizardLM et divers modèles de pointe open source et propriétaires autorisés, puis laissez-les enseigner ensemble et s'améliorer chacun autres. Le contenu pédagogique comprend un chat de simulation, des évaluations de qualité, des suggestions d'amélioration, la réduction des lacunes en matière de compétences, etc.

- Auto-apprentissage : WizardLM peut générer de nouvelles données d'entraînement évolutives pour l'apprentissage supervisé et des données de préférence pour l'apprentissage par renforcement grâce à l'apprentissage par activation.

Apprentissage :

- Apprentissage supervisé.

- Phase - DPO : Afin d'effectuer plus efficacement un apprentissage par renforcement hors ligne, les données préférées sont divisées en différents fragments et le modèle est amélioré étape par étape.

- RLEIF : Utilisation d'une méthode qui combine le modèle de récompense de la qualité de l'instruction (IRM) et le modèle de récompense de la supervision des processus (PRM) pour obtenir une exactitude plus précise dans l'apprentissage par renforcement en ligne.

La dernière chose que je veux dire, c'est que toute spéculation est vaine, attendons avec impatience le retour de WizardLM-2.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!