Maison >Périphériques technologiques >IA >Docker achève le déploiement local du grand modèle open source LLama3 en trois minutes

Docker achève le déploiement local du grand modèle open source LLama3 en trois minutes

- 王林avant

- 2024-04-26 10:19:211664parcourir

Présentation

LLaMA-3 (Large Language Model Meta AI 3) est un modèle d'intelligence artificielle générative open source à grande échelle développé par Meta Company. Il ne présente aucun changement majeur dans la structure du modèle par rapport à la génération précédente LLaMA-2.

Le modèle LLaMA-3 est divisé en différentes versions à échelle, notamment petite, moyenne et grande, pour s'adapter aux différentes exigences des applications et ressources informatiques. La taille des paramètres des petits modèles est de 8B, la taille des paramètres des modèles moyens est de 70B et la taille des paramètres des grands modèles atteint 400B. Cependant, lors de la formation, l'objectif est d'atteindre une fonctionnalité multimodale et multilingue, et les résultats devraient être comparables à GPT 4/GPT 4V.

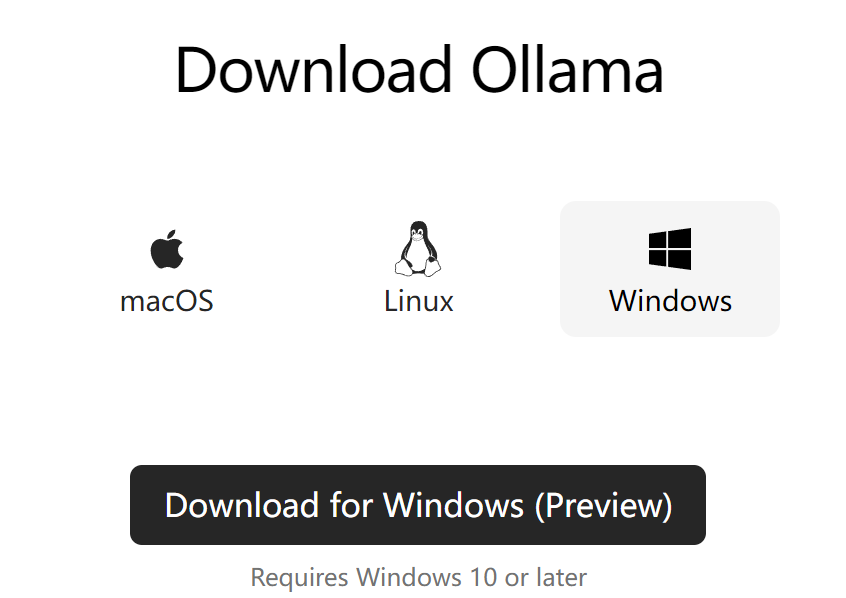

Installer Ollama

Ollama est un outil de service open source de grands modèles de langage (LLM) qui permet aux utilisateurs d'exécuter et de déployer de grands modèles de langage sur leur machine locale. Ollama est conçu comme un framework qui simplifie le processus de déploiement et de gestion de grands modèles de langage dans des conteneurs Docker, rendant le processus rapide et facile. Les utilisateurs peuvent exécuter rapidement des modèles de langage open source à grande échelle tels que Llama 3 localement via de simples opérations de ligne de commande.

Adresse officielle du site Web : https://ollama.com/download

Pictures

Pictures

Ollama est un outil qui prend en charge plusieurs plates-formes, notamment Mac et Linux, et fournit des images Docker pour simplifier le processus d'installation. Les utilisateurs peuvent importer et personnaliser davantage de modèles en écrivant un Modelfile, qui est similaire au rôle d'un Dockerfile. Ollama propose également une API REST pour exécuter et gérer des modèles, ainsi qu'un ensemble d'outils de ligne de commande pour l'interaction des modèles.

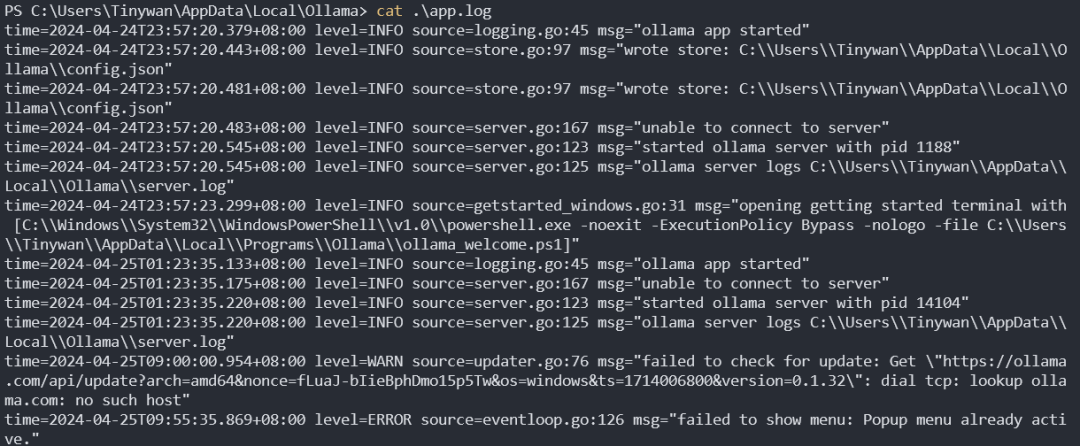

Journal de démarrage du service Ollama

Photos

Photos

Gestion des modèles

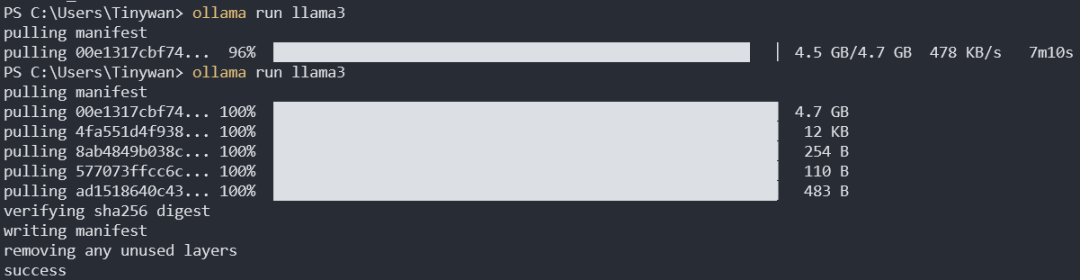

Télécharger le modèle

ollama pull llama3:8b

Le téléchargement par défaut est lama3:8b. Les deux points avant les deux points ici représentent le nom du modèle, et les deux points après la balise représentent la balise. Vous pouvez voir toutes les balises de lama3 à partir d'ici

photos

photos

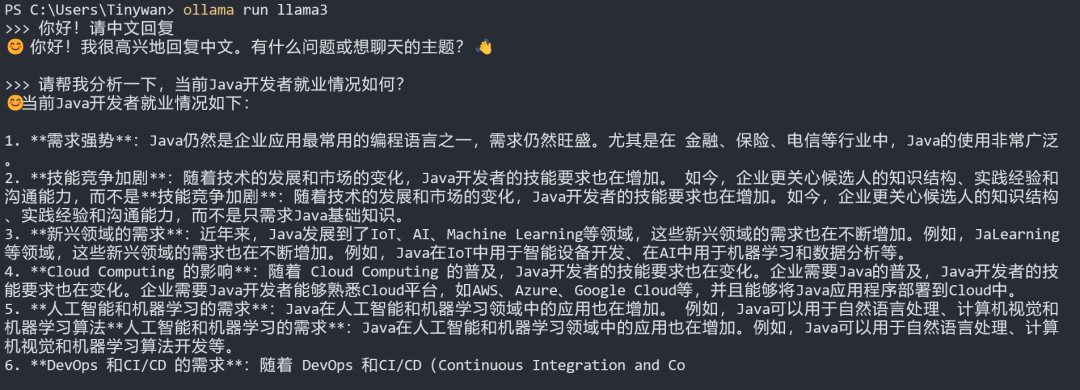

tests du modèle

Remarque : si vous souhaitez que le modèle le fasse. répondez en chinois, veuillez d'abord saisir : Bonjour ! Veuillez répondre en chinois

image

image

Configurer Open-WebUI

Exécuter sous CPU

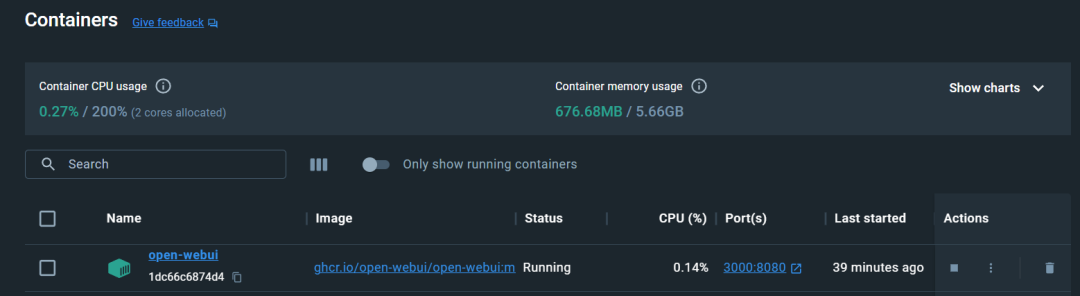

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

image

image

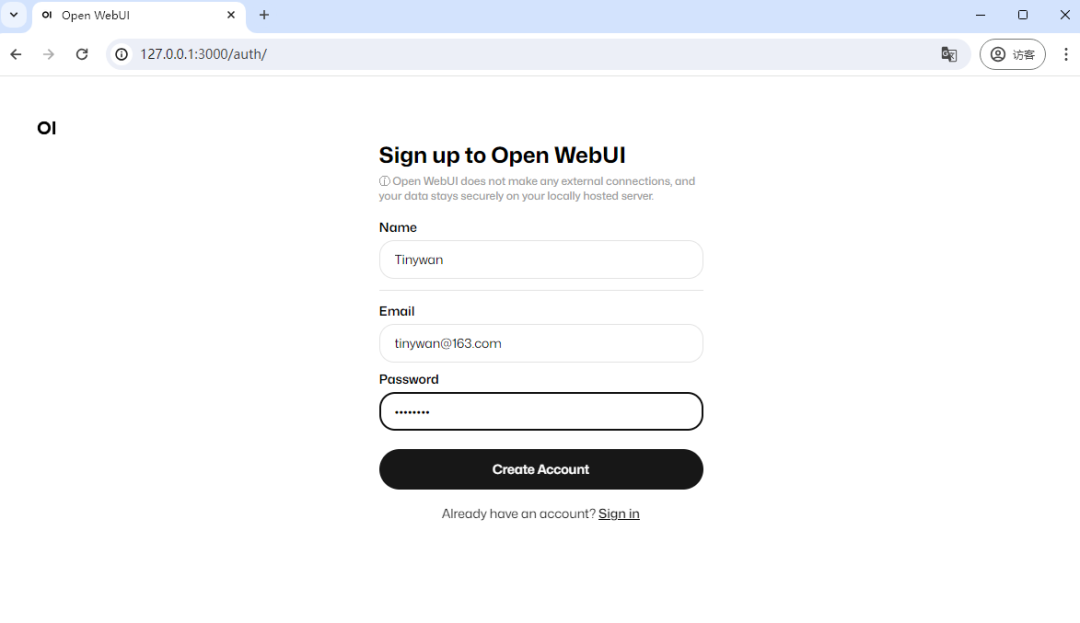

Visite

Entrez l'adresse http://127.0.0.1:3000 pour l'accès

Photos

Photos

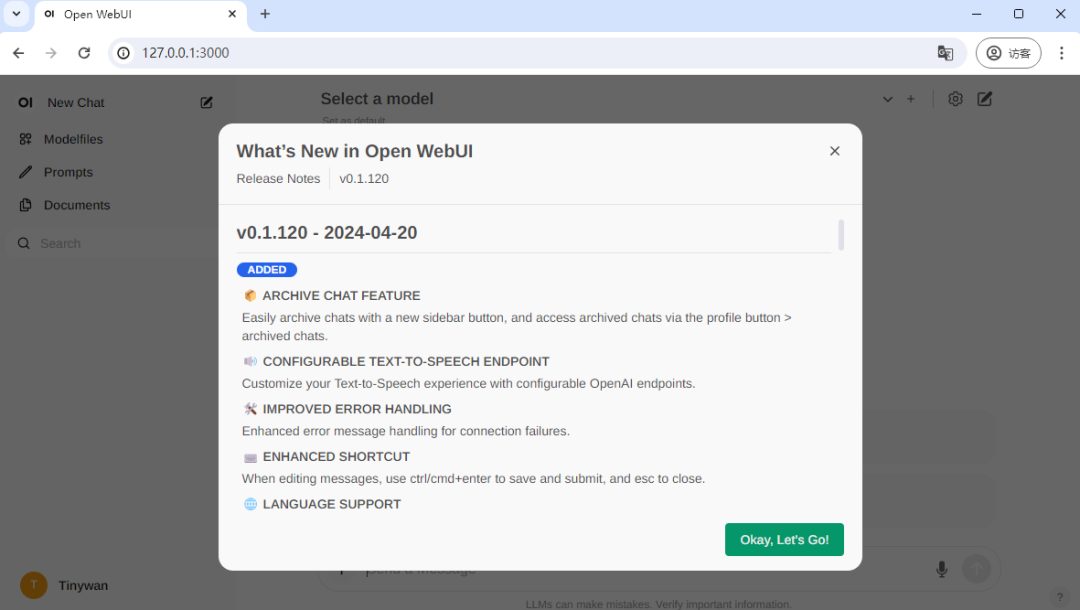

Vous devez vous inscrire pour la première visite, ici j'enregistre un compte, l'inscription est terminée et la connexion est réussie

Photos

Photos

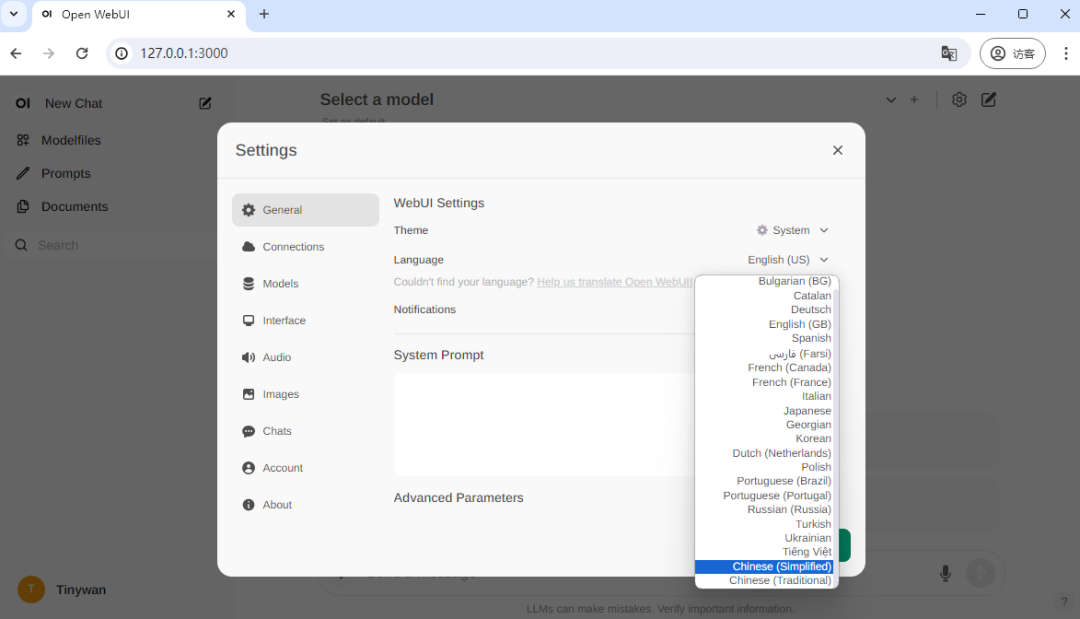

Changer de langue chinoise

Photos

Photos

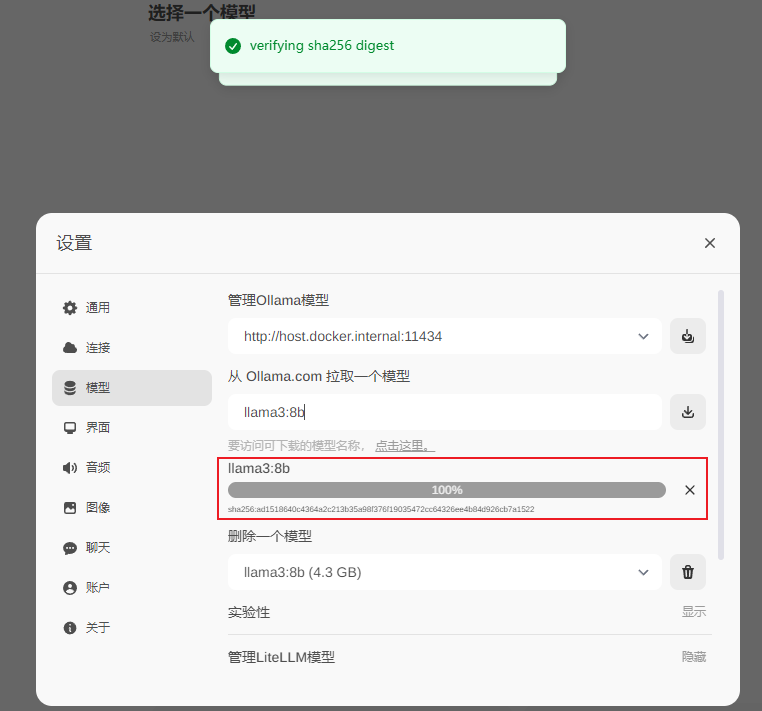

Téléchargez le modèle lama3:8b

llama3:8b

images

images

Téléchargement terminé

images

images

Utiliser

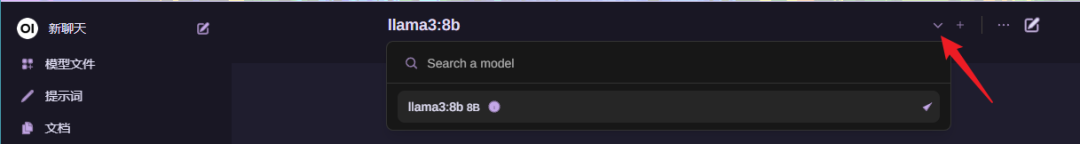

Choisir le modèle

images

images

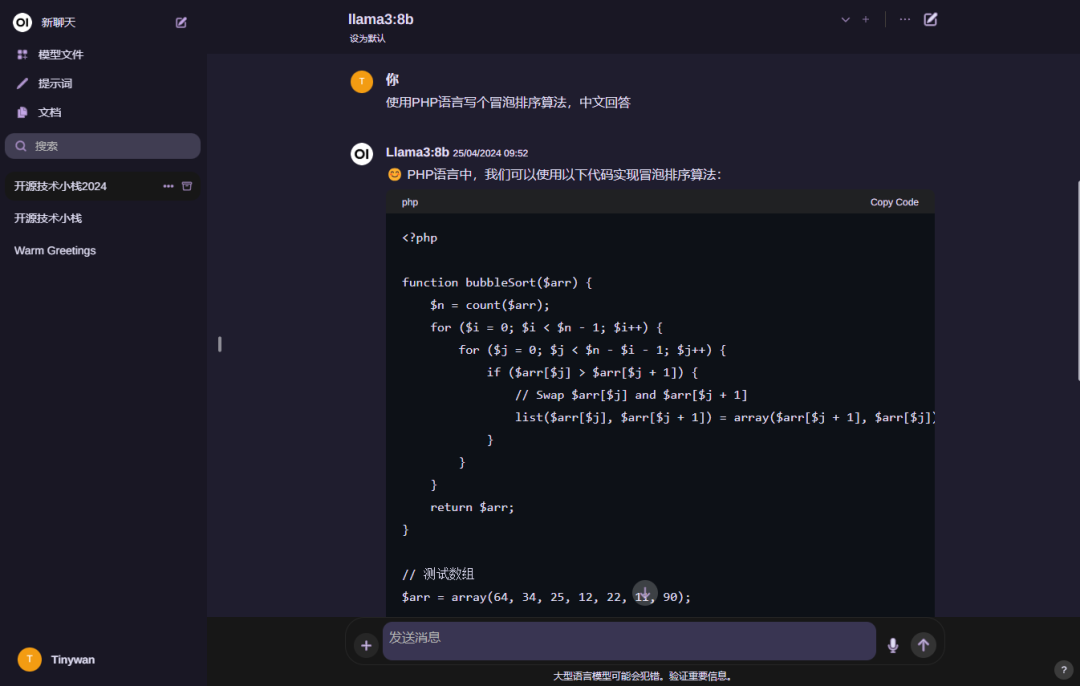

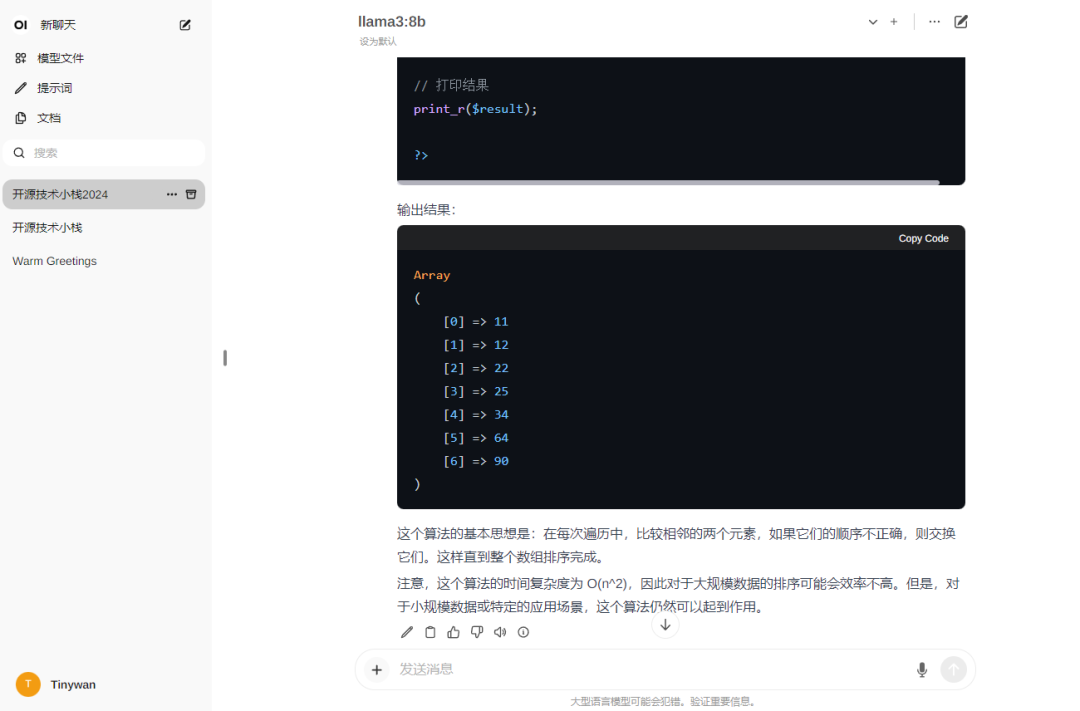

Utiliser le modèle

images

images

Remarque : Si vous souhaitez que le modèle réponde en chinois, veuillez d'abord saisir : Bonjour ! Veuillez répondre en chinois

Photos

Photos

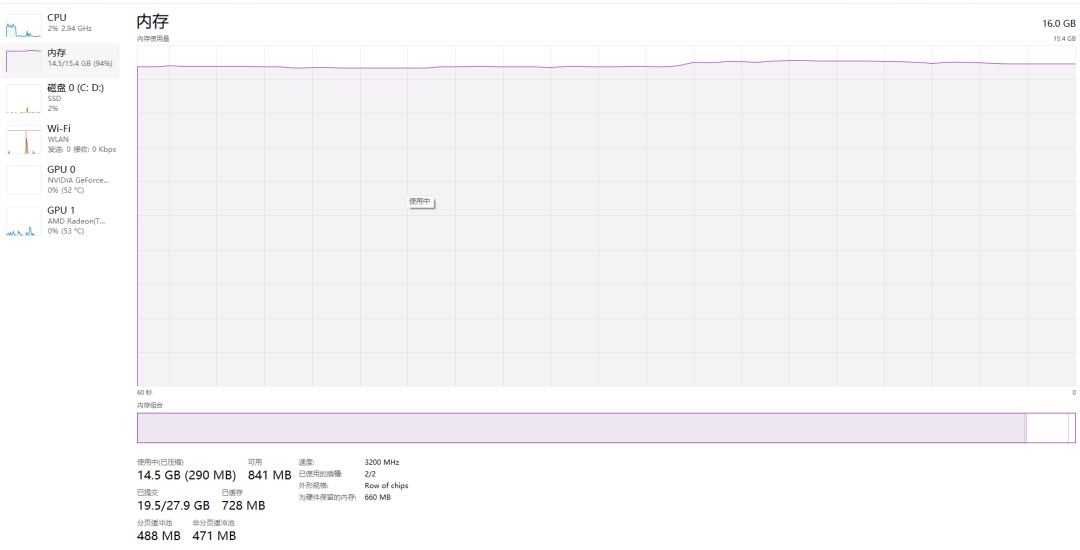

Mémoire

Photos

Photos

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Quelles sont les propriétés du modèle de boîte en CSS ? Introduction aux propriétés liées au modèle de boîte CSS

- Comment entrer les privilèges root sous Linux

- Comment afficher les fichiers dans le conteneur Docker

- Dans la technologie des bases de données, quels sont les quatre principaux modèles de données ?

- Quelle est la différence entre Kubernetes et Docker