Maison >Périphériques technologiques >IA >Au-delà de BEVFormer ! CR3DT : RV Fusion facilite la détection et le suivi 3D du nouveau SOTA (ETH)

Au-delà de BEVFormer ! CR3DT : RV Fusion facilite la détection et le suivi 3D du nouveau SOTA (ETH)

- PHPzavant

- 2024-04-24 18:07:211153parcourir

Écrit devant et compréhension personnelle de l'auteur

Cet article présente une méthode de fusion caméra-radar à ondes millimétriques (CR3DT) pour la détection de cibles 3D et le suivi multi-cibles. La méthode basée sur le lidar a établi une norme élevée dans ce domaine, mais sa puissance de calcul élevée et son coût élevé ont limité le développement de cette solution dans le domaine de la conduite autonome ; les solutions de détection et de suivi de cibles 3D basées sur une caméra sont dues à leur haute qualité. coût Il est relativement faible et a attiré l'attention de nombreux chercheurs, mais en raison de ses mauvais résultats. La fusion des caméras et du radar à ondes millimétriques devient donc une solution prometteuse. Dans le cadre de la caméra existante BEVDet, l'auteur fusionne les informations spatiales et de vitesse du radar à ondes millimétriques et les combine avec la tête de suivi CC-3DT++ pour améliorer considérablement la précision de la détection et du suivi des cibles 3D et neutraliser la contradiction entre performances et coût.

Contribution principale

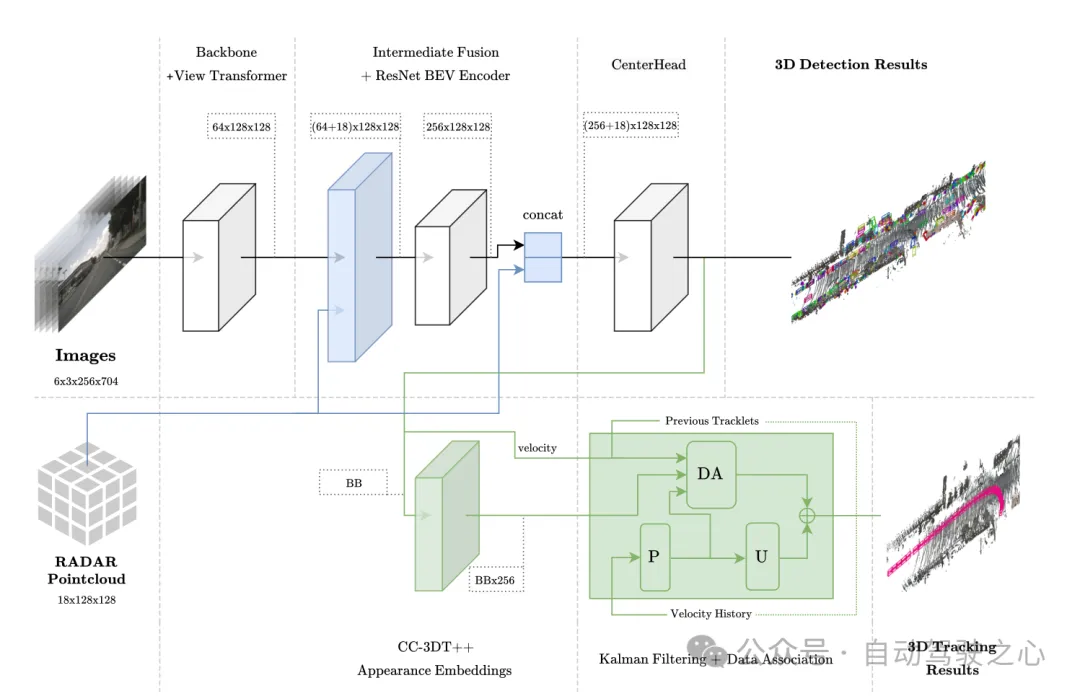

Architecture de fusion de capteursLe CR3DT proposé utilise une technologie de fusion intermédiaire avant et après l'encodeur BEV pour intégrer les données radar à ondes millimétriques tandis que pour le suivi, une tête d'intégration d'apparence quasi-dense est utilisée, Target ; corrélation utilisant l'estimation de la vitesse à partir d'un radar à ondes millimétriques.

Évaluation des performances de détection CR3DT a obtenu 35,1 % de mAP et 45,6 % de score de détection (NDS) nuScenes sur l'ensemble de validation de détection 3D nuScenes. Tirant parti des riches informations de vitesse contenues dans les données radar, l'erreur de vitesse moyenne (mAVE) du détecteur est réduite de 45,3 % par rapport aux détecteurs de caméra SOTA.

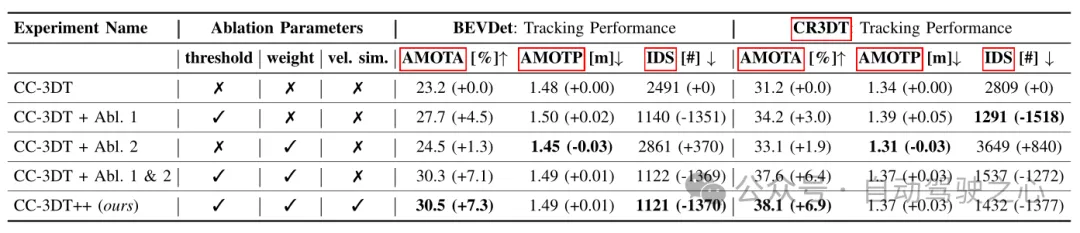

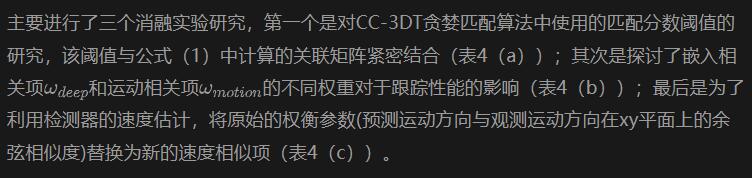

Évaluation des performances de suivi Les performances de suivi de CR3DT sur l'ensemble de validation de suivi nuScenes sont de 38,1 % AMOTA, une amélioration AMOTA de 14,9 % par rapport au modèle de suivi SOTA avec caméra uniquement, l'utilisation explicite des informations de vitesse dans le tracker et d'autres améliorations a considérablement réduit le nombre d’IDS d’environ 43 %.

Architecture du modèle

Cette méthode est basée sur le cadre EV-Det, fusionne les informations spatiales et de vitesse du RADAR et est combinée avec la tête de suivi CC-3DT++, qui utilise explicitement un détecteur amélioré de radar à ondes millimétriques dans son association de données. Estimation de la vitesse, permettant finalement la détection et le suivi de cibles 3D.

Figure 1 Architecture globale. La détection et le suivi sont surlignés respectivement en bleu clair et vert.

Figure 1 Architecture globale. La détection et le suivi sont surlignés respectivement en bleu clair et vert.

Fusion de capteurs dans l'espace BEV

Ce module adopte une méthode de fusion similaire à PointPillars, y compris l'agrégation et la connexion en son sein. La grille BEV est définie sur [-51,2, 51,2] avec une résolution de 0,8, ce qui donne une grille de fonctionnalités (128 × 128). Projetez les caractéristiques de l'image directement dans l'espace BEV. Le nombre de canaux de chaque unité de grille est de 64, puis les caractéristiques de l'image BEV sont (64 × 128 × 128) de la même manière, les informations à 18 dimensions du radar sont agrégées dans chaque In ; l'unité de grille, cela inclut les coordonnées x, y et z du point, et aucune amélioration n'est apportée aux données radar. L'auteur a confirmé que le nuage de points Radar contient déjà plus d'informations que le nuage de points LiDAR, la fonction Radar BEV est donc (18 × 128 × 128). Enfin, les caractéristiques de l'image BEV (64 × 128 × 128) et les caractéristiques du radar BEV (18 × 128 × 128) sont directement connectées ((64 + 18) × 128 × 128) en tant qu'entrée de la couche de codage des caractéristiques BEV. Dans des expériences d'ablation ultérieures, il a été constaté qu'il est avantageux d'ajouter des connexions résiduelles à la sortie de la couche de codage de caractéristiques BEV avec une dimension de (256 × 128 × 128), ce qui donne une taille d'entrée finale de la tête de détection CenterPoint de ( (256+18 )×128×128).

Figure 2 Visualisation du nuage de points radar agrégé dans l'espace BEV pour l'opération de fusion

Architecture du module de suivi

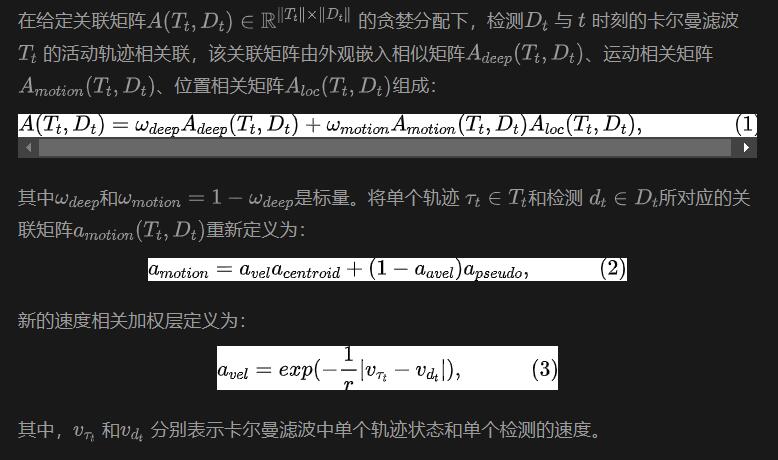

Le suivi consiste à associer des cibles dans deux cadres différents en fonction de la corrélation de mouvement et de la similarité des caractéristiques visuelles. Au cours du processus de formation, des vecteurs d'intégration de caractéristiques visuelles unidimensionnelles sont obtenus grâce à un apprentissage à contraste positif multivarié quasi-dense, puis la détection et l'intégration de caractéristiques sont utilisées simultanément dans l'étape de suivi de CC-3DT. L'étape d'association de données (module DA sur la figure 1) a été modifiée pour tirer parti de la détection de position et de l'estimation de la vitesse CR3DT améliorées. Les détails sont les suivants :

Les expériences et les résultats

ont été réalisés sur la base de l'ensemble de données nuScenes, et toutes les formations n'ont pas utilisé le CBGS.

Modèle restreint

Parce que l'auteur a réalisé l'intégralité du modèle sur un ordinateur équipé d'une carte graphique 3090, on l'appelle un modèle restreint. La partie détection de cible de ce modèle utilise BEVDet comme référence de détection, l'épine dorsale de codage d'image est ResNet50 et l'entrée d'image est définie sur (3 × 256 × 704) les informations d'image passées ou futures ne sont pas utilisées dans le modèle, et la taille du lot est définie sur 8. Pour atténuer la rareté des données radar, cinq analyses sont utilisées pour améliorer les données. Aucune information temporelle supplémentaire n'est utilisée dans le modèle de fusion.

Pour la détection de cibles, utilisez les scores de mAP, NDS et mAVE pour évaluer le suivi, utilisez AMOTA, AMOTP et IDS pour évaluer.

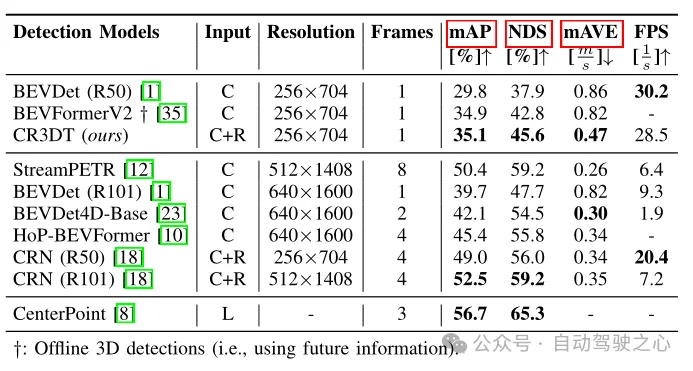

Résultats de détection d'objets

Tableau 1 Résultats de détection sur l'ensemble de validation nuScenes

Le Tableau 1 montre les performances de détection de CR3DT par rapport à l'architecture de base BEVDet (R50) en utilisant uniquement des caméras. Il est évident que l’ajout du Radar améliore considérablement les performances de détection. Sous les contraintes d'une petite résolution et d'un laps de temps réduit, CR3DT atteint avec succès une amélioration de 5,3 % de mAP et de 7,7 % de NDS par rapport au BEVDet avec caméra uniquement. Cependant, en raison des limites de la puissance de calcul, l'article n'a pas abouti à des résultats expérimentaux de haute résolution, de fusion d'informations temporelles, etc. De plus, le temps d'inférence est également indiqué dans la dernière colonne du tableau 1.

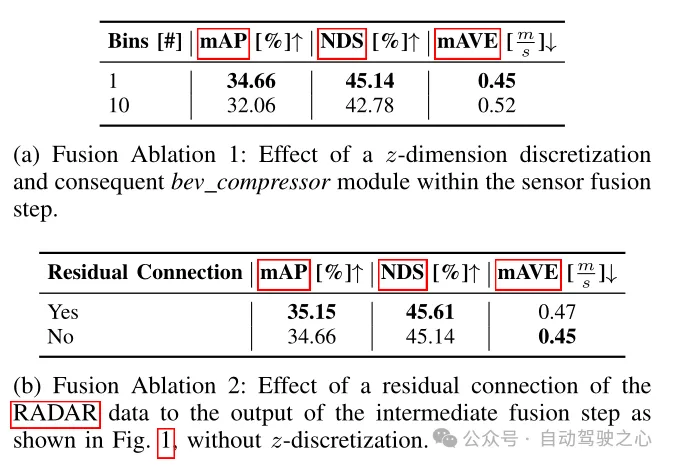

Tableau 2 Expérience d'ablation du cadre de détection

Dans le tableau 2, l'impact de différentes architectures de fusion sur les indicateurs de détection est comparé. Les méthodes de fusion ici sont divisées en deux types : la première est mentionnée dans l'article, qui abandonne la voxélisation dimensionnelle z et la convolution 3D ultérieure, et agrège directement les caractéristiques d'image améliorées et les données RADAR pures en colonnes, obtenant ainsi la taille des caractéristiques connues. est ((64+18)×128×128) ; l'autre consiste à voxer les caractéristiques d'image améliorées et les données RADAR pures dans un cube d'une taille de 0,8×0,8×0,8 m pour obtenir des caractéristiques alternatives. La taille est ((64+ 18) × 10 × 128 × 128), le module compresseur BEV doit donc être utilisé sous forme de convolution 3D. Comme le montre le tableau 2(a), une augmentation du nombre de compresseurs BEV entraînera une diminution des performances, et on peut voir que la première solution est plus performante. Il ressort également du tableau 2 (b) que l'ajout du bloc résiduel de données radar peut également améliorer les performances, ce qui confirme également ce qui a été mentionné dans l'architecture du modèle précédent. L'ajout de connexions résiduelles à la sortie de la couche de codage de fonctionnalités BEV est un avantage. .

Tableau 3 Résultats de suivi sur l'ensemble de validation nuScenes en fonction de différentes configurations de base BEVDet et CR3DT

Tableau 3 Résultats de suivi sur l'ensemble de validation nuScenes en fonction de différentes configurations de base BEVDet et CR3DT

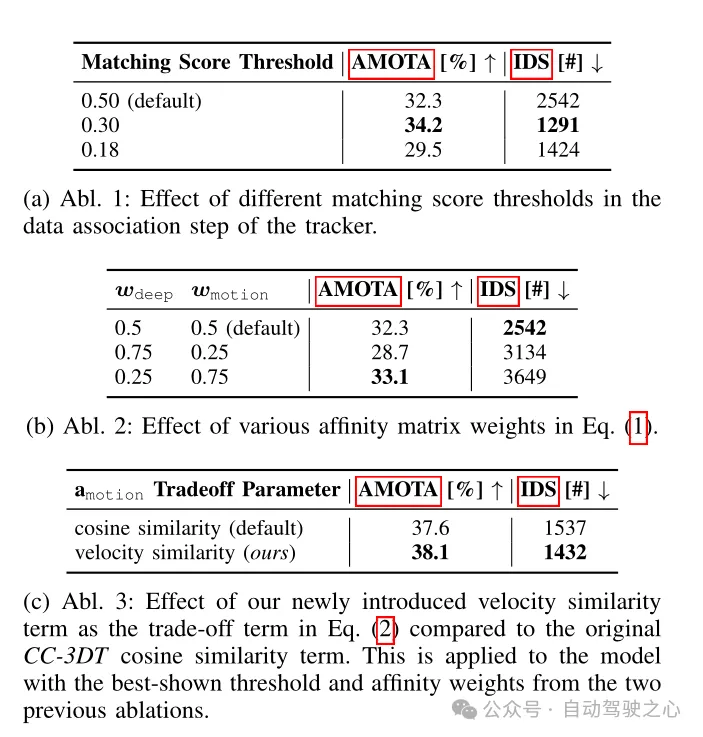

Le Tableau 3 montre les résultats de suivi du modèle de suivi CC3DT++ amélioré sur l'ensemble de validation nuScenes. Il montre les résultats de suivi du tracker sur. la référence et les performances sur le modèle de détection CR3DT. Le modèle CR3DT améliore les performances de l'AMOTA de 14,9 % par rapport à la ligne de base et la diminue de 0,11 m dans l'AMOTP. De plus, on peut constater que l’IDS est réduit d’environ 43 % par rapport à la ligne de base.

Tableau 4 Expériences d'ablation d'architecture de suivi réalisées sur le squelette de détection CR3DT

Conclusion

Ce travail propose un modèle de fusion caméra-radar efficace - CR3DT, spécifiquement pour la détection d'objets 3D et le suivi multi-objets. En fusionnant les données radar dans l'architecture BEVDet réservée aux caméras et en introduisant l'architecture de suivi CC-3DT++, CR3DT a considérablement amélioré la détection et la précision du suivi des cibles 3D, avec mAP et AMOTA augmentant respectivement de 5,35 % et 14,9 %.

La solution d'intégration d'une caméra et d'un radar à ondes millimétriques présente l'avantage d'être faible par rapport au LiDAR pur ou à la solution d'intégration du LiDAR et d'une caméra, et est proche du développement actuel des véhicules autonomes. De plus, le radar à ondes millimétriques présente l'avantage d'être robuste par mauvais temps et peut faire face à une variété de scénarios d'application. Le gros problème actuel est la rareté des nuages de points radar à ondes millimétriques et l'incapacité de détecter les informations de hauteur. Cependant, avec le développement continu du radar à ondes millimétriques 4D, je pense que l'intégration future des caméras et des solutions de radar à ondes millimétriques atteindra un niveau supérieur et obtiendra des résultats encore meilleurs !

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Un article parle du problème de synchronisation de l'horodatage de l'étalonnage du lidar et de la caméra

- Nouvelles photos espion Xpeng P5 exposées : extérieur et intérieur renouvelés, la configuration du radar peut être ajustée

- Hesai Technology coopère avec le groupe FAW pour créer la première solution mondiale de conduite intelligente lidar

- Hesai Technology établit un record de l'industrie : livrant 50 000 lidars montés sur véhicule en un seul mois, ouvrant la voie vers de nouveaux sommets

- La nouvelle camionnette à quatre roues motrices de Radar Automotive « Radar Horizon » est sur le point d'être lancée, avec une accélération de 0 à 0-60 secondes en 4 secondes