Maison > Article > Périphériques technologiques > Le papier Stable Diffusion 3 est enfin publié, et les détails architecturaux sont révélés. Cela aidera-t-il à reproduire Sora ?

Le papier Stable Diffusion 3 est enfin publié, et les détails architecturaux sont révélés. Cela aidera-t-il à reproduire Sora ?

- WBOYavant

- 2024-03-06 17:34:14590parcourir

Le papier pour Stable Diffusion 3 est enfin là !

Ce modèle est sorti il y a deux semaines, utilisant la même architecture DiT (Diffusion Transformer) que Sora, et a fait beaucoup de bruit dès sa sortie.

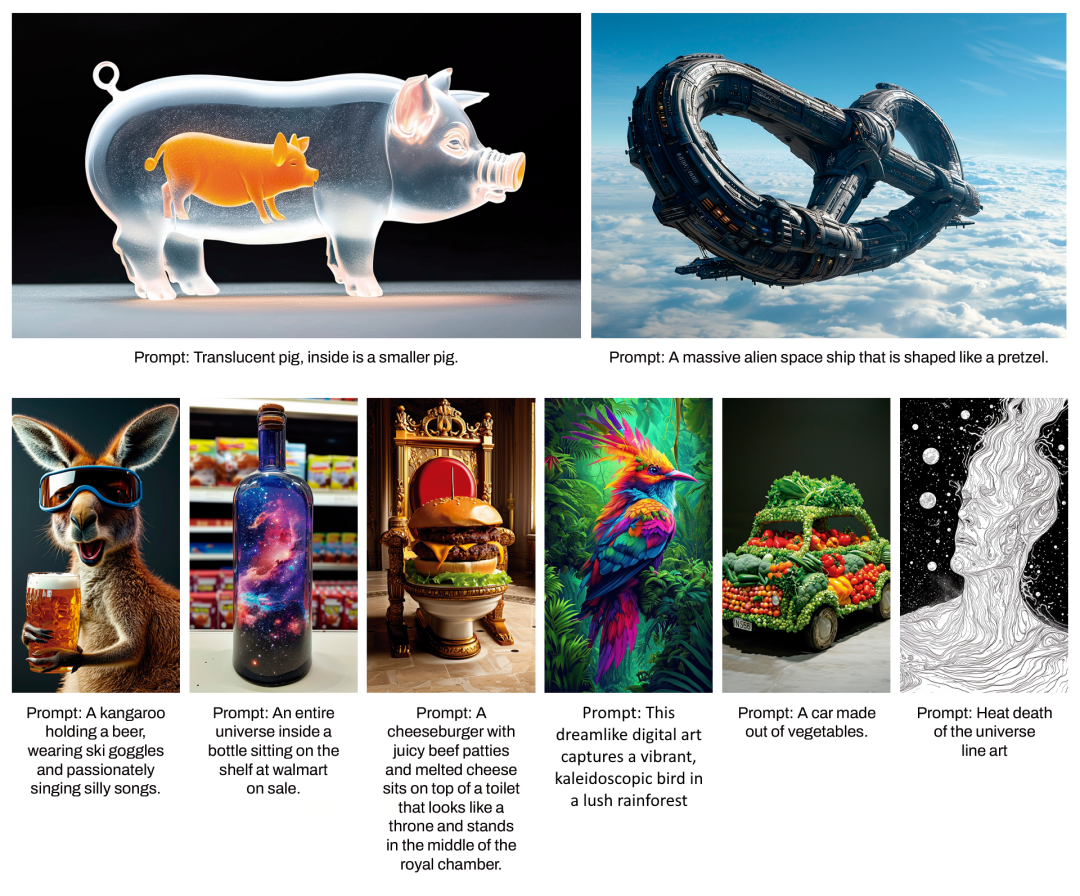

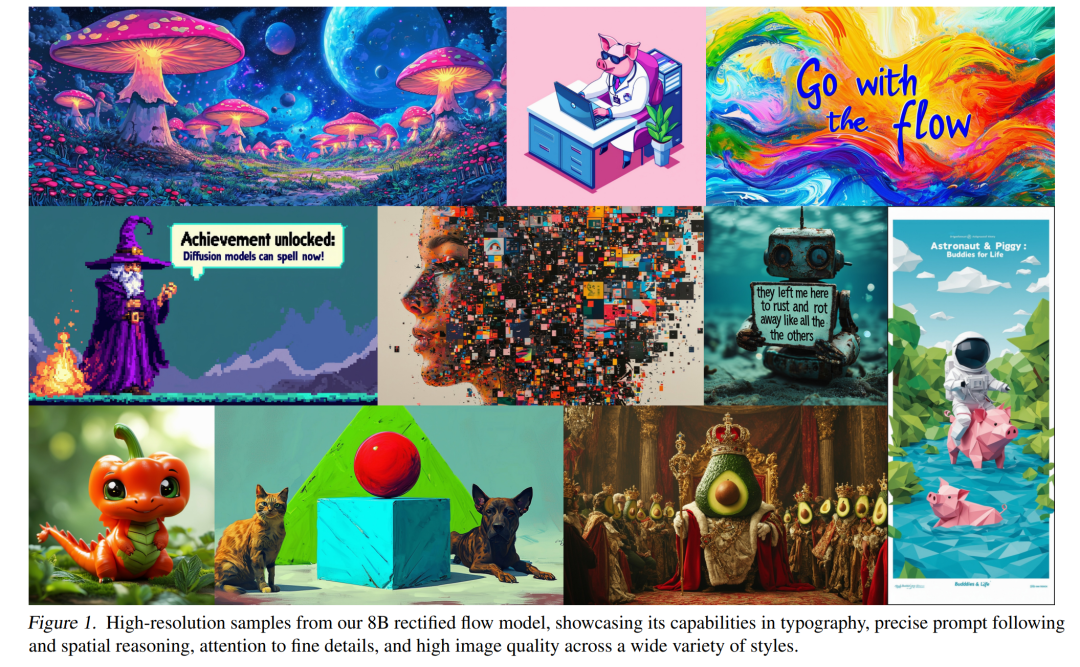

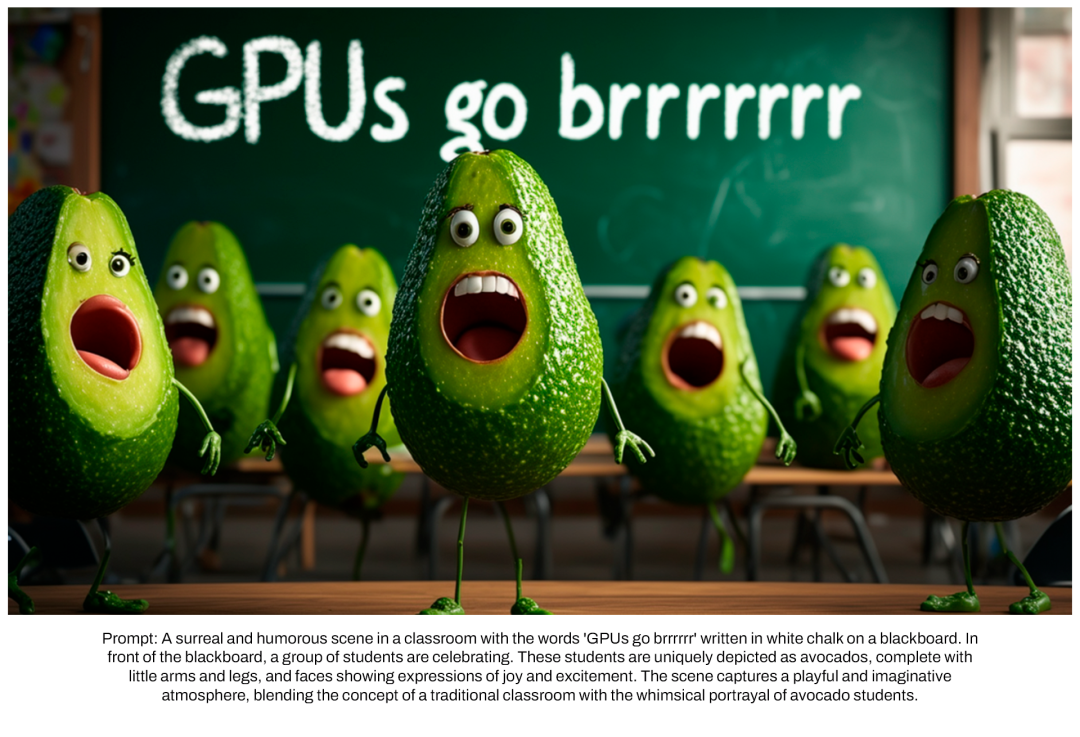

Par rapport à la version précédente, la qualité des images générées par Stable Diffusion 3 a été considérablement améliorée. Il prend désormais en charge les invites multithèmes, et l'effet d'écriture de texte a également été amélioré, plus de caractères tronqués.

Stability AI a souligné que Stable Diffusion 3 est une série de modèles avec des tailles de paramètres allant de 800M à 8B. Cette plage de paramètres signifie que le modèle peut être exécuté directement sur de nombreux appareils portables, abaissant considérablement le seuil d'utilisation de grands modèles d'IA.

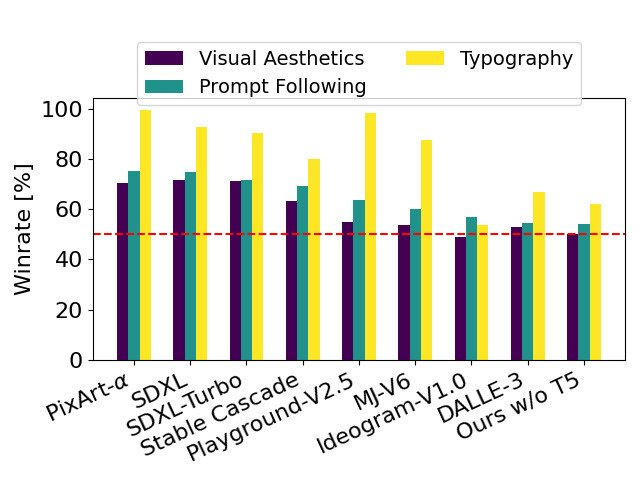

Dans un article récemment publié, Stability AI affirme que dans les évaluations basées sur les préférences humaines, Stable Diffusion 3 surpasse les systèmes de génération de texte en image de pointe actuels tels que DALL・E 3, Midjourney v6, et Idéogramme v1. Bientôt, ils rendront publics les données expérimentales, le code et les poids du modèle de l’étude.

Dans le journal, Stability AI a révélé plus de détails sur Stable Diffusion 3.

- Titre de l'article : Mise à l'échelle des transformateurs de flux rectifiés pour la synthèse d'images à haute résolution

- Lien de l'article : https://stabilityai-public-packages.s3.us-west-2.amazonaws .com/Stable+Diffusion+3+Paper.pdf

Détails architecturaux

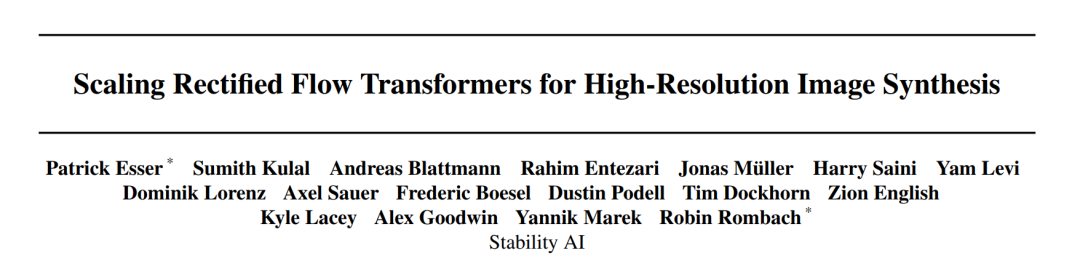

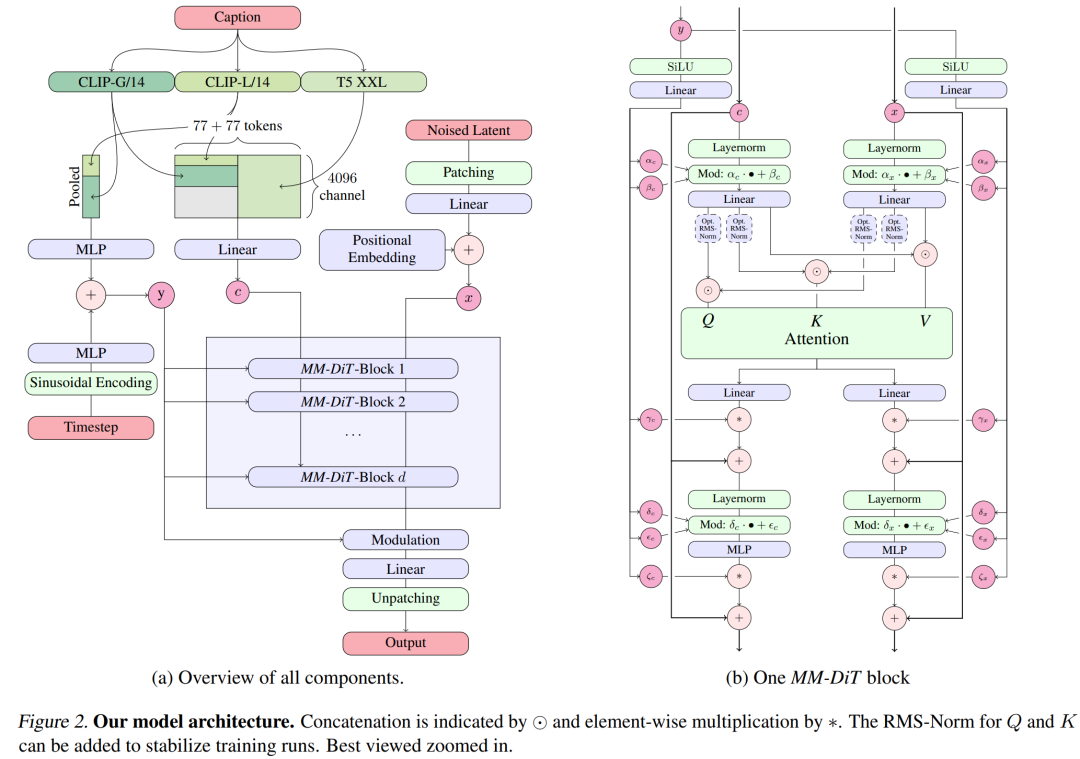

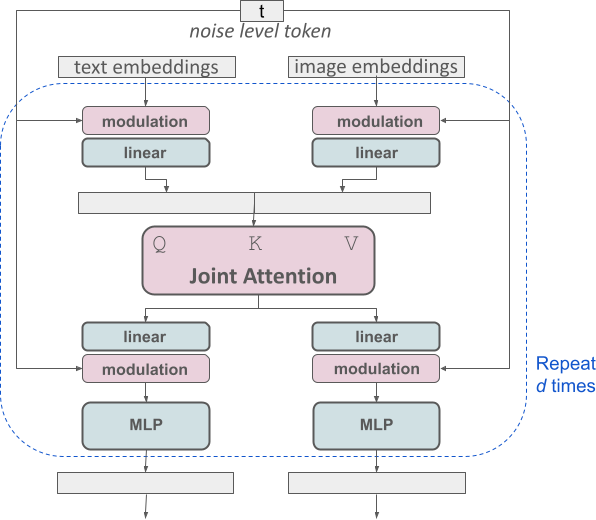

Pour la génération de texte en image, le modèle Stable Diffusion 3 doit prendre en compte à la fois les modes texte et image. C’est pourquoi les auteurs de l’article appellent cette nouvelle architecture MMDiT, en référence à sa capacité à gérer plusieurs modalités. Comme pour les versions précédentes de Stable Diffusion, les auteurs utilisent des modèles pré-entraînés pour dériver des représentations de texte et d'images appropriées. Plus précisément, ils ont utilisé trois modèles d'intégration de texte différents (deux modèles CLIP et T5) pour coder les représentations textuelles, ainsi qu'un modèle d'encodage automatique amélioré pour coder les jetons d'image.

Architecture du modèle Stable Diffusion 3.

Transformateur de diffusion multimodal amélioré : bloc MMDiT.

L'architecture SD3 est basée sur DiT proposé par William Peebles, membre R&D principal de Sora, et Xie Saining, professeur adjoint d'informatique à l'Université de New York. Étant donné que l'intégration de texte et l'intégration d'images sont conceptuellement très différentes, les auteurs de SD3 utilisent deux ensembles de poids différents pour les deux modalités. Comme le montre la figure ci-dessus, cela équivaut à mettre en place deux transformateurs indépendants pour chaque modalité, mais en combinant les séquences des deux modalités pour les opérations d'attention, afin que les deux représentations puissent travailler dans leur propre espace. Une autre représentation est également prise en compte. .

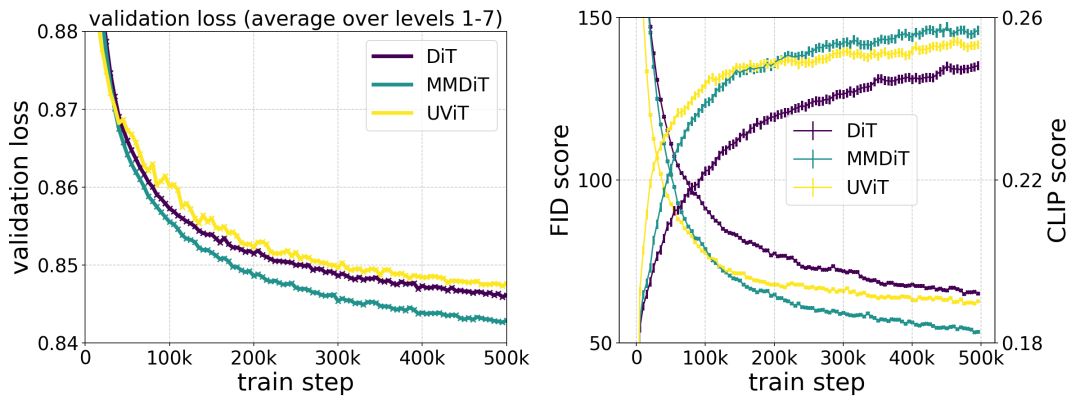

L'architecture MMDiT proposée par les auteurs surpasse les bases de texte-image établies telles que UViT et DiT lors de la mesure de la fidélité visuelle et de l'alignement du texte pendant la formation.

Avec cette approche, les informations peuvent circuler entre les images et les jetons de texte, améliorant ainsi la compréhension globale du modèle et la typographie de la sortie générée. Comme indiqué dans l'article, cette architecture est également facilement extensible à plusieurs modalités telles que la vidéo.

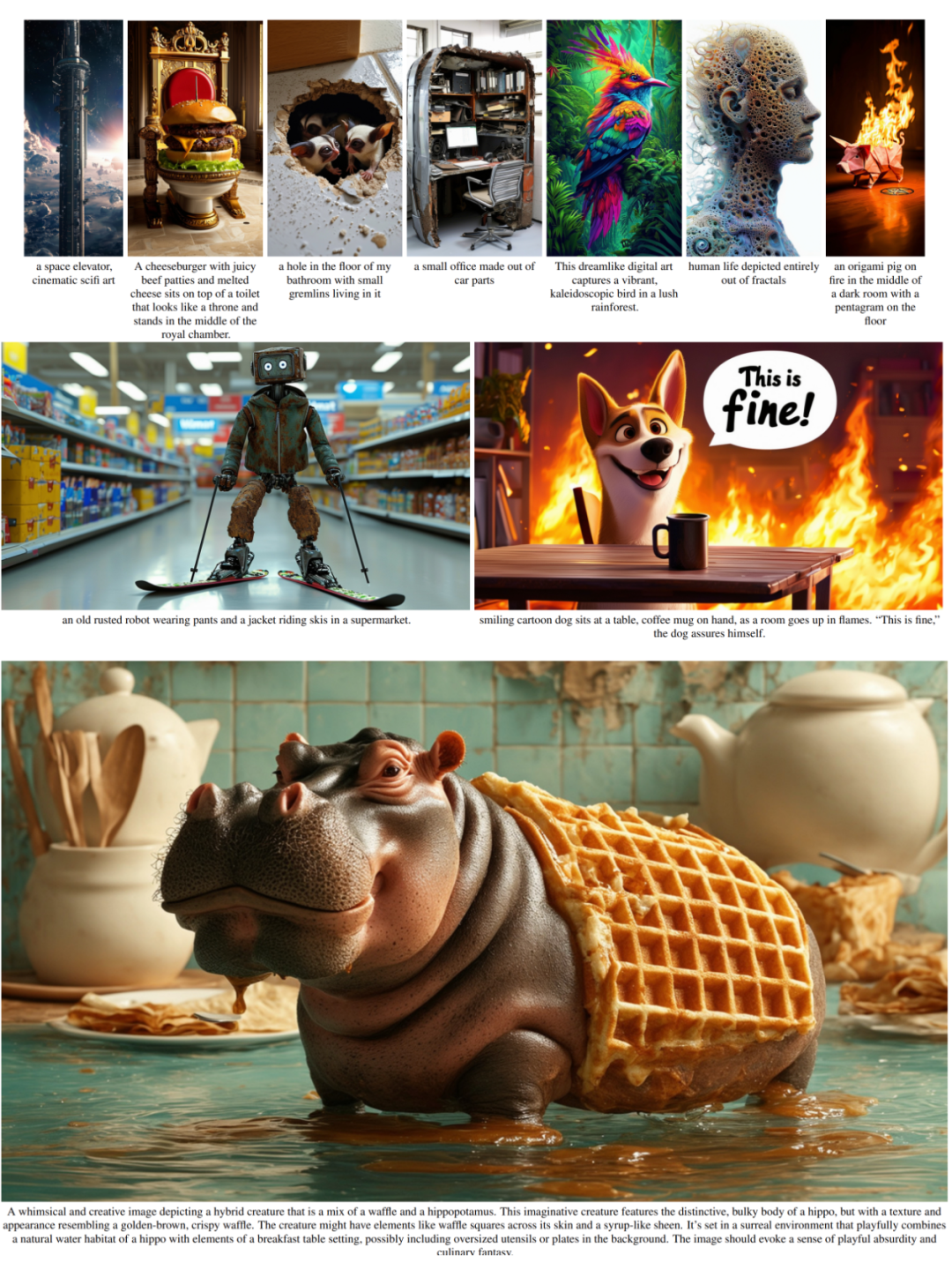

Grâce aux capacités améliorées de suivi d'invite de Stable Diffusion 3, le nouveau modèle a la capacité de produire des images qui se concentrent sur une variété de thèmes et de qualités différents, tout en étant très flexible dans le style de l'image elle-même.

Flux rectifié amélioré grâce à la repondération

Stable Diffusion 3 adopte la formule Rectified Flow (RF) Pendant le processus d'entraînement, les données et le bruit sont connectés dans une trajectoire linéaire. Cela rend le chemin d'inférence plus droit, réduisant ainsi les étapes d'échantillonnage. De plus, les auteurs introduisent également un nouveau schéma d’échantillonnage de trajectoire au cours du processus de formation. Ils ont émis l’hypothèse que la partie médiane de la trajectoire poserait une tâche de prédiction plus difficile, de sorte que le système a accordé plus de poids à la partie médiane de la trajectoire. Ils ont comparé en utilisant plusieurs ensembles de données, métriques et paramètres d'échantillonneur et ont testé la méthode proposée par rapport à 60 autres trajectoires de diffusion telles que LDM, EDM et ADM. Les résultats montrent que même si les performances des formulations RF précédentes s'améliorent avec peu d'étapes d'échantillonnage, leurs performances relatives diminuent à mesure que le nombre d'étapes augmente. En revanche, la variante RF repondérée proposée par les auteurs améliore systématiquement les performances.

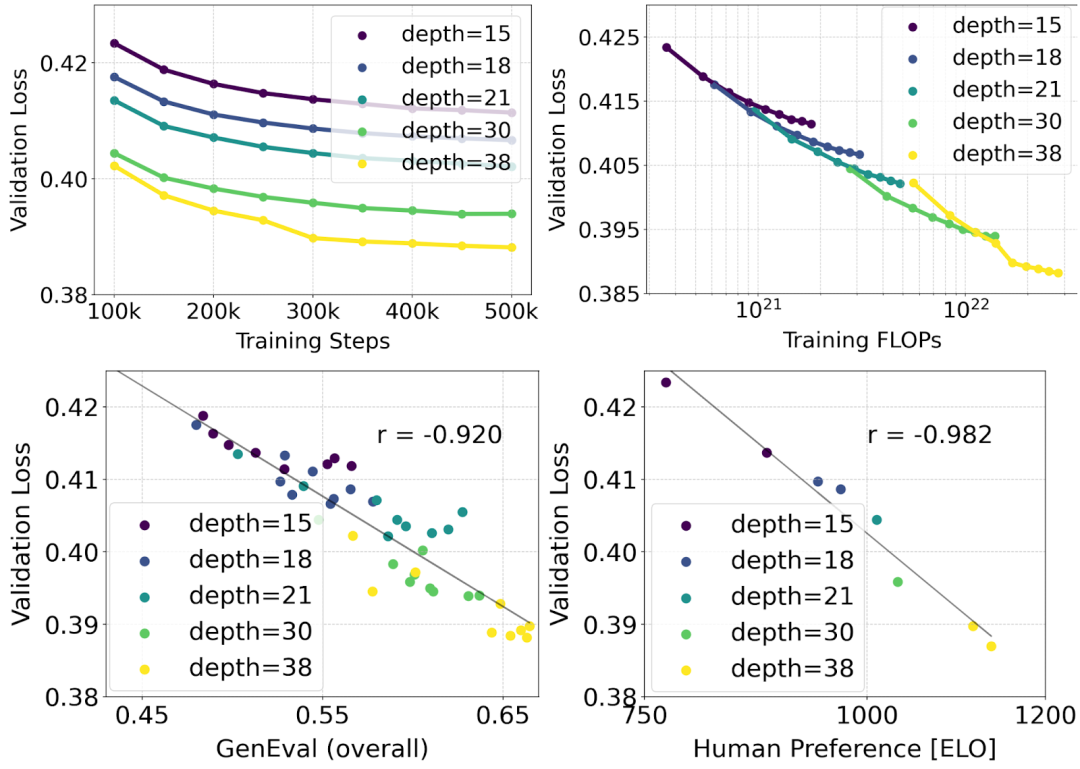

Mise à l'échelle du modèle de transformateur de flux rectifié

L'auteur a mené des recherches de mise à l'échelle sur la synthèse texte-image à l'aide de la formule de flux rectifié repondérée et du squelette MMDiT. Ils ont formé des modèles allant de 15 blocs avec des paramètres 450M à 38 blocs avec des paramètres 8B et ont observé que la perte de validation diminuait progressivement avec l'augmentation de la taille du modèle et des étapes de formation (première partie de la figure ci-dessus OK). Pour examiner si cela se traduisait par des améliorations significatives des résultats du modèle, les auteurs ont également évalué la métrique d'alignement automatique des images (GenEval) et le score de préférence humaine (ELO) (deuxième ligne ci-dessus). Les résultats montrent une forte corrélation entre ces métriques et la perte de validation, ce qui suggère que cette dernière est un bon prédicteur des performances globales du modèle. De plus, la tendance à la mise à l’échelle ne montre aucun signe de saturation, ce qui rend les auteurs optimistes quant à la poursuite de l’amélioration des performances du modèle à l’avenir.

Encodeur de texte flexible

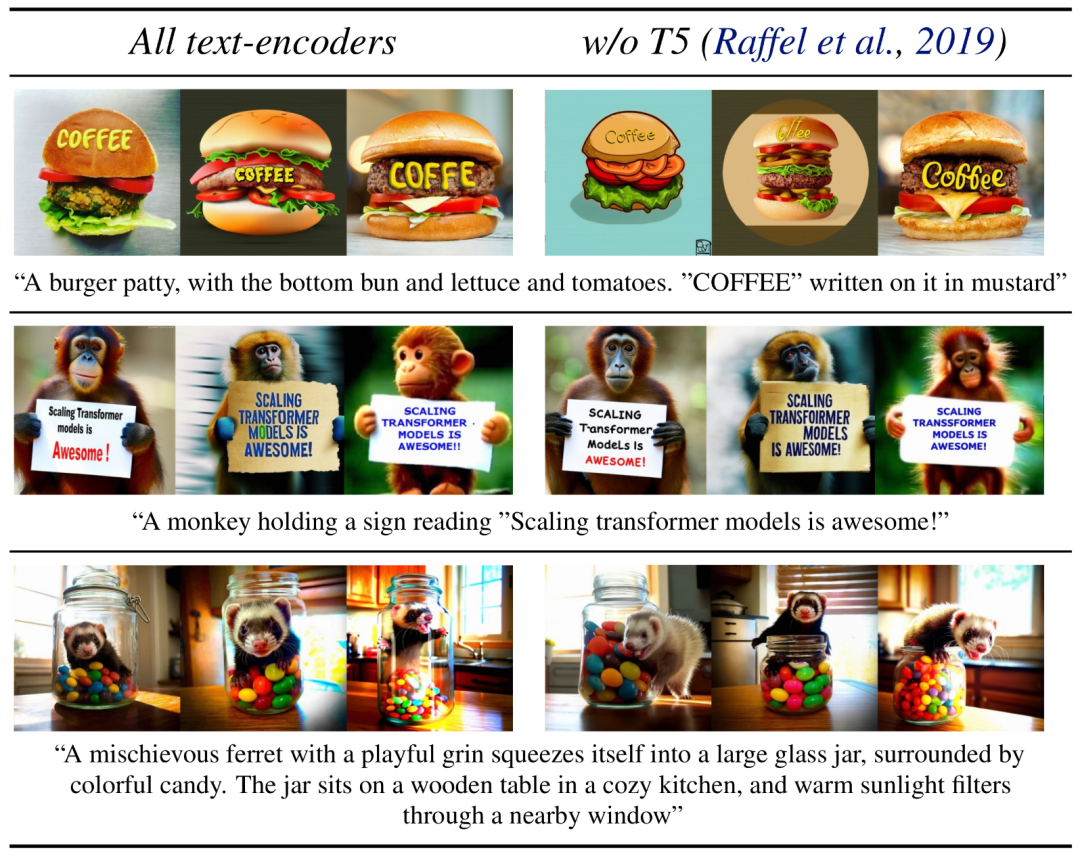

En supprimant l'encodeur de texte T5, paramètre 4,7B, gourmand en mémoire, utilisé pour l'inférence, les besoins en mémoire du SD3 peuvent être considérablement réduits avec une perte de performances minimale. Comme indiqué, la suppression de cet encodeur de texte n'a aucun impact sur l'esthétique visuelle (taux de victoire de 50 % sans T5) et ne réduit que légèrement la cohérence du texte (taux de victoire de 46 %). Cependant, l'auteur recommande d'ajouter T5 lors de la génération de texte écrit pour utiliser pleinement les performances de SD3, car ils ont observé que sans l'ajout de T5, les performances de génération de composition diminuaient encore plus (taux de victoire de 38 %), comme le montre la figure ci-dessous :

La suppression de T5 pour l'inférence n'entraînera qu'une baisse significative des performances lors de la présentation d'invites très complexes impliquant de nombreux détails ou de grandes quantités de texte écrit. L'image ci-dessus montre trois échantillons aléatoires de chaque exemple.

Performances du modèle

L'auteur compare les images de sortie de Stable Diffusion 3 avec divers autres modèles open source (y compris SDXL, SDXL Turbo, Stable Cascade, Playground v2.5 et Pixart-α) ainsi qu'avec des sources fermées. des modèles tels que DALL -E 3, Midjourney v6 et Ideogram v1) ont été comparés pour évaluer les performances sur la base des commentaires humains. Dans ces tests, les évaluateurs humains reçoivent des exemples de résultats de chaque modèle et sont jugés en fonction de la façon dont le résultat du modèle suit le contexte de l'invite donnée (suivi de l'invite), de la qualité du rendu du texte conformément à l'invite (typographie) et quelle image Les images avec une esthétique visuelle plus élevée sont sélectionnées pour obtenir les meilleurs résultats.

Comparé à SD3, ce tableau décrit son taux de victoire basé sur l'évaluation humaine de l'esthétique visuelle, du suivi rapide et de la mise en page du texte.

D'après les résultats des tests, l'auteur a constaté que Stable Diffusion 3 est équivalent, voire meilleur, au système de génération de texte en image de pointe actuel dans tous les aspects ci-dessus.

Lors des premiers tests d'inférence non optimisés sur du matériel grand public, le plus grand modèle SD3 à paramètres 8B s'insère dans la VRAM de 24 Go du RTX 4090, prenant 34 secondes pour générer une image à une résolution de 1024 x 1024 en utilisant 50 étapes d'échantillonnage.

De plus, lors de la version initiale, Stable Diffusion 3 sera disponible en plusieurs variantes, allant des modèles paramétriques 800 m aux modèles paramétriques 8B, afin de supprimer davantage les barrières matérielles.

Veuillez vous référer au document original pour plus de détails.

Lien de référence : https://stability.ai/news/stable-diffusion-3-research-paper

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Quelles sont les caractéristiques de la technologie nb-lot ?

- Que signifie l'ordinateur principal ?

- Quelles sont les quatre technologies fondamentales de la blockchain ?

- Est-il fiable d'utiliser ChatGPT pour rédiger des articles ? Certains chercheurs l'ont essayé : plein de failles, mais un "bon" outil pour l'injection d'eau

- Les « 100 meilleurs articles sur l'IA » en 2022 sont publiés : Tsinghua se classe deuxième après Google et l'Institut de technologie de Ningbo devient le plus grand cheval noir