Maison >Périphériques technologiques >IA >Les « 100 meilleurs articles sur l'IA » en 2022 sont publiés : Tsinghua se classe deuxième après Google et l'Institut de technologie de Ningbo devient le plus grand cheval noir

Les « 100 meilleurs articles sur l'IA » en 2022 sont publiés : Tsinghua se classe deuxième après Google et l'Institut de technologie de Ningbo devient le plus grand cheval noir

- 王林avant

- 2023-04-11 14:07:031976parcourir

Le rythme de l'innovation dans le domaine de l'intelligence artificielle est de plus en plus rapide, et le nombre d'articles a explosé, atteignant même un niveau qui ne peut pas être lu par les humains.

Parmi les articles massifs publiés en 2022, quelles institutions ont le plus d'influence ? Quels articles valent le plus la peine d'être lus ?

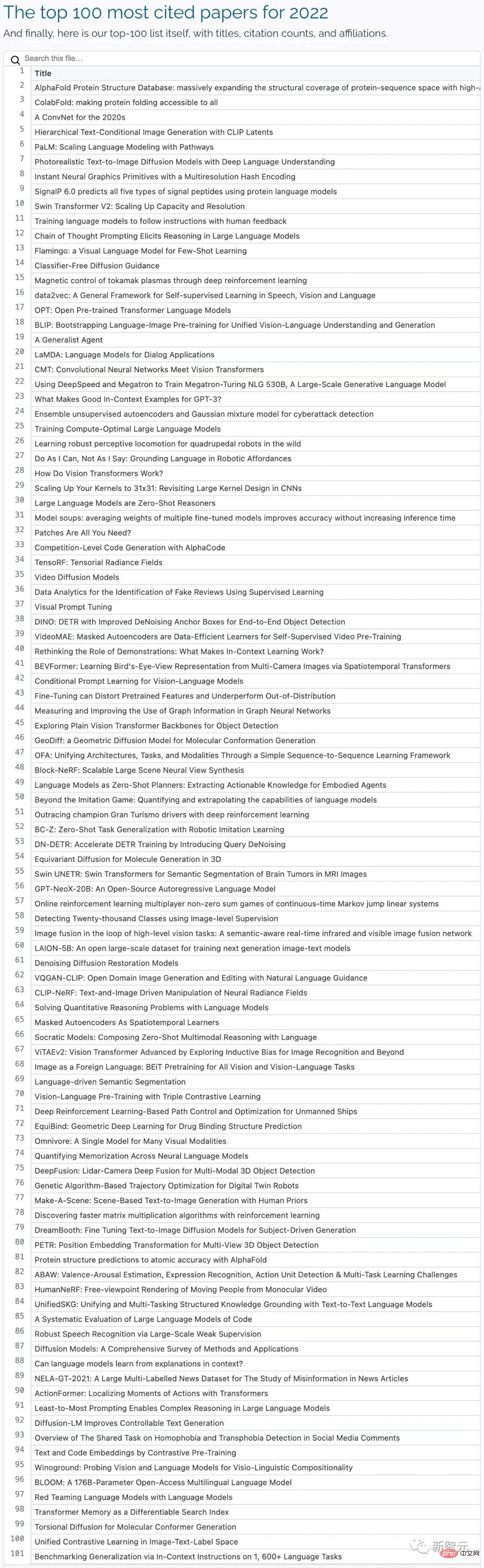

Récemment, les médias étrangers Zeta Alpha ont utilisé le classique nombre de citations comme indicateur d'évaluation, ont collecté et compilé les 100 articles les plus cités en 2022 et analysé les articles publiés par différents pays et institutions au cours des trois dernières années. années. Nombre d’articles très cités.

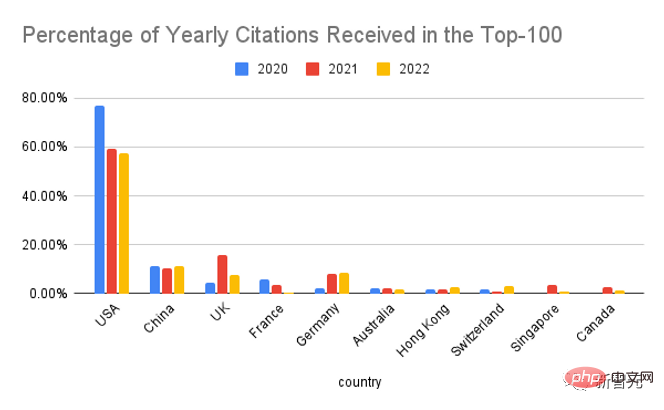

Les États-Unis sont toujours en tête, la Chine deuxièmeSi on les divise par pays, les États-Unis occupent toujours la première place, mais leur proportion dans le Top-100 des journaux a considérablement diminué par rapport à 2020.

La Chine arrive en deuxième position, avec des données légèrement supérieures à celles de l'année dernière ; le troisième est le Royaume-Uni, la production de DeepMind représentant 69 % du total du Royaume-Uni l'année dernière, dépassant 60 % les années précédentes ; L'influence dans le domaine de l'IA a également dépassé les attentes des analystes.

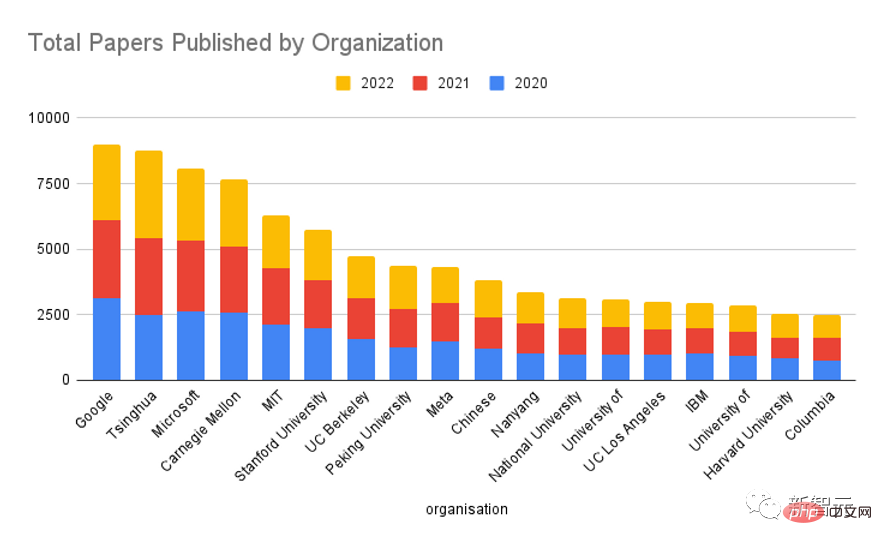

Si nous sommes divisés par organisation, nous pouvons voir que Google a toujours été l'acteur le plus puissant dans le domaine de l'IA, suivi de Meta, Microsoft, de l'Université de Californie, de Berkeley, de DeepMind et de l'Université de Stanford, qui se classe au premier rang du pays. Université.

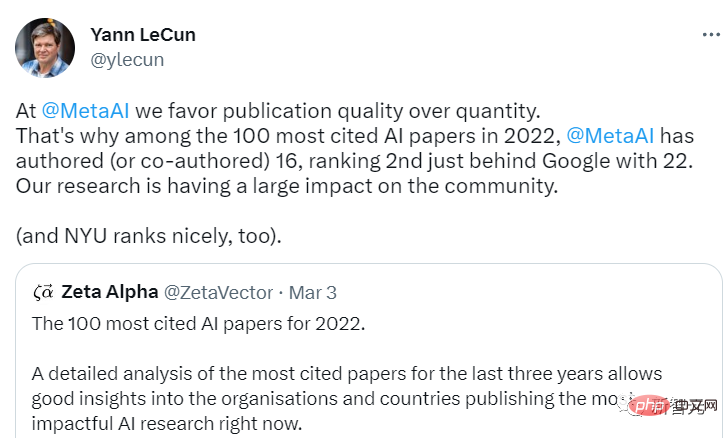

En tant que leader de Meta AI, Yann LeCun est également fier d'annoncer l'influence de Meta dans l'industrie et a déclaré que Meta AI accorde plus d'attention à la qualité de la publication plutôt qu'à la quantité de publication.

Quant à la question de Google et DeepMind, tous deux détenus par Alphabet, étant comptés séparément dans la liste, LeCun a déclaré que DeepMind a toujours insisté pour qu'ils fonctionnent indépendamment de Google, ce qui est étrange, et les employés de Google ne peuvent pas accéder à la bibliothèque de code de DeepMind.

Bien que la plupart des recherches actuelles sur l'intelligence artificielle soient menées par l'industrie et qu'un seul établissement universitaire ait peu d'impact, en raison de l'effet de longue traîne, le monde universitaire dans son ensemble est toujours à égalité avec l'industrie lorsque les données sont agrégées en fonction de l'organisation. types Quand , on peut voir que l'influence des deux est à peu près égale.

Si vous regardez les trois dernières années et comptez le nombre total de résultats de recherche de diverses institutions, vous pouvez voir que Google est toujours en tête, mais l'écart est beaucoup plus petit par rapport aux autres institutions. mentionnant que l'Université Tsinghua suit de près Google au deuxième rang.

OpenAI et DeepMind ne sont même pas dans le top 20. Bien sûr, le nombre d'articles publiés par ces institutions est plus faible, mais l'influence de chaque article est très élevée.

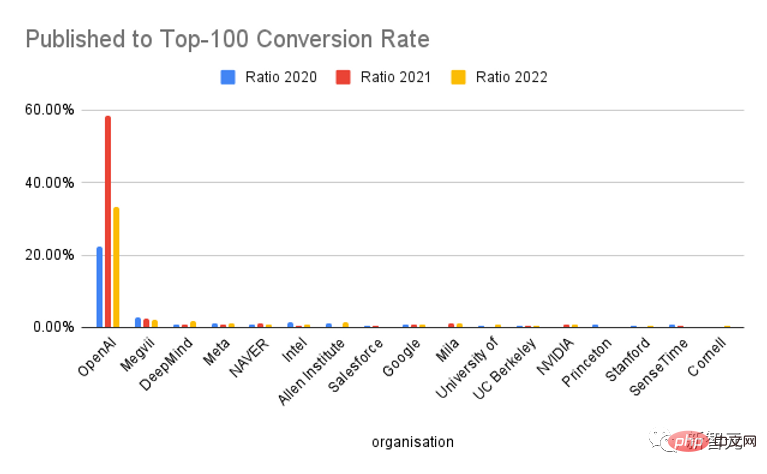

Si vous regardez la proportion de publications entrant dans le Top-100, OpenAI est unique et son taux de conversion dépasse de loin celui des autres institutions. En gros, l'un des deux journaux est devenu le "Top 100 Papers of the Year". .

Bien sûr, à en juger par la popularité de ChatGPT, OpenAI est en effet très doué en marketing, ce qui a favorisé dans une certaine mesure l'augmentation des citations. Il est indéniable que la qualité de leurs résultats de recherche est très élevée.

Méthode de collecte de papier

Collectez d'abord les articles les plus cités chaque année sur la plateforme Zeta Alpha, puis vérifiez manuellement la première date de publication (généralement une préimpression arXiv) Classés dans le correspondant année.

Complétez cette liste en extrayant des articles sur l'IA très cités sur Semantic Scholar, qui ont une couverture plus large et peuvent être triés par nombre de citations, principalement provenant d'éditeurs influents de sources fermées (tels que Nature, Elsevier, Springer et d'autres revues) pour des articles supplémentaires.

Ensuite, le nombre de citations de chaque article sur Google Scholar est utilisé comme indicateur représentatif, et les articles sont triés en fonction de ce nombre pour obtenir les 100 meilleurs articles en un an.

Pour ces articles, utilisez GPT-3 pour extraire les auteurs, leurs affiliations et leurs pays, et vérifiez manuellement ces résultats (si le pays n'est pas reflété dans la publication, le pays où le siège de l'organisation est utilisé).

Les articles avec des auteurs de plusieurs institutions comptent une fois pour chaque affiliation.

Les cinq meilleurs articles en 2022

1. Base de données sur la structure des protéines AlphaFold : étendre massivement la couverture structurelle de l'espace des séquences de protéines avec des modèles de haute précision

Lien de l'article : https://academic .oup.com/nar/article/50/D1/D439/6430488

Institution d'édition : Laboratoire européen de biologie moléculaire, DeepMind

AlphaFold DB : https://alphafold.ebi. uk

Nombre de citations : 1331

Base de données sur la structure des protéines AlphaFold AlphaFold DB est une base de données de prédiction de la structure des protéines, étendue et de haute précision, accessible au public.

Propulsée par AlphaFold v2.0 de DeepMind, cette base de données permet une expansion sans précédent de la couverture structurelle de l'espace des séquences protéiques connues.

AlphaFold DB fournit un accès programmatique et une visualisation interactive des coordonnées atomiques prédites, des estimations de confiance du modèle pour chaque résidu et paire, ainsi que des erreurs d'alignement prédites.

La version initiale d'AlphaFold DB contient plus de 360 000 structures prédites couvrant les protéomes de 21 organismes modèles, et sera étendue pour couvrir la plupart (plus de 100 millions) de séquences représentatives de l'ensemble de données UniRef90 à l'avenir.

2. ColabFold : rendre le repliement des protéines accessible à tous

Lien papier : https://www.nature.com/articles/s41592-022-01488-1.

Lien code : https://github.com/sokrypton/colabfold

Lien environnement : https://colabfold.mmseqs.com

Citations : 1138

ColabFold accélère la prédiction des structures et complexes protéiques en combinant la recherche rapide d'homologie de MMSEQS2 avec AlphaFold2 ou Rosettafold.

ColabFold peut accélérer la recherche et l'optimisation de l'utilisation des modèles de 40 à 60 fois, et peut prédire près de 1 000 structures sur un serveur avec une seule unité de traitement graphique.

ColabFold est une plateforme gratuite et accessible pour le repliement des protéines basée sur Google Colaboratory et est également un logiciel open source disponible.

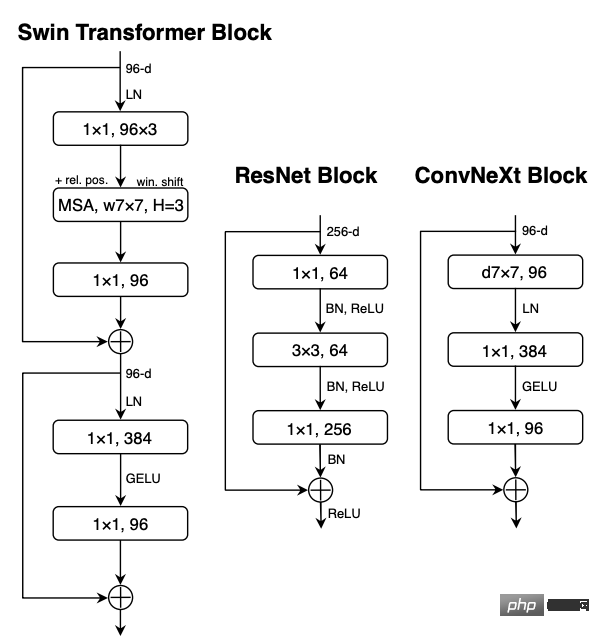

3. Un ConvNet pour les années 2020

Lien papier : https://arxiv.org/pdf/2201.03545.pdf

Citations : 835

Visuellement identifiable Le « Les années folles » ont commencé avec l’introduction des Visual Transformers (ViT), qui ont rapidement remplacé les ConvNets en tant que modèle de classification d’images le plus avancé.

D'un autre côté, un ViT le plus simple se heurte encore à certaines difficultés lorsqu'il est appliqué à des tâches générales de vision par ordinateur, telles que la détection d'objets et la segmentation sémantique.

Les transformateurs hiérarchiques (tels que les transformateurs Swin) réintroduisent plusieurs priorités ConvNet, rendant le transformateur réellement réalisable en tant qu'épine dorsale du modèle de vision générale et montrant des performances significatives dans diverses tâches de vision.

Cependant, l'efficacité de cette approche hybride reste principalement due aux avantages inhérents aux transformateurs plutôt qu'au biais inductif inhérent aux convolutions.

Dans ce travail, les chercheurs ont revisité l'espace de conception et testé les limites de ce que les ConvNets purs peuvent réaliser.

Progressivement "modernisé" un ResNet standard dans la conception de ViT et, ce faisant, a découvert plusieurs composants clés qui ont contribué à la différence de performances. Après l'exploration, un modèle ConvNet pur appelé ConvNeXt a été découvert en série.

ConvNeXt est entièrement composé de modules ConvNet standard et est à égalité avec Transformer en termes de précision et d'évolutivité, atteignant 87,8 % de précision ImageNet top 1 dans la détection COCO et la segmentation ADE20K, et surpassant les Swin Transformers, tout en conservant la simplicité et l'efficacité de ConvNets standards.

4. Génération d'images conditionnelles de texte hiérarchique avec CLIP Latents

Lien papier : https://arxiv.org/abs/2204.06125

Citations : 718

Il a été prouvé que les modèles contrastés comme CLIP apprennent des représentations d'images robustes qui capturent la sémantique et le style.

Pour exploiter ces représentations pour générer des images, les chercheurs proposent un modèle en deux étapes : un modèle a priori qui génère des intégrations d'images CLIP à partir d'une légende de texte, et un décodeur qui génère des images conditionnées par des intégrations d'images.

Des expériences ont prouvé que la génération explicite de représentations d'images peut améliorer la diversité des images avec une perte minimale de fidélité et de similarité des titres, et que les décodeurs conditionnés par les représentations d'images peuvent également produire des changements dans les images qui préservent leur sémantique et leur style, tout en modifiant les détails non essentiels qui ne sont pas présents dans la représentation de l’image.

De plus, l'espace d'intégration commun de CLIP permet d'effectuer des opérations d'image guidées par le langage de manière zéro.

Utilisez un modèle de diffusion pour le décodeur et expérimentez avec des modèles autorégressifs et de diffusion a priori, constatant que ces derniers sont plus efficaces sur le plan informatique et peuvent générer des échantillons de meilleure qualité.

5. PaLM : faire évoluer la modélisation du langage avec Pathways

Lien papier : https://arxiv.org/pdf/2204.02311.pdf

Citations : 426

Il a été démontré que les grands modèles de langage atteignent des performances plus élevées en utilisant un apprentissage en quelques étapes sur une variété de tâches en langage naturel, réduisant considérablement le nombre d'instances de formation spécifiques à une tâche requises pour adapter le modèle à une application spécifique.

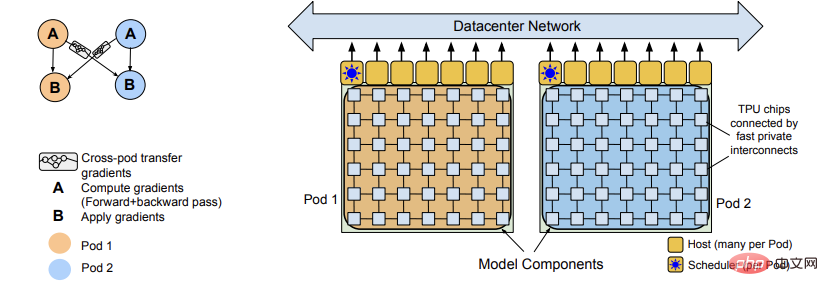

Afin de mieux comprendre l'impact de l'échelle sur l'apprentissage en quelques étapes, les chercheurs ont formé un modèle de langage Transformer de 540 milliards de paramètres, densément activé, Pathways Language Model (PaLM).

PaLM formé sur 6144 puces TPU v4 à l'aide de Pathways (un nouveau système ML capable d'effectuer une formation efficace sur plusieurs pods TPU), atteignant quelques centaines de tests de compréhension et de génération de langues à la pointe de la technologie - les résultats d'apprentissage par tir démontrent les avantages de mise à l'échelle.

Sur certaines de ces tâches, le PaLM 540B atteint des performances révolutionnaires, dépassant l'état de l'art en termes de réglage fin sur un ensemble de tâches d'inférence en plusieurs étapes et dépassant les performances humaines moyennes sur le benchmark BIG-bench récemment publié.

Un grand nombre de tâches BIG-bench montrent des améliorations discontinues de la taille du modèle, ce qui signifie également que lorsque l'échelle est étendue au plus grand modèle, les performances s'améliorent soudainement.

PaLM possède également de fortes capacités en matière de tâches multilingues et de génération de code source, qui ont également été prouvées dans une série de tests de référence.

De plus, les chercheurs effectuent une analyse complète des biais et de la toxicité et examinent dans quelle mesure les données d'entraînement peuvent être mémorisées par rapport à la taille du modèle. Enfin, les chercheurs discutent des considérations éthiques liées aux grands modèles de langage. Stratégies d'atténuation potentielles.

Top cinq des journaux nationaux en 2022

1 Swin Transformer V2 : augmentation de la capacité et de la résolution

.

Lien papier : https://arxiv.org/pdf/2111.09883.pdf

Lien code : https://github.com/microsoft/Swin-Transformer

Citations : 266

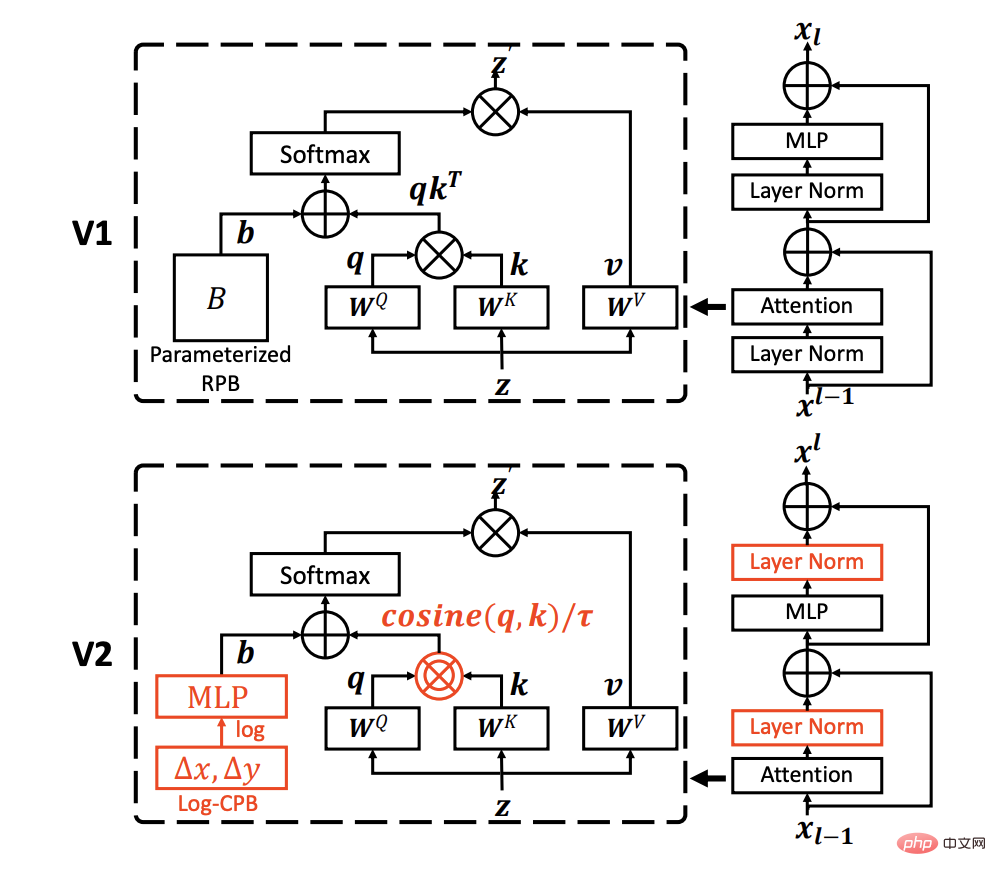

Il a été démontré que les modèles PNL à grande échelle améliorent considérablement les performances des tâches linguistiques sans signes de saturation, tout en démontrant d'étonnantes capacités en quelques étapes comme celles des humains.

Cet article vise à explorer les modèles à grande échelle en vision par ordinateur, en résolvant trois problèmes principaux dans la formation et l'application de modèles de vision à grande échelle, notamment l'instabilité de la formation, l'écart de résolution entre la pré-formation et le réglage fin, et la nécessité pour les données étiquetées.

Les chercheurs ont proposé trois techniques principales :

1) Une méthode de post-normalisation résiduelle combinée à une attention cosinusoïdale pour améliorer la stabilité de l'entraînement

2) Une méthode de biais de position continue espacée logarithmique pour efficacement ; transférer des modèles pré-entraînés avec des images basse résolution vers des tâches en aval avec une entrée haute résolution ;

3) Une méthode de pré-entraînement auto-supervisée SimMIM pour réduire le besoin de grandes exigences pour l'étiquetage des images ;

Grâce à ces techniques, un modèle Swin Transformer V2 de 3 milliards de paramètres a été entraîné avec succès, qui est le plus grand modèle de vision dense à ce jour, et lui a permis d'être entraîné avec des images jusqu'à une résolution de 1 536 × 1 536.

Établissez de nouveaux records de performances sur 4 tâches de vision représentatives, notamment la classification d'images ImageNet-V2, la détection d'objets COCO, la segmentation sémantique ADE20K et la classification d'actions vidéo Kinetics-400.

Dans le même temps, on peut noter que la formation est bien plus efficace que la formation au modèle de vision au niveau milliard de Google, consommant 40 fois moins de données étiquetées et de temps de formation.

2. Ensemble d'auto-encodeurs non supervisés et de modèle de mélange gaussien pour la détection des cyberattaques

Des recherches précédentes utilisaient l'apprentissage automatique non supervisé avec réduction de dimensionnalité pour la détection de réseau, qui se limitait à être robuste à la détection d'anomalies de grande dimension et clairsemées.

La plupart des méthodes supposent généralement que les paramètres de chaque domaine sont homogènes et ont une distribution gaussienne spécifique, ignorant le test de robustesse de l'asymétrie des données.

Lien article : https://www.sciencedirect.com/science/article/pii/S0306457321003162

Citations : 145

Cet article propose d'utiliser un modèle de mélange gaussien connecté à ( GMM) auto-encodeur d'ensemble non supervisé pour s'adapter à plusieurs domaines sans tenir compte de l'asymétrie de chaque domaine.

Dans l'espace latent de l'auto-encodeur intégré, la représentation latente basée sur l'attention et les caractéristiques de l'erreur minimale de la reconstruction sont utilisées, et l'algorithme de maximisation des attentes (EM) est utilisé pour estimer la densité d'échantillon dans le GMM When. la densité d'échantillon estimée dépasse Lorsque le seuil d'apprentissage est obtenu lors de la phase d'apprentissage, l'échantillon est identifié comme une valeur aberrante liée à l'anomalie.

Enfin, l'auto-encodeur intégré et le GMM sont optimisés conjointement pour convertir l'optimisation de la fonction objectif en un problème dual lagrangien. Des expériences menées sur trois ensembles de données publiques vérifient les performances du modèle proposé et de la base de détection d'anomalies sélectionnée. .

Les co-auteurs de l'article sont le professeur An Peng de l'Institut de technologie de Ningbo et Zhiyuan Wang de l'Université de Tongji.

Le professeur An Peng est actuellement vice-doyen de l'École d'ingénierie électronique et informatique de l'Institut de technologie de Ningbo. Il a étudié au Département d'ingénierie physique de l'Université Tsinghua de 2000 à 2009 et a obtenu un baccalauréat et un doctorat en ingénierie ; CERN, National Pardo, Italie Chercheur invité à l'Université de Warburg et à l'Université de Heidelberg en Allemagne, membre du Comité professionnel sur l'informatique et les systèmes cognitifs de la Société chinoise d'automatisation, membre du Comité professionnel sur les systèmes cognitifs et le traitement de l'information de la Société chinoise d'intelligence artificielle , et membre du Comité de travail des jeunes de la Société chinoise de commandement et de contrôle ; a présidé et participé à des projets nationaux clés du Plan de développement de la recherche fondamentale (Plan 973), de la Fondation nationale des sciences naturelles de Chine, du Programme national Spark et de nombreux autres projets de recherche scientifique.

3. Augmenter vos noyaux jusqu'à 31x31 : revisiter la conception des grands noyaux dans les CNN

Lien papier : https://arxiv.org/abs/2203.06717

Lien du code : https://github.com/megvii-research/RepLKNet

Citations : 127

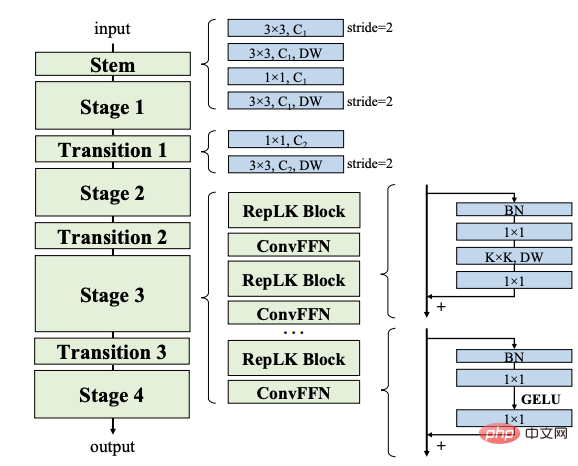

L'article passe en revue la conception de grands cœurs dans les réseaux de neurones convolutifs (CNN) modernes.

Inspiré par les progrès récents des transformateurs visuels (ViT), cet article démontre que l'utilisation de plusieurs gros noyaux convolutifs au lieu d'un groupe de petits noyaux peut être un paradigme plus puissant.

Les chercheurs ont proposé cinq lignes directrices, telles que l'application de convolutions reparamétrées à grande profondeur, pour concevoir des CNN à grand noyau efficaces et hautes performances.

Sur la base de ces directives, nous proposons RepLKNet, une architecture CNN pure avec une taille de noyau de 31x31, contrairement au 3x3 couramment utilisé, RepLKNet réduit considérablement l'écart de performances entre les CNN et les ViT, par exemple. ou mieux que Swin Transformer avec une latence plus faible sur ImageNet et certaines tâches typiques en aval.

RepLKNet montre également une bonne évolutivité pour le Big Data et les grands modèles, atteignant la précision la plus élevée de 87,8 % sur ImageNet, 56,0 % mIoU sur ADE20K et 56,0 % mIoU sur des technologies de pointe avec des tailles de modèles similaires. compétitif.

L'étude montre en outre que par rapport aux CNN à petit cœur, les CNN à grand cœur ont des champs de réception effectifs plus grands et un biais de forme plus élevé, plutôt qu'un biais de texture.

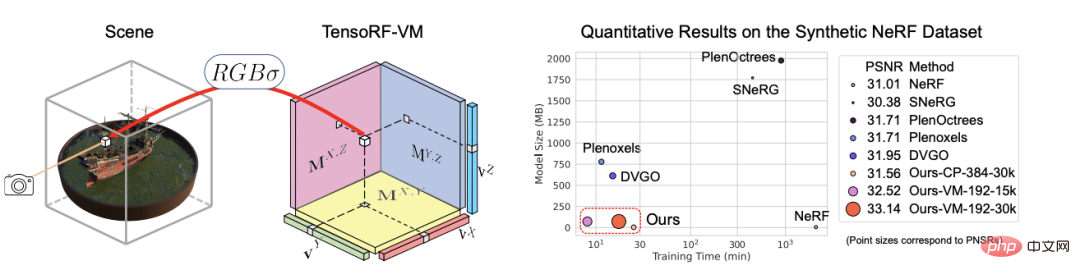

4. TensoRF : Champs de Radiance Tensoriels

Lien papier : https://arxiv.org/abs/2203.09517

Citations : 110

TensoRF est proposé dans l'article , Une nouvelle façon de modéliser et de reconstruire les champs de rayonnement.

Contrairement à NeRF, qui utilise uniquement le MLP, les chercheurs modélisent le champ de rayonnement de la scène comme un tenseur 4D, représentant une grille de voxels tridimensionnelle avec des caractéristiques multicanaux par voxel, l'idée centrale est de décomposer la scène 4D. tenseur en plusieurs composants tenseurs compacts de bas rang.

Il est prouvé qu'en appliquant la décomposition CP traditionnelle dans ce cadre, la décomposition du tenseur en composants de rang un avec des vecteurs compacts entraîne de meilleures performances que le NeRF ordinaire.

Pour améliorer encore les performances, l'article introduit également une nouvelle décomposition vecteur-matrice (VM), qui assouplit les contraintes de bas rang des deux modes de tenseurs et décompose les tenseurs en vecteurs compacts et facteurs matriciels. .

En plus d'une meilleure qualité de rendu, les travaux antérieurs et simultanés sur l'optimisation directe des fonctionnalités par pixel ont abouti à une empreinte mémoire importante pour ce modèle par rapport à la décomposition CP et VM.

Des expériences ont prouvé que TensoRF avec décomposition CP permet une reconstruction rapide (

De plus, TensoRF avec décomposition de VM améliore encore la qualité du rendu et dépasse les méthodes de pointe précédentes, tout en réduisant le temps de reconstruction (

5. VideoMAE : les auto-encodeurs masqués sont des apprenants efficaces en matière de données pour une pré-formation vidéo auto-supervisée

Lien papier : https://arxiv.org/abs/2203.1. 2 602

Lien de code : https://github.com/MCG-NJU/VideoMAE

Citations : 100

Afin d'obtenir des performances plus élevées sur des ensembles de données relativement petits, qui sont généralement nécessite une pré-formation du transformateur vidéo sur des ensembles de données supplémentaires à grande échelle.

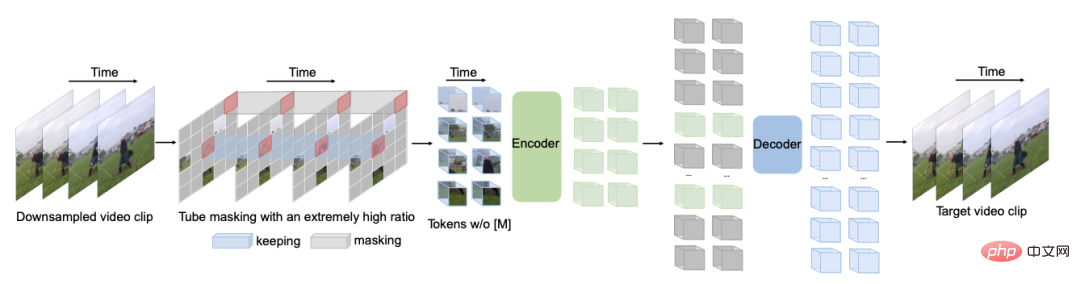

Cet article montre que le Video Masked Autoencoder (VideoMAE) est un apprenant économe en données pour la pré-formation vidéo auto-supervisée (SSVP).

Inspirés par le récent ImageMAE, les chercheurs proposent un tube vidéo personnalisé avec un rapport de masque extrêmement élevé. Cette conception simple fait de la reconstruction vidéo une tâche auto-supervisée plus difficile, encourageant ainsi l'extraction de représentations vidéo plus efficaces au cours de ce processus de pré-formation.

Trois résultats importants ont été obtenus sur SSVP :

(1) Une proportion extrêmement élevée de taux de masquage (c'est-à-dire 90 % à 95 %) peut toujours produire des performances favorables de VideoMAE. Le contenu vidéo temporairement redondant entraîne des taux de masquage plus élevés que les images.

(2) VideoMAE atteint de très hautes performances sur de très petits ensembles de données (c'est-à-dire environ 3 000 à 4 000 vidéos) sans utiliser de données supplémentaires.

(3) VideoMAE montre que pour la SSVP, la qualité des données est plus importante que la quantité des données.

Le transfert de domaine entre la pré-formation et les ensembles de données cibles est un enjeu important.

Il convient de noter que VideoMAE avec ViT ordinaire peut atteindre 87,4 % sur Kinetics-400, 75,4 % sur Something-Something V2, 91,3 % sur UCF101 et 62,6 % sur HMDB51 sans utiliser de données supplémentaires.

Liste complète des 100 meilleurs articles

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI