Maison >Périphériques technologiques >IA >Combattez le problème de « l'élégance conceptuelle » ! Google publie un nouveau cadre de perception du temps : la précision de la reconnaissance d'image a augmenté de 15 %

Combattez le problème de « l'élégance conceptuelle » ! Google publie un nouveau cadre de perception du temps : la précision de la reconnaissance d'image a augmenté de 15 %

- 王林avant

- 2024-03-02 12:04:02728parcourir

Dans la recherche sur l'apprentissage automatique, la dérive des concepts a toujours été un problème épineux. Il fait référence aux changements dans la distribution des données au fil du temps, ce qui affecte l'efficacité du modèle. Cette situation oblige les chercheurs à ajuster constamment leurs modèles pour s'adapter aux nouvelles distributions de données. La clé pour résoudre le problème de la dérive des concepts est de développer des algorithmes capables de détecter et de s'adapter aux changements de données en temps opportun.

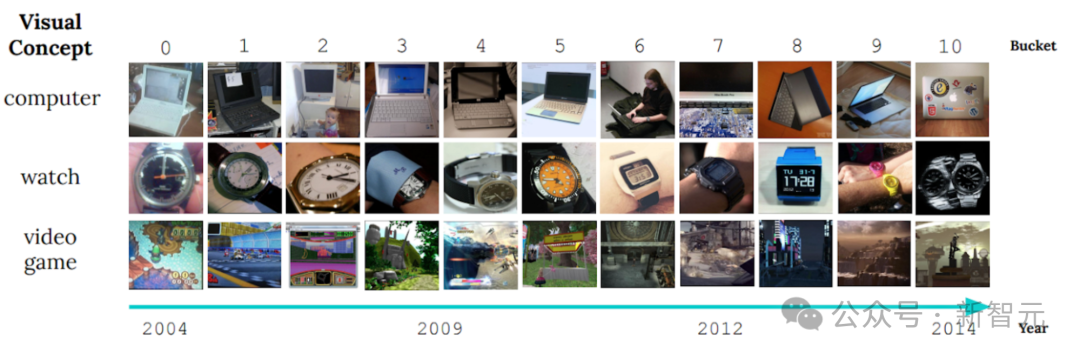

Un exemple évident est l'affichage d'images du benchmark d'apprentissage non stationnaire CLEAR, qui révèle le problème. changements importants dans les caractéristiques visuelles des objets au cours de la dernière décennie.

Ce phénomène est appelé « dérive lente des concepts » et pose un défi de taille aux modèles de classification d'objets. À mesure que l'apparence ou les attributs des objets changent au fil du temps, la recherche se concentre sur la façon de garantir que le modèle peut s'adapter à ce changement et continuer à classer avec précision.

Récemment, face à ce défi, l'équipe de recherche de Google AI a proposé une méthode basée sur l'optimisation appelée MUSCATEL (Multi-Scale Temporal Learning), qui a réussi à améliorer le modèle dans des performances axées sur des données énormes et changeantes. Ce résultat de recherche a été publié à AAAI2024.

Adresse papier : https://arxiv.org/abs/2212.05908

À l'heure actuelle, les méthodes principales de dérive des probabilités sont l'apprentissage en ligne et l'apprentissage continu (apprentissage en ligne et continu).

Le concept principal de ces méthodes est de mettre à jour en permanence le modèle pour s'adapter aux dernières données afin de garantir l'efficacité du modèle. Cependant, cette approche se heurte à deux défis principaux.

Ces méthodes se concentrent souvent uniquement sur les données les plus récentes, ignorant les informations précieuses contenues dans les données passées. De plus, ils supposent que la contribution de toutes les instances de données décroît uniformément avec le temps, ce qui n’est pas cohérent avec la réalité. La méthode

MUSCATEL peut résoudre efficacement ces problèmes. Elle attribue des scores d'importance aux instances de formation et optimise les performances du modèle dans les instances futures.

À cette fin, les chercheurs ont introduit un modèle auxiliaire qui combine les instances et leurs âges pour générer des scores. Le modèle auxiliaire et le modèle principal apprennent en collaboration pour résoudre deux problèmes fondamentaux.

Cette méthode présente d'excellentes performances dans les applications pratiques. Dans une expérience sur un ensemble de données réelles à grande échelle couvrant 39 millions de photos et d'une durée de 9 ans, par rapport à d'autres méthodes de base d'apprentissage en régime permanent, la précision a augmenté de 15 %. .

En même temps, elle montre également de meilleurs résultats que la méthode SOTA dans deux ensembles de données d'apprentissage non stationnaires et des environnements d'apprentissage continu.

Le défi de la dérive des concepts vers l'apprentissage supervisé

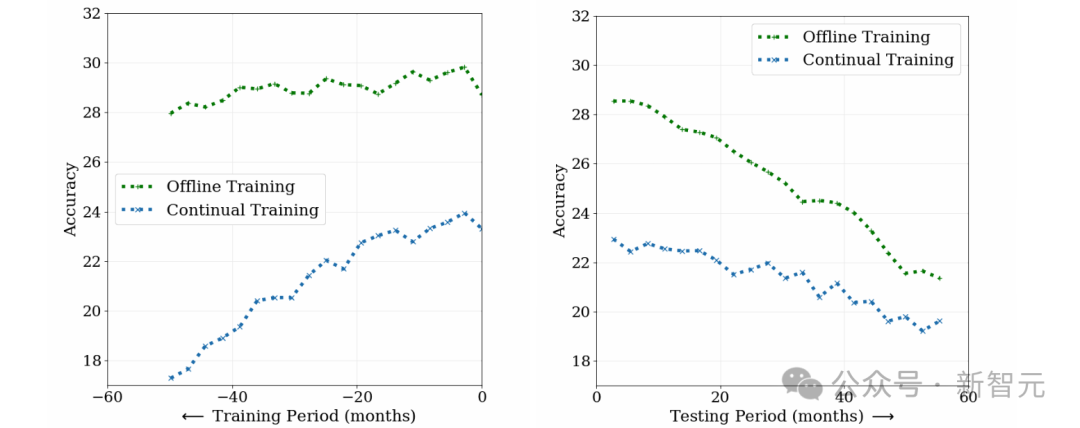

Afin d'étudier le défi de la dérive des concepts vers l'apprentissage supervisé, les chercheurs ont comparé la formation hors ligne (formation hors ligne) et la formation continue (formation continue) dans la tâche de classification de photos. méthode utilisant environ 39 millions de photos de réseaux sociaux sur une période de 10 ans.

Comme le montre la figure ci-dessous, bien que les performances initiales du modèle de formation hors ligne soient élevées, la précision diminue avec le temps et la compréhension des premières données est réduite en raison d'un oubli catastrophique.

Au contraire, bien que les performances initiales du modèle de formation continue soient moindres, il est moins dépendant des anciennes données et se dégrade plus rapidement lors des tests.

Cela montre que les données évoluent avec le temps et que l'applicabilité des deux modèles diminue. La dérive conceptuelle pose un défi à l'apprentissage supervisé, qui nécessite une mise à jour continue du modèle pour s'adapter aux changements de données.

MUSCATEL

MUSCATEL est une approche innovante conçue pour résoudre le problème de la lente dérive des concepts. Il vise à réduire la dégradation des performances du modèle à l'avenir en combinant intelligemment les avantages de l'apprentissage hors ligne et de l'apprentissage continu.

Face à d'énormes données d'entraînement, MUSCATEL montre son charme unique. Il s'appuie non seulement sur l'apprentissage hors ligne traditionnel, mais régule et optimise également soigneusement l'impact des données passées sur cette base, jetant ainsi une base solide pour les performances futures du modèle.

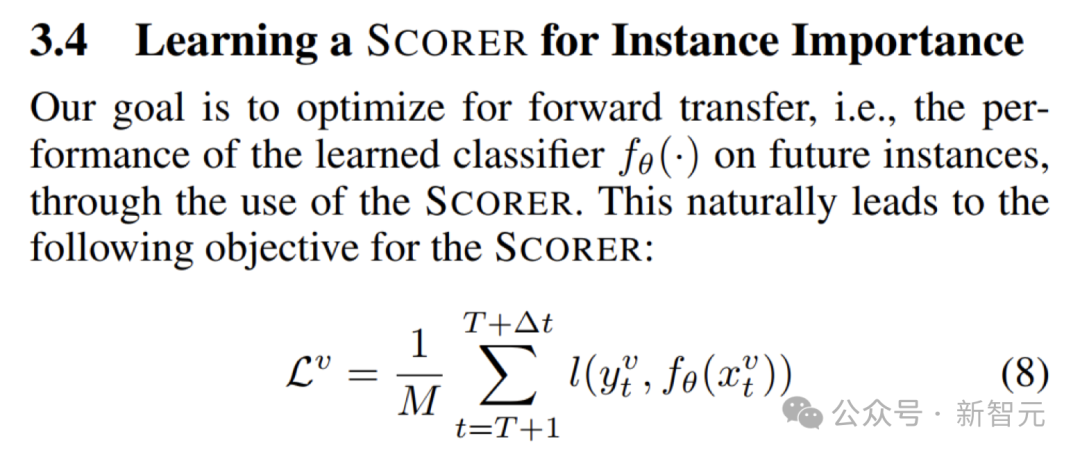

Afin d'améliorer encore les performances du modèle principal sur les nouvelles données, MUSCATEL introduit un modèle auxiliaire.

Sur la base des objectifs d'optimisation de la figure ci-dessous, le modèle auxiliaire de formation attribue des pondérations à chaque point de données en fonction de son contenu et de son âge. Cette conception permet au modèle de mieux s'adapter aux changements dans les données futures et de maintenir des capacités d'apprentissage continu.

Afin de co-évoluer le modèle auxiliaire et le modèle principal, MUSCATEL adopte également une stratégie de méta-apprentissage.

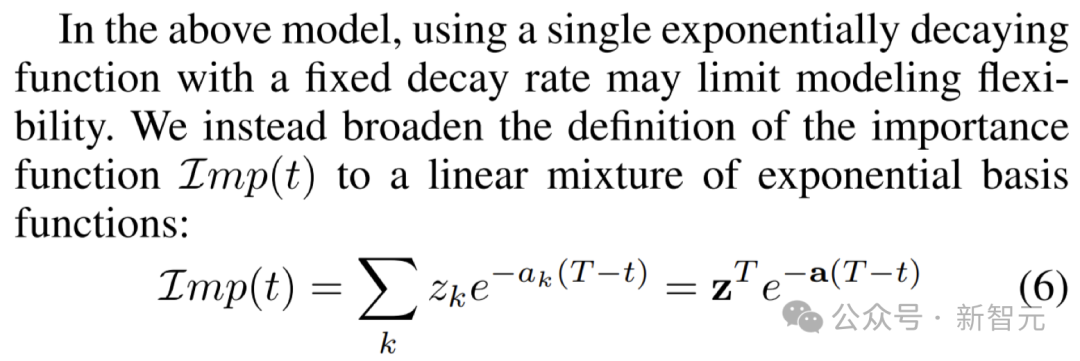

La clé de cette stratégie est de séparer efficacement la contribution des instances d'échantillon et de l'âge, et de définir les poids en combinant plusieurs échelles de temps de décroissance fixes, comme le montre la figure ci-dessous.

De plus, MUSCATEL apprend à « répartir » chaque instance à l'échelle de temps la plus appropriée pour un apprentissage plus précis.

Score de poids d'instance

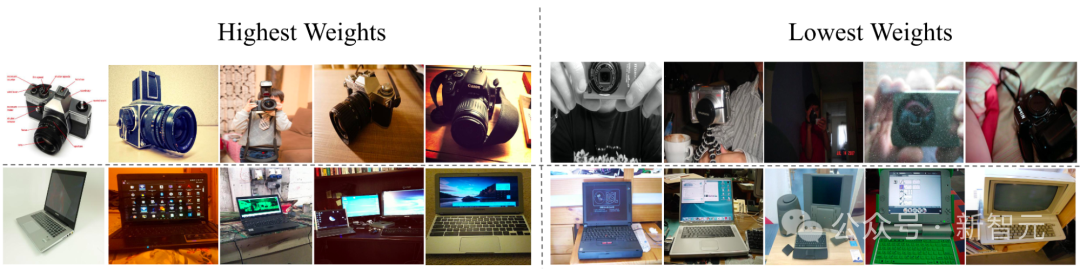

Comme le montre la figure ci-dessous, dans le défi de reconnaissance d'objet CLEAR, le modèle auxiliaire appris a ajusté avec succès le poids des objets : le poids des objets avec une nouvelle apparence a augmenté et le poids des objets avec une apparence ancienne diminuée.

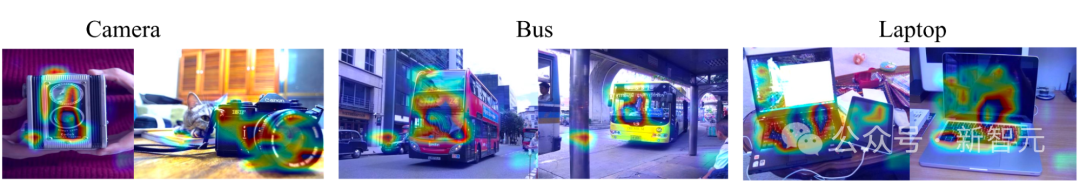

Grâce à l'évaluation de l'importance des caractéristiques basée sur le gradient, on peut constater que le modèle auxiliaire se concentre sur le sujet dans l'image, plutôt que sur l'arrière-plan ou les caractéristiques indépendantes de l'âge de l'instance, démontrant ainsi son efficacité.

Une avancée significative dans la tâche de classification de photos à grande échelle

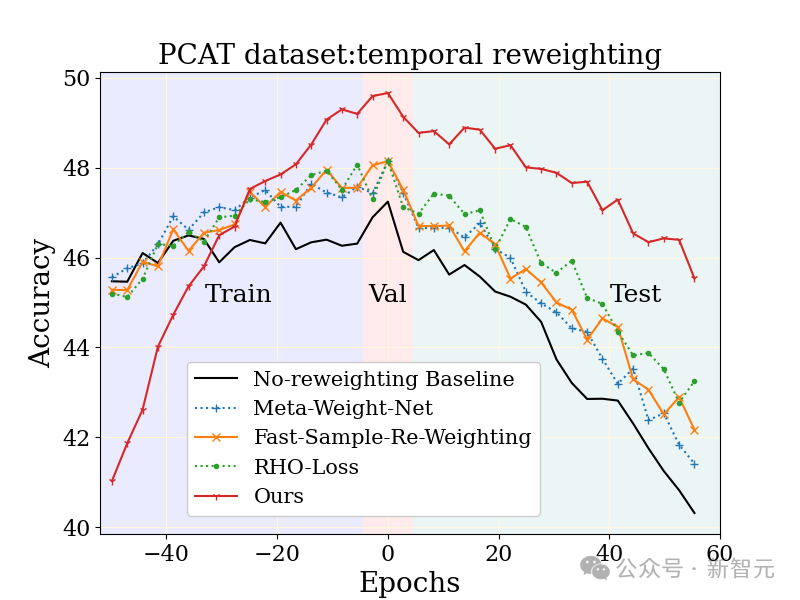

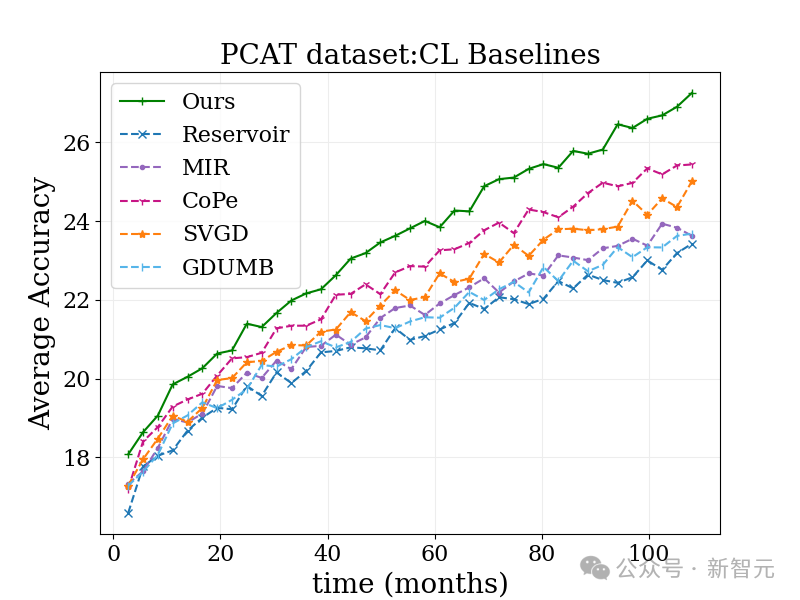

La tâche de classification de photos à grande échelle (PCAT) a été étudiée sur l'ensemble de données YFCC100M, en utilisant les données des cinq premières années comme base ensemble de formation et les données des cinq dernières années comme ensemble de test.

Par rapport aux bases de référence non pondérées et à d'autres techniques d'apprentissage robustes, la méthode MUSCATEL présente des avantages évidents.

Il est à noter que la méthode MUSCATEL ajuste consciemment l'exactitude des données d'un passé lointain en échange d'une amélioration significative des performances lors des tests. Cette stratégie optimise non seulement la capacité du modèle à s'adapter aux données futures, mais montre également une moindre dégradation lors des tests.

Large utilisation vérifiée sur tous les ensembles de données

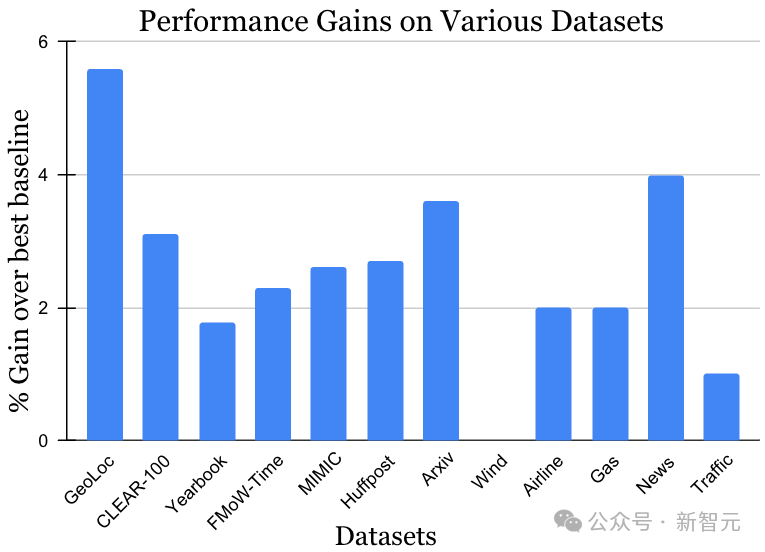

L'ensemble de données pour le défi d'apprentissage non stationnaire couvre une variété de sources et de modalités de données, notamment des photos, des images satellite, des textes sur les réseaux sociaux, des dossiers médicaux, des lectures de capteurs et des données tabulaires. , la taille des données varie également de 10 000 à 39 millions d'instances. Il convient de noter que la meilleure méthode précédente peut être différente pour chaque ensemble de données. Cependant, comme le montre la figure ci-dessous, dans le contexte de la diversité des données et des méthodes, la méthode MUSCATEL a montré des effets de gain significatifs. Ce résultat démontre pleinement la large applicabilité de MUSCATEL.

Développez les algorithmes d'apprentissage continu pour faire face aux défis de traitement de données à grande échelle

Face à des montagnes de données à grande échelle, les méthodes d'apprentissage hors ligne traditionnelles peuvent sembler inadéquates.

Avec cette problématique en tête, l’équipe de recherche a intelligemment adapté une méthode inspirée de l’apprentissage continu pour s’adapter facilement au traitement de données à grande échelle.

Cette méthode est très simple, c'est-à-dire ajouter un poids temporel à chaque lot de données, puis mettre à jour le modèle séquentiellement.

Bien qu'il existe encore quelques petites limitations, telles que le fait que les mises à jour du modèle ne peuvent être basées que sur les dernières données, l'effet est étonnamment bon !

Dans le test de classification de photos ci-dessous, cette méthode a mieux fonctionné que l'algorithme d'apprentissage continu traditionnel et divers autres algorithmes.

De plus, comme son idée s'accorde bien avec de nombreuses méthodes existantes, on s'attend à ce que lorsqu'elle est combinée avec d'autres méthodes, l'effet soit encore plus étonnant !

De manière générale, l'équipe de recherche a combiné avec succès l'apprentissage hors ligne et continu pour résoudre le problème de dérive des données qui tourmente depuis longtemps l'industrie.

Cette stratégie innovante atténue non seulement considérablement le phénomène « d'oubli de catastrophe » du modèle, mais ouvre également une nouvelle voie pour le développement futur de l'apprentissage continu de données à grande échelle, injectant une nouvelle vitalité dans l'ensemble du domaine de l'apprentissage automatique. .

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!