Maison >Périphériques technologiques >IA >Comprendre en un seul article : les liens et les différences entre l'IA, le machine learning et le deep learning

Comprendre en un seul article : les liens et les différences entre l'IA, le machine learning et le deep learning

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2024-03-02 11:19:301584parcourir

Dans la vague actuelle de changements technologiques rapides, l’intelligence artificielle (IA), l’apprentissage automatique (ML) et l’apprentissage profond (DL) sont comme des étoiles brillantes, à la tête de la nouvelle vague des technologies de l’information. Ces trois mots apparaissent fréquemment dans diverses discussions de pointe et applications pratiques, mais pour de nombreux explorateurs novices dans ce domaine, leurs significations spécifiques et leurs connexions internes peuvent encore être entourées de mystère.

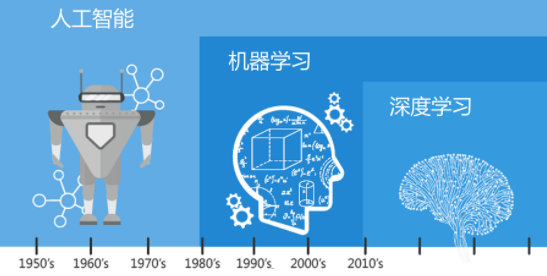

Alors jetons d’abord un coup d’œil à cette photo.

On peut constater qu'il existe une corrélation étroite et une relation progressive entre l'apprentissage profond, l'apprentissage automatique et l'intelligence artificielle. L’apprentissage profond est un domaine spécifique de l’apprentissage automatique, qui constitue une composante importante de l’intelligence artificielle. Les connexions et la promotion mutuelle entre ces domaines permettent le développement et l’amélioration continus de la technologie de l’intelligence artificielle.

Qu'est-ce que l'intelligence artificielle ?

L'intelligence artificielle (IA) est un concept vaste dont l'objectif principal est de développer des systèmes informatiques capables de simuler, d'étendre, voire de surpasser l'intelligence humaine. Elle a des applications spécifiques dans de nombreux domaines, tels que :

- La reconnaissance d'images (Reconnaissance d'images) est une branche importante de l'IA, dédiée à l'étude de la manière de permettre aux ordinateurs d'obtenir des données via des capteurs visuels et d'analyser sur la base de ces données pour identifier des images. dans les images. Les objets, scènes, comportements et autres informations simulent le processus de reconnaissance et de compréhension des signaux visuels par l’œil et le cerveau humains.

- Le traitement du langage naturel (NLP) est la capacité des ordinateurs à comprendre et à générer le langage naturel humain. Il couvre une variété de tâches telles que la classification de textes, l'analyse sémantique, la traduction automatique, etc., et s'efforce de simuler les compétences humaines en matière d'écoute, parler, lire et écrire, etc. comportement intelligent.

- Computer Vision (CV) inclut la reconnaissance d'images dans un sens plus large. Elle implique également de nombreux aspects tels que l'analyse d'images, l'analyse vidéo et la reconstruction tridimensionnelle. Elle vise à permettre aux ordinateurs de « voir » et de reconnaître des images en deux dimensions. ou des images tridimensionnelles. Comprendre le monde est une profonde imitation du système visuel humain.

- Knowledge Graph (KG) est un modèle de données structuré utilisé pour stocker et représenter des entités et leurs relations complexes les unes avec les autres. Il simule la capacité humaine à accumuler et à utiliser des connaissances dans le processus cognitif, ainsi que le processus de raisonnement et d'apprentissage. sur les connaissances existantes.

Ces technologies haut de gamme sont recherchées et appliquées autour du concept principal de « simulation de l'intelligence humaine ». Ils se concentrent sur le développement de différentes dimensions de perception (telles que la vision, l'audition, la logique de la pensée, etc.) et promeuvent conjointement le développement et les progrès continus de la technologie de l'intelligence artificielle.

Qu’est-ce que l’apprentissage automatique ?

Le Machine Learning (ML) est une branche cruciale dans le domaine de l'intelligence artificielle (IA). Il utilise divers algorithmes pour permettre aux systèmes informatiques d'apprendre automatiquement des règles et des modèles à partir des données afin de faire des prédictions et des décisions, améliorant et élargissant ainsi les capacités de l'intelligence humaine.

Par exemple, lors de la formation d'un modèle de reconnaissance de chat, le processus d'apprentissage automatique est le suivant :

- Prétraitement des données : tout d'abord, prétraitez un grand nombre d'images de chat et de non-chat collectées, y compris la mise à l'échelle, les niveaux de gris, la normalisation et d'autres opérations. sont effectuées et l'image est convertie en une représentation vectorielle de caractéristiques. Ces caractéristiques peuvent provenir de techniques d'extraction de caractéristiques conçues manuellement, telles que des caractéristiques de type Haar, des modèles binaires locaux (LBP) ou d'autres descripteurs de caractéristiques couramment utilisés dans le domaine de la vision par ordinateur. .

- Sélection des fonctionnalités et réduction de la dimensionnalité : sélectionnez les fonctionnalités clés en fonction des caractéristiques du problème, supprimez les informations redondantes et non pertinentes et utilisez parfois PCA, LDA et d'autres méthodes de réduction de dimensionnalité pour réduire davantage les dimensions des fonctionnalités et améliorer l'efficacité de l'algorithme.

- Formation du modèle : utilisez ensuite l'ensemble de données étiquetées prétraitées pour entraîner le modèle d'apprentissage automatique sélectionné et optimisez les performances du modèle en ajustant les paramètres du modèle afin que le modèle puisse distinguer les chats des non-chats en fonction des caractéristiques de l'image.

- Évaluation et validation du modèle : une fois la formation terminée, le modèle est évalué à l'aide d'un ensemble de tests indépendant pour garantir que le modèle a une bonne capacité de généralisation et peut être appliqué avec précision à de nouveaux échantillons invisibles.

Les 10 principaux algorithmes d'apprentissage automatique couramment utilisés sont : l'arbre de décision, la forêt aléatoire, la régression logistique, SVM, Naive Bayes, l'algorithme K le plus proche voisin, l'algorithme K-means, l'algorithme Adaboost, le réseau neuronal, Markov, etc.

Qu’est-ce que l’apprentissage profond ?

Le Deep Learning (DL) est une forme spéciale d'apprentissage automatique. Il simule la façon dont le cerveau humain traite les informations via une structure de réseau neuronal profond, extrayant ainsi automatiquement des représentations de caractéristiques complexes à partir des données.

Par exemple, lors de la formation d'un modèle de reconnaissance de chat, le processus d'apprentissage en profondeur est le suivant :

(1) Prétraitement et préparation des données :

- Collectez un grand nombre d'ensembles de données contenant des images de chats et de non-chats, et effectuez Nettoyez et étiquetez, en vous assurant que chaque image porte une étiquette correspondante (telle que « chat » ou « pas de chat »).

- Prétraitement des images : ajustez toutes les images à une taille uniforme, effectuez un traitement de normalisation, une amélioration des données et d'autres opérations.

(2) Conception et construction du modèle :

- Choisissez une architecture d'apprentissage en profondeur. Pour les tâches de reconnaissance d'images, le réseau neuronal convolutif (CNN) est généralement utilisé. CNN peut extraire efficacement les caractéristiques locales des images et les résumer via des structures multicouches.

- Créez des couches de modèle, y compris des couches convolutives (pour l'extraction de fonctionnalités), des couches de pooling (pour réduire les calculs et éviter le surajustement), des couches entièrement connectées (pour intégrer et classer les fonctionnalités) et d'éventuelles couches de normalisation par lots, une fonction d'activation (telle que ReLU, sigmoïde, etc.).

(3) Paramètres d'initialisation et définition des hyperparamètres :

- Initialisez les poids et les biais de chaque couche du modèle, et vous pouvez utiliser une initialisation aléatoire ou une stratégie d'initialisation spécifique.

- Définissez des hyperparamètres tels que le taux d'apprentissage, l'optimiseur (tel que SGD, Adam, etc.), la taille du lot, la période de formation (époque), etc.

(4) Propagation avant :

- Introduisez l'image prétraitée dans le modèle, et grâce à la convolution, au regroupement, à la transformation linéaire et à d'autres opérations de chaque couche, la distribution de probabilité prédite de la couche de sortie est finalement obtenue, qui c'est-à-dire que le modèle détermine la probabilité que l'image d'entrée soit un chat.

(5) Fonction de perte et rétropropagation :

- Utilisez la fonction de perte d'entropie croisée ou une autre fonction de perte appropriée pour mesurer la différence entre les résultats de la prédiction du modèle et la véritable étiquette.

- Après avoir calculé la perte, exécutez l'algorithme de rétropropagation pour calculer le gradient de la perte par rapport aux paramètres du modèle afin de mettre à jour les paramètres.

(6) Optimisation et mise à jour des paramètres :

- Utilisez la descente de gradient ou d'autres algorithmes d'optimisation pour ajuster les paramètres du modèle en fonction des informations de gradient, dans le but de minimiser la fonction de perte.

- Au cours de chaque itération d'entraînement, le modèle continuera à apprendre et à ajuster les paramètres, améliorant progressivement sa capacité à reconnaître les images de chats.

(7) Vérification et évaluation :

- Évaluez régulièrement les performances du modèle sur l'ensemble de vérification, surveillez les changements d'exactitude, de précision, de rappel et d'autres indicateurs pour guider l'ajustement des hyperparamètres et l'apprentissage précoce pendant la formation du modèle.

(8) Achèvement de la formation et tests :

- Lorsque les performances du modèle sur l'ensemble de validation deviennent stables ou atteignent les conditions d'arrêt prédéfinies, arrêtez la formation.

- Enfin, évaluez la capacité de généralisation du modèle sur un ensemble de tests indépendant pour vous assurer que le modèle peut identifier efficacement les chats sur de nouveaux échantillons invisibles.

La différence entre l'apprentissage profond et l'apprentissage automatique

La différence entre l'apprentissage profond et l'apprentissage automatique est la suivante :

1 Méthode de résolution du problème

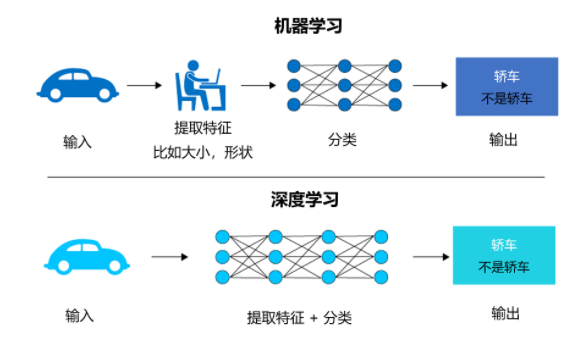

Les algorithmes d'apprentissage automatique reposent généralement sur une ingénierie de fonctionnalités conçue par l'homme, c'est-à-dire pré. -extraction basée sur la connaissance de base du problème Fonctionnalités clés, puis création d'un modèle basé sur ces fonctionnalités et exécution de solutions d'optimisation.

Le Deep Learning adopte une méthode d'apprentissage de bout en bout, générant automatiquement des fonctionnalités abstraites de haut niveau grâce à une transformation non linéaire multicouche, et ces fonctionnalités sont continuellement optimisées pendant tout le processus de formation. Il n'est pas nécessaire de les sélectionner et de les sélectionner manuellement. construire des caractéristiques plus proches du style de traitement cognitif du cerveau.

Par exemple, si vous souhaitez écrire un logiciel pour reconnaître une voiture, si vous utilisez l'apprentissage automatique, vous devez extraire manuellement les caractéristiques de la voiture, telles que la taille et la forme et si vous utilisez l'apprentissage profond, alors l'intelligence artificielle ; neuronal Le réseau extrait ces fonctionnalités lui-même, mais il nécessite un grand nombre d'images étiquetées comme des voitures pour les apprendre.

2. Scénarios d'application

L'application de l'apprentissage automatique dans la reconnaissance d'empreintes digitales, la détection d'objets caractéristiques et d'autres domaines a fondamentalement atteint les exigences de commercialisation.

Le deep learning est principalement utilisé dans la reconnaissance de texte, la technologie faciale, l'analyse sémantique, la surveillance intelligente et d'autres domaines. À l'heure actuelle, il se déploie également rapidement dans les secteurs du matériel intelligent, de l'éducation, de la médecine et autres.

3. Quantité de données requise

Les algorithmes d'apprentissage automatique peuvent également montrer de bonnes performances dans de petits exemples de cas. Pour certaines tâches simples ou problèmes où les fonctionnalités sont faciles à extraire, moins de données peuvent obtenir des résultats satisfaisants.

L'apprentissage profond nécessite généralement une grande quantité de données annotées pour former des réseaux de neurones profonds. Son avantage est qu'il peut apprendre directement des modèles et des représentations complexes à partir des données d'origine, en particulier lorsque la taille des données augmente, ce qui améliore les performances du modèle d'apprentissage profond. est plus significatif.

4. Temps d'exécution

Pendant la phase de formation, en raison du plus grand nombre de couches de modèles d'apprentissage profond et du grand nombre de paramètres, le processus de formation prend souvent du temps et nécessite le support de ressources informatiques hautes performances, telles que Clusters GPU.

En comparaison, les algorithmes d'apprentissage automatique (en particulier les modèles légers) nécessitent généralement moins de temps de formation et de ressources informatiques, et sont plus adaptés à une itération rapide et à une vérification expérimentale.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Que devez-vous apprendre sur l'intelligence artificielle Python ?

- Quelle est la forme d'intelligence artificielle la plus avancée du futur ?

- La future tendance de l'intelligence artificielle

- Geoffrey Hinton, lauréat du prix Turing : Mes cinquante années de carrière en apprentissage profond et mes méthodes de recherche

- Le deep learning présente un nouveau piège ! L'Université de Sydney propose une nouvelle tâche multimodale, utilisant du texte pour guider la découpe d'image