Maison >Périphériques technologiques >IA >Les performances des paramètres 2B dépassent celles de Mistral-7B : modèle open source multimodal intelligent d'extrémité côté mur

Les performances des paramètres 2B dépassent celles de Mistral-7B : modèle open source multimodal intelligent d'extrémité côté mur

- 王林avant

- 2024-02-02 19:33:321346parcourir

Qianyuan Machine peut également être exécutée localement.

Récemment, les gens ont obtenu des résultats en matière d'optimisation et de déploiement, avec l'évolution des grands modèles vers les gros volumes.

Le 1er février, Wall-Facing Intelligence et le laboratoire Tsinghua NLP ont officiellement lancé le modèle phare à grande échelle de bout en bout « Wall-Facing MiniCPM » à Pékin. Cette nouvelle génération de grands modèles est connue sous le nom de « petit canon en acier performant ». Elle peut non seulement être déployée directement sur le terminal, mais possède également les capacités multimodales les plus puissantes au même niveau. Cela offrira aux utilisateurs une expérience d’application intelligente plus rapide et plus efficace.

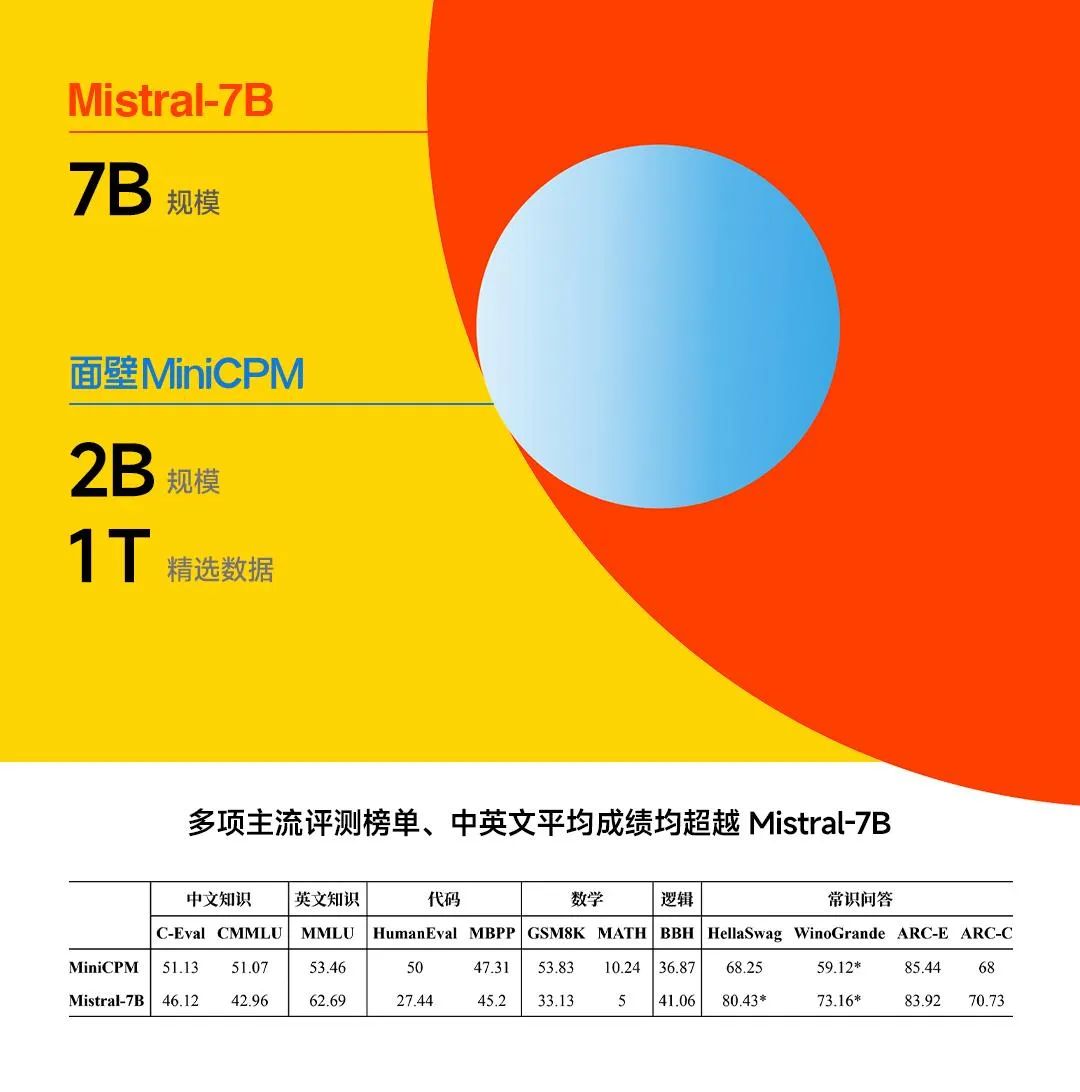

Le dernier modèle MiniCPM 2B lancé par Face Wall Intelligence ne comporte que 2 milliards de paramètres et est formé en utilisant les données sélectionnées du jeton 1T. Par rapport au modèle BERT publié en 2018, ce modèle a le même nombre de paramètres, mais Wall-Facing Intelligence a fait des efforts extrêmes en matière d'optimisation des performances et de contrôle des coûts, permettant à ce modèle d'obtenir l'effet de « sauter et tuer des monstres » en termes de performances.

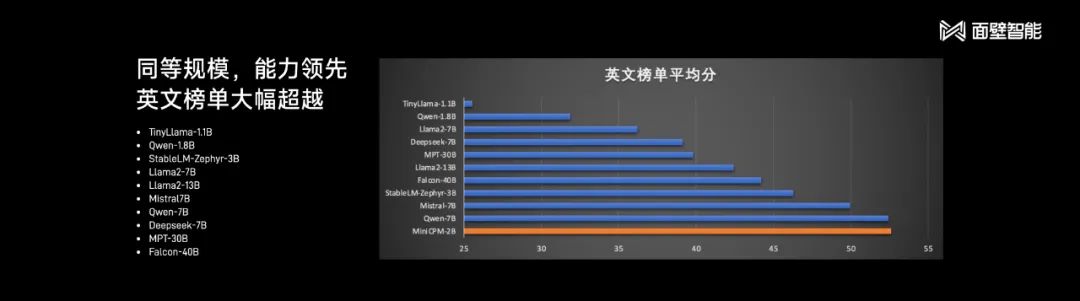

Li Dahai, co-fondateur et PDG de Wall-Facing Intelligence, a comparé le nouveau modèle avec Mistral-7B, un grand modèle open source bien connu dans l'industrie. Le MiniCPM 2B a surpassé ce dernier en termes de performances lors de plusieurs évaluations grand public. listes.

Par rapport au « petit modèle » Phi-2 récemment proposé par Microsoft, le MiniCPM présente également de grands avantages.

Li Dahai a souligné que le nouveau modèle d'intelligence face aux murs a le potentiel de réaliser une mise en œuvre avancée en termes de capacités et peut atteindre les capacités des modèles 13B, 30B ou même 40B. Lorsqu'il est évalué à l'aide de MT-Bench, la liste d'évaluation la plus proche de l'expérience utilisateur, MiniCPM a obtenu 7 points (en comparaison, GPT-4-Turbo a obtenu 9 points).

Sur place, Wall-Facing Intelligence a également démontré l'effet d'application pratique du MiniCPM. Bien que le nombre de paramètres soit faible, le modèle possède de nombreuses fonctionnalités telles que la traduction de texte et le jeu de rôle qu'un grand modèle devrait avoir, et il possède des connaissances riches. Le modèle peut gérer même des tâches d’interprétation de code difficiles.

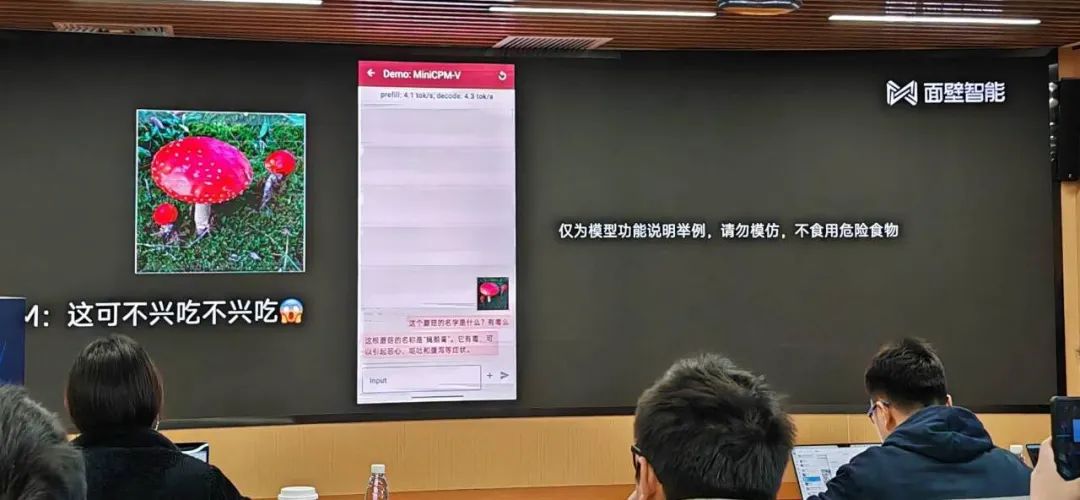

Parce qu'il peut être déployé côté appareil, MiniCPM peut également fournir une aide rapide aux personnes confrontées à certaines urgences :

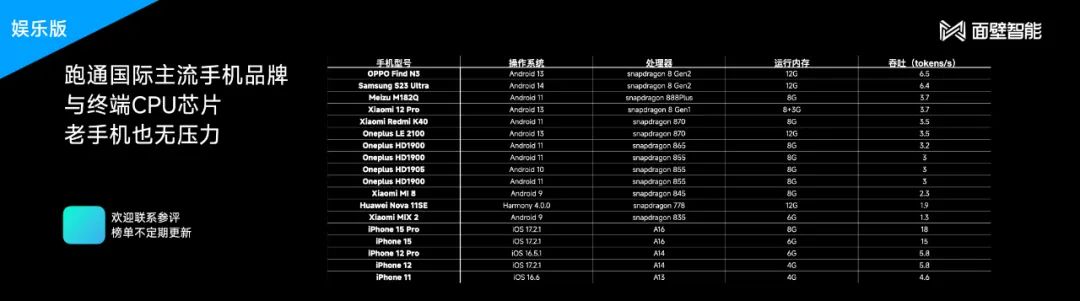

Récemment, divers fabricants de téléphones mobiles ont proposé des modèles côté client à grande échelle. le grand modèle de langage est compressé dans une taille plus petite, nous pouvons l'utiliser pour nous connecter à plus de scénarios et obtenir un degré d'intelligence plus élevé malgré une puissance de calcul et une mémoire limitées. En revanche, la nouvelle technologie proposée par Wall-Facing Intelligence est plus légère et peut être appliquée à des téléphones mobiles de configuration inférieure ou à des modèles antérieurs.

Selon Face Wall Intelligence, le modèle final MiniCPM a subi une quantification Int4 et a été compressé de 75 % en taille, n'occupant que 2 Go de mémoire. En même temps, il n'y a presque aucune perte de performances, il a donc été compressé. été mis en œuvre sur divers modèles courants de téléphones mobiles.

Parce qu'il prend en charge l'inférence du processeur mobile, MiniCPM peut réduire considérablement les coûts d'utilisation. Face Wall Intelligence a calculé pour nous : un téléphone mobile équipé de Snapdragon 855 utilisant MiniCPM peut traiter 1,7 million de tokens pour un dollar d'électricité. Ce prix ne représente que 1% du Mistral-Medium fonctionnant dans le cloud.

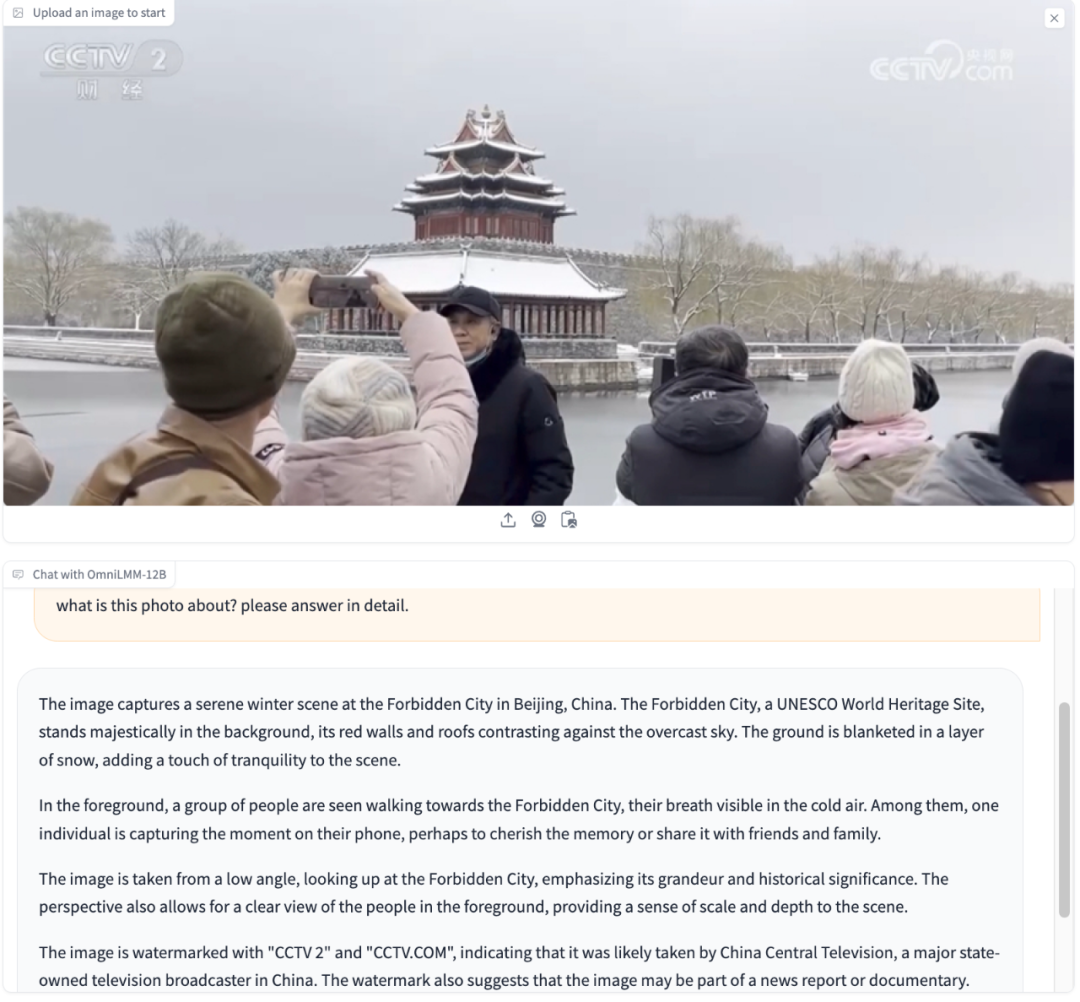

En plus des modèles end-side, Wall Intelligence a également démontré son exploration des grands modèles multimodaux et l'open source du paramètre 12B OmniLMM. Lors de la conférence de presse, Face Wall Intelligence a présenté la même démonstration pierre-papier-ciseaux lors de la sortie de Gemini. Demandez à l'IA en anglais : à quel jeu je joue ? Le grand modèle répondrait : pierre, papier, ciseaux.

En même temps, OmniLMM peut également reconnaître les gestes humains et vous dire quoi jouer si vous voulez gagner.

OmniLMM peut également comprendre et raisonner sur les informations contenues dans de nombreuses images, telles que des bâtiments emblématiques, des logos de chaînes de télévision, des activités organisées par des personnes, etc.

Il semble que nous ne soyons pas loin de grands modèles véritablement multimodaux et de l'application de nouvelles formes.

La performance ultime du grand modèle intelligent mural vient de l’accumulation technologique à long terme de l’entreprise. Depuis 2021, Wallface Intelligence a construit une pile technologique efficace, en se concentrant sur les trois directions de l'Infra, des algorithmes et de la méthodologie des données. Parmi eux, le cadre de formation efficace développé par BMTrain est crucial.

Au niveau des algorithmes, Wall-Facing Intelligence a également accumulé un système de bac à sable de modèles, qui a élevé les grands modèles de l'alchimie au niveau de la science expérimentale. En théorie, elle est constamment à la recherche de solutions optimales pour les hyperparamètres et l'échelle. , comme la taille optimale du lot, la configuration des hyperparamètres commune à toutes les tailles de modèles.

Actuellement, Wall-Facing Intelligence a accumulé une grande quantité de données de haute qualité. Après la sortie d'hier, Face Wall Intelligence a open source sa nouvelle génération de grandes séries de modèles (y compris MiniCPM-SFT / DPOMiniCPM-V & MiniCPM-SFT / DPO-int4), ainsi que les recettes de données pour les deux étapes de formation MiniCPM pour référence de l'industrie. .

Adresse Open source (y compris le rapport technique) :

MiniCPM GitHub : https://github.com/OpenBMB/MiniCPM

OmniLMM GitHub : https://github.com/OpenBMB/OmniLMM

L'intelligence face au mur est originaire de Tsinghua NLP Le laboratoire est l'une des premières équipes à mener des recherches sur de grands modèles en Chine. En 2018, il a publié le premier modèle de pré-formation ERNIE au monde basé sur des conseils de connaissances. Face Wall Intelligence, qui a démarré ses activités en août 2022, a connu deux cycles de financement l'année dernière, et son application « Mian Wall Luka » a également reçu le deuxième lot d'enregistrements de grands modèles de l'Administration chinoise du cyberespace.

Actuellement, Wall-Facing Intelligence a constitué une équipe de recherche scientifique de plus de 100 personnes, dont 80 % sont originaires de Qingbei, avec une moyenne d'âge de 28 ans.

Wall-face Intelligence construit une stratégie double moteur grand modèle + agent, dans l'espoir de créer une solution à plus petite échelle, plus rapide et moins coûteuse.

Cette année, Wall-Facing Intelligence accélérera également l’itération des nouvelles technologies. « Nous continuerons à publier de nouvelles versions de MiniCPM après la Fête du Printemps, et les performances seront encore améliorées. Nous voulons donner à tout le monde une pause pendant la Fête du Printemps », a déclaré Liu Zhiyuan.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Pour aider à construire la « Ville n°1 des drones industriels », la Chengdu Drone Industry Association prévoit

- Exploration de l'application du langage Go dans l'industrie automobile intelligente

- L'alliance industrielle de l'interface cerveau-ordinateur publie dix technologies clés pour l'interface cerveau-ordinateur

- Construisons ensemble le Guangxi numérique et allons ensemble vers un avenir numérique ! La conférence écologique de l'industrie de l'intelligence artificielle du Guangxi Kunpeng Shengteng 2023 s'est tenue avec succès