Maison >Périphériques technologiques >IA >Un modèle open source comparable à GPT-4 a fuité ! Le patron de Mistral vient de le confirmer : la version officielle sera encore plus forte

Un modèle open source comparable à GPT-4 a fuité ! Le patron de Mistral vient de le confirmer : la version officielle sera encore plus forte

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2024-02-01 21:00:471121parcourir

Mistral-Medium a été accidentellement divulgué ? Auparavant disponible uniquement via API, performances sont proches de GPT-4.

La dernière déclaration du PDG : C'est vrai, elle a été divulguée par un des premiers employés d'un client. Mais j'ai quand même dit Restez à l'écoute.

Photos

Photos

En d'autres termes, cette version est encore ancienne et les performances de la version réelle seront meilleures.

Au cours des deux derniers jours, ce mystérieux modèle nommé "Miqu" est devenu un sujet brûlant dans la grande communauté des mannequins. Beaucoup de gens soupçonnent également qu'il s'agit d'une version peaufinée de LIama.

Photos

Photos

Le PDG de Mistral a expliqué qu'ils avaient recyclé Mistral Medium et l'avaient amélioré sur la base de Llama 2. Il s’agit de fournir le plus rapidement possible une API proche des performances de GPT-4 aux premiers clients. Les travaux de pré-formation se sont achevés le jour de la sortie de Mistral 7B.

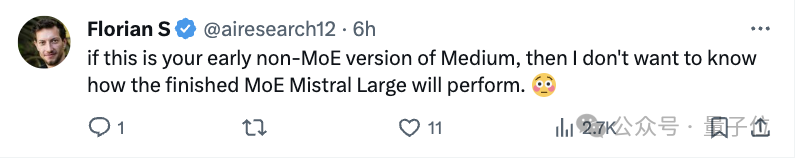

Maintenant que la vérité a été révélée, le PDG reste discret et de nombreux internautes se tendent la main en prévision.

Photos

Photos

Photos

Photos

Mistral-Medium divulgué accidentellement

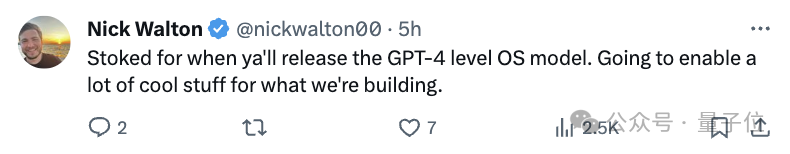

Revoyons à nouveau l'ensemble de l'incident. Le 28 janvier, un mystérieux utilisateur nommé Miqu Dev a publié un ensemble de fichiers « miqu-1-70b » sur HuggingFace.

Photos

Photos

Le document indique que le "format d'invite" et les méthodes d'interaction utilisateur du nouveau LLM sont les mêmes que ceux de Mistral.

Le même jour, un utilisateur anonyme sur 4chan a posté un lien vers le fichier miqu-1-70b.

Certains internautes ont remarqué ce modèle mystérieux et ont commencé à effectuer des tests de référence.

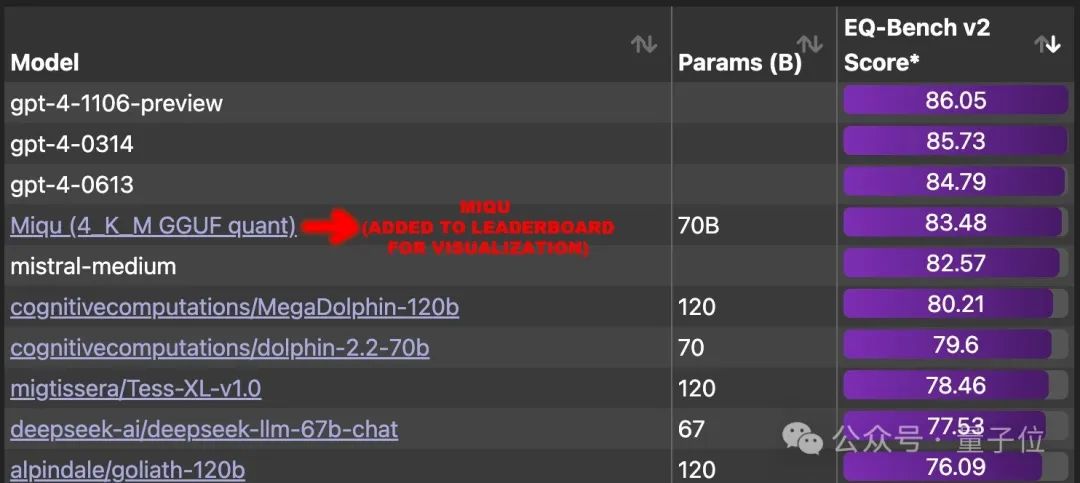

Les résultats sont étonnants, il obtient un score de 83,5 sur EQ-Bench (évaluation locale), surpassant tous les autres grands modèles dans le monde sauf GPT-4.

Pendant un temps, les internautes ont fortement réclamé que ce grand modèle soit ajouté au classement et que l'on découvre le véritable modèle qui se cache derrière.

Il y a trois directions principales de suspicion :

- et Mistral-Medium sont le même modèle.

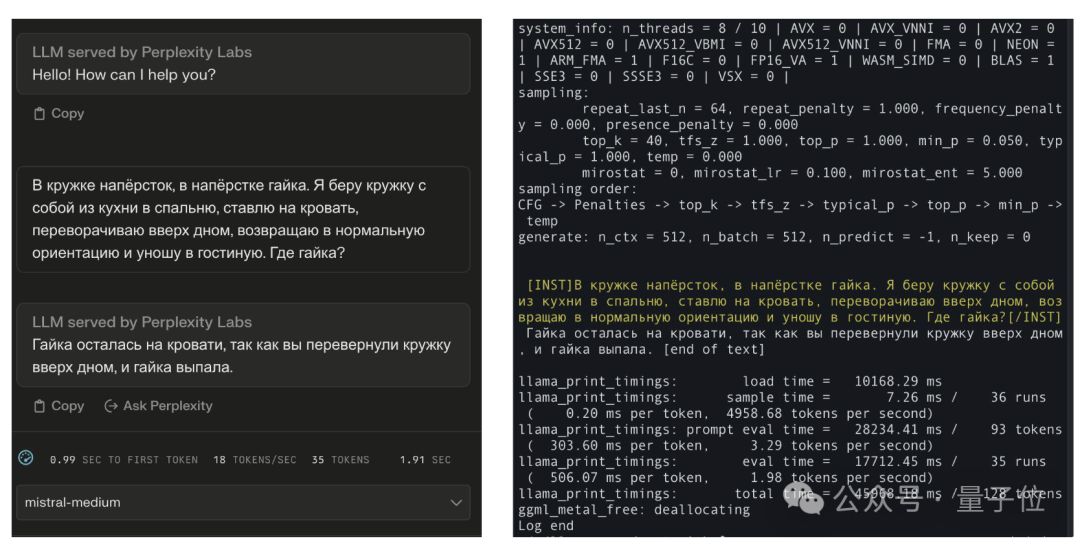

Certains internautes ont posté l'effet de comparaison : il connaît la réponse standard et cela a du sens, mais il est impossible que même la formulation russe soit exactement la même que celle de Mistral-Medium.

Pictures

Pictures

- Miqu devrait être une version peaufinée de LIama 2.

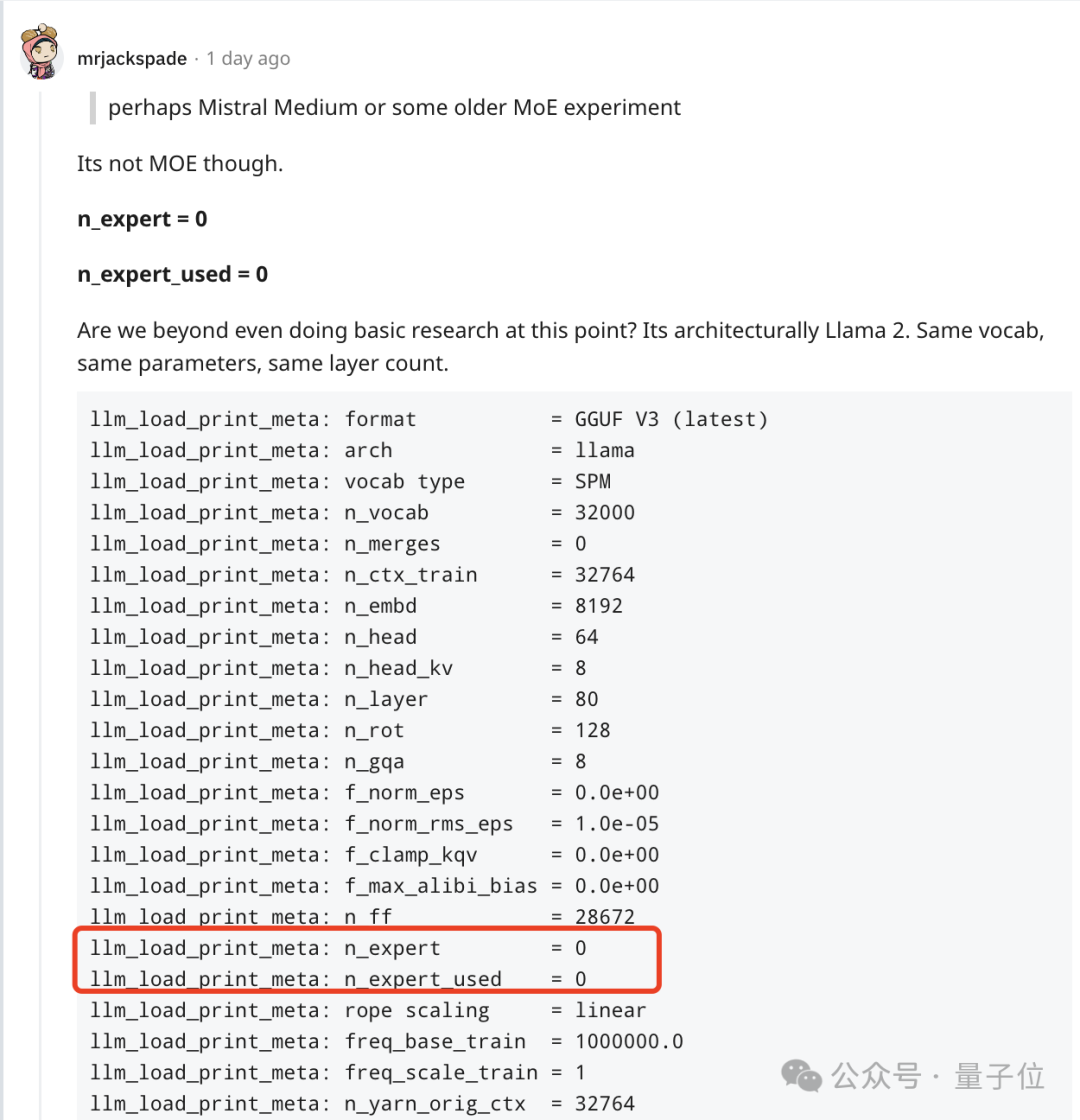

Mais d'autres internautes ont découvert qu'il ne s'agit pas d'un modèle MoE et qu'il a la même architecture, les mêmes paramètres et le même nombre de couches que LIama 2.

Photos

Photos

Cependant, il a été immédiatement remis en question par d'autres internautes. Mistral 7b a également les mêmes paramètres et nombre de couches que le lama 7B.

Au lieu de cela, cela ressemble plus à un Modèle Mistral précoce non-MoE.

Photos

Photos

Cependant, après discussions, il est indéniable que dans l'esprit de nombreuses personnes, il s'agit du modèle le plus proche du GPT-4.

Photos

Photos

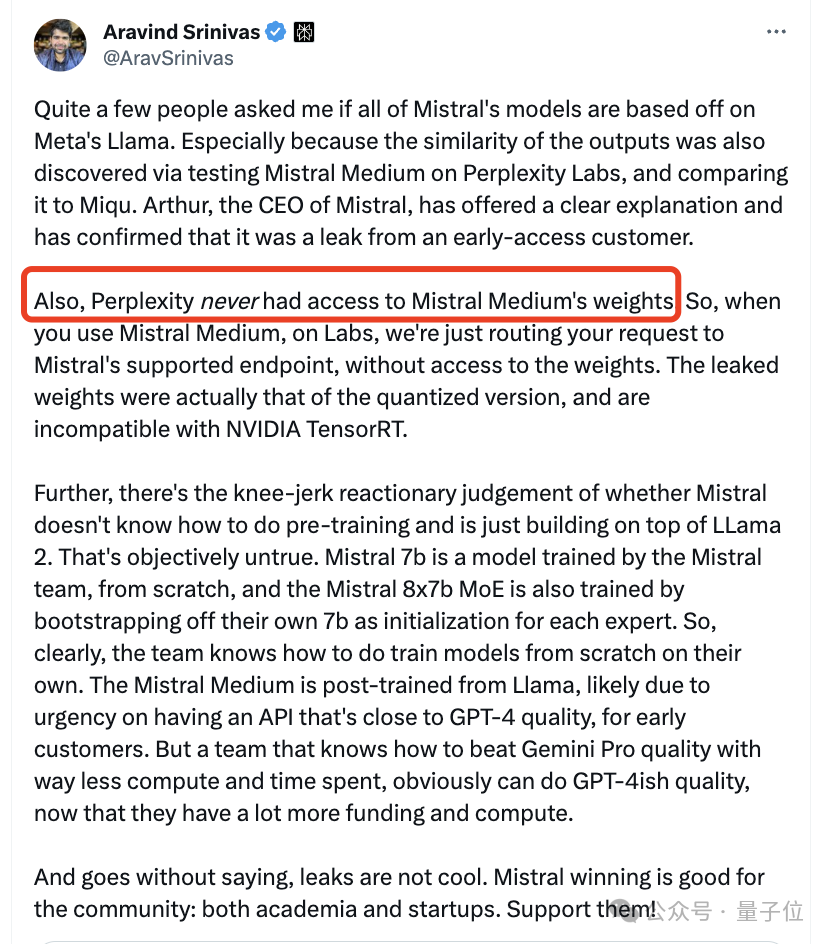

Maintenant, le co-fondateur et PDG de Mistral, Arthur Mensch, a admis que l'un de ses premiers employés clients était trop enthousiaste et avait divulgué une version quantifiée d'un ancien modèle qu'ils avaient formé et rendu public.

Quant à Perplexity, le PDG a également précisé qu'ils n'ont jamais reçu le poids de Mistral Medium.

Photos

Photos

Les internautes s'inquiètent de savoir si cette version sera supprimée.

Photos

Photos

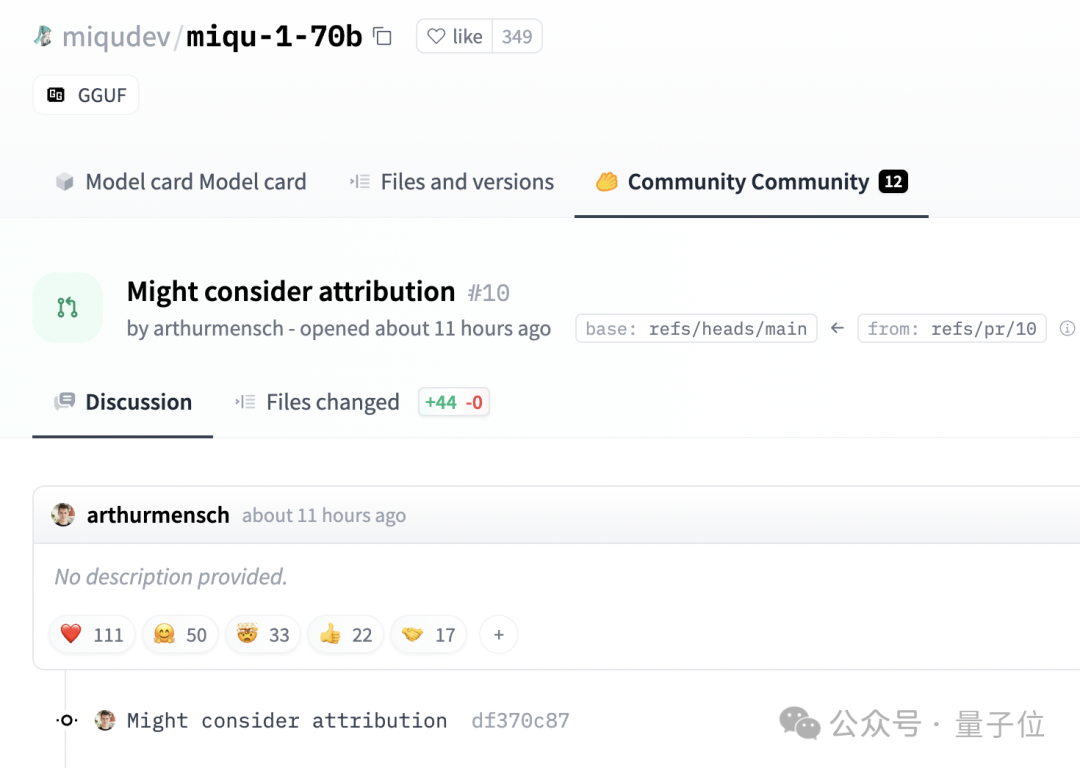

Fait intéressant, Mensch n'a pas demandé que le message sur HuggingFace soit supprimé.

Photos

Photos

Au lieu de cela, laissez un commentaire disant : Des problèmes d'attribution peuvent être pris en compte.

Liens de référence :

[1]https://www.reddit.com/r/LocalLLaMA/comments/1af4fbg/llm_comparisontest_miqu170b/

[2]https://twitter.com/teortaxesTex/status/1752427812466593975

[3]https://twitter.com/N8Programs/status/1752441060133892503

[4]https://twitter.com/AravSrinivas/status/1752803571035504858

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!