Maison >Périphériques technologiques >IA >Collaboration décisionnelle entre humains et IA : formulation, explication et évaluation de problèmes de prise de décision

Collaboration décisionnelle entre humains et IA : formulation, explication et évaluation de problèmes de prise de décision

- 王林avant

- 2024-02-01 14:54:181352parcourir

Dans des domaines tels que l'intelligence artificielle et la visualisation de données, comment utiliser l'affichage d'informations pour aider les humains à prendre de meilleures décisions est un objectif de recherche important. Cependant, il n’existe actuellement aucun consensus clair sur la définition des problèmes de décision et sur la conception d’expériences sur la manière d’évaluer la performance humaine en matière de prise de décision. Un article récent propose une définition d'un problème de décision basée sur la théorie statistique de la décision et l'économie de l'information et fournit un cadre pour évaluer la perte de performance décisionnelle humaine. Cet article interprétera le document et explorera ses implications pour faire progresser la recherche sur la prise de décision.

Dans l'article "Decision Theoretic Foundations for Experiments Evaluating Human Decisions", trois experts américains proposent une interface d'information pour aider la prise de décision à atteindre un objectif commun pour la recherche en intelligence artificielle centrée sur l'humain (HCAI), la visualisation et les domaines connexes. . Ces experts soutiennent que les chercheurs en visualisation mettent l'accent sur l'aide à la prise de décision comme un objectif important de la visualisation des données. Dans le même temps, dans le domaine de l'intelligence artificielle centrée sur l'humain, la recherche empirique sur le comportement décisionnel humain est également largement considérée comme « évaluant l'efficacité de la technologie de l'intelligence artificielle pour aider à la prise de décision et développer une compréhension de base de la façon dont les gens interagissent avec l'intelligence artificielle ». prendre des décisions" » contenu nécessaire. Les objectifs de ces études sont d’améliorer la précision et l’efficacité de la prise de décision, d’assurer une bonne interaction entre la technologie de l’intelligence artificielle et les décideurs humains et de fournir aux individus une meilleure aide à la décision.

Ils pensent qu'en étudiant l'affichage des informations lors de la prise de décision humaine, un ensemble minimal d'engagements théoriques peut être clairement défini, offrant ainsi la possibilité de déterminer un comportement normatif pour la tâche. Heureusement, la théorie statistique de la décision et la théorie de l’utilité attendue peuvent relever ce défi et fournir un cadre rigoureusement dérivé et largement applicable pour étudier la prise de décision. En outre, le développement de l’économie de l’information fournit également des solutions pour la formalisation des structures d’information pour les problèmes de prise de décision, ce qui peut impliquer la conception d’options de visualisation et d’interprétation pour les prédictions des modèles.

Ils synthétisent une définition largement applicable de problèmes de décision bien définis issus de la théorie statistique de la décision et de l'économie de l'information, et inspirent la valeur de cette approche dans l'HCAI et la recherche décisionnelle connexe à partir d'une interface basée sur les données. Leur première contribution a été d'établir et de motiver l'ensemble minimal de composants qui doivent être définis pour un problème de décision afin d'identifier les décisions optimales et ainsi identifier les biais dans la prise de décision humaine. Utilisant le concept d’agents bayésiens rationnels, ils montrent que les pertes de performance ne peuvent être prises en compte que lorsque les participants à la recherche sont théoriquement capables d’identifier des décisions normatives à partir des informations qui leur sont fournies. Ils ont constaté que dans un échantillon de 46 études existantes, 35 études utilisaient des affichages prédictifs pour tirer des conclusions sur les déficits de prise de décision humaine, mais seulement 6 d'entre elles (17 %) étaient des tâches d'étude explicites parce que les participants recevaient suffisamment d'informations pour que, au moins dans principe, peut déterminer la meilleure décision. Ils utilisent des exemples pour illustrer les risques épistémologiques de ces conclusions et fournissent des suggestions aux expérimentateurs pour améliorer l'interprétabilité de leurs résultats.

Contexte de l'auteur de l'article

Le titre de cet article est "Fondements théoriques de la décision pour les expériences évaluant les décisions humaines". Il a été co-écrit par Jessica Hullman, Alex Kale et Jason Hartline, trois informaticiens. scientifiques de l’Université Northwestern aux États-Unis Publié sur arXiv le 25 janvier 2024 (adresse papier : https://arxiv.org/abs/2401.15106). Ces trois auteurs sont des chercheurs reconnus dans les domaines de l'intelligence artificielle, de la visualisation de données, de l'interaction homme-machine, etc. Les résultats de leurs recherches ont été publiés dans des conférences et revues universitaires de premier plan, telles que ACM CHI, ACM CSCW, IEEE VIS, ACM. CE, etc. Leurs intérêts de recherche portent principalement sur la manière d’utiliser l’intelligence artificielle et la visualisation de données pour aider les humains à comprendre et à prendre des décisions sur des questions d’incertitude complexes, telles que l’évaluation des risques, la prévision, la recommandation, etc.

La principale contribution de l'article

donne une définition d'un problème général de prise de décision, comprenant des éléments tels que l'espace d'action, l'espace d'état, les règles de notation, les croyances antérieures, les modèles de génération de données et les stratégies de signalisation, et explique comment utiliser ces éléments pour déterminer les actions optimales et l’utilité attendue.

Proposer un cadre pour évaluer les pertes de performances de prise de décision humaine, comprenant quatre sources potentielles de pertes, notamment la perte préalable, la perte de réception, la perte de mise à jour et la perte d'optimisation, et explorer comment estimer et analyser ces pertes grâce à une conception expérimentale et résultats.

Ces dernières années, les chercheurs ont codé et évalué la prise de décision assistée par l'intelligence artificielle, et les résultats ont montré que seul un petit nombre d'études (environ 17 %) fournissaient suffisamment d'informations pour permettre aux participants de déterminer des décisions normatives. Au lieu de cela, la plupart des études (environ 83 %) souffrent de problèmes de prise de décision peu clairs et incomplets, ce qui conduit à des conclusions peu fiables sur les biais et les défauts de la prise de décision humaine.

Base théorique et méthode

La base théorique de cet article provient principalement de la théorie statistique de la décision et de l'économie de l'information. La théorie statistique de la décision étudie les méthodes permettant de faire des choix optimaux dans des conditions d'incertitude, en se concentrant sur la relation entre les préférences, les croyances et les actions des décideurs, et sur la manière d'utiliser les données et les informations pour mettre à jour les croyances et sélectionner les actions. L'économie de l'information étudie l'impact de l'information sur le comportement et les résultats économiques, en se concentrant sur les mécanismes de production, de diffusion et de consommation de l'information, ainsi que l'impact d'une information asymétrique, incomplète et peu fiable sur le marché et la société. Ces deux disciplines fournissent une base théorique importante pour l’article et nous aident à comprendre en profondeur le rôle et l’impact de la prise de décision et de l’information dans l’économie.

La méthode de cet article est principalement basée sur la théorie bayésienne et la théorie de l'utilité attendue. La théorie bayésienne est une théorie des probabilités utilisée pour décrire et raisonner sur l'incertitude, en se concentrant sur le calcul de croyances postérieures basées sur des croyances antérieures et des données d'observation, c'est-à-dire la probabilité qu'une certaine hypothèse ou un certain événement se produise dans des conditions de données données. La théorie de l'utilité attendue est une théorie d'évaluation des décisions risquées qui se concentre sur la façon de calculer l'utilité attendue, une moyenne pondérée de l'utilité produite dans différents états, basée sur des fonctions d'utilité et des distributions de probabilité. Cette approche combine le raisonnement bayésien et l'évaluation de l'utilité pour fournir aux décideurs des décisions optimales face à l'incertitude.

Définition du problème de décision

Ils définissent un problème de décision et le critère de comportement optimal correspondant pour déterminer la pénalité de performance par rapport à ce critère. Leur définition vise l'évaluation contrôlée du comportement humain, c'est-à-dire l'étude de la prise de décision normative. Ce type de recherche évaluative nécessite la capacité de déterminer les faits de base sur l’état sur lequel les participants à la recherche sont interrogés. Les données comportementales (qui peuvent être générées par des humains ou des simulations) sont collectées dans des conditions contrôlées dans le but de comprendre le comportement suscité par la fourniture d'informations. De telles études sont souvent utilisées pour décrire la qualité de la performance humaine dans certaines situations (par exemple, la mesure dans laquelle les gens prennent des décisions basées sur des affichages dans des contextes stratégiques) et pour classer différents éléments d'assistance en fonction de la performance humaine (par exemple, différentes visualisations ou intelligence artificielle). ). Stratégies d'explication intelligentes), ou tester des hypothèses sur la façon dont les humains prennent des décisions ou sur ce qui les aidera à mieux faire (par exemple, les capacités de forçage cognitif amélioreront la prise de décision assistée par l'IA).

Calcul des actions optimales et de l'utilité attendue

Étant donné un problème de décision défini comme ci-dessus, ils le font en supposant que l'agent a des préférences cohérentes et prend des décisions optimales entre les actions sous des moyens de résultats incertains, pour calculer le normatif (" optimales »). Ils peuvent donc interpréter la performance des participants expérimentaux comme une tentative de répondre à ce critère et identifier les sources d'erreur (perte) de performance.

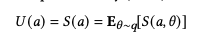

Pour ce faire, ils supposeront d'abord que les préférences de l'agent peuvent être résumées par une règle de notation Supposons qu'il choisira l'action qui maximise son utilité attendue (score) :

L'image

L'image

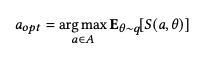

décrit la distribution des croyances de l'agent qui est la distribution de probabilité de l'état du monde auquel le sujet croit. Nous pouvons définir l'action optimale comme celle qui maximise l'utilité attendue de l'agent :

Image

Image

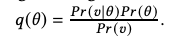

Plus précisément, afin de calculer la décision optimale pour la tâche de prise de décision, ils définissent d'abord l'agent dans l'équation à partir de π : Pr (θ) ou p(θ) comme nous l’avons décrit ci-dessus. Chaque fois qu'une stratégie de signalisation n'affiche pas π(θ |u) directement à travers le signal mais informe θ, nous supposons qu'après avoir vu le signal, les agents utilisent la règle de Bayes pour prédire leur réponse au signal en fonction de leur connaissance du signal. modèle de génération de données La croyance précédente de l'état de somme est mise à jour vers la croyance postérieure π :

image

image

u est un facteur de normalisation. Notez que la définition de l'équation 3 implique que q(θ) est calculé pour que l'agent le sache.

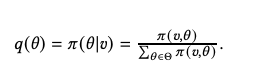

Picture

Picture

Compte tenu de ces croyances postérieures, nous utilisons l'équation 2 pour déterminer l'action S choisie par un agent parfaitement rationnel pour maximiser son utilité attendue.

Le cadre informatique de l'auteur fournit un outil utile pour la collaboration décisionnelle en matière d'intelligence humaine et artificielle, qui peut aider à analyser et à améliorer le comportement et les effets de la prise de décision humaine, ainsi qu'à améliorer la qualité et la satisfaction de la prise de décision humaine. Leur cadre informatique fournit également un espace inspirant et innovant pour l’expansion et l’approfondissement des théories et méthodes de prise de décision, et peut explorer davantage de facteurs et de mécanismes de prise de décision, ainsi que davantage de modèles et de stratégies de prise de décision.

Évaluation des pertes de performances décisionnelles humaines

Les principales motivations pour utiliser le cadre ci-dessus sont de nature épistémologique et liées à notre connaissance des résultats expérimentaux. Afin d’interpréter les réponses aux problèmes de décision dans les expériences de prise de décision humaine comme la preuve de processus de prise de décision défectueux, l’expérience doit fournir aux participants suffisamment d’informations pour, en principe, déterminer les décisions normatives par rapport auxquelles leur comportement sera jugé. En d’autres termes, l’expérience fournit-elle aux participants suffisamment d’informations pour rendre leur compréhension du problème de décision cohérente avec son interprétation normative ?

Ils ont découvert que les modèles de réseaux neuronaux peuvent reproduire et surpasser les recherches psychologiques existantes, telles que la théorie des perspectives, les modèles basés sur l'environnement, les modèles hybrides, etc. Le modèle de réseau neuronal peut apprendre automatiquement différentes fonctions de perception des risques et les pondérations entre elles en fonction de différentes hypothèses. Les auteurs ont également constaté que les fonctions de perception du risque humain sont non linéaires, dépendantes du scénario et qu’il existe une relation interdépendante entre probabilité et rendement. Ces résultats illustrent que la prise de décision en matière de risques humains est extrêmement complexe et ne peut être attribuée à de simples hypothèses.

Les auteurs ont utilisé une mesure simple pour mesurer l'ampleur de la perte de performance décisionnelle humaine, qui est la différence moyenne entre le choix humain et le choix optimal. Les auteurs ont constaté que la perte de performance en matière de prise de décision humaine variait considérablement selon les scénarios, allant de 0,01 à 0,5. Les auteurs ont également constaté que la perte de performance décisionnelle humaine est positivement corrélée à l’erreur de prédiction du modèle de réseau neuronal, c’est-à-dire que plus il est difficile pour le modèle de réseau neuronal de prédire les choix humains, plus la perte de ressources humaines est importante. performance en matière de prise de décision. Cela montre que le modèle de réseau neuronal peut capturer efficacement les caractéristiques de la perception du risque humain, ainsi que l'irrationalité et l'incohérence de la prise de décision en matière de risque humain.

Le cadre d'évaluation de l'auteur fournit un outil utile pour la collaboration décisionnelle entre les humains et l'intelligence artificielle, qui peut aider à analyser et à améliorer les comportements et les effets de la prise de décision humaine, ainsi qu'à améliorer la qualité et la satisfaction de la prise de décision humaine. Le cadre d'évaluation de l'auteur fournit également un espace inspirant et innovant pour l'expansion et l'approfondissement des théories et méthodes de prise de décision, permettant l'exploration d'un plus grand nombre de facteurs et de mécanismes de prise de décision, ainsi que d'un plus grand nombre de modèles et de stratégies de prise de décision.

Analyse empirique et résultats

L'analyse empirique de cet article code et évalue principalement les recherches sur la prise de décision assistée par l'intelligence artificielle ces dernières années afin de tester si ces études sont cohérentes avec le cadre de la théorie de la prise de décision. et s'ils sont bénéfiques à la prise de décision humaine. Une conclusion raisonnable a été tirée concernant les défauts ou les pertes. L'auteur a sélectionné au hasard 46 études dans l'analyse documentaire de Lai et al., qui ont été publiées lors des conférences ACM ou ACL entre 2018 et 2021 et impliquaient des expériences sur la prise de décision assistée par intelligence artificielle pour des problèmes de classification ou de régression.

Les auteurs ont codé ces études selon les trois aspects suivants.

Applicabilité du cadre de la théorie de la décision : s'il existe un état réel qui peut être déterminé et s'il existe un gain ou une perte associé à l'État.

Évaluation de la prise de décision humaine : s'il existe une évaluation ou un jugement sur la performance ou la qualité de la prise de décision humaine, par exemple en soulignant le phénomène de dépendance excessive ou insuffisante à l'égard de l'intelligence artificielle, ou en spéculant sur la causes ou facteurs d’influence de la prise de décision humaine.

Clarté du problème de décision : si suffisamment d'informations sont fournies aux participants pour identifier les décisions normatives, y compris l'espace d'action, l'espace d'état, les règles de notation, les croyances antérieures, les modèles de génération de données, les stratégies de signalisation, etc.

Les résultats de codage de l'auteur montrent que 11 études (24 %) comportent des tâches qui n'ont pas d'état réel déterminable, comme la recommandation subjective de musique ou de film ou la reconnaissance d'émotions. Ces études ne conviennent pas au cadre de la théorie de la décision. Les 35 études restantes (76 %) ont effectué des évaluations ou des jugements sur la performance ou la qualité de la prise de décision humaine, mais seulement 6 études (17 %) ont fourni aux participants suffisamment d'informations pour identifier les décisions normatives, tandis que les 29 autres études (83 %) avaient des problèmes de prise de décision flous et incomplets, conduisant à des conclusions peu fiables sur les préjugés et les défauts de la prise de décision humaine. L'auteur fournit également une analyse et une discussion détaillées des problèmes spécifiques et des méthodes d'amélioration de ces études, tels que le manque de communication des croyances antérieures, le manque de calcul des croyances a posteriori, le manque de motivation et de comparaison des règles de notation, etc. L'auteur estime que ces problèmes proviennent tous de la définition et de la communication insuffisantes des problèmes de prise de décision par les chercheurs, ainsi que de leur compréhension floue de la relation entre le monde expérimental et le monde réel. L'auteur recommande que les chercheurs prennent pleinement en compte le cadre de la théorie de la prise de décision lors de la conception d'expériences et communiquent clairement toutes les composantes nécessaires du problème de prise de décision aux participants et aux lecteurs, afin d'évaluer et d'améliorer efficacement le comportement décisionnel humain.

Future Work

Les limites de cet article proviennent principalement des défis et des critiques de la théorie de l'utilité attendue et des méthodes normatives. La théorie de l’utilité attendue est une théorie de prise de décision basée sur la rationalité et l’optimisation, qui suppose que les décideurs disposent d’informations complètes et d’une puissance de calcul, ainsi que de préférences cohérentes et stables. Cependant, ces hypothèses ne sont souvent pas vraies dans le monde réel. Le comportement décisionnel humain peut être affecté par des facteurs cognitifs, émotionnels, sociaux, moraux et autres, conduisant à des écarts par rapport aux prédictions de la théorie de l’utilité attendue. L'approche normative est une approche de prise de décision basée sur des valeurs et des objectifs qui suppose que le décideur a un objectif de valeur clair et un moyen d'évaluer l'impact de différentes actions sur l'objectif de valeur. Cependant, ces hypothèses ne sont souvent pas vraies dans le monde réel, où les valeurs humaines peuvent être diverses, dynamiques, ambiguës et peuvent entrer en conflit ou s'harmoniser avec les valeurs d'autres personnes ou de la société. Par conséquent, le cadre et les méthodes de cet article peuvent ne pas convenir à certains problèmes de prise de décision subjectifs, complexes et multi-objectifs, et peuvent également ignorer la valeur et l'importance inhérentes de certaines prises de décision humaines.

Les travaux futurs s'étendront et s'approfondiront principalement dans les quatre aspects suivants.

Explorez d'autres théories et méthodes de prise de décision, telles que l'économie comportementale, la théorie de l'utilité multi-attributs, l'analyse décisionnelle multicritère, etc., pour mieux décrire et évaluer le comportement et les préférences décisionnelles réelles de l'homme.

Étudier différentes méthodes d'affichage et d'interaction d'informations, telles que le langage naturel, les graphiques, le son, le toucher, etc., pour mieux transmettre et expliquer les différentes composantes des problèmes de prise de décision, ainsi que pour améliorer les capacités humaines de réception et de traitement de l'information. .

Essayez différents mécanismes d'incitation et de rétroaction, tels que les récompenses, les punitions, la crédibilité, la réputation, l'influence sociale, etc., pour mieux stimuler et maintenir la motivation et la participation humaines à la prise de décision, ainsi qu'améliorer l'apprentissage et la prise de décision humaine. capacités d’amélioration.

Développez différents modes de collaboration entre l'IA et les humains, tels que l'assistance, la suggestion, l'agence, la négociation, la coordination, etc., pour mieux équilibrer et utiliser les avantages et les inconvénients de l'IA et des humains, et améliorer les performances de la confiance de l'IA et des humains. et satisfaction.

Importance et valeur

Cet article fournit aux chercheurs en intelligence artificielle, visualisation de données, interaction homme-machine et autres domaines un cadre clair et organisé pour la définition et l'évaluation des problèmes de prise de décision afin de mieux concevoir et analyser des expériences sur la collaboration décisionnelle en matière d’intelligence humaine et artificielle.

Fournit aux chercheurs en intelligence artificielle, visualisation de données, interaction homme-machine et autres domaines une méthode objective et rigoureuse pour évaluer et analyser les pertes de performances décisionnelles afin de mieux identifier et améliorer la collaboration décisionnelle entre humains et artificiels. intelligence.effet et qualité. Ils apportent une perspective critique et réflexive sur la communication et l’interprétation des problèmes de prise de décision afin de mieux comprendre et communiquer les enjeux et défis de la collaboration décisionnelle humaine et IA. Ils fournissent également une extension inspirante et innovante et une orientation approfondie des problèmes de prise de décision pour mieux explorer et découvrir les possibilités et le potentiel de la collaboration décisionnelle entre les humains et l’intelligence artificielle.

Résumé et perspectives

L'article propose une définition des problèmes de prise de décision basée sur la théorie statistique de la décision et l'économie de l'information, ainsi qu'un cadre pour évaluer la perte de performance décisionnelle humaine. Leur objectif est de fournir un guide et une référence clairs et organisés aux chercheurs dans les domaines de l'intelligence artificielle, de la visualisation de données, de l'interaction homme-machine et d'autres domaines afin de mieux concevoir et analyser des expériences sur la collaboration décisionnelle entre les humains et l'intelligence artificielle. Ils ont codé et évalué les études pertinentes au cours des dernières années et ont constaté que seule une petite proportion d'études fournissait aux participants suffisamment d'informations pour identifier les décisions normatives, tandis que la plupart des études souffraient de problèmes de décision peu clairs et incomplets, conduisant à des conclusions sur les biais et les défauts des décisions humaines. la fabrication n’est pas fiable. Nous recommandons aux chercheurs de prendre pleinement en compte le cadre de la théorie de la prise de décision lors de la conception d'expériences et de communiquer clairement toutes les composantes nécessaires du problème de prise de décision aux participants et aux lecteurs afin d'évaluer et d'améliorer efficacement le comportement décisionnel humain.

L'auteur est également conscient des limites du cadre et des méthodes et de la nécessité de travaux futurs. Leurs cadres et méthodes sont basés sur la théorie de l’utilité attendue et les méthodes normatives, qui présentent également certains défis et critiques, comme le fait d’être incompatibles avec les comportements et préférences décisionnels humains réels et d’ignorer la valeur et l’importance intrinsèques de la prise de décision humaine. Leurs cadres et méthodes peuvent également ne pas être adaptés à certains problèmes de prise de décision subjectifs, complexes et multi-objectifs, et peuvent ne pas couvrir toutes les possibilités et potentiels de collaboration décisionnelle entre les humains et l’intelligence artificielle. Par conséquent, nos travaux futurs consistent principalement à élargir et à approfondir les aspects suivants : explorer d'autres théories et méthodes de prise de décision, étudier différentes méthodes d'affichage et d'interaction d'informations, étudier différents mécanismes d'incitation et de rétroaction, étudier différentes intelligences artificielles et modes de collaboration humaine. (FIN)

Référence : https://arxiv.org/abs/2401.15106

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Quels sont respectivement les logiciels Ai, Ae et Ps ?

- Quels sont les contenus fondamentaux de la recherche sur l'intelligence artificielle ?

- Quel dossier est BaiduNetDisk ?

- Quelle est la touche de raccourci pour fusionner des calques dans AI ?

- Quelles sont les orientations de développement de l'intelligence artificielle ?