Maison >Périphériques technologiques >IA >Une analyse approfondie des techniques d'apprentissage contradictoire dans l'apprentissage automatique

Une analyse approfondie des techniques d'apprentissage contradictoire dans l'apprentissage automatique

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2024-01-23 12:51:131439parcourir

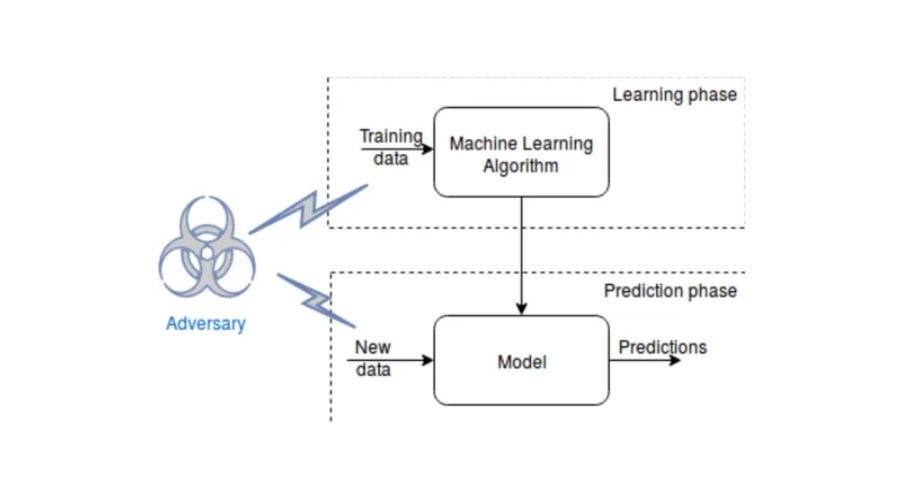

L'apprentissage contradictoire est une technique d'apprentissage automatique qui améliore la robustesse d'un modèle en l'entraînant de manière contradictoire. Le but de cette méthode de formation est d'amener le modèle à produire des prédictions inexactes ou erronées en introduisant délibérément des échantillons difficiles. De cette manière, le modèle entraîné peut mieux s'adapter aux changements dans les données du monde réel, améliorant ainsi la stabilité de ses performances.

Attaques adverses contre les modèles d'apprentissage automatique

Les attaques contre les modèles d'apprentissage automatique peuvent être divisées en deux catégories : les attaques par boîte blanche et les attaques par boîte noire. Une attaque en boîte blanche signifie que l'attaquant peut accéder à la structure et aux paramètres du modèle pour mener l'attaque tandis qu'une attaque en boîte noire signifie que l'attaquant ne peut pas accéder à ces informations ; Certaines méthodes d'attaque contradictoire courantes incluent la méthode des signes de gradient rapide (FGSM), la méthode itérative de base (BIM) et l'attaque par carte de saillance basée sur la matrice jacobienne (JSMA).

Pourquoi l'apprentissage contradictoire est-il important pour améliorer la robustesse du modèle ?

L'apprentissage contradictoire joue un rôle important dans l'amélioration de la robustesse du modèle. Cela peut aider les modèles à mieux généraliser, à identifier et à s'adapter aux structures de données, améliorant ainsi la robustesse. De plus, l’apprentissage contradictoire peut découvrir les faiblesses du modèle et fournir des conseils pour l’améliorer. Par conséquent, l’apprentissage contradictoire est crucial pour la formation et l’optimisation des modèles.

Comment intégrer l’apprentissage contradictoire dans les modèles d’apprentissage automatique ?

L'intégration de l'apprentissage contradictoire dans un modèle d'apprentissage automatique nécessite deux étapes : générer des exemples contradictoires et intégrer ces exemples dans le processus de formation.

Génération et formation d'exemples contradictoires

Il existe de nombreuses façons de générer des informations, notamment les méthodes basées sur le gradient, les algorithmes génétiques et l'apprentissage par renforcement. Parmi elles, les méthodes basées sur le gradient sont les plus couramment utilisées. Cette méthode consiste à calculer le gradient de la fonction de perte d'entrée et à ajuster les informations en fonction de la direction du gradient pour augmenter la perte.

Des exemples contradictoires peuvent être intégrés au processus de formation grâce à une formation contradictoire et à une amélioration contradictoire. Pendant la formation, des exemples contradictoires sont utilisés pour mettre à jour les paramètres du modèle tout en améliorant la robustesse du modèle en ajoutant des exemples contradictoires aux données de formation.

Les données augmentées sont une méthode pratique simple et efficace largement utilisée pour améliorer les performances des modèles. L'idée de base est d'introduire des exemples contradictoires dans les données d'entraînement, puis d'entraîner le modèle sur les données augmentées. Le modèle entraîné est capable de prédire avec précision les étiquettes de classe des exemples originaux et contradictoires, ce qui le rend plus robuste aux changements et aux distorsions des données. Cette méthode est très courante dans les applications pratiques.

Exemples d'application de l'apprentissage contradictoire

L'apprentissage contradictoire a été appliqué à une variété de tâches d'apprentissage automatique, notamment la vision par ordinateur, la reconnaissance vocale et le traitement du langage naturel.

En vision par ordinateur, pour améliorer la robustesse des modèles de classification d'images, l'ajustement de la robustesse des réseaux de neurones convolutifs (CNN) peut améliorer la précision des données invisibles.

L'apprentissage contradictoire joue un rôle dans l'amélioration de la robustesse des systèmes de reconnaissance automatique de la parole (ASR) en reconnaissance vocale. La méthode fonctionne en utilisant des exemples contradictoires pour modifier le signal vocal d'entrée d'une manière qui est conçue pour être imperceptible pour les humains, mais qui amène le système ASR à le mal transcrire. La recherche montre que la formation contradictoire peut améliorer la robustesse des systèmes ASR face à ces exemples contradictoires, améliorant ainsi la précision et la fiabilité de la reconnaissance.

Dans le traitement du langage naturel, l'apprentissage contradictoire a été utilisé pour améliorer la robustesse des modèles d'analyse des sentiments. Les exemples contradictoires dans ce domaine de la PNL visent à manipuler le texte saisi de manière à aboutir à des prédictions de modèle incorrectes et inexactes. Il a été démontré que la formation contradictoire rend les modèles d'analyse des sentiments plus robustes à ces types d'exemples contradictoires, ce qui se traduit par une précision et une robustesse améliorées.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Trois meilleures bibliothèques d'apprentissage automatique pour Python

- Comment utiliser l'apprentissage automatique pour analyser les sentiments

- Intelligence artificielle basée sur des règles vs apprentissage automatique

- Les essentiels du machine learning : comment éviter le surapprentissage ?

- Méthode de configuration pour l'utilisation de RStudio pour le développement de modèles d'apprentissage automatique sur les systèmes Linux