Maison >Périphériques technologiques >IA >Styles mixtes de Yang Mi et Taylor : Xiaohongshu AI lance des styles adaptés SD et ControlNet

Styles mixtes de Yang Mi et Taylor : Xiaohongshu AI lance des styles adaptés SD et ControlNet

- WBOYavant

- 2024-01-18 17:15:251383parcourir

Je dois dire que prendre des photos maintenant est vraiment « si simple que c'en est ridicule ».

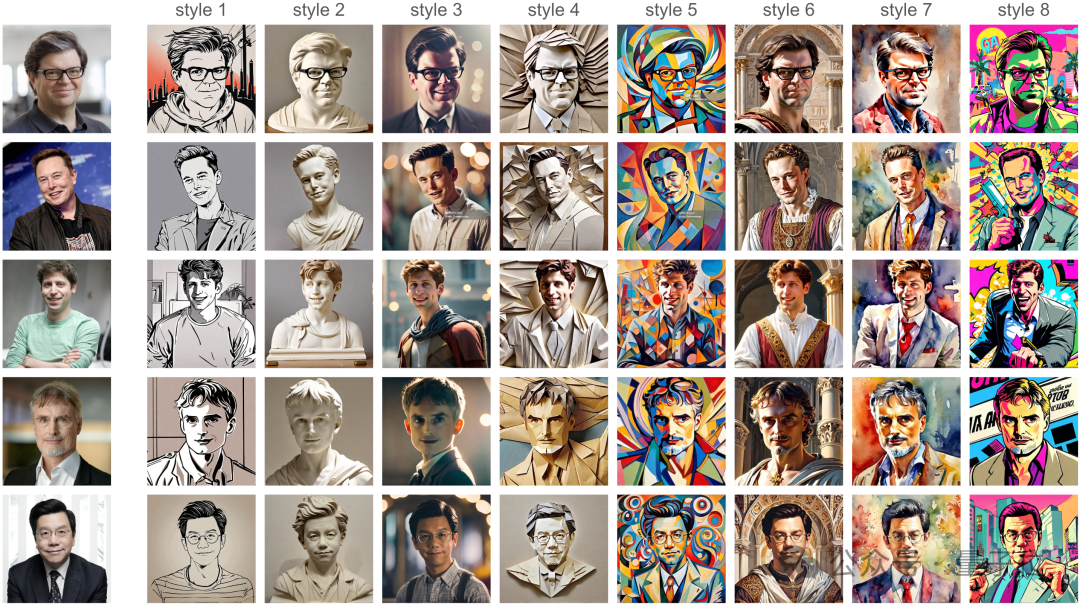

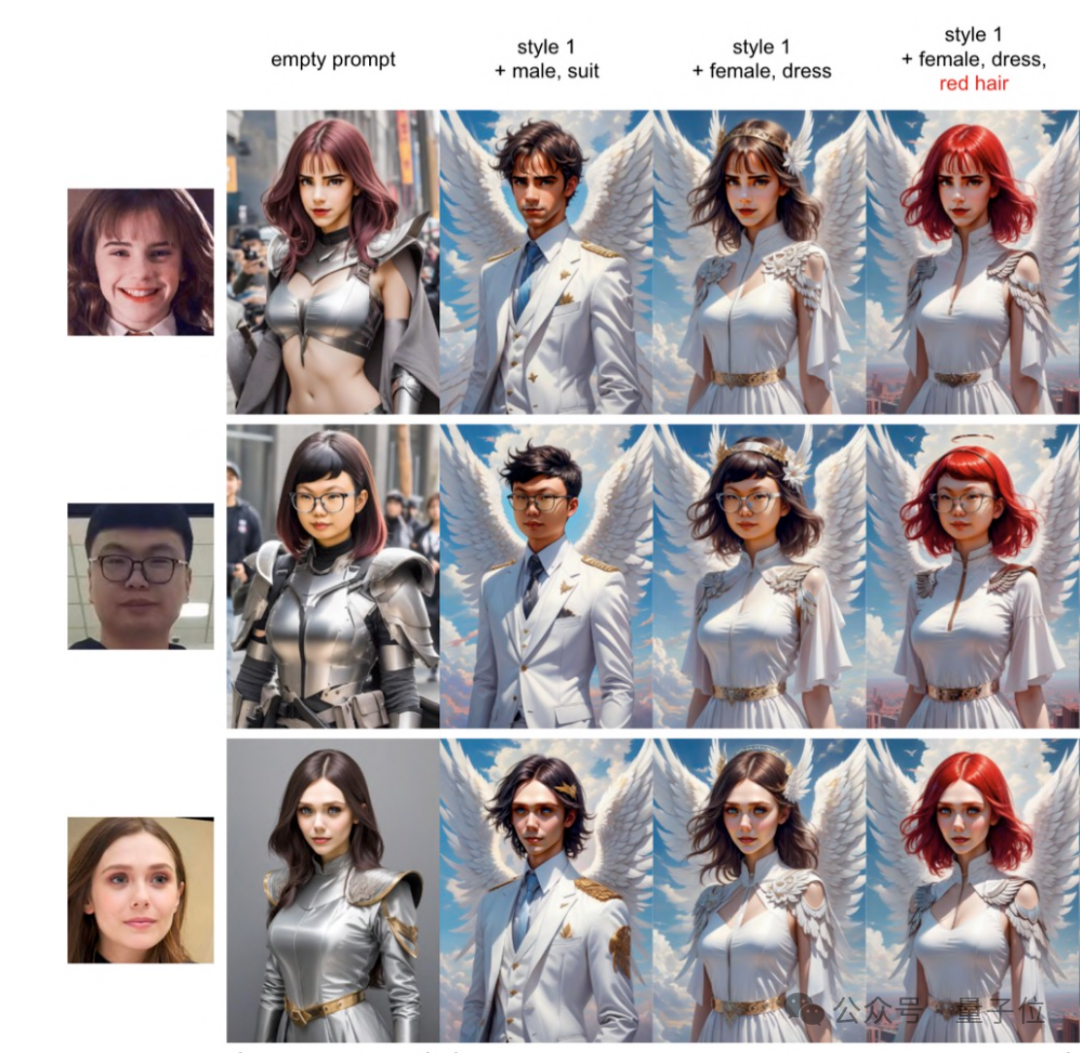

Une personne réelle n'a pas besoin d'apparaître devant la caméra et n'a pas à se soucier de la pose ou de la coiffure. Vous avez seulement besoin d'une image de vous-même, attendez quelques secondes, et vous pouvez obtenir 7 styles complètement différents :

InstantID.

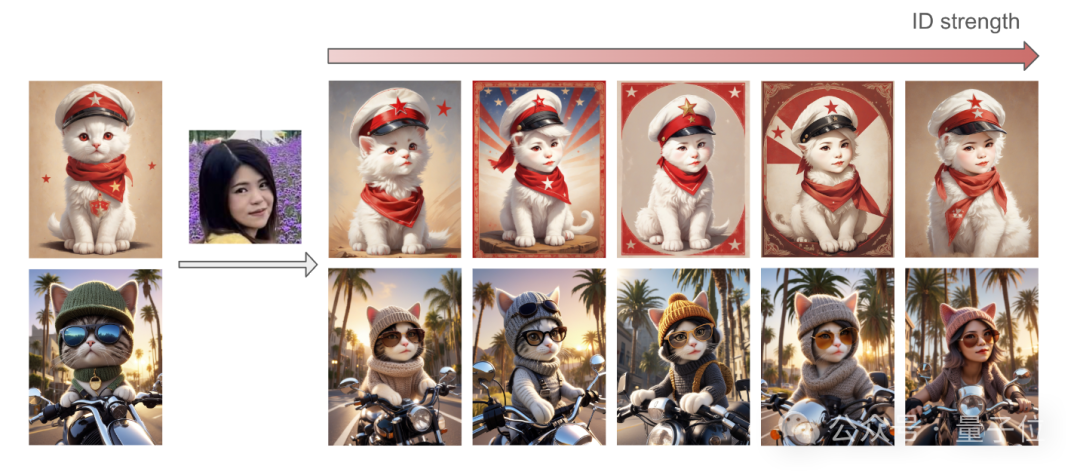

En plus des photos réalistes, il peut aussi être « non humain » : Par exemple, il a une tête et un corps de chat, mais si vous regardez bien, il a vos traits du visage.

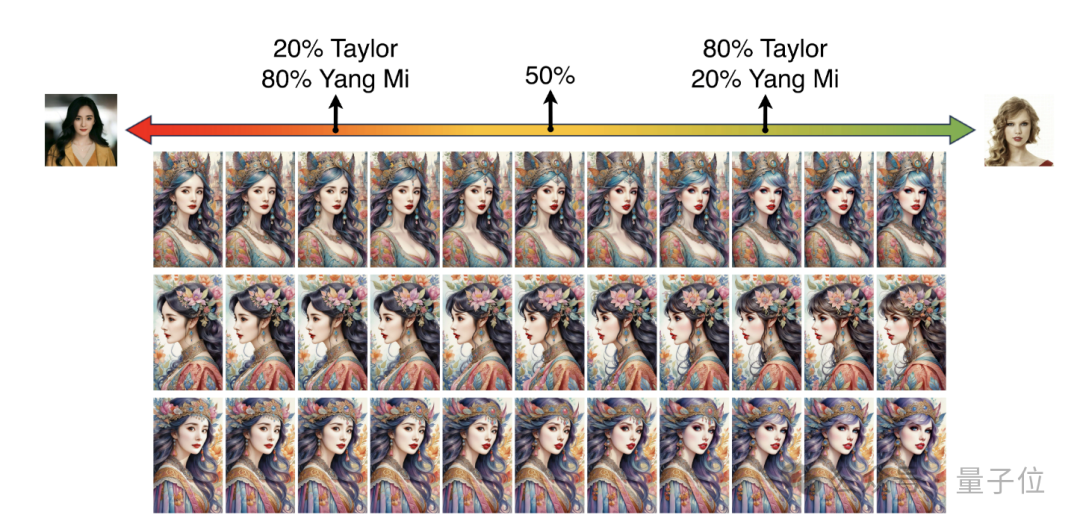

fusion de deux visages Voyez ce que 20% de Yang Mi +. 80% de Taylor ressemble à :

(c'est-à-dire basée sur l'intégration d'ID).

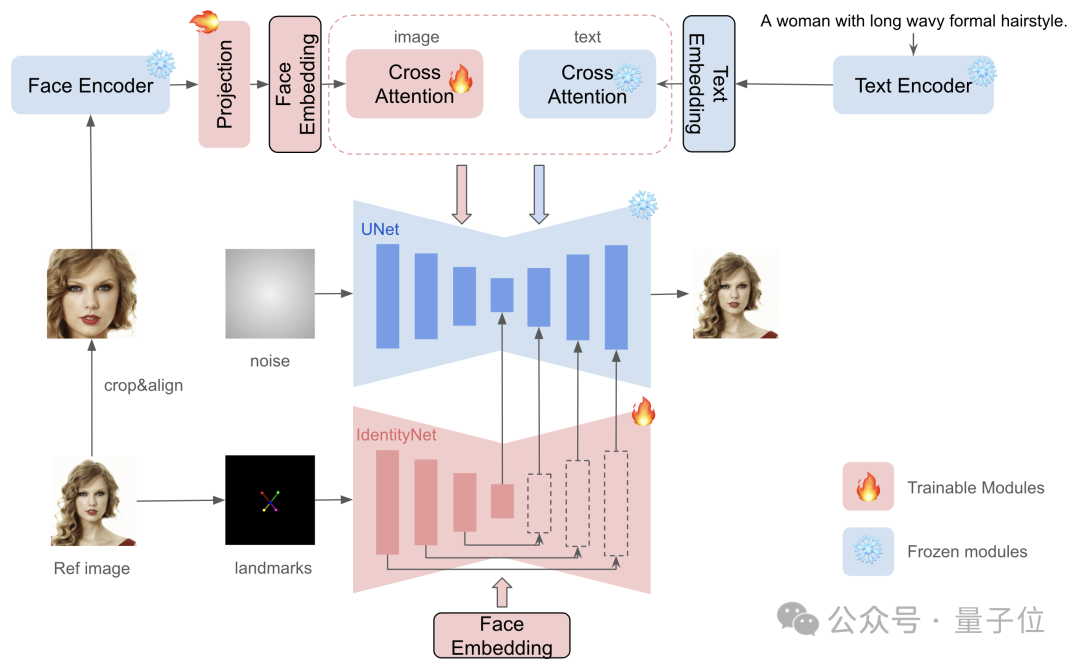

Mais cette technologie présente également des problèmes : soit elle nécessite un réglage approfondi de nombreux paramètres du modèle, soit elle manque de compatibilité avec les modèles pré-entraînés développés par la communauté, soit elle ne peut pas maintenir les traits du visage haute fidélité. Pour résoudre ces défis, ils ont développé InstantID. InstantID est construit sur la base du modèle de diffusion et son module plug-and-play peut gérer habilement diverses transformations stylisées avec une seule image faciale, tout en conservant une haute fidélité.La chose la plus remarquable est qu'il peut être intégré de manière transparente aux modèles de diffusion pré-entraînés texte-image populaires (tels que SD1.5, SDXL)

et utilisé comme plug-in.Plus précisément, InstantID se compose de trois composants clés :

(1) l'intégration d'identifiants qui capture des informations sémantiques robustes sur le visage (2) un module d'adaptation léger avec une attention croisée découplée, des images pratiques comme repères visuels ; Réseau IdentityNet, qui code les caractéristiques détaillées de l'image de référence grâce à un contrôle spatial supplémentaire, complétant ainsi la génération de l'image.Par rapport aux travaux antérieurs de l'industrie, InstantID présente plusieurs différences :

Premièrement, il n'est pas nécessaire de former UNet, donc la capacité de génération du modèle texte-image d'origine peut être conservée, et c'est compatible avec les modèles pré-entraînés existants et les modèles de la communauté ControlNet.

Encore une fois, tous les effets ci-dessus peuvent être réalisés en quelques secondes avec une seule image de référence.

Comme le montre l'expérience ci-dessous,

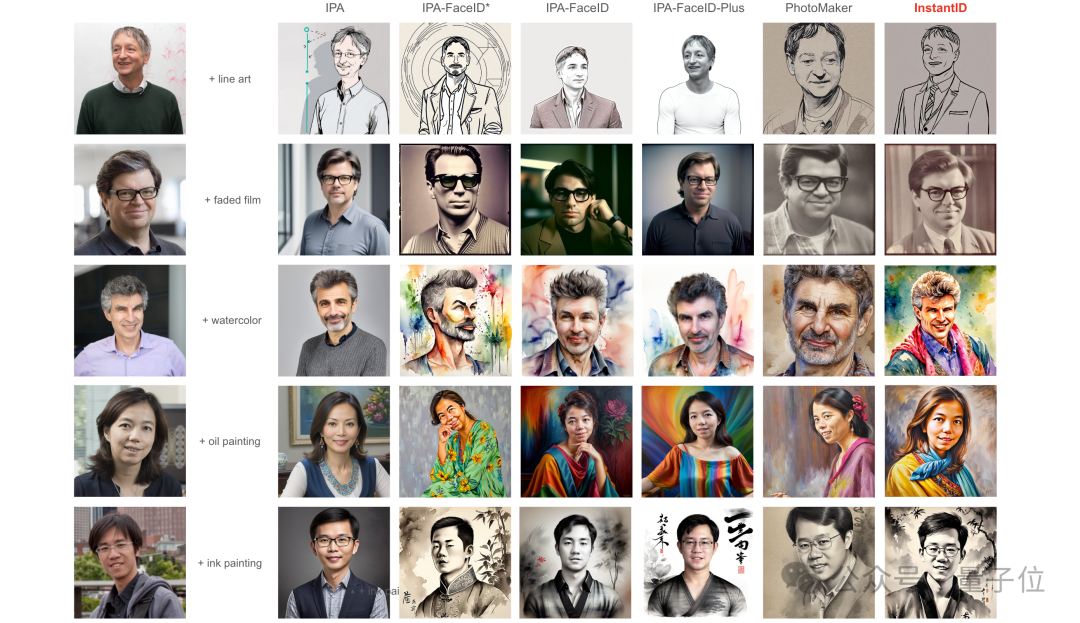

Voici quelques comparaisons spécifiques.

Les objets de comparaison sont les méthodes SOTA sans réglage existantes : IP-Adapter (IPA), IP-Adapter-FaceID et PhotoMaker, qui vient d'être produit par Tencent il y a deux jours.

Vous pouvez voir que tout le monde est assez "volume" et l'effet n'est pas mauvais - mais si vous les comparez attentivement, PhotoMaker et IP-Adapter-FaceID ont tous deux une bonne fidélité, mais leurs capacités de contrôle de texte sont évidemment pires.

En revanche, les visages et les styles d'InstantID se mélangent mieux, obtenant une meilleure fidélité tout en conservant une bonne éditabilité du texte.

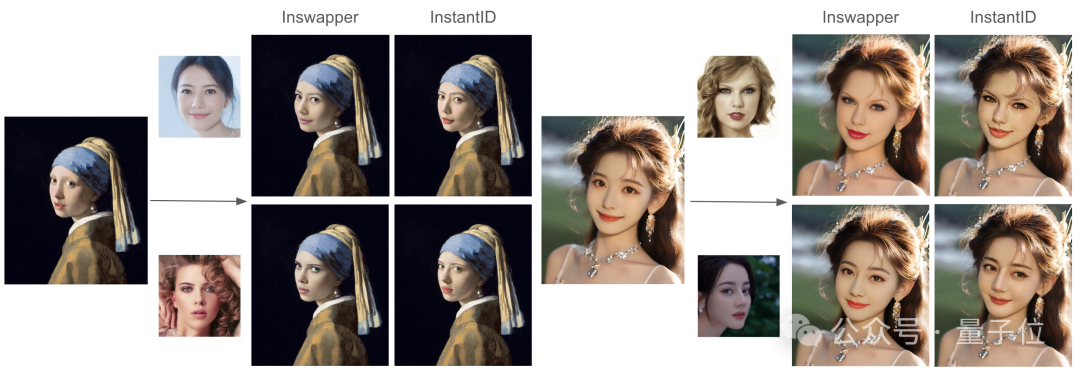

De plus, il existe également une comparaison avec le modèle InsightFace Swapper, lequel pensez-vous est le meilleur ?

Présentation de l'auteur

Il y a 5 auteurs dans cet article, issus de la mystérieuse équipe InstantX (peu d'informations peuvent être trouvées en ligne).

Mais l'un d'eux est Qixun Wang du Petit Livre Rouge.

L'auteur correspondant Wang Haofan est également ingénieur à Xiaohongshu. Il est engagé dans des recherches sur la génération de contenu contrôlable et conditionnelle (AIGC) et est un ancien élève de la CMU'20.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Quels sont les trois modèles de données de la base de données ?

- Comment additionner une colonne de données dans Excel

- Quelles sont les cinq méthodes d'analyse des données spss ?

- À quel modèle la structure du réseau à 7 couches fait-elle référence ?

- Comment ajouter et personnaliser des étiquettes de données dans les graphiques Microsoft Excel ?