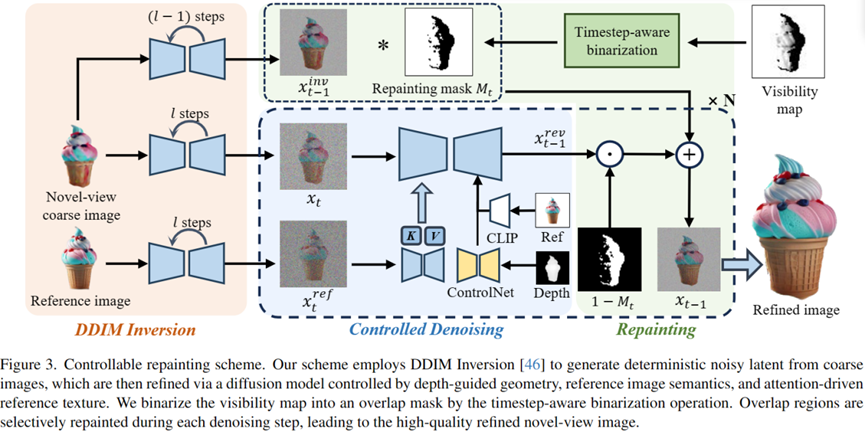

Maison >Périphériques technologiques >IA >Nouvelle technologie Repaint123 : Générez efficacement de la 3D à vue unique de haute qualité en seulement 2 minutes !

Nouvelle technologie Repaint123 : Générez efficacement de la 3D à vue unique de haute qualité en seulement 2 minutes !

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2024-01-08 19:06:44854parcourir

La méthode de conversion d'une image en 3D utilise généralement l'échantillonnage par distillation de score (SDS). Bien que les résultats soient impressionnants, il existe encore plusieurs défauts, notamment l'incohérence multi-vue, la sursaturation et les textures trop lisses. ainsi que des problèmes tels qu'une vitesse de génération lente.

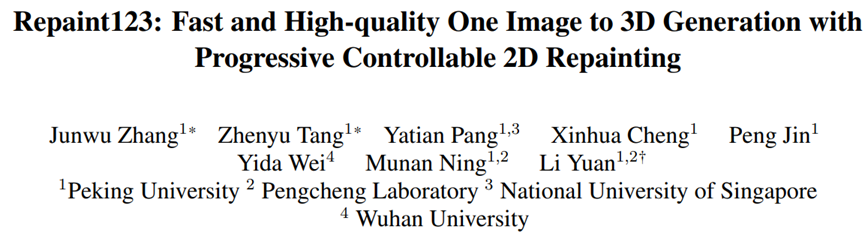

Pour résoudre ces problèmes, des chercheurs de l'Université de Pékin, de l'Université nationale de Singapour, de l'Université de Wuhan et d'autres institutions ont proposé Repaint123 pour atténuer le biais de vues multiples, la dégradation de la texture et accélérer le processus de génération.

Adresse papier : https://arxiv.org/pdf/2312.13271.pdf

GitHub : https://github.com/PKU-YuanGroup/repaint123

Adresse du projet : https ://pku-yuangroup.github.io/repaint123/

L'idée principale est de combiner les capacités de génération d'images du modèle de diffusion 2D avec les capacités d'alignement de texture pour produire des images multi-vues de haute qualité.

L'auteur propose en outre une intensité de redessin adaptative sensible à la visibilité pour améliorer la qualité de l'image générée.

Les images cohérentes multi-vues de haute qualité générées permettent une génération rapide de contenu 3D à l'aide d'une simple perte d'erreur quadratique moyenne (MSE).

L'auteur a prouvé expérimentalement que Repaint123 est capable de générer du contenu 3D de haute qualité en 2 minutes, avec une cohérence multi-vues et des textures fines.

Les principales contributions de l'article sont les suivantes :

1. Repaint123 considère de manière exhaustive le processus de redessinage contrôlable de l'image vers la génération 3D et peut générer des séquences d'images cohérentes de haute qualité sous plusieurs perspectives.

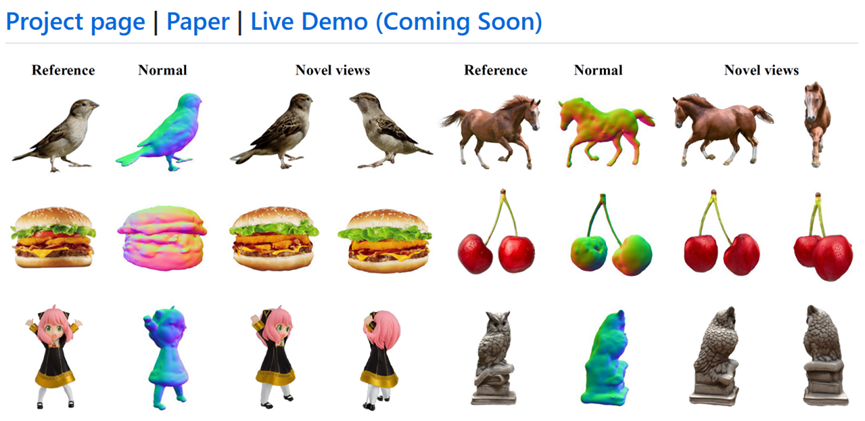

2. Repaint123 a proposé une ligne de base générée en 3D à vue unique Dans la phase de modèle grossier, Zero123 a été utilisé comme a priori 3D et comme perte SDS pour optimiser rapidement la géométrie d'éclaboussure gaussienne (1 minute). La diffusion a été utilisée comme préalable 2D et la perte SDS affine rapidement les textures de maillage (1 minute).

3. Des expériences approfondies ont vérifié l'efficacité de la méthode Repaint123, qui peut générer du contenu 3D correspondant à la qualité de la génération 2D à partir d'une seule image en seulement 2 minutes.

Figure 1 : Motivation du papier : génération 3D à vue unique rapide, cohérente et de haute qualité

Méthode spécifique :

Repaint123 Les principales améliorations se concentrent sur l'étape de raffinement du maillage, qui contient deux parties : génération cohérente de séquences d'images de haute qualité à partir de plusieurs perspectives et reconstruction 3D rapide et de haute qualité.

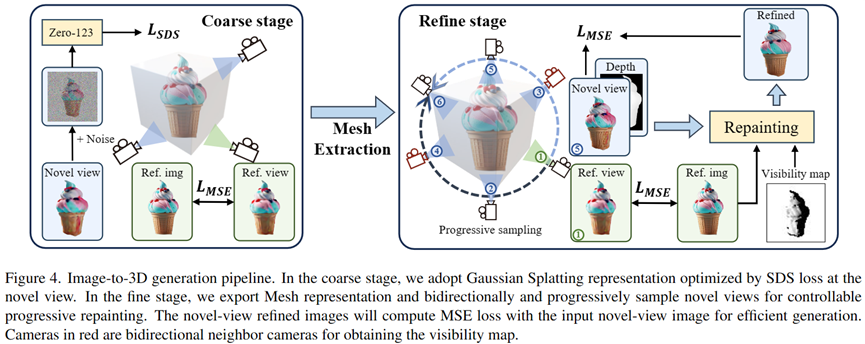

Au stade du modèle approximatif, l'auteur utilise l'éclaboussure gaussienne 3D comme représentation 3D, et la géométrie et la texture approximatives du modèle sont optimisées grâce à la perte SDS.

Dans la phase de raffinement, l'auteur convertit le modèle grossier en une représentation maillée et propose un schéma de redessin de raffinement de texture progressif et contrôlable.

Tout d'abord, les auteurs redessinent progressivement la zone invisible par rapport à la vue précédemment optimisée grâce au contrôle géométrique et au guidage à partir de l'image de référence, obtenant ainsi une image cohérente de la nouvelle vue.

Ensuite, les auteurs adoptent des repères d'image pour un guidage sans classificateur et conçoivent une stratégie de redessin adaptative pour améliorer encore la qualité de génération des régions qui se chevauchent.

Enfin, en générant des images de haute qualité et cohérentes, les auteurs exploitent une simple perte MSE pour générer rapidement du contenu 3D.

Génération de séquences d'images cohérentes de haute qualité multi-vues :

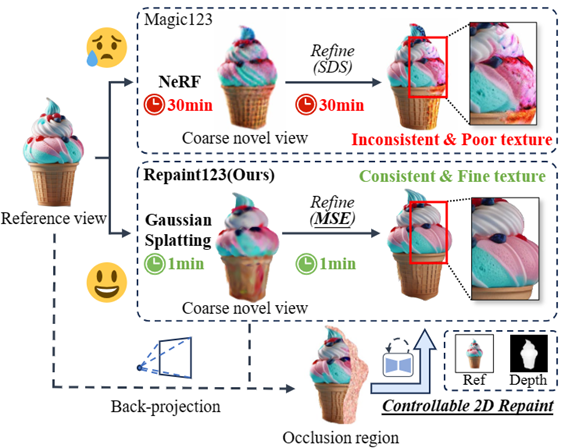

Comme le montre la figure 2, la génération de séquences d'images cohérentes de haute qualité multi-vues est divisée en quatre parties suivantes :

Figure 2 : Processus de génération d'image cohérent sous plusieurs perspectives

Inversion DDIM

Afin de préserver les informations de texture basse fréquence cohérentes en 3D générées au stade du modèle approximatif, l'auteur utilise l'inversion DDIM pour inverser l'image. à un certain latent pour le débruitage ultérieur Générer des images fidèles et cohérentes comme base.

Débruitage contrôlable

Afin de contrôler la cohérence de la géométrie et de la texture à longue portée, lors de l'étape de débruitage, l'auteur utilise ControlNet pour introduire la carte de profondeur du rendu grossier du modèle comme a priori géométrique, et injecte la fonction Attention de l'image de référence pour la texture migration.

Dans le même temps, afin d'effectuer des conseils sans classificateur pour améliorer la qualité de l'image, le document utilise CLIP pour encoder l'image de référence dans un réseau de débruitage d'invite d'image.

Obtenir un masque d'occlusion

Afin d'obtenir le masque d'occlusion Mn à partir de la nouvelle vue de l'image rendue In et de la carte de profondeur Dn, étant donné la vue de référence redessinée Vr de Ir et Dr, l'auteur First , en utilisant la profondeur Dr pour mettre à l'échelle les pixels 2D de Vr à un nuage de points 3D, puis en restituant le nuage de points 3D Pr à partir de la nouvelle perspective Vn, la carte de profondeur Dn' est obtenue.

L'auteur considère la zone avec des valeurs de profondeur différentes entre les deux nouvelles cartes de profondeur de vue (Dn et Dn') comme étant la zone d'occlusion dans le masque d'occlusion.

Repeindre progressivement les occlusions et les chevauchements

Afin de garantir que les zones qui se chevauchent de la séquence d'images et des images adjacentes sont alignées au niveau des pixels, l'auteur utilise une stratégie de repeinture locale progressive tout en conservant le chevauchement. zones inchangées Générez des zones adjacentes harmonieuses, et ainsi de suite depuis la perspective de référence à 360°.

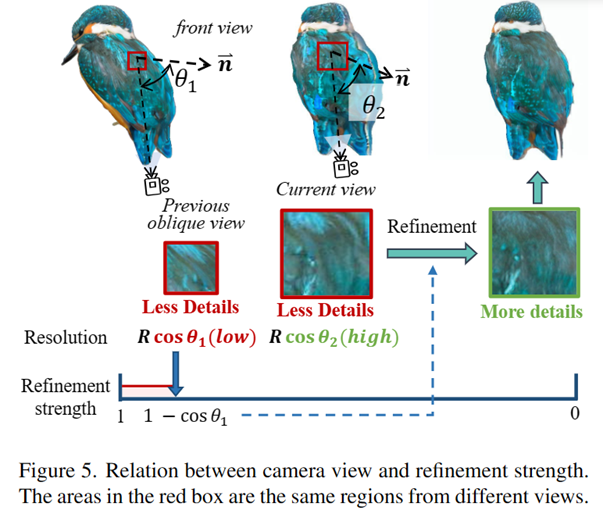

Cependant, comme le montre la figure 3, l'auteur a constaté que la zone de chevauchement doit également être affinée, car la résolution visuelle d'une zone précédemment strabisée devient plus grande lorsqu'on lui fait face directement, et davantage d'informations à haute fréquence doivent être ajoutées. .

Afin de choisir l'intensité d'amincissement appropriée pour assurer la fidélité tout en améliorant la qualité, l'auteur s'appuie sur le théorème de projection et l'idée de super-résolution d'image pour proposer une stratégie de redessinage simple et directe sensible à la visibilité pour affiner l'image. zone de chevauchement, et l'intensité de raffinement est égale à 1-cosθ* (où θ* est l'angle maximum entre tous les angles de caméra précédents et le vecteur normal de la surface visualisée), redessinant ainsi de manière adaptative la zone de chevauchement.

Figure 3 : La relation entre l'angle de la caméra et l'intensité de l'amincissement

Reconstruction 3D rapide et de haute qualité :

Comme le montre la figure 4, l'auteur adopte une méthode en deux étapes, d'abord en utilisant la représentation Gaussian Splatting pour générer rapidement une géométrie raisonnable et des textures rugueuses. Dans le même temps, avec la séquence d'images cohérentes de haute qualité générée ci-dessus sous plusieurs perspectives, l'auteur a pu utiliser une simple perte MSE pour une reconstruction rapide de texture 3D.

Figure 4 : Cadre de génération 3D à vue unique en deux étapes Repaint123

Résultats expérimentaux

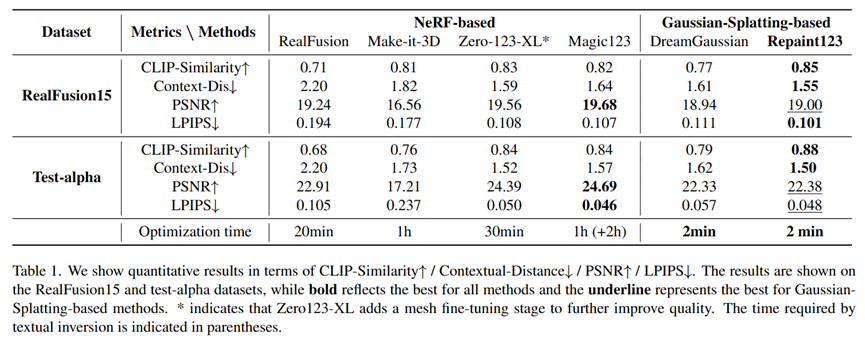

L'auteur a comparé plusieurs méthodes de tâches de génération à vue unique et a obtenu une cohérence sur les ensembles de données RealFusion15 et Test-alpha. effets les plus avancés en termes de qualité et de rapidité.

Comparaison visuelle de la génération 3D à vue unique

Comparaison quantitative de la génération 3D à vue unique

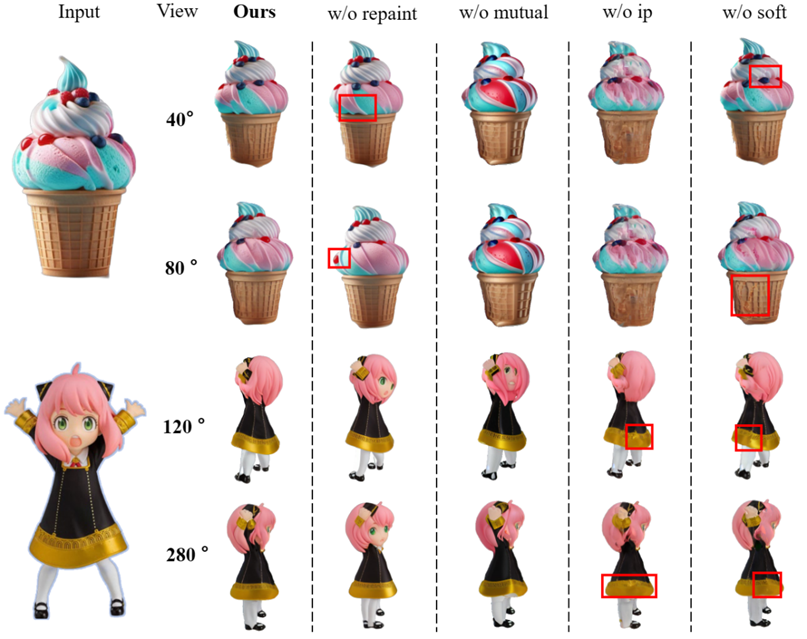

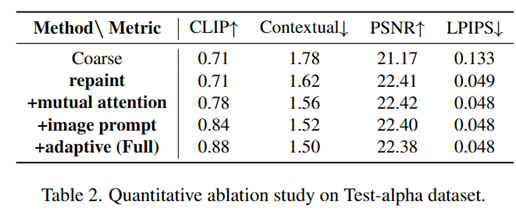

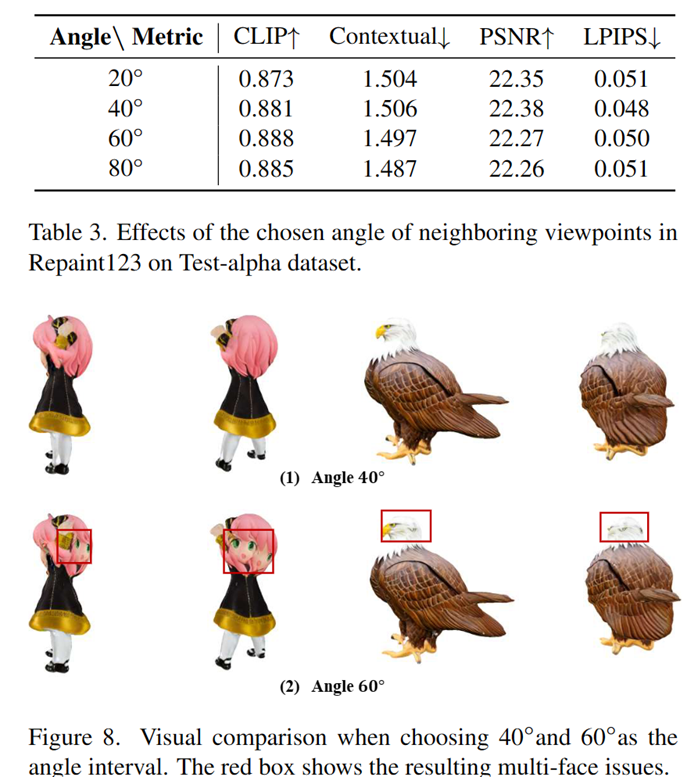

Expérience d'ablation

En même temps , l'auteur a également utilisé l'efficacité de chaque module et l'incrément de rotation de l'angle de vision pour des expériences d'ablation :

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- La différence entre has et with dans le modèle d'association Laravel (introduction détaillée)

- Quel est le modèle de boîte CSS ?

- Qu'est-ce qu'un pôle de formation en IA ?

- Quels sont les quatre modèles courants de développement de logiciels ?

- NUS et Byte ont collaboré de manière intersectorielle pour obtenir une formation 72 fois plus rapide grâce à l'optimisation des modèles, et ont remporté le prix AAAI2023 Outstanding Paper.