Maison >Périphériques technologiques >IA >Ali innove encore : vous pouvez réaliser la danse de « Nettoyer la vitre » avec une phrase et un visage humain, et le costume et le fond peuvent être changés librement !

Ali innove encore : vous pouvez réaliser la danse de « Nettoyer la vitre » avec une phrase et un visage humain, et le costume et le fond peuvent être changés librement !

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-12-15 12:39:161108parcourir

Un autre article d'Alibaba intitulé "Dance Work" a fait sensation après AnimateAnyone

Maintenant, téléchargez simplement une photo de visage et une simple description, et vous pouvez danser n'importe où !

Par exemple, la vidéo de danse de "Cleaning the Glass" ci-dessous :

Photo

Photo

Tout ce que vous avez à faire est de télécharger une photo de portrait et de remplir les informations correspondantes

Dans les feuilles dorées de l'automne, une fille Portez une robe bleu clair et dansez avec le sourire

À mesure que les invites changent, l'arrière-plan et les vêtements du personnage changeront en conséquence. Par exemple, nous pouvons modifier quelques phrases supplémentaires :

Une fille sourit et danse dans une maison en bois. Elle porte un pull et un pantalon.

Une fille sourit et danse à Times Square, vêtue d'une chemise blanche ressemblant à une robe. avec un pantalon long. Manches, pantalon.

Photos

Photos

Il s'agit de la dernière recherche d'Ali - DreaMoving, qui vise à permettre à chacun de danser à tout moment et n'importe où.

images

images

Et non seulement de vraies personnes, mais aussi des personnages de dessins animés et d'animation peuvent être détenus~

images

images

Dès que le projet est sorti, il a également attiré l'attention de nombreux internautes. les gens sont Après avoir vu l'effet, je l'ai appelé "Incroyable" ~

photo

photo

Alors, comment ce résultat a-t-il été obtenu ? Comment cette recherche a-t-elle été menée ?

Le principe derrière

Bien que l'avènement des modèles texte-vidéo (T2V) tels que Stable Video Diffusion et Gen2 ait réalisé des avancées majeures dans le domaine de la génération vidéo, il est toujours confronté à de nombreux défis

Par exemple, en termes d'ensembles de données, il existe actuellement un manque d'ensembles de données vidéo de danse humaine open source et des difficultés à obtenir des descriptions textuelles précises correspondantes, ce qui rend difficile pour les modèles de générer des vidéos avec une diversité, une cohérence d'image et une durée plus longue. Et dans le domaine de la génération de contenu centré sur l’humain, la personnalisation et la contrôlabilité des résultats générés sont également des facteurs clés.

Photos Afin de relever ces deux défis, l'équipe d'Alibaba a d'abord commencé à traiter l'ensemble de données

Afin de relever ces deux défis, l'équipe d'Alibaba a d'abord commencé à traiter l'ensemble de données

Les chercheurs ont d'abord collecté environ 1 000 vidéos de danse humaine de haute qualité sur Internet. Ensuite, ils ont découpé ces vidéos en environ 6000 courtes vidéos (8 à 10 secondes chacune) pour s'assurer qu'il n'y a pas de transitions et d'effets spéciaux dans les clips vidéo, ce qui est propice à l'entraînement du modèle temporel

De plus, afin pour générer des descriptions textuelles des vidéos, ils ont utilisé Minigpt-v2 comme sous-titreur vidéo (sous-titreur vidéo), en utilisant spécifiquement la version "grounding". L'instruction est de décrire l'image en détail.

En générant des sous-titres basés sur l'image centrale de l'image clé, le thème et le contenu de l'arrière-plan du clip vidéo peuvent être décrits avec précision

En termes de cadre, l'équipe Alibaba a proposé un modèle appelé DreaMoving basé sur la diffusion stable.

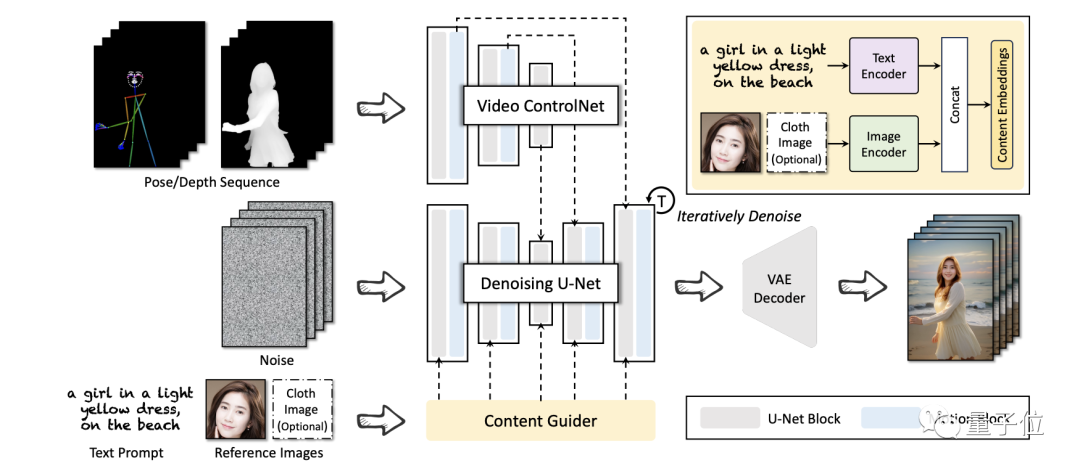

Il est principalement composé de trois réseaux de neurones, dont Denoising U-Net, Video ControlNet et Content Guider.

photos Parmi eux, Video ControlNet est un réseau de contrôle d'image injecté dans Motion Block après chaque bloc U-Net, traitant la séquence de contrôle (pose ou profondeur) en résidus temporels supplémentaires Denoising U-Net est un U-Net à diffusion stable dérivé , avec des blocs de mouvement pour la génération vidéo. Le Content Guider transmet des invites de saisie de texte et des expressions d'apparence (telles que des visages) au contenu intégré. En faisant cela, DreaMoving est capable de générer des vidéos de haute qualité et haute fidélité, mais très malheureusement, il n'existe actuellement aucun code open source pour le projet DreaMoving. Pour ceux que cela intéresse, vous pouvez d'abord y prêter attention et attendre la sortie du code open source~ Veuillez vous référer au lien suivant : [1]https://dreamoving.github.io/dreamoving/ [2]https://arxiv.org/abs/2312.05107[3]https://twitter.com/ProperPrompter/status/1734192772465258499[4]https://github.com/dreamoving/dreamoving-project

images

images

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Comment créer un projet en langage C avec vscode

- Comment déployer un projet php sous nginx

- En réexaminant le problème d'optimisation de Prompt, le biais de prédiction renforce l'apprentissage du contexte du modèle de langage

- Ajustement efficace des paramètres des modèles de langage à grande échelle - Série de réglage fin BitFit/Prefix/Prompt