Maison >Périphériques technologiques >IA >En réexaminant le problème d'optimisation de Prompt, le biais de prédiction renforce l'apprentissage du contexte du modèle de langage

En réexaminant le problème d'optimisation de Prompt, le biais de prédiction renforce l'apprentissage du contexte du modèle de langage

- 王林avant

- 2023-04-04 11:40:011429parcourir

Les LLM ont obtenu de bonnes performances dans le cadre de l'apprentissage en contexte, mais choisir des exemples différents conduira à des performances complètement différentes. Un travail de recherche récent propose une stratégie de recherche rapide du point de vue du biais prédictif, et trouve approximativement la combinaison optimale d'exemples.

- Lien papier : https://arxiv.org/abs/2303.13217

- Lien code : https://github.com/MaHuanAAA/g_fair_searching

Introduction à la recherche

Grand modèle de langage dans l'apprentissage en contexte Démonstration Grâce à leur incroyable capacité, ces modèles peuvent apprendre à partir d'un contexte construit à partir de quelques exemples d'entrées et de sorties et être directement appliqués à de nombreuses tâches en aval sans optimisation fine. Cependant, des recherches antérieures ont montré que l'apprentissage contextuel peut présenter un degré élevé d'instabilité en raison de changements dans les exemples de formation, l'ordre des exemples et les formats d'invite. Par conséquent, la construction d’invites appropriées est cruciale pour améliorer les performances de l’apprentissage contextuel.

Les recherches précédentes étudient généralement cette question sous deux angles : (1) réglage rapide dans l'espace de codage (réglage rapide), (2) recherche dans l'espace d'origine (recherche rapide).

L'idée clé du réglage Prompt est d'injecter des intégrations spécifiques à une tâche dans des calques cachés, puis d'utiliser une optimisation basée sur le dégradé pour ajuster ces intégrations. Cependant, ces méthodes nécessitent de modifier le processus d'inférence original du modèle et d'obtenir le gradient du modèle, ce qui n'est pas pratique dans les services LLM boîte noire comme GPT-3 et ChatGPT. De plus, le réglage des indices introduit des coûts de calcul et de stockage supplémentaires, qui sont généralement coûteux pour le LLM.

Une approche plus réalisable et plus efficace consiste à optimiser les invites en recherchant dans l'espace de texte d'origine des échantillons et des séquences de démonstration approximatifs. Certains travaux génèrent des invites à partir de la « Vue globale » ou de la « Vue locale ». Les méthodes basées sur une vue globale optimisent généralement les différents éléments de l'invite dans son ensemble pour obtenir de meilleures performances. Par exemple, les approches guidées par la diversité [1] exploitent la diversité globale des démonstrations pour la recherche, ou tentent d'optimiser l'ensemble de l'ordre de combinaison d'échantillons [2] pour obtenir de meilleures performances. Contrairement à la vue globale, les méthodes basées sur la vue locale fonctionnent en concevant différents critères de sélection heuristiques, tels que KATE [3].

Mais ces méthodes ont leurs propres limites : (1) La plupart des recherches actuelles se concentrent principalement sur la recherche d'indices en fonction d'un seul facteur, tel que la sélection ou l'ordre des exemples. Cependant, l’impact global de chaque facteur sur la performance n’est pas clair. (2) Ces méthodes sont généralement basées sur des critères heuristiques et nécessitent une perspective unifiée pour expliquer leur fonctionnement. (3) Plus important encore, les méthodes existantes optimisent les indices globalement ou localement, ce qui peut conduire à des performances insatisfaisantes.

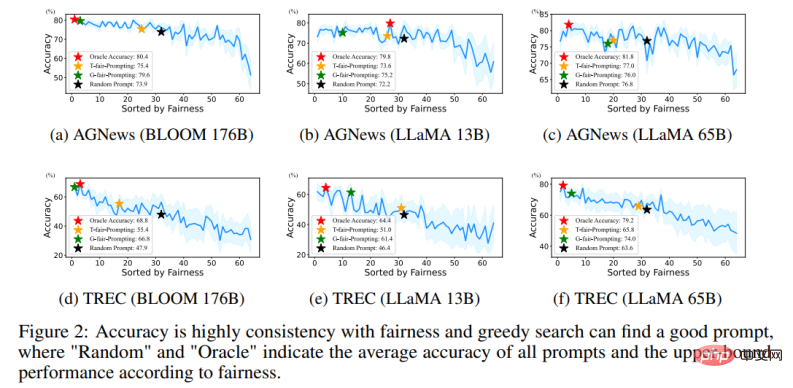

Cet article réexamine le problème de l'optimisation des invites dans le domaine de la PNL du point de vue du « biais de prédiction » et découvre un phénomène clé : la qualité d'une invite donnée dépend de son biais inhérent. Sur la base de ce phénomène, l'article propose un critère alternatif pour évaluer la qualité des invites basé sur le biais de prédiction. Cette métrique peut évaluer les invites via un seul processus direct sans avoir besoin d'un ensemble de développement supplémentaire.

Plus précisément, en saisissant un test « sans contenu » à une invite donnée, le modèle est censé générer une distribution de prédiction uniforme (une entrée « sans contenu » ne contient aucune information utile). Par conséquent, l’uniformité de la distribution de prédiction est utilisée dans cet article pour représenter l’écart de prédiction d’une invite donnée. Ceci est similaire à la métrique utilisée par la méthode de post-étalonnage précédente [4], mais contrairement au post-étalonnage qui utilise cette métrique pour un post-étalonnage probabiliste sous une invite fixe, l'article explore plus en détail son application dans la recherche automatique d'invites approximatives. Et grâce à des expériences approfondies, nous avons confirmé la corrélation entre le biais inhérent à une invite donnée et sa performance moyenne à une tâche sur un ensemble de tests donné.

De plus, cette métrique basée sur les biais permet à la méthode de rechercher des invites appropriées d'une manière « locale à globale ». Cependant, un problème réaliste est qu’il n’est pas possible de rechercher la solution optimale en parcourant toutes les combinaisons car sa complexité dépasserait O (N !).

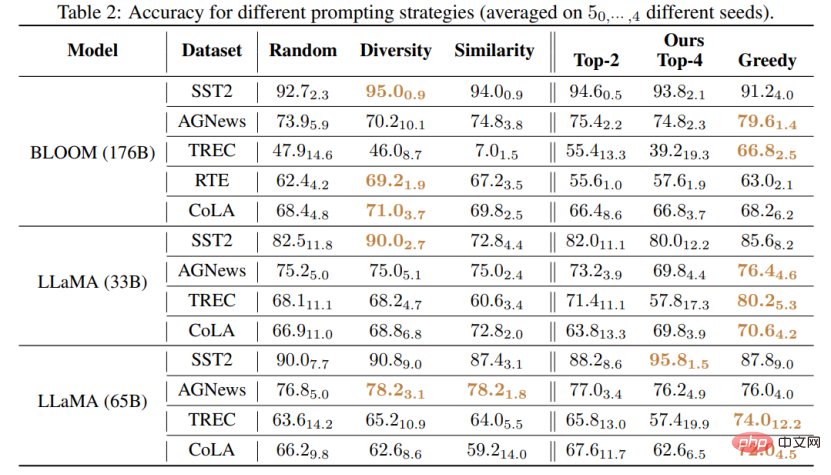

Ce travail propose deux nouvelles stratégies pour rechercher des invites de haute qualité de manière efficace : (1) T-fair-Prompting (2) G-fair-Prompting. T-fair-Prompting utilise une approche intuitive, calculant d'abord l'écart de chaque exemple individuellement pour former une invite, puis sélectionnant les exemples Top-k les plus justes à combiner dans l'invite finale. Cette stratégie est assez efficace, de complexité O (N). Mais il convient de noter que T-fair-Prompting repose sur l’hypothèse que l’invite optimale est généralement construite à partir des exemples les moins biaisés. Cependant, cela peut ne pas être vrai dans des situations pratiques et conduit souvent à des solutions locales optimales. Par conséquent, G-fair-Prompting est présenté davantage dans l'article pour améliorer la qualité de la recherche. G-fair-Prompting suit le processus régulier de recherche gourmande pour trouver la solution optimale en faisant des choix optimaux locaux à chaque étape. À chaque étape de l'algorithme, des exemples sont sélectionnés de telle sorte que l'invite mise à jour atteigne une équité optimale avec une complexité temporelle dans le pire des cas de O (N^2), améliorant considérablement la qualité de la recherche. G-fair-Prompting fonctionne dans une perspective locale vers globale, où le biais des échantillons individuels est pris en compte dès les premières étapes, tandis que les étapes ultérieures se concentrent sur la réduction du biais de prédiction global.

Résultats expérimentaux

Cette étude propose une méthode efficace et interprétable pour améliorer les performances d'apprentissage contextuel des modèles de langage, qui peut être appliquée à diverses tâches en aval. L'article vérifie l'efficacité de ces deux stratégies sur divers LLM (y compris la série de modèles GPT et la série LMaMA récemment publiée). Par rapport à la méthode SOTA, G-fair-Prompting a obtenu plus de 10 % d'amélioration relative sur différentes tâches en aval. .

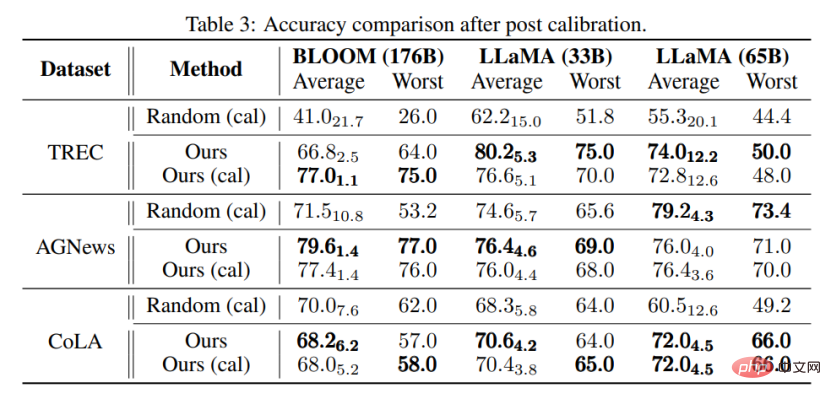

Ce qui se rapproche le plus de cette recherche est la méthode Calibration-before-use [4], qui utilisent toutes deux une entrée « sans contenu » pour améliorer les performances du modèle. Cependant, la méthode d'étalonnage avant utilisation est conçue pour utiliser cette norme pour calibrer la sortie, ce qui reste sensible à la qualité des exemples utilisés. En revanche, cet article vise à parcourir l'espace d'origine pour trouver une invite presque optimale pour améliorer les performances du modèle sans aucun post-traitement de la sortie du modèle. De plus, cet article est le premier à démontrer, par des expériences approfondies, le lien entre le biais de prédiction et la performance finale de la tâche, qui n'a pas encore été étudié dans les méthodes d'étalonnage avant utilisation.

On peut également constater grâce à des expériences que même sans calibrage, l'invite sélectionnée par la méthode proposée dans cet article peut être meilleure que l'invite calibrée sélectionnée au hasard. Cela montre que la méthode peut être pratique et efficace dans des applications pratiques et peut servir d’inspiration pour de futures recherches sur le traitement du langage naturel.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI