Maison >Périphériques technologiques >IA >Nouvelle idée de détection Range View3D : RangePerception

Nouvelle idée de détection Range View3D : RangePerception

- 王林avant

- 2023-12-14 16:57:461437parcourir

Titre réécrit : Range Awareness : Taming LiDAR Range View for Efficient and Accurate 3D Object Detection

Veuillez cliquer sur le lien suivant pour consulter l'article : https://openreview.net/pdf?id=9kFQEJSyCM

Affiliation de l'auteur : Shanghai Artificial Laboratoire de renseignement Université de Fudan Après réécriture : Unité : Laboratoire d'Intelligence Artificielle de Shanghai, Université de Fudan

Idée de thèse :

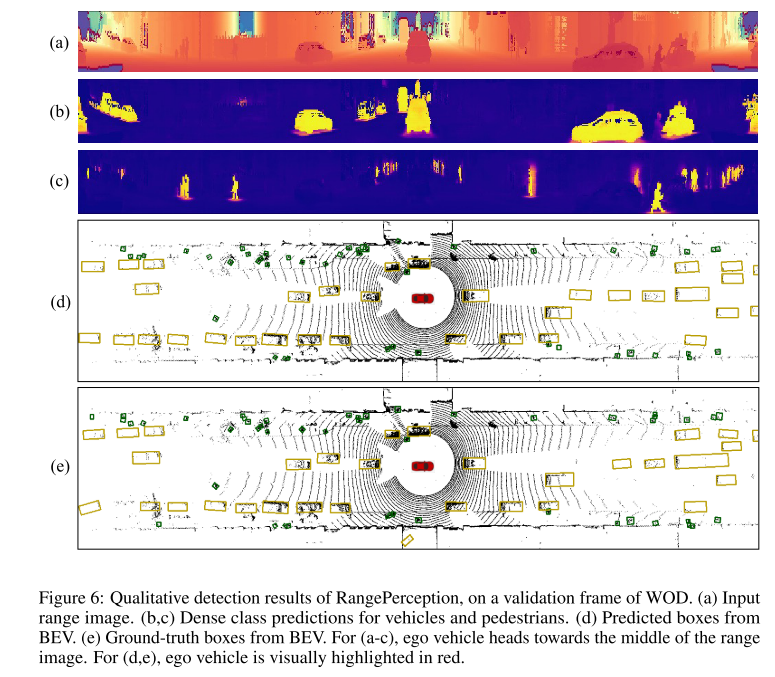

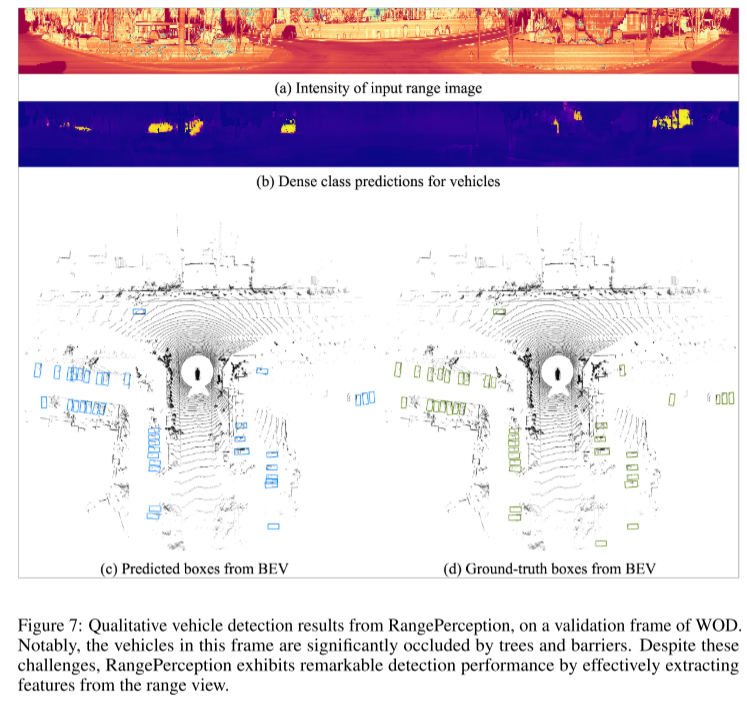

Actuellement, les méthodes de détection 3D basées sur LiDAR utilisent principalement la vue à vol d'oiseau (BEV) ou la vue à distance (RV) comme base . Les méthodes BEV reposent sur la voxélisation et la convolution 3D, ce qui entraîne des processus de formation et d'inférence moins efficaces. En revanche, la méthode RV présente une efficacité plus élevée en raison de sa compacité et de sa compatibilité avec les convolutions 2D, mais ses performances sont encore en retard par rapport à la méthode BEV. Pour éliminer l'écart de performances tout en maintenant l'efficacité de la méthode RV, cette étude propose un cadre de détection d'objets 3D efficace et précis basé sur RV appelé RangePerception. Grâce à une analyse minutieuse, cette étude identifie deux défis clés qui entravent les performances des méthodes RV existantes : 1) Il existe un écart de domaine naturel entre les coordonnées du monde 3D utilisées dans la sortie et les coordonnées de l'image de plage 2D utilisées dans l'entrée, ce qui conduit à un changement de distance Il devient difficile d'extraire des informations à partir des images ; 2) L'image de distance d'origine présente des problèmes de dommages visuels, ce qui affecte la précision de détection des cibles situées au bord de l'image de distance. Pour relever ces défis, cet article propose deux nouveaux algorithmes nommés Range Aware Kernel (RAK) et Vision Restoration Module (VRM), qui facilitent le flux d'informations sur la représentation des images de distance et les résultats de détection 3D des coordonnées mondiales. Avec l'aide de RAK et VRM, RangePerception améliore l'AP L1/L2 moyen de 3,25/4,18 par rapport à la précédente méthode RV de pointe RangeDet sur Waymo Open Dataset. RangePerception est la première méthode de détection 3D basée sur RV Par rapport à la célèbre méthode CenterPoint basée sur BEV, son AP moyen est légèrement plus élevé et la vitesse d'inférence est 1,3 fois celle de CenterPoint. démontre un cadre de détection 3D efficace et précis basé sur RV appelé RangePerception. Pour surmonter les principaux défis ci-dessus, deux nouveaux algorithmes nommés Range Aware Kernel (RAK) et Vision Restoration Module (VRM) sont proposés et intégrés dans le cadre RangePerception, qui facilitent tous deux la représentation des images de distance et le flux d'informations 3D de coordination mondiale des résultats des tests. Avec l'aide de RAK et VRM, notre RangePerception atteint des performances de pointe en tant que méthode de détection 3D basée sur une vue de portée en fournissant 73,62, 80,24 et 70,33 L1 3D AP sur WOD pour les véhicules, les piétons et les cyclistes. Les contributions de cet article sont les suivantes.

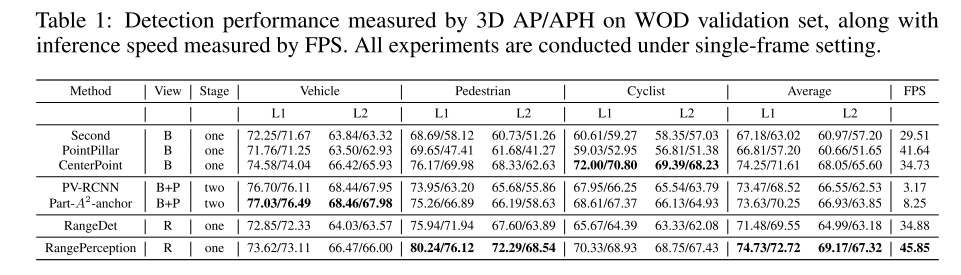

RangePerception Framework. Cet article présente un nouveau framework de détection 3D hautes performances appelé RangePerception. RangePerception est le premier détecteur 3D basé sur RV, atteignant un AP L1/L2 moyen de 74,73/69,17 sur WOD, ce qui est meilleur que le précédent détecteur RV de pointe RangeDet, qui avait une L1/L2 moyenne. AP de 71,48/ 64,99, montrant une amélioration de 3,25/4,18. RangePerception montre également des performances légèrement supérieures par rapport à la méthode largement utilisée basée sur BEV CenterPoint [6], qui atteint un AP L1/L2 moyen de 74,25/68,04. Notamment, la vitesse d’inférence de RangePerception est 1,3 fois plus rapide que celle de CenterPoint, ce qui prouve qu’il est plus adapté au déploiement en temps réel sur des véhicules autonomes.

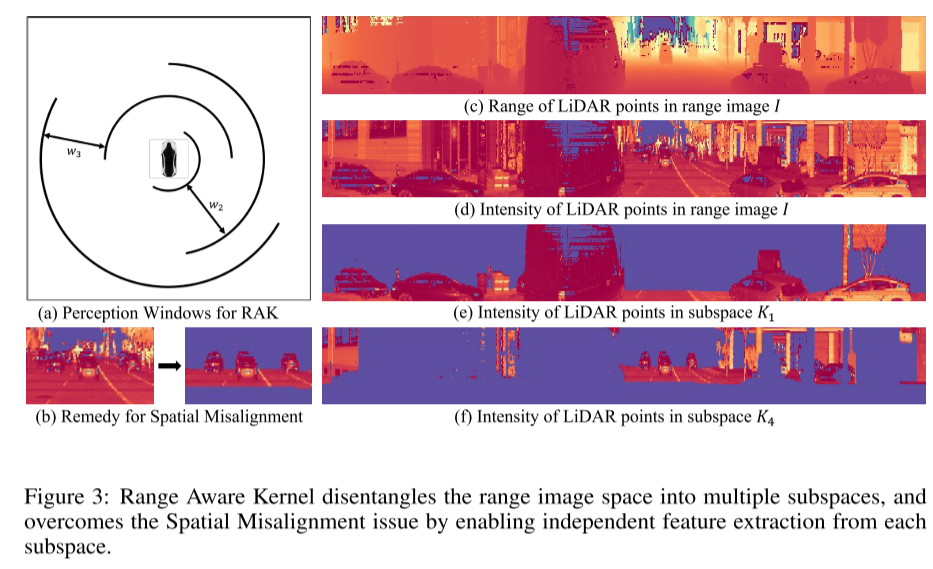

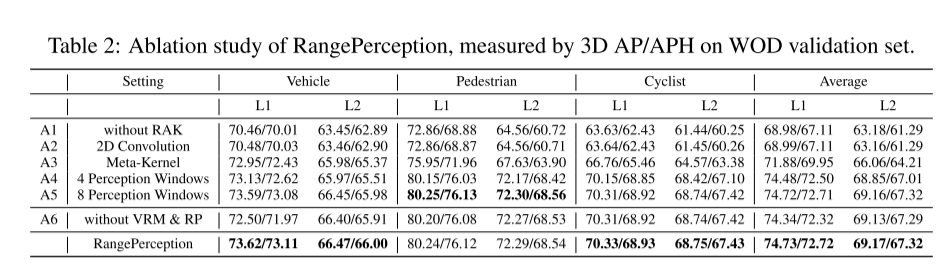

Range Aware KernelParti de l'extracteur de fonctionnalités RangePerception, le Range Aware Kernel (RAK) est un algorithme révolutionnaire conçu pour les réseaux basés sur RV. RAK décompose l'espace d'image de plage en plusieurs sous-espaces et surmonte le problème de désalignement spatial en extrayant indépendamment les caractéristiques de chaque sous-espace. Les résultats expérimentaux montrent que RAK améliore le AP L1/L2 moyen de 5,75/5,99 avec un coût de calcul négligeable.

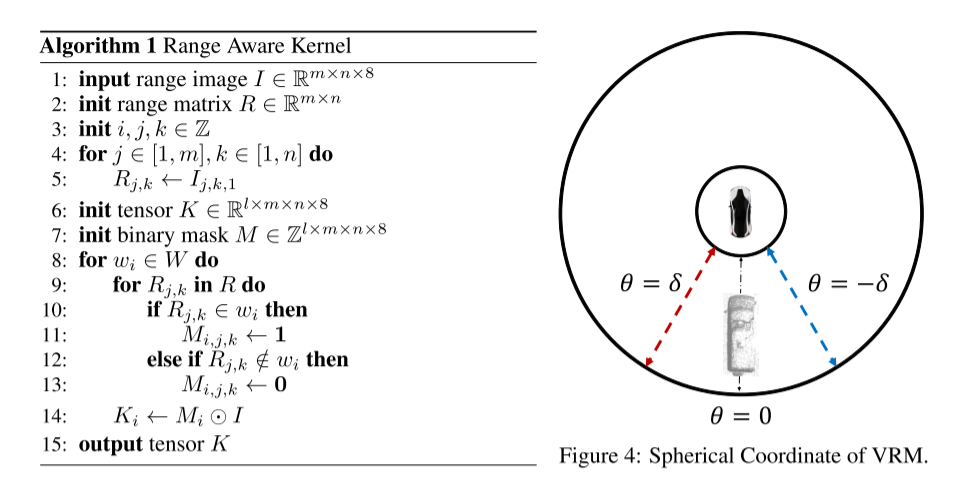

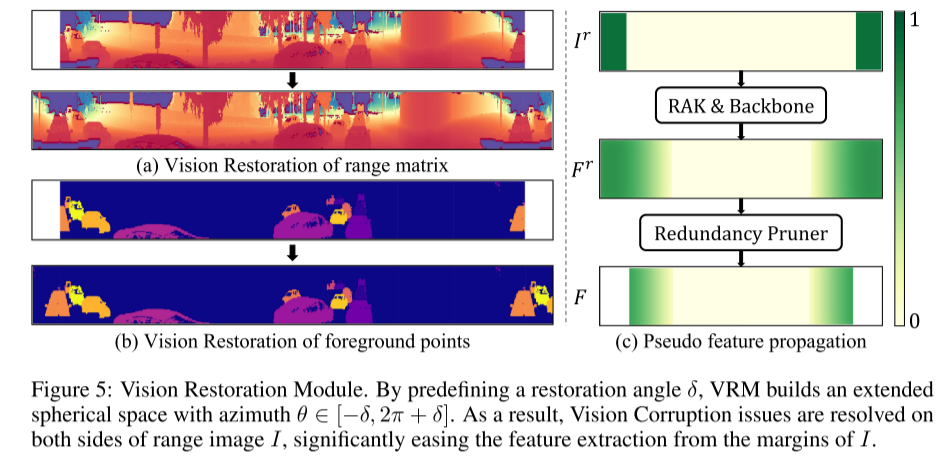

Module de restauration de la vision.Afin de résoudre le problème de corruption de la vision (Vision Corruption issue), cette recherche propose le Module de restauration de la vision (VRM). VRM étend le champ de réception du réseau fédérateur en restaurant les zones précédemment endommagées. VRM est particulièrement utile pour la détection de véhicules, comme le montre la section expérimentale.

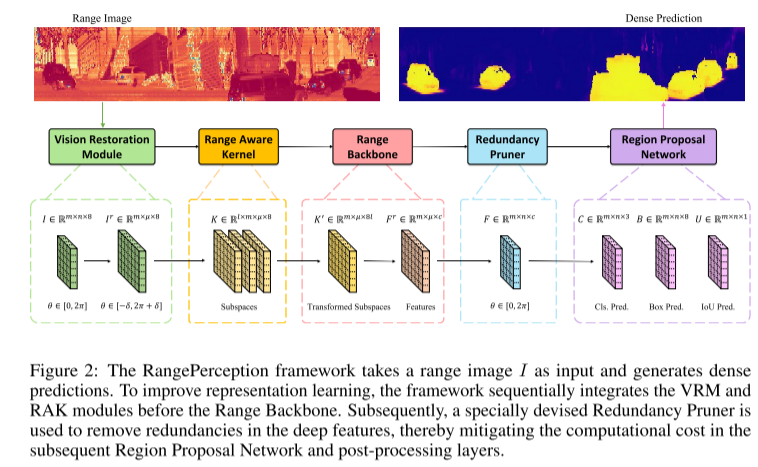

Figure 2 : Le framework RangePerception prend une image de plage I en entrée et génère des prédictions denses. Afin d'améliorer l'effet d'apprentissage de la représentation, le framework intègre les modules VRM et RAK en séquence avant Range Backbone. Ensuite, un élagueuse de redondance spécialement conçu est utilisé pour éliminer la redondance dans les fonctionnalités profondes, réduisant ainsi le coût de calcul du réseau de proposition de région ultérieur et des couches de post-traitement

Figure 1 : (a-d) Exemples d'images du signal LiDAR supérieur, représentés respectivement par RV et BEV. (e) Phénomènes de désalignement spatial. (f) Phénomènes de corruption de la vision.

Figure 3 : Range Aware Kernel décompose l'espace d'image de plage en plusieurs sous-espaces et surmonte le problème de désalignement spatial en extrayant des caractéristiques indépendantes de chaque sous-espace.

Figure 5 : Module de restauration de la vision. En prédéfinissant l'angle de récupération δ, VRM construit un espace sphérique étendu avec des angles d'azimut θ ∈ [−δ, 2π + δ]. Par conséquent, le problème de corruption visuelle des deux côtés de l’image de distance I est résolu, simplifiant considérablement le processus d’extraction de caractéristiques à partir des bords de I.

Résultats expérimentaux :

Résumé :

Cet article explique RangePerception, un cadre de détection tridimensionnelle basé sur RV qui peut résoudre efficacement les erreurs spatiales. inflammation et dommages visuels énigme. En introduisant les technologies RAK et VRM, RangePerception a démontré d'excellentes capacités de détection sur WOD, tout en démontrant également son potentiel de déploiement pratique efficace et précis

Citation :

@inproceedings{bai2023rangeperception,title={RangePerception: Taming Li{DAR} Range View for Efficient and Accurate 3D Object Detection},author={Yeqi BAI and Ben Fei and Youquan Liu and Tao MA and Yuenan Hou and Botian Shi and Yikang LI},booktitle={Thirty-seventh Conference on Neural Information Processing Systems},year={2023},url={https://openreview.net/forum?id=9kFQEJSyCM}}

Lien original : https://mp .weixin.qq .com/s/EJCl5kLxhHaa7lh98g2I6w

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!