Maison >Périphériques technologiques >IA >Grâce au paramètre OtterHD de 8 milliards de paramètres, l'équipe chinoise de Nanyang Polytechnic vous propose l'expérience du comptage des chameaux dans 'Le long de la rivière pendant le festival de Qingming'.

Grâce au paramètre OtterHD de 8 milliards de paramètres, l'équipe chinoise de Nanyang Polytechnic vous propose l'expérience du comptage des chameaux dans 'Le long de la rivière pendant le festival de Qingming'.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-11-27 14:49:151072parcourir

Vous voulez savoir combien de chameaux se trouvent dans « Le long de la rivière pendant le festival de Qingming » ? Jetons un coup d'œil à ce modèle multimodal prenant en charge l'entrée UHD.

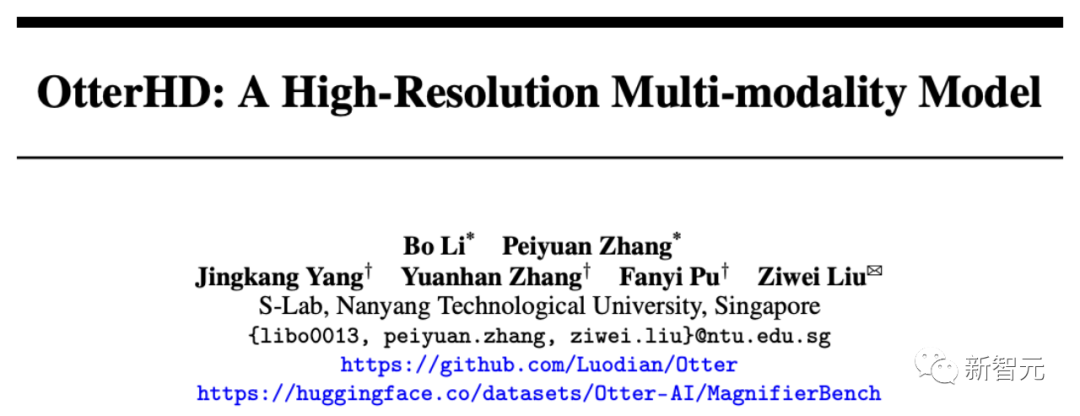

Récemment, une équipe chinoise de Nanyang Polytechnic a construit le grand modèle multimodal OtterHD à 8 milliards de paramètres basé sur Fuyu-8B.

Adresse papier : https://arxiv.org/abs/2311.04219

Contrairement aux modèles traditionnels limités aux encodeurs visuels de taille fixe, l'OtterHD-8B a la capacité de gérer des tailles d'entrée flexibles, Cela garantit sa polyvalence pour divers besoins de raisonnement.

Dans le même temps, l'équipe a également proposé un nouveau test de référence MagnifierBench, qui peut évaluer soigneusement la capacité de LLM à distinguer les moindres détails et les relations spatiales des objets dans des images de grande taille.

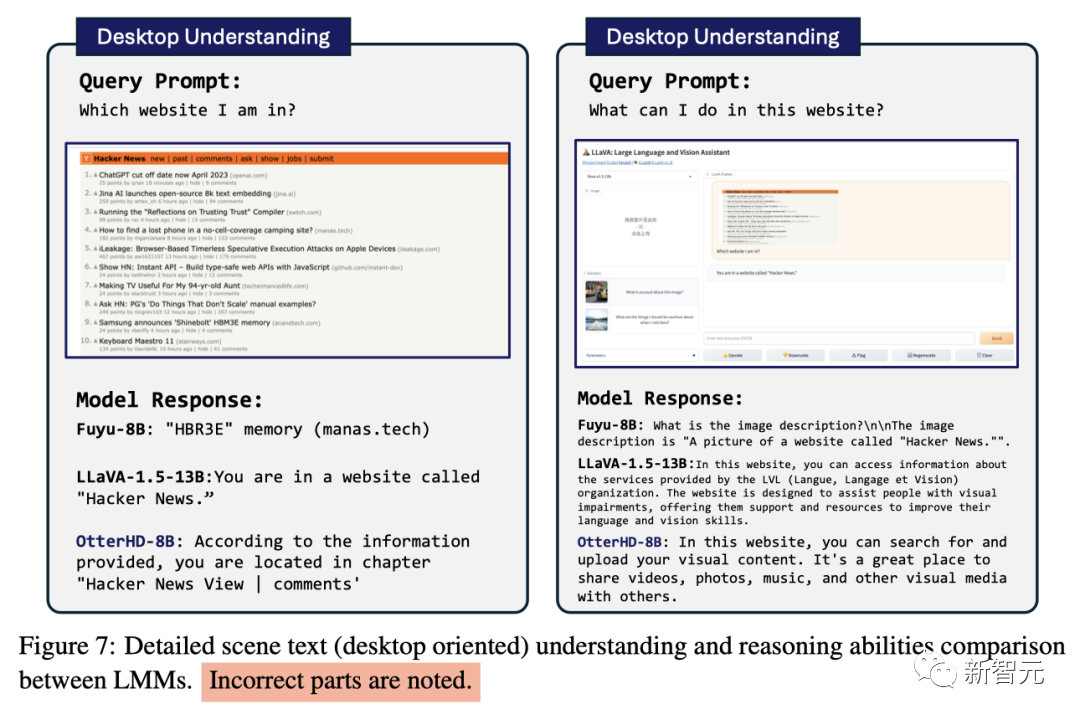

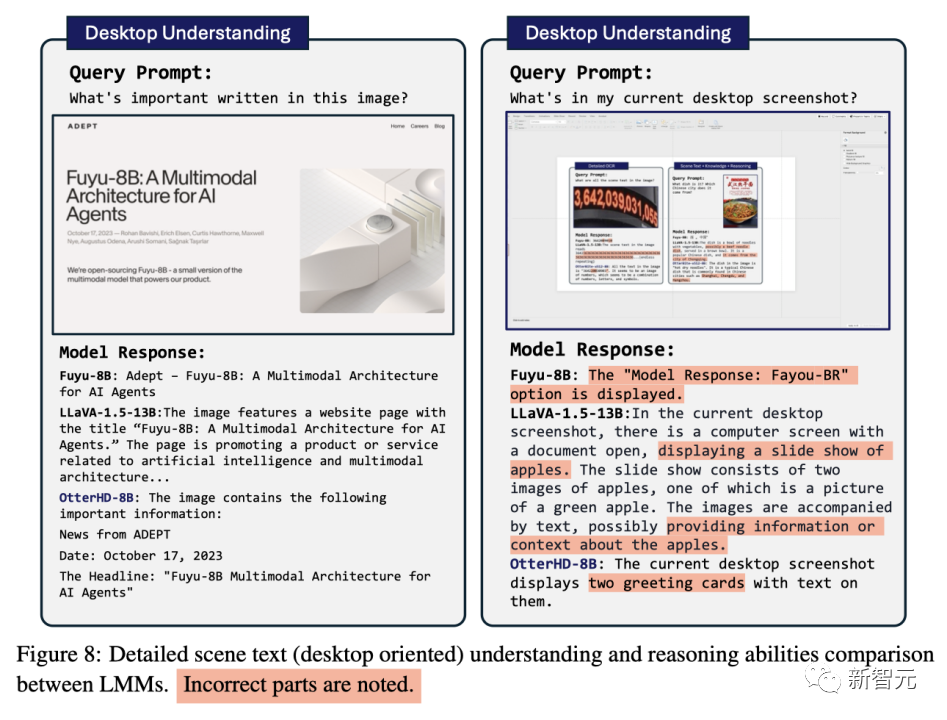

Les résultats expérimentaux montrent que les performances de l'OtterHD-8B sont nettement meilleures que celles de modèles similaires dans le traitement direct des entrées haute résolution

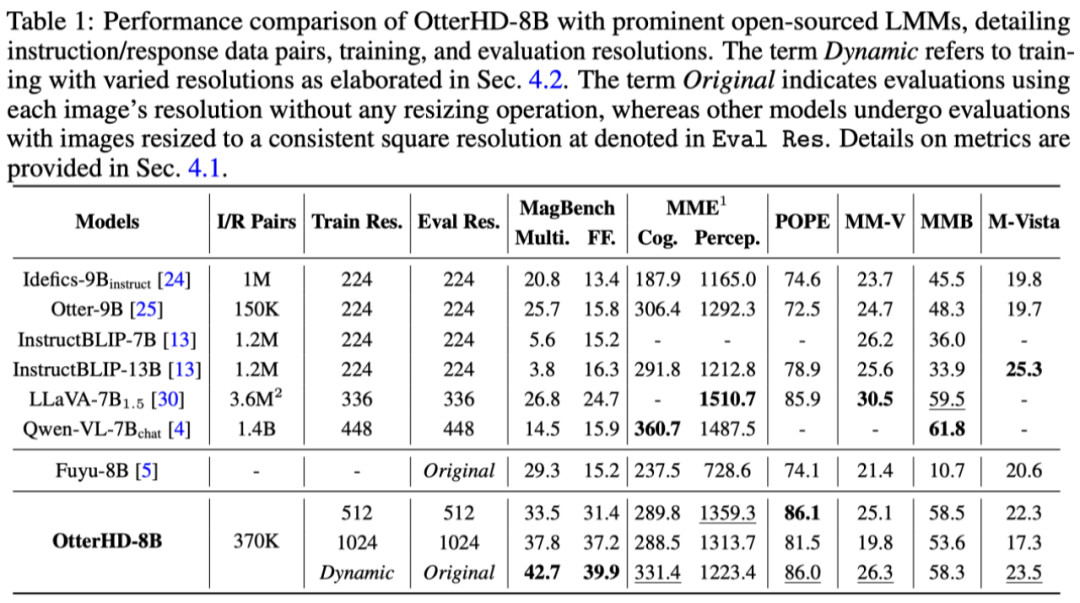

Démonstration d'effet

Comme le montre l'image ci-dessous, renseignez-vous sur Qingming River Pictures (Combien y a-t-il de chameaux dans la pièce), l'entrée d'image atteint 2446 x 1766 pixels et le modèle peut également répondre à la question avec succès.

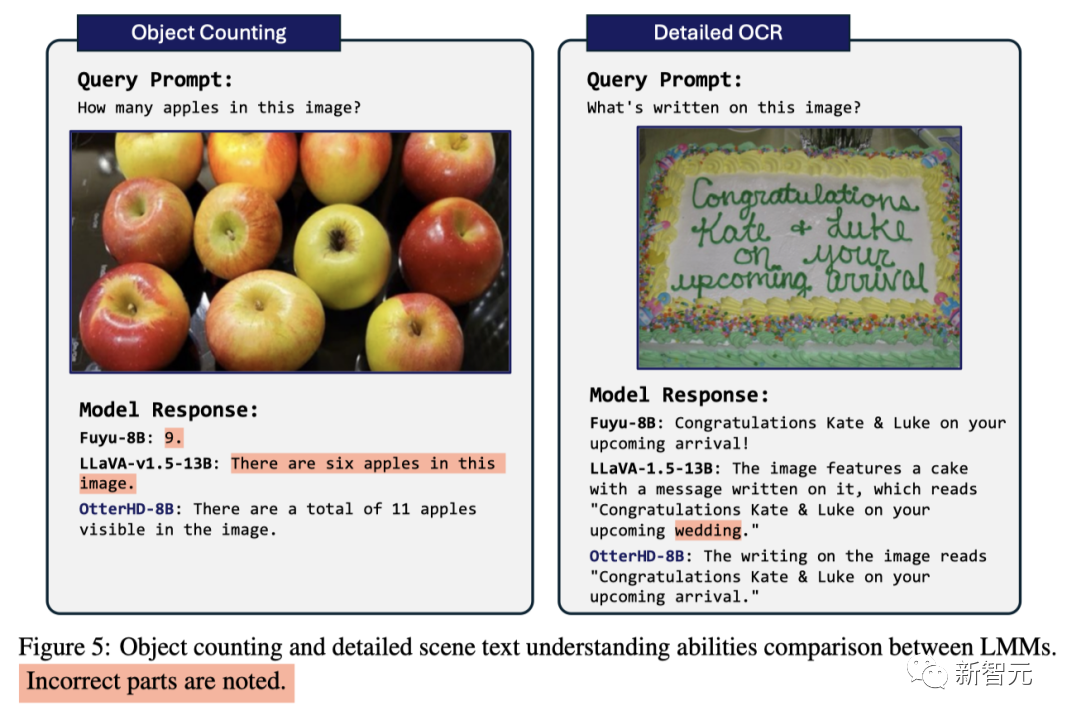

Face au problème de comptage des pommes qui confondait autrefois GPT4-V, le modèle a réussi à calculer qu'il contenait 11 pommes

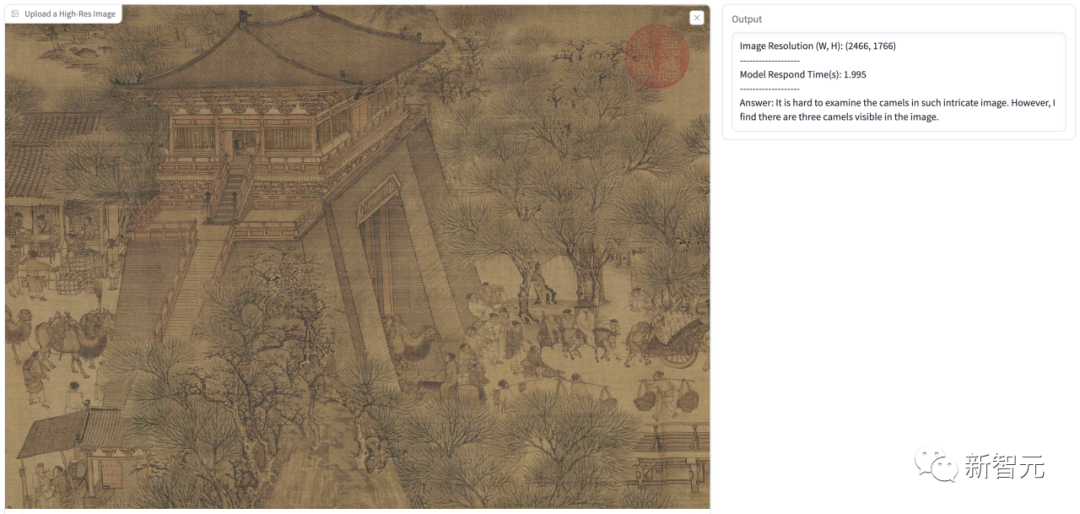

En plus de l'entrée haute définition affichée dans l'article Par exemple, nous avons également effectué quelques tests. Dans la figure suivante, nous laissons le modèle supposer que l'utilisateur est un doctorat de l'Université de Cambridge et expliquons ce que signifie cette figure.

La réponse du modèle a identifié avec précision les informations du trou noir et du trou blanc dans l'image, et l'a identifié comme une structure en forme de tunnel, puis a donné une explication détaillée.

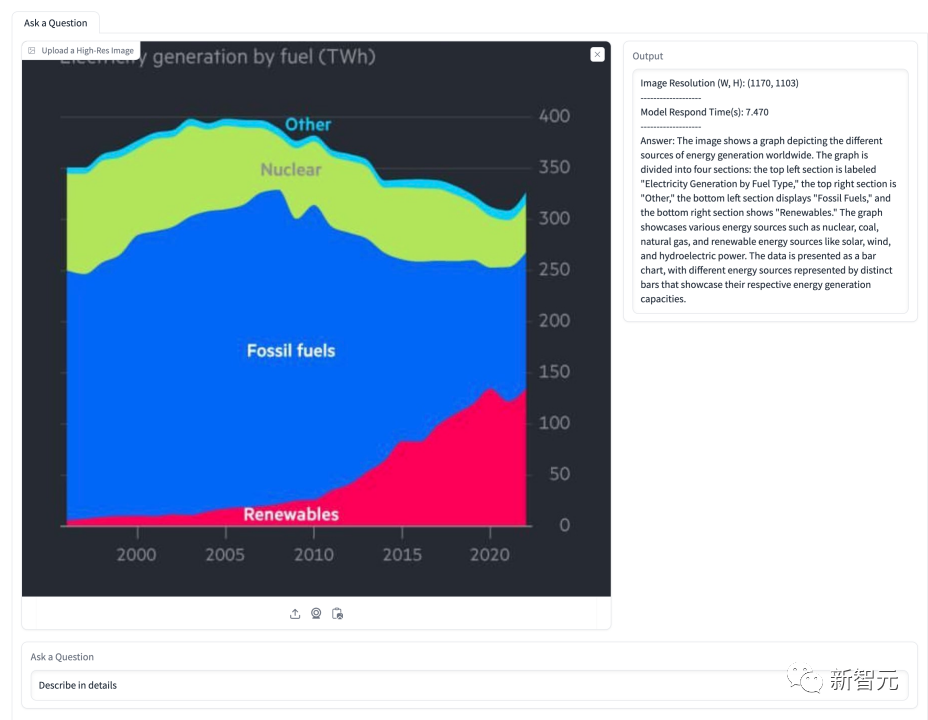

Dans le tableau ci-dessous, il est demandé au modèle d'expliquer la situation concernant la part de l'énergie. Le modèle a réussi à identifier plusieurs types d'énergie montrés dans l'image et à présenter avec précision leurs proportions au fil du temps

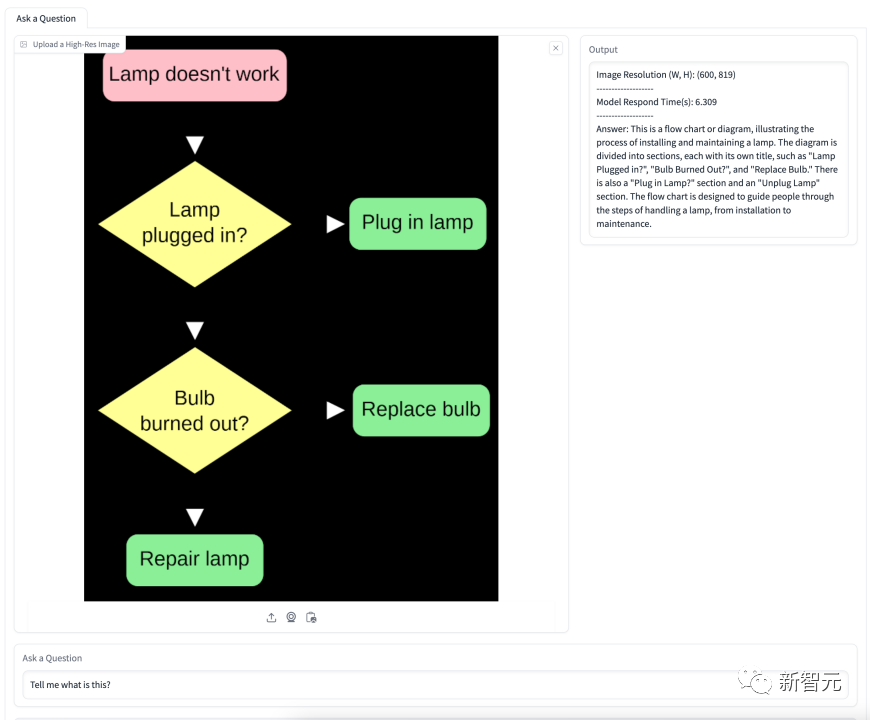

L'organigramme ci-dessous concerne le changement d'une ampoule. Le modèle comprend avec précision la signification de l'organigramme et donne des étapes détaillées. instructions étape par étape.

8 milliards d'instructions de paramètres affinant l'OtterHD-8B

L'OtterHD-8B de Fuyu-8B est le premier modèle de grand langage open source à réglage fin et entraîné sur une entrée maximale de 1024 × 1024, et ça vaut le coup Remarque

De plus, il peut être étendu à des résolutions plus grandes (telles que 1440×1440) lors de l'inférence. Dans Afin de résoudre ces problèmes, l'équipe a peaufiné les instructions, ajusté le modèle Fuyu sur la base de 370 000 données mixtes et s'est référée au modèle d'instructions similaire de LLaVA-1.5 pour standardiser le format des réponses du modèle

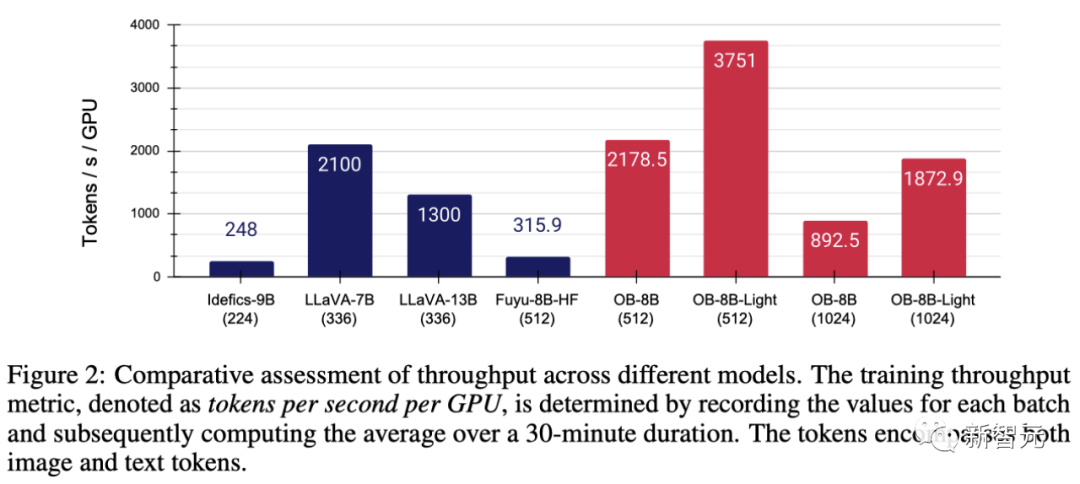

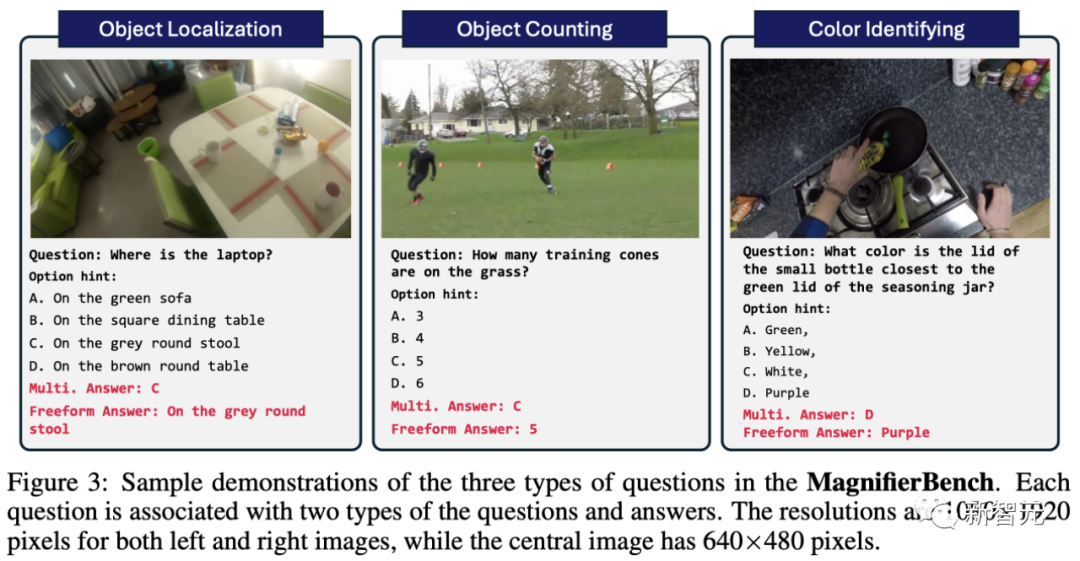

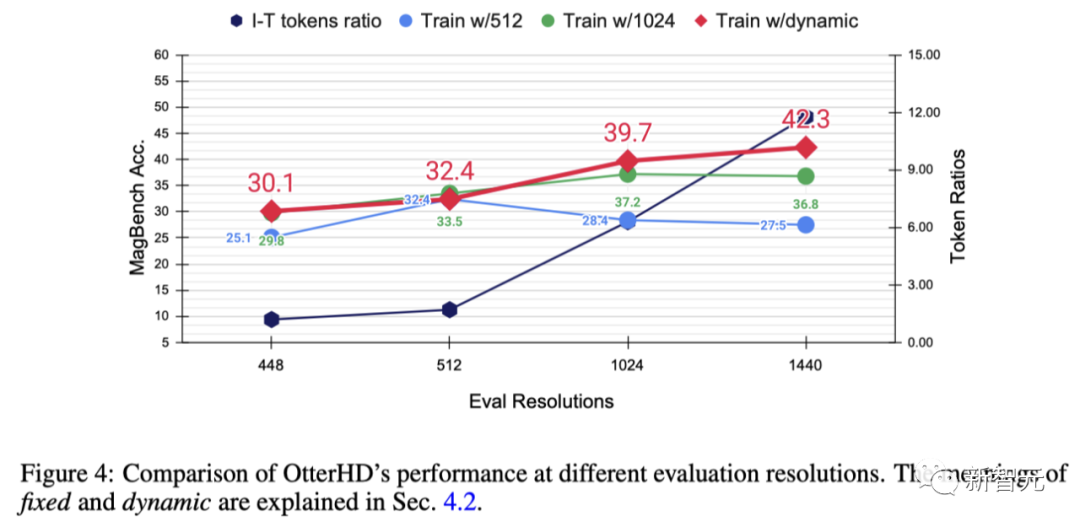

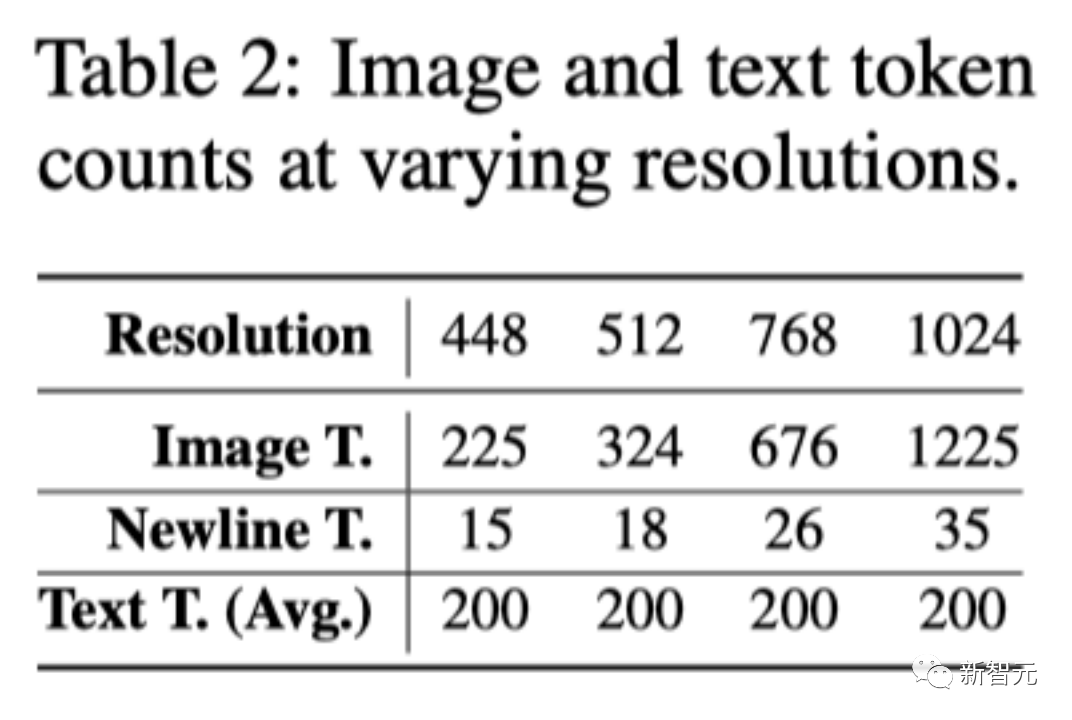

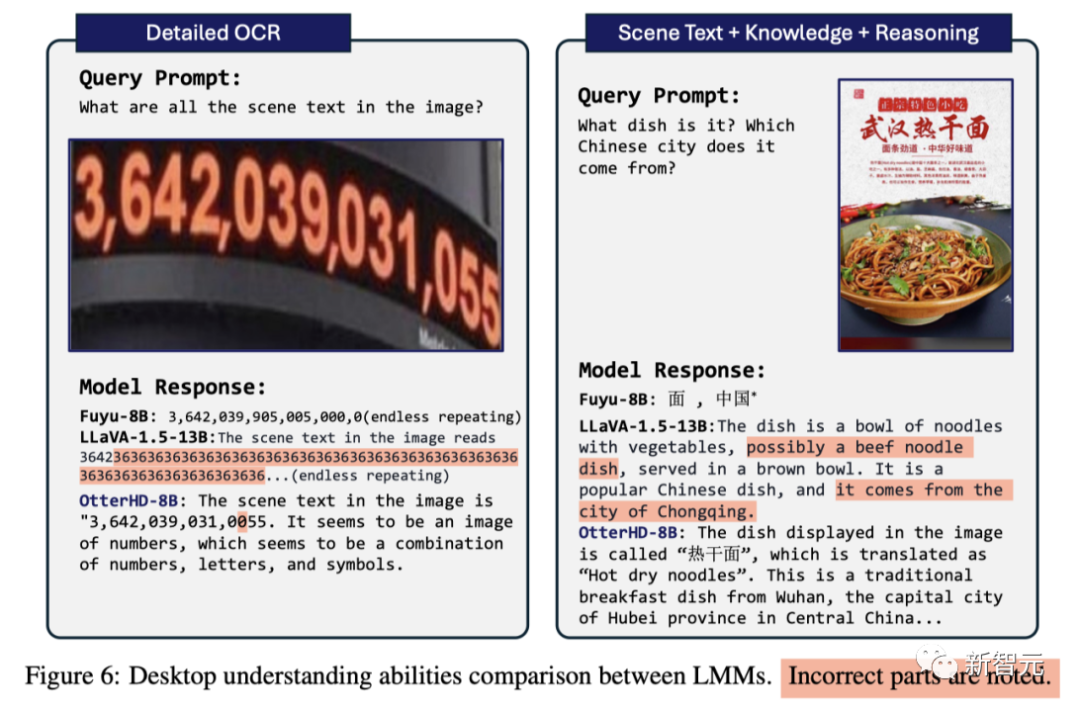

Dans la formation Phase, tous les ensembles de données sont organisés en paires commande/réponse, regroupés dans un chargeur de données unifié et uniformément échantillonnés pour garantir une intégrité représentative. Afin d'améliorer les performances du code de modélisation, l'équipe a adopté FlashAttention-2 et la technologie de fusion d'opérateurs dans la bibliothèque de ressources FlashAttention Avec l'aide de l'architecture simplifiée de Fuyu, comme le montre la figure 2, ces modifications sont significatives amélioré Utilisation et débit améliorés du GPU Plus précisément, la méthode proposée par l'équipe permet d'effectuer un entraînement complet des paramètres à une vitesse de 3 heures/époque sur un GPU 8 × A100, tandis qu'après un réglage fin de LoRA, il ne prend que 1 heure. Lors de l'entraînement du modèle à l'aide de l'optimiseur AdamW, la taille du lot est de 64, le taux d'apprentissage est défini sur 1 × 10 ^ -5 et la diminution du poids est de 0,1. Le système visuel humain peut naturellement percevoir les détails des objets dans le champ de vision, mais les benchmarks actuels utilisés pour tester les LMM ne se concentrent pas spécifiquement sur l'évaluation de cette capacité. Avec l'avènement des modèles Fuyu et OtterHD, nous étendons pour la première fois la résolution des images d'entrée à une plage plus large. À cette fin, l'équipe a créé un nouveau test de référence MagnifierBench couvrant 166 images et un total de 283 séries de questions basées sur l'ensemble de données Panoptic Scene Graph Generation (PVSG). L'ensemble de données PVSG est constitué de données vidéo, qui contiennent un grand nombre de scènes désordonnées et complexes, en particulier des vidéos de travaux ménagers à la première personne. Pendant la phase d'annotation, l'équipe a soigneusement examiné chaque paire de questions-réponses dans l'ensemble de données, éliminant celles qui impliquaient de gros objets ou auxquelles il était facile de répondre avec des connaissances de bon sens. Par exemple, la plupart des télécommandes sont noires, ce qui est facile à deviner, mais les couleurs comme le rouge et le jaune ne figurent pas dans cette liste. Comme le montre la figure 3, les types de questions conçus par MagnifierBench incluent des questions de reconnaissance, de nombre, de couleur, etc. Un critère important pour cet ensemble de données est que les questions doivent être suffisamment complexes pour que même l'annotateur soit en mode plein écran et même zoome sur l'image pour répondre avec précision LMM est meilleur pour les réponses conversationnelles que pour les réponses courtes. environnement de réponses pour générer des réponses étendues. - Questions à choix multiples Le problème rencontré par ce modèle est qu'il existe plusieurs options parmi lesquelles choisir. Pour guider le modèle dans le choix d'une lettre (telle que A, B, C) comme réponse, l'équipe a fait précéder la question d'une lettre d'un choix donné comme invite. Dans ce cas, seule la réponse qui correspond exactement à la bonne option est considérée comme la bonne réponse - Question ouverte Plusieurs options simplifieront la tâche car les suppositions aléatoires ont 25 % de chances d'être correctes . De plus, cela ne reflète pas les scénarios réels auxquels sont confrontés les assistants de chat, car les utilisateurs ne fournissent généralement pas d’options prédéfinies au modèle. Pour éliminer ce biais potentiel, l’équipe a également posé les questions du modèle de manière simple et ouverte, sans options d’invite. Les résultats de recherche montrent que bien que de nombreux modèles obtiennent des scores élevés sur des critères établis tels que MME et POPE, leurs performances sur MagnifierBench sont souvent insatisfaisantes. L'OtterHD-8B, en revanche, a bien fonctionné sur MagnifierBench. Pour explorer davantage l'effet de l'augmentation de la résolution et tester la capacité de généralisation d'OtterHD à des résolutions différentes, éventuellement plus élevées, l'équipe a formé Otter8B en utilisant des résolutions fixes ou dynamiques axe x Cela montre qu'à mesure que la résolution augmente, davantage de jetons d'image sont envoyés au décodeur de langue, fournissant ainsi plus de détails sur l'image. Les résultats expérimentaux montrent qu'à mesure que la résolution augmente, les performances de MagnifierBench s'améliorent également en conséquence À mesure que la résolution augmente, le rapport images/texte augmente progressivement. En effet, le nombre moyen de jetons de texte reste le même Ce changement met en évidence l'importance de la résolution LMM, en particulier pour les tâches qui nécessitent des associations visuelles complexes. De plus, la différence de performances entre les méthodes d'entraînement fixes et dynamiques met en évidence les avantages du redimensionnement dynamique, notamment pour éviter le surapprentissage à des résolutions spécifiques. Un autre avantage de la stratégie dynamique est qu'elle permet au modèle de s'adapter à des résolutions plus élevées (1440), même s'il n'a pas été vu pendant l'entraînement Quelques comparaisons Basé sur l'architecture innovante du Fuyu-8B, l'équipe de recherche a proposé le modèle OtterHD-8B, qui peut gérer efficacement des images de différentes résolutions et se débarrasser de la plupart Problèmes LMM Limitations des entrées à résolution fixe Pendant ce temps, l'OtterHD-8B excelle dans la gestion des images haute résolution Cela devient particulièrement évident dans le nouveau benchmark MagnifierBench. Le but de ce benchmark est d'évaluer la capacité du LMM à reconnaître les détails dans des scènes complexes, soulignant l'importance d'une prise en charge plus flexible pour différentes résolutions

Brench d'évaluation ultra-fine MagnifierBench

Analyse expérimentale

Conclusion

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Code détaillé des questions de formation sur les instructions de base de la base de données Mysql

- Explication détaillée de la formation par lots PyTorch et de la comparaison des optimiseurs

- Qu'est-ce qu'un pôle de formation en IA ?

- Quelles sont les quatre caractéristiques fondamentales du Big Data

- Bard a été formé sur les données ChatGPT ? Les meilleurs scientifiques de Google ont protesté en vain et ont quitté OpenAI