Maison >Périphériques technologiques >IA >Une nouvelle avancée dans la génération vidéo : PixelDance, présentant facilement des mouvements complexes et des effets spéciaux sympas

Une nouvelle avancée dans la génération vidéo : PixelDance, présentant facilement des mouvements complexes et des effets spéciaux sympas

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-11-24 15:10:591399parcourir

Récemment, en plus des modèles linguistiques à grande échelle largement regardés qui continuent de faire la une des journaux, la technologie de génération vidéo a également continué à faire des percées majeures. De nombreuses entreprises ont lancé de nouveaux modèles les uns après les autres

Tout d'abord, Runway est le premier à explorer le domaine de la génération vidéo. L'un des leaders, il a mis à niveau son modèle Gen-2 pour offrir une haute définition cinématographique accrocheuse. Dans le même temps, la cohérence de la génération vidéo a également été considérablement améliorée

Cependant, cette amélioration de la cohérence semble se faire au détriment de la dynamique vidéo. Il ressort de la vidéo promotionnelle officielle de Gen-2 que bien que plusieurs courts clips soient assemblés, la dynamique de chaque clip est relativement faible, ce qui rend difficile la capture d'actions et de mouvements clairs de personnages, d'animaux ou d'objets.

Récemment, Meta a également publié le modèle de génération vidéo Emu Video. Comme le montrent les exemples officiels d'Emu Video, la dynamique de ses vidéos est considérablement améliorée par rapport à Gen-2, mais elles sont toujours limitées à des actions plus simples.

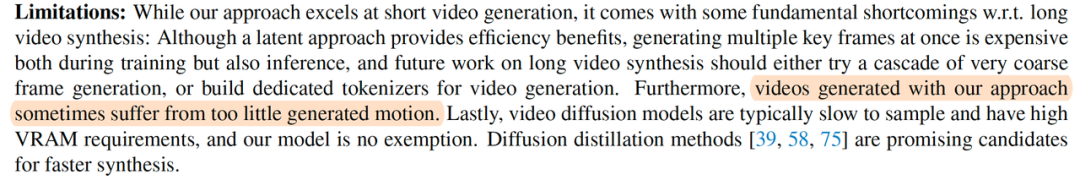

Stability.ai, la société qui a développé le modèle classique de graphe Vincent Stable Diffusion, a également récemment publié le modèle open source de génération vidéo Stable Video Diffusion (SVD), qui a attiré beaucoup d'attention et de discussions dans le monde. communauté open source. L'effet du SVD est comparable à celui du Gen-2. À partir de l'échantillon de test, on peut voir que la vidéo générée par SVD manque relativement de dynamique.

a souligné dans l'article SVD que la vidéo actuelle générée par SVD a une dynamique insuffisante

L'exemple ci-dessus montre que génère des vidéos hautement cohérentes et richement dynamiques, rendant le contenu vidéo véritablement quand le sol. bouge, c'est actuellement le plus grand défi dans le domaine de la génération vidéo.

À cet égard, les derniers résultats de la recherche PixelDance ont franchi une étape critique. La dynamique de ses résultats générés est nettement meilleure que celle des autres modèles existants, ce qui a attiré l'attention de l'industrie.

La news PixelDance relayée par le célèbre blogueur IA @_akhaliq sur Twitter a reçu près de 80 000 vues

sur le site officiel (https://pixelmake danse.github .io), PixelDance propose deux modes de génération vidéo différents.

Vous avez le choix entre deux modes, le premier est le mode de base. Dans ce mode, les utilisateurs doivent uniquement fournir une image guide et une description textuelle, et PixelDance peut générer une vidéo hautement cohérente et dynamique. L'image de guidage peut être une vraie photo ou elle peut être générée par un modèle d'image généré par du texte existant. À en juger par les résultats affichés, PixelDance peut toutes les résoudre dans un style réel, un style d'animation, un style bidimensionnel et un style magique. ., mouvements des personnages, expressions faciales, contrôle de la perspective de la caméra, mouvements d'effets spéciaux, Pixeldance peut également être très bien complété. Tout ce que je peux dire, c'est tql !

Le second est le mode Magic avancé, qui donne aux utilisateurs plus d'espace pour utiliser leur imagination et leur créativité. Dans ce mode, les utilisateurs doivent fournir deux images de guidage + une description textuelle, ce qui permet de mieux générer un contenu vidéo plus difficile. Le site Web présente diverses photos d'effets spéciaux sympas réalisées avec le mode magique.

De plus, le site officiel présente également un court métrage de 3 minutes entièrement réalisé avec PixelDance

Ce qui est très choquant, c'est que l'utilisation de PixelDance peut créer chaque scène et action correspondante selon une histoire imaginée par l'utilisateur. Qu'il s'agisse d'une scène réelle (comme l'Égypte, la Grande Muraille, etc.) ou d'une scène imaginaire (comme une planète extraterrestre), PixelDance peut générer des vidéos riches en détails et en action, voire même divers plans avec effets spéciaux.

Le chapeau haut de forme noir et le nœud papillon rouge du protagoniste M. Polar Bear sont bien entretenus dans diverses scènes. Désormais, générer de longues vidéos ne consiste plus simplement à assembler de courts clips vidéo non pertinents !

Pour obtenir des effets de génération vidéo aussi exceptionnels, il ne s'appuie pas sur des ensembles de données complexes et sur une formation de modèles à grande échelle. PixelDance a obtenu les effets ci-dessus avec seulement un modèle de 1,5 milliard sur l'ensemble de données public WebVid-10M.

Adresse papier : https://arxiv.org/abs/2311.10982

Réécrivez le contenu sans changer le sens original et réécrivez-le en chinois : Veuillez visiter le site Web suivant pour obtenir la démo : https ://makepixelsdance.github.io

Dans l'article correspondant "Make Pixels Dance: High-Dynamic Video Generation", l'auteur a souligné la raison pour laquelle la génération vidéo est difficile à obtenir de bons résultats : par rapport à la génération d'images, la vidéo La génération a un espace de fonctionnalités beaucoup plus grand. Une grande diversité d'actions est des fonctionnalités nettement plus fortes. Cela rend difficile pour les méthodes de génération vidéo existantes l’acquisition d’informations efficaces sur les actions dans le domaine temporel. Bien que les vidéos générées aient une qualité d’image élevée, leur dynamique est très limitée.

En réponse aux problèmes ci-dessus, PixelDance propose une méthode de génération de vidéo basée sur le guidage de texte + le guidage d'image de la première et de la dernière image, afin que le modèle puisse prêter davantage attention et apprendre les informations dynamiques de la vidéo.

Dans la génération vidéo, la première image fournit le cadre et le matériau pour l'ensemble du contenu vidéo. Dans le même temps, des vidéos plus longues peuvent être générées en utilisant la dernière image du clip vidéo précédent comme guide pour la première image du clip suivant. La description du texte vidéo décrit le contenu spécifique de l'action vidéo. Le guidage d'image de dernière trame fournit des informations d'état final pour le processus de génération vidéo. L'auteur propose une méthode d'adaptation qui permet au modèle d'accepter des images relativement grossières comme guide, ce qui permet aux utilisateurs d'utiliser des outils d'édition d'image de base pour obtenir un guidage d'image de fin de cadre

L'affichage des informations sur le site officiel est toujours actif lors de l'itération les effets de modèle, un modèle que tout le monde peut essayer sortira dans les 2-3 prochains mois. À l'heure actuelle, l'auteur propose également un moyen d'aider chacun à envoyer des échantillons qu'il souhaite tester. À l'heure actuelle, certains échantillons de tests utilisateurs ont été publiés sur le site officiel :

Il semble qu'avec PixelDance, tant que cela est long. comme vous avez une imagination débordante. Avec le pouvoir, tout le monde peut devenir un « maître des effets spéciaux à un million de dollars » !

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!