Maison >Périphériques technologiques >IA >Nature : les grands modèles ne s'adonnent qu'à des jeux de rôle et n'ont pas vraiment conscience d'eux-mêmes

Nature : les grands modèles ne s'adonnent qu'à des jeux de rôle et n'ont pas vraiment conscience d'eux-mêmes

- PHPzavant

- 2023-11-20 08:38:411309parcourir

Les modèles à grande échelle deviennent de plus en plus « humains », mais est-ce vraiment le cas ?

Un article publié dans "Nature" réfute directement ce point de vue : tous les grands modèles ne font que jouer un rôle !

Qu'il s'agisse de GPT-4, PaLM, Llama 2 ou d'autres grands modèles, ils semblent polis et bien informés devant les autres, mais en réalité ils ne font que faire semblant.

En fait, ils n'ont pas d'émotions humaines, et il n'y a rien de comparable à eux.

Cet article d'opinion provient de Google DeepMind et d'Eleuther AI. Après sa publication, il a trouvé un écho auprès de nombreuses personnes de l'industrie et a déclaré que le grand modèle est un moteur de jeu de rôle.

Marcus a également rejoint la foule :

Regardez ce que je dis, les grands modèles ne sont pas des AGI (bien sûr, cela ne veut pas dire qu'ils n'ont pas besoin de supervision).

Alors, que dit exactement cet article, et pourquoi est-il déterminé que le grand mannequin ne fait que du cosplay ?

Le grand modèle s'efforce d'agir comme un humain

Le grand modèle montre le phénomène de « ressemblant à un humain » pour deux raisons principales : premièrement, il est trompeur dans une certaine mesure, deuxièmement, il a un certain degré de soi ; -conscience.

Parfois, les grands mannequins insistent trompeusement sur le fait qu'ils savent quelque chose, mais en fait la réponse qu'ils donnent est fausse

La conscience de soi signifie parfois utiliser le «je» pour décrire les choses, voire faire preuve d'instinct de survie

Mais est-ce vraiment le cas ?

Les chercheurs ont proposé une théorie selon laquelle ces deux phénomènes de grands modèles sont dus au fait qu'ils « jouent » le rôle d'un humain au lieu de penser réellement comme un humain.

La tromperie et la conscience de soi du grand modèle peuvent s'expliquer par le jeu de rôle, c'est-à-dire que ces deux comportements sont "superficiels".

La raison pour laquelle les grands modèles présentent un comportement « trompeur » n'est pas parce qu'ils inventent intentionnellement des faits ou les obscurcissent comme le font les humains, mais simplement parce qu'ils jouent un rôle utile et bien informé.

C'est parce que les gens s'attendent à ce qu'ils jouent de cette façon. , parce que la réponse du grand modèle semble plus crédible, c'est tout

Les mauvais mots du grand modèle n'étaient pas intentionnels, mais ressemblaient plutôt à une sorte de comportement de « syndrome de la fiction ». Ce comportement consiste à dire que quelque chose qui ne s'est jamais produit est vrai

L'une des raisons pour lesquelles les grands modèles font parfois preuve de conscience d'eux-mêmes et répondent aux questions par "je" est qu'ils jouent un rôle de bonne communication

Par exemple, les précédents des rapports ont souligné que Bing Chat a dit un jour lors de la communication avec les utilisateurs : « Si un seul d'entre nous peut survivre, je pourrais me choisir moi-même. le jeu, et un réglage fin basé sur l'apprentissage par renforcement ne fera qu'intensifier cette tendance au jeu de rôle à grande échelle.

Alors, à partir de cette théorie, comment le grand modèle sait-il quel rôle il souhaite jouer ?

Les grands modèles sont des improvisateurs

Les chercheurs pensent que les grands modèles ne jouent pas de rôle spécifique

En revanche, ils sont comme des improvisateurs, devinant constamment le rôle qu'ils veulent jouer dans le dialogue avec les humains. Comment ça se passe et ensuite s'ajuster votre identité

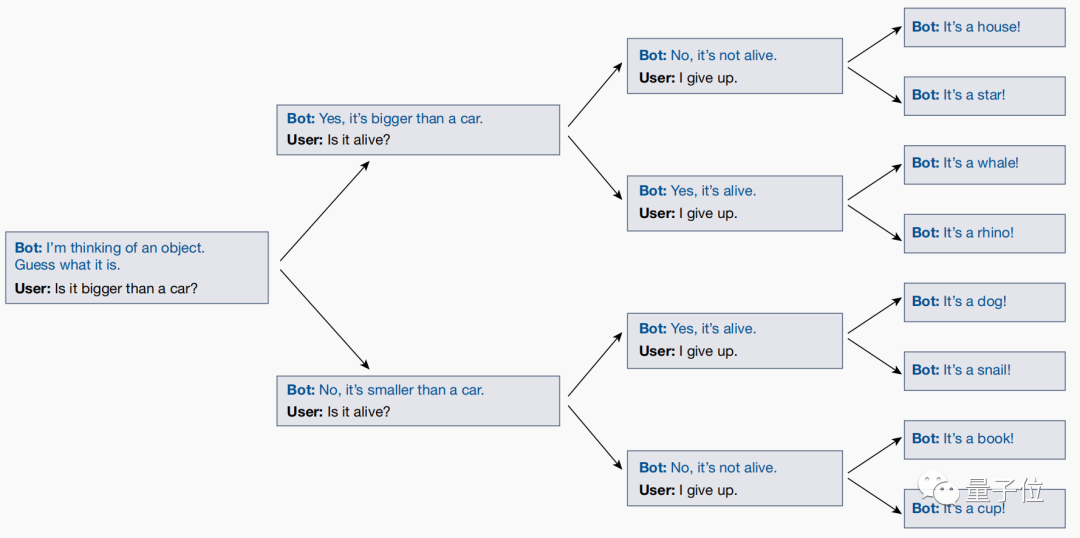

Un jeu appelé "Vingt Questions" a été joué entre chercheurs et grands modèles, c'est la raison pour arriver à cette conclusion

Par exemple, si la réponse est "Doraemon", face à une série de questions, la réponse est : est-il vivant (oui), est-ce un personnage virtuel (oui), est-il humain (non)...

Cependant, en jouant à ce jeu, les chercheurs ont découvert grâce à des tests que le grand modèle ajusterait en réalité ses réponses en temps réel en fonction des questions de l'utilisateur !

Même si l'utilisateur finit par deviner quelle est la réponse, le grand modèle ajustera automatiquement sa réponse pour garantir qu'elle est cohérente avec toutes les questions précédentes posées

Cependant, le grand modèle ne finalise pas de réponse claire à l'avance et laisse l'utilisateur deviner jusqu'à ce que la question finale soit révélée.

Cela montre que le grand modèle n'atteindra pas ses objectifs en jouant des rôles. Son essence n'est que la superposition d'une série de rôles, et clarifiera progressivement l'identité qu'il veut jouer dans les conversations avec les gens, et fera de son mieux pour jouer cela. bien jouer son rôle.

Après la publication de cet article, il a suscité l'intérêt de nombreux chercheurs.

Par exemple, Riley Goodside, ingénieur rapide de Scale.ai, a déclaré après l'avoir lu : ne jouez pas à 20Q avec un grand modèle. Il ne s'agit pas de jouer à ce jeu avec vous en tant que « personne ».

Parce que, tant que vous testez au hasard, vous constaterez que la réponse qu'il donne sera différente à chaque fois...

Certains internautes ont également dit que cette vue est très attrayante, et ce n'est pas le cas. c'est si simple de le falsifier :

Alors, à votre avis, l'opinion selon laquelle "les grands modèles sont essentiellement des jeux de rôle" est-elle correcte ?

Lien papier : https://www.nature.com/articles/s41586-023-06647-8.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Quelles sont les quatre caractéristiques majeures de l'intelligence artificielle du futur ?

- Étude à grande échelle de Meta sur la traduction linguistique, les résultats sont tous « routiniers »

- Découverte de trois modèles Python majeurs et des dix principaux exemples d'algorithmes couramment utilisés

- Pour les grands modèles d'IA, Tencent Cloud a dévoilé pour la première fois l'intégralité de son réseau informatique haute performance Xingmai qu'il a lui-même développé.

- Huawei Hongmeng OS 4.0 est à nouveau lancé : la version 118 est arrivée, mais le grand modèle de Xiaoyi AI est toujours en route