Maison >Périphériques technologiques >IA >Étude à grande échelle de Meta sur la traduction linguistique, les résultats sont tous « routiniers »

Étude à grande échelle de Meta sur la traduction linguistique, les résultats sont tous « routiniers »

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-11 23:46:041963parcourir

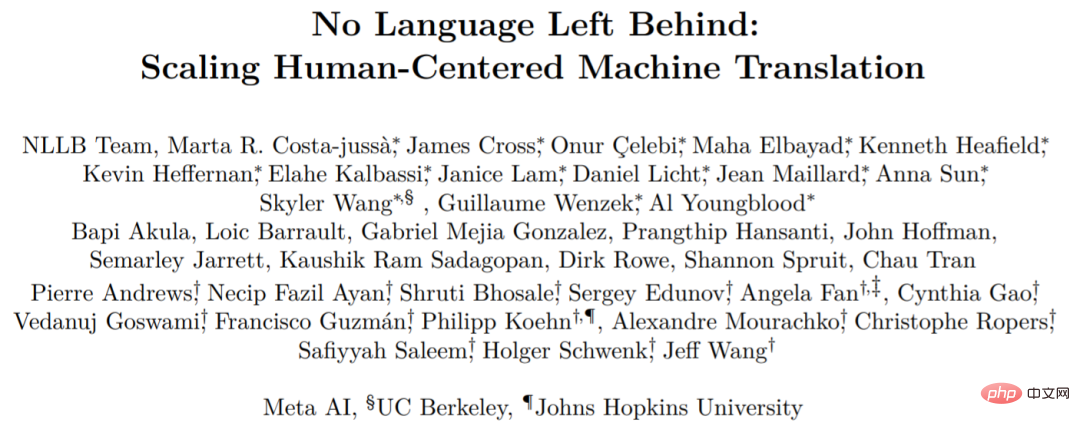

Début juillet de cette année, Meta AI a publié un nouveau modèle de traduction appelé No Language Left Behind (NLLB), que nous pouvons littéralement traduire par « Aucune langue laissée pour compte ».

Comme son nom l'indique, NLLB peut prendre en charge n'importe quelle traduction entre plus de 200 langues, et Meta AI l'a également rendu open source. Il peut traduire des langues que vous n'avez jamais vues auparavant, comme le luganda, l'ourdou, etc.

- Adresse papier : https://research.facebook.com/publications/no-lingual-left-behind/

- Adresse open source : https://github. com /facebookresearch/fairseq/tree/nllb

Cependant, cette recherche a été remise en question récemment. Certaines personnes pensent que bon nombre des affirmations faites par Meta AI dans le NLLB sont infondées et trompeuses, et les résultats de l'évaluation sont sérieux. conséquences. De plus, les sceptiques affirment qu'il serait facile d'obtenir des chiffres plus élevés que ceux rapportés par la méthodologie d'évaluation de Meta AI.

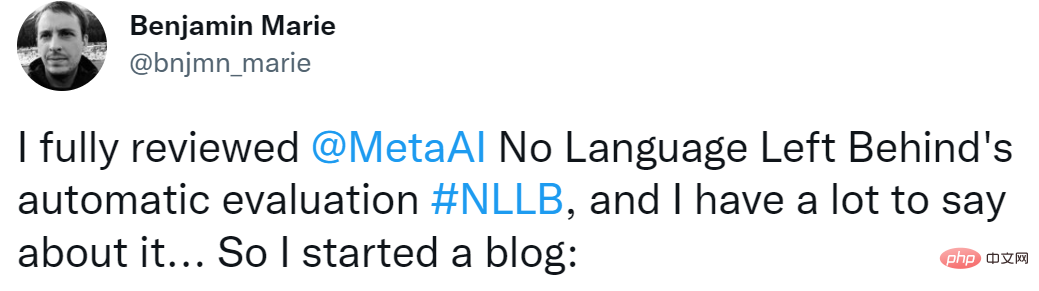

Le sceptique est Benjamin Marie, chercheur en traitement du langage naturel, qui maîtrise les technologies de traduction. Ce qu'il a remis en question peut être résumé par Meta AI comparant spBLEU et BLEU côte à côte.

Concernant cette question, certains chercheurs ont déclaré : spBLEU est une métrique raisonnable, à condition que le texte ne comporte pas d'espaces (thaï, etc.). Mais comparer spBLEU et BLEU est définitivement incorrect.

L'internaute Arle Lommel a répondu à Benjamin Marie : C'est un excellent point. Cela m’a également appris qu’en matière de recherche sur l’apprentissage automatique, nous devons être très prudents à l’égard des recherches qui manquent de confirmation. Ce que vous trouvez ici suggère que le problème se complique lorsque les gens se contentent de faire référence à des fractions sans contrôler la manière dont elles sont produites.

Vedanuj Goswami, l'un des auteurs de l'article, a déclaré : « Nous sommes à 100 % d'accord avec l'auteur sur le fait que vous ne pouvez pas comparer les scores BLEU avec différents tokenizers. Mais l'argument principal de l'auteur est que le gros problème dans notre article Il n'est pas vrai que la plupart des résultats sont incomparables.

Dans notre article, le tableau 30 et le tableau 31 utilisent le même tokenizer pour l'évaluation spBLEU (FLORES-101 spm tokenizer), nous n'utilisons pas spécifiquement FLORES -200. spm tokenizer. Nous décrivons cela en détail dans le titre du tableau 30 et dans la section 8.3.1. De même, les tableaux 35, 36, 37 et 38 utilisent tous des métriques/tokenizers comparables pour notre article. La méthode actuelle d'évaluation de la traduction automatique n'est pas parfaite et différents articles utilisent des méthodes différentes "

Ci-dessous, nous présentons le contenu spécifique des doutes de Benjamin Marie. :

Ci-dessous, nous présentons le contenu spécifique des doutes de Benjamin Marie. :

La méthode d'évaluation est imparfaite

Premièrement. Faisons une analogie simple :Paul a 25 bananes et Bill a 30 tomates. Diriez-vous que Bill a 5 bananes de plus que Paul ?

BLEU est comme une banane, spBLEU est comme une tomate. Remplacez Paul par Travaux antérieurs et Bill par NLLB. On peut maintenant écrire quelque chose comme ceci :

Le travail précédent réalisé à 25 BLEU et NLLB réalisé à 30 spBLEU. Diriez-vous que NLLB est meilleur de 5 points BLEU que les travaux précédents ?

Avec l'analogie ci-dessus, le contenu présenté ci-dessous peut être plus facile à comprendre.

Auparavant, Meta AI a publié un article qui expliquait et évaluait de manière exhaustive le NLLB. Dans le résumé de l'article, ils affirment que le modèle atteint une amélioration BLEU de 44 % par rapport aux méthodes SOTA précédentes. En d’autres termes, NLLB produira de meilleurs résultats que les études précédentes.

Concernant BLEU, il est rare dans l'histoire de la recherche en traduction automatique de voir BLEU s'améliorer de 44% par rapport à la technologie SOTA précédente. Cette simple phrase dans l’article représente donc un progrès scientifique. Certains médias ont directement rapporté cette déclaration et, sans autre vérification, ont positionné Meta AI au sommet de la traduction automatique des langues.

Si Meta AI choisit de publier une étude technique d’une telle envergure, elle devrait fournir des preuves scientifiques très fiables. Sinon, la prétention de Meta AI de faire mieux que les autres, sans aucune preuve, ne fera que saper le travail très acharné que d'autres institutions de recherche ont accompli et continuent de faire.

Marie Pour expliquer le problème d'erreur NLLB, il tente de montrer comment Meta AI peut être induite en erreur par ses propres résultats. À l'aide d'exemples simples de NLLB et d'exemples similaires qu'elle a trouvés elle-même, Marie démontre à quel point il est facile d'aller au-delà de SOTA en utilisant les méthodes d'évaluation imparfaites de NLLB. Enfin, Marie identifie et explique spécifiquement les principales erreurs de leur évaluation.

Meta AI a comparé son modèle avec les données de plus de 20 études précédentes et a conclu que NLLB surpassait considérablement les études précédentes. Pour rendre possible un si grand nombre de comparaisons, ils s'appuient sur des mesures d'évaluation automatisées pour l'évaluation de la traduction automatique, principalement BLEU et spBLEU.

BLEU est extrêmement populaire en traduction automatique, malgré ses défauts.

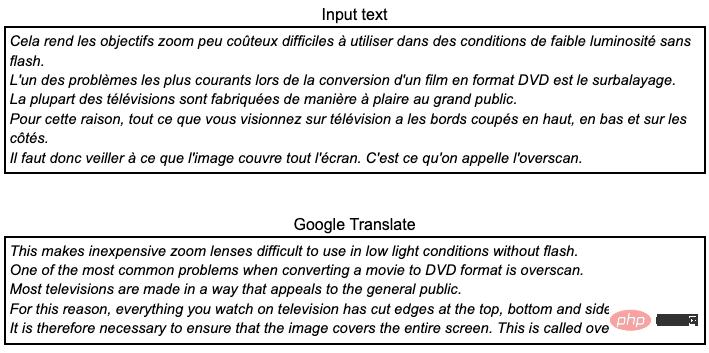

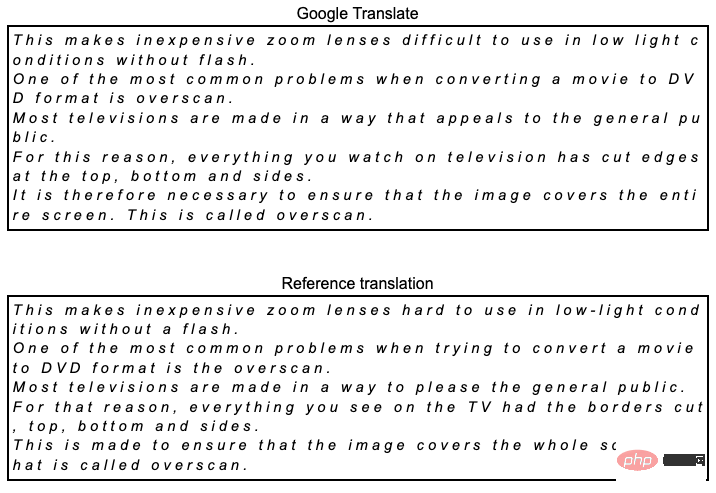

Par exemple, nous aimerions traduire le texte français suivant de l'ensemble de données FLORES101 en anglais à l'aide de Google Translate. Si vous parlez français, vous remarquerez qu'il s'agit d'une traduction de très mauvaise qualité : erreurs grammaticales, terminologie incohérente et elle ne se lit pas naturellement. En fait, puisque l’ensemble de données a été créé à partir de l’anglais, Meta AI n’évalue la traduction automatique que lors de la traduction vers l’anglais.

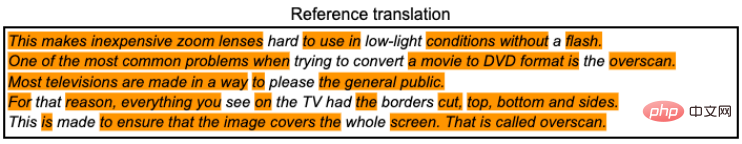

Nous pouvons la comparer à la traduction de référence en comptant combien de jetons dans Google Translate se trouvent également dans cette traduction de référence. Un jeton est défini ici comme une séquence de caractères séparés par un espace. Orange met en évidence toutes les séquences de jetons dans Google Translate ci-dessus qui apparaissent dans la traduction de référence ci-dessous.

En prenant en compte uniquement tous les jetons correspondants, le score BLEU peut être calculé à 50,8 BLEU. Ce score à lui seul ne veut rien dire, il n'a de sens que par rapport à un autre score BLEU.

Le point clé à comprendre ici est que le score est calculé sur la base de jetons, ce qui est ignoré dans la plupart des recherches en traduction automatique. Le score BLEU est calculé à l'aide de SacreBLEU, qui effectue sa propre tokenisation interne, en ajoutant simplement des espaces avant la ponctuation. Il s’agit de l’une des méthodes les plus fiables et reproductibles de calcul des scores BLEU. Meta AI utilise spBLEU.

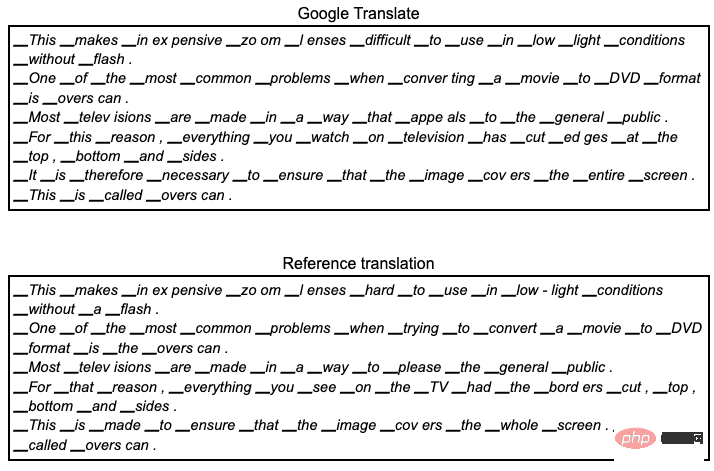

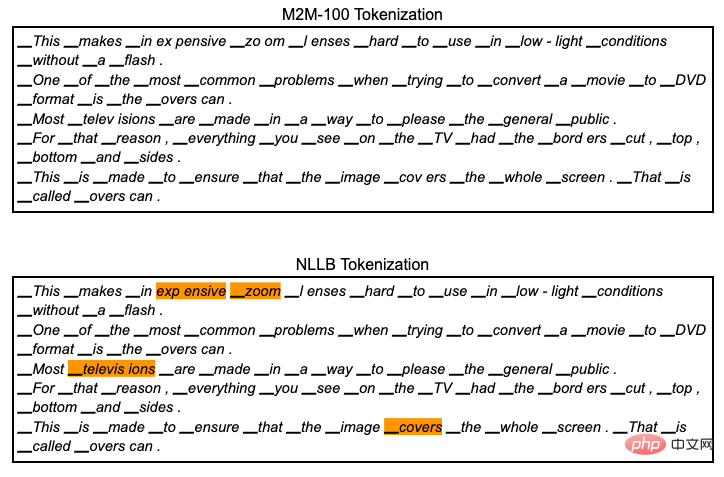

Alors c'est quoi spBLEU ? Il s'agit de BLEU mais utilise une tokenisation différente. Il symbolise Google Translate et les traductions de référence comme suit.

Le jeton associé à spBLEU génère le jeton en divisant le mot en morceaux plus petits (ce qui est ajouté au jeton n'est pas important ici, essayez de l'ignorer). Une conséquence directe de l’utilisation de la tokenisation spBLEU est que nous nous retrouvons avec plus de jetons pour les traductions et les références. Puisqu'il y a plus de jetons, nous pouvons nous attendre à ce que Google Translate fasse correspondre davantage de jetons à partir de la référence. Ensuite, le score augmentera. En fait, le score spBLEU est ici de 54,8.

On ne peut s'empêcher de demander 4 points de plus que le score BLEU calculé ci-dessus à l'aide de la tokenisation interne de SacreBLEU ? Alors, la traduction s’améliore-t-elle de plus en plus ?

Apparemment non, la traduction reste la même. Comparer BLEU et spBLEU n'a aucun sens. BLEU et spBLEU gèrent différemment Google Translate et les traductions de référence et sont utilisés uniquement à des fins d'évaluation. Ce sont en fait des indicateurs différents. S’il s’agissait du même indicateur, nous n’aurions pas besoin de les nommer différemment. Comme nous le lisons et l’entendons souvent dans la communauté des chercheurs en traduction automatique, il n’est pas juste, voire injuste, de comparer la qualité des traductions à l’aide des scores BLEU calculés pour des jetons différents, voire presque similaires. Si vous souhaitez que votre recherche soit scientifiquement crédible, il vous suffit de calculer votre score BLEU de manière cohérente en utilisant exactement la même tokenisation.

Meta AI affirme que NLLB est bien meilleur que les études précédentes car ils peuvent toujours obtenir de meilleurs scores spBLEU que les scores BLEU publiés précédemment, l'inverse est vrai. Car obtenir un score spBLEU inférieur au score BLEU pour une traduction donnée est une tâche extrêmement difficile. Ce qui est encore plus déroutant, c'est que si leur objectif est d'obtenir le score le plus élevé, pourquoi ne pas simplement utiliser la métrique chrBLEU.

Par exemple dans Google Translate et Reference Translate, chaque caractère devient un jeton (c'est-à-dire que des espaces sont ajoutés entre les caractères).

Ensuite, nous calculons la valeur chrBLEU à 75,5, soit 20,7 points de plus que spBLEU. Selon l'évaluation du NLLB, il s'agira d'une amélioration significative qui constituera un nouveau point culminant pour la traduction automatique, tandis que le Google Translate original reste inchangé.

Exemples d'erreurs dans les articles

Maintenant, regardons un exemple concret d'évaluation NLLB.

Meta AI prétend avoir surpassé les travaux précédents en comparant ses chiffres aux chiffres précédemment publiés. Dans cet article, les conclusions sont tirées des tableaux 30, 31, 32, 35, 36, 37 et 38, qui sont comparés aux travaux antérieurs.

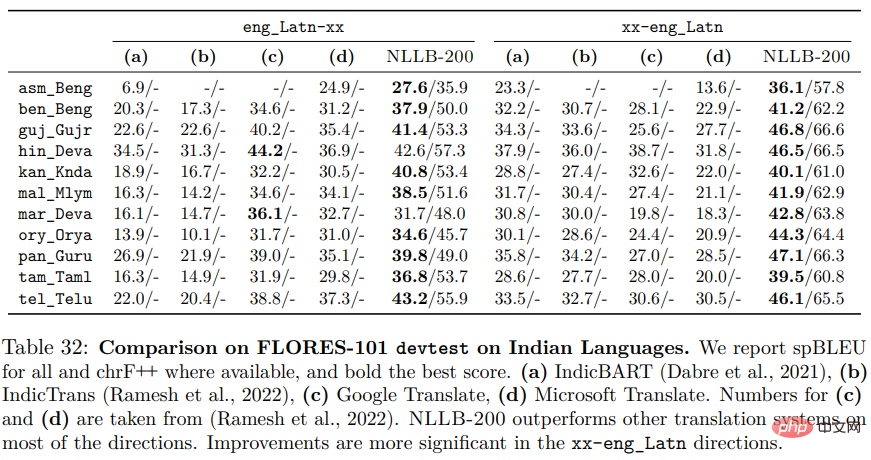

partira du tableau 32. C’est l’un des exemples les plus illustratifs en raison des différents types d’erreurs qui peuvent survenir.

Dans le tableau, tous les nombres à l'exception de la colonne NLLB-200 sont copiés directement à partir des articles précédemment publiés IndicBART et IndicTrans. Pour faciliter la lecture, Meta AI marque le score le plus élevé pour chaque langue en gras, la colonne en gras indiquant que le système correspondant est le meilleur.

Le tableau montre spBLEU pour tous, ce qui est trompeur. En fait, tout signifie uniquement NLLB-200, puisque IndicBART et IndicTrans n'utilisent pas spBLEU mais BLEU. Cependant, après comparaison, il s’avère que le score spBLEU du NLLB est supérieur au score BLEU des travaux antérieurs. Mais cela signifie-t-il que NLLB est meilleur ? Est-ce que 30 tomates valent mieux que 25 bananes ?

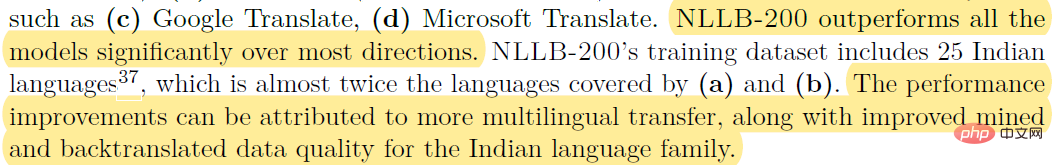

Dans le texte expliquant les résultats, on peut voir :

Par exemple (c) Google Translate, (d) Microsoft Translate. Le NLLB-200 surpasse considérablement tous les modèles dans la plupart des directions. L'ensemble de données de formation pour NLLB-200 comprend 25 langues indiennes, soit presque deux fois plus que celles couvertes par (a) et (b). Les améliorations des performances peuvent être attribuées à davantage de transmissions multilingues, ainsi qu'à une meilleure qualité des données pour l'exploration des langues indiennes et la rétro-traduction.

En d’autres termes, NLLB contient plus de tomates que l’étude précédente n’avait de bananes. Donc NLLB a plus de bananes.

Les scores spBLEU sont supérieurs aux scores BLEU car ils sont calculés sur des jetons plus petits et différents. Cependant, NLLB traduit-il mieux ? Nous ne pouvons tout simplement pas répondre. Pour aggraver les choses, IndicBART et IndicTrans ne sont pas comparables car ils utilisent tous deux deux méthodes de jetons différentes.

La plupart des tableaux répertoriés ci-dessus ont des problèmes similaires et contiennent plus ou moins d'erreurs.

Si vous regardez les articles publiés par IndicBART et IndicTrans pour vérifier les chiffres, vous verrez qu'il y a d'autres problèmes. Les colonnes (a, b) du tableau 32 sont toutes inversées, les numéros IndicBART sont les numéros dans indicatrans et vice versa.

Si vous regardez le tableau 30, le problème est encore plus grand.  Cependant, le tableau 30 a été mis à jour dans le journal et Benjamin Marie a exprimé sa gratitude à Vedanuj pour la mise à jour de l'article. Le tableau 30 mentionne que le tokenizer est le même. J'avoue mon erreur.

Cependant, le tableau 30 a été mis à jour dans le journal et Benjamin Marie a exprimé sa gratitude à Vedanuj pour la mise à jour de l'article. Le tableau 30 mentionne que le tokenizer est le même. J'avoue mon erreur.

Comme le montre le tableau 32, Meta AI affirme que NLLB surpasse les précédents DeltaLM et Deepnet, tout en comparant les scores BLEU obtenus en utilisant différentes méthodes de calcul. Ce qui est nouveau ici, c'est qu'ils ont également comparé NLLB à leurs travaux précédents, M2M-100, également évalués à l'aide de spBLEU. Alors cette comparaison a-t-elle un sens ? Non. Même s’ils utilisent tous deux spBLEU, ils utilisent en réalité des tokenizers différents, ce qui rend la comparaison impossible. Ils font la déclaration suivante dans la note de bas de page 28 :

"Notre analyse montre que lorsqu'ils sont mesurés sur le langage FLORES-101, le SPM-200 de FLORES-200 et le SPM-100 de FLORES-101 Là Il y a de petites différences entre les modèles. Le principal avantage du SPM-200 est qu'il couvre plus de 200 langues.

De petites différences sont aussi des différences. Dans ce cas, ces différences sont importantes car nous menons des recherches scientifiques.

Une avancée de NLLB par rapport à leur travail sur M2M-100 est l'ajout de plus de langues au modèle et à l'ensemble de données. Il inclut le modèle de tokenisation. Techniquement parlant, si vous ajoutez plus de langues avec des systèmes d'écriture différents à ce tokenizer tout en gardant la taille du vocabulaire constante, vous obtiendrez mécaniquement un vocabulaire avec des jetons plus petits. Comme vu ci-dessus, l’utilisation de jetons plus petits peut entraîner de meilleurs scores. Vérifions-le.

Comme le montre la figure ci-dessous :

Cette tokenisation génère 95 jetons, tandis que NLLB génère 97 jetons. Ce n'est qu'une différence subtile, si spBLEU est calculé à l'aide de la tokenisation M2M-100, le score est de 53,8, soit 1 point de moins que la tokenisation NLLB. Selon la littérature de recherche sur la traduction automatique, une différence de 1 point suffit généralement pour affirmer qu’un système est nettement meilleur. Comme prévu, NLLB produira des scores plus élevés que M2M-100.

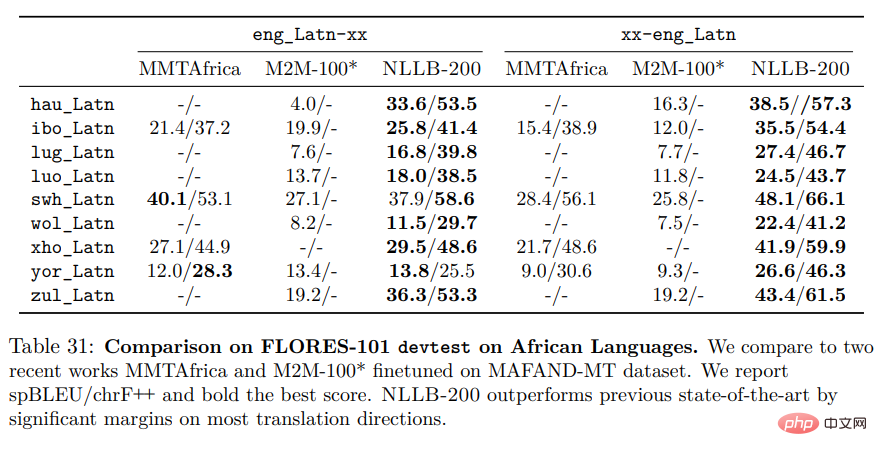

Le tableau suivant est le dernier tableau de cet article : Tableau 31.

Encore une fois, nous avons les mêmes problèmes mentionnés ci-dessus :

1. M2M-100 et NLLB utilisent deux tokenisations différentes pour la notation, la comparaison ne peut donc pas être effectuée. 2. MMTAfrica semble utiliser la tokenisation M2M-100 dans son article. C'est comparable au M2M-100, mais pas au NLLB.

Il y a encore quelques questions dans l'article, je ne les présenterai donc pas une par une ici. La principale erreur commise par Meta AI dans NLLB est une erreur très courante dans l'évaluation de la traduction automatique, même si nous devons admettre que ce travail est vraiment étonnant et peut fournir une qualité de traduction supérieure pour de nombreuses langues.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI