Maison >Périphériques technologiques >IA >La dernière recherche de Microsoft explore la technologie LoRAShear pour l'élagage LLM et la récupération des connaissances

La dernière recherche de Microsoft explore la technologie LoRAShear pour l'élagage LLM et la récupération des connaissances

- 王林avant

- 2023-11-13 17:37:291596parcourir

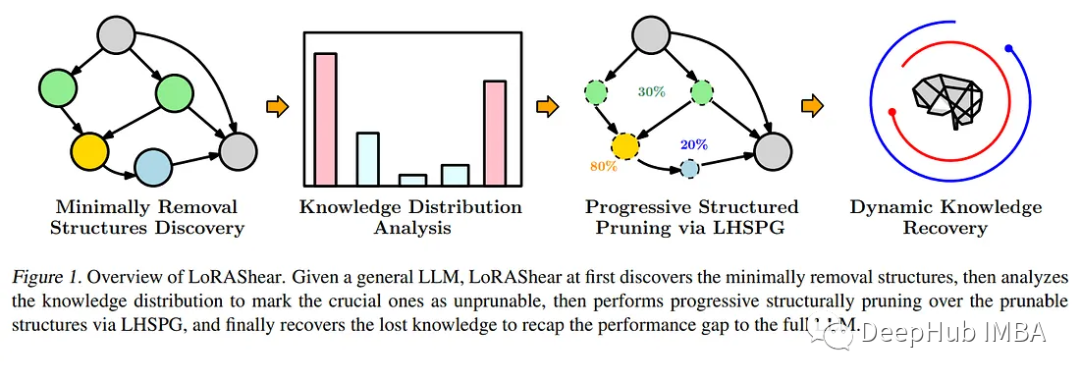

LoRAShear est une nouvelle méthode développée par Microsoft pour optimiser les modèles de langage (llm) et préserver les connaissances. Il permet un élagage structurel, réduisant les besoins de calcul et améliorant l’efficacité.

La technologie LHSPG (Lora Half-Space Projected Gradient) prend en charge l'élagage structuré progressif et la récupération dynamique des connaissances. Peut être appliqué à divers LLM via l'analyse des graphes de dépendances et l'optimisation de la parcimonie

LoRAPrune combine LoRA avec un élagage structuré itératif pour obtenir un réglage fin efficace des paramètres. Même avec un élagage important sur LLAMA v1, ses performances restent assez élevées

Dans le domaine en évolution de l'intelligence artificielle, les modèles de modèles de langage (llm) sont devenus un outil important pour traiter de grandes quantités de données textuelles, en récupérant rapidement les données pertinentes. l’information et les outils clés pour améliorer l’accessibilité des connaissances. Leur impact considérable couvre des domaines allant de l’amélioration des moteurs de recherche et des systèmes de questions-réponses à l’analyse de données, bénéficiant ainsi aux chercheurs, aux professionnels et aux chercheurs de connaissances.

Le plus gros problème à l'heure actuelle est que LLM doit continuellement mettre à jour ses connaissances pour répondre aux exigences dynamiques de l'information. En règle générale, les développeurs affinent les modèles pré-entraînés à l'aide de données spécifiques au domaine pour les maintenir à jour et intégrer les dernières informations au modèle. Des mises à jour régulières sont essentielles pour les organisations et les chercheurs afin de garantir que LLM suit le rythme du paysage de l'information en constante évolution. Cependant, le coût du réglage fin est élevé et le cycle est long

En réponse à ce besoin urgent, les chercheurs de Microsoft ont lancé une méthode révolutionnaire : LoRAShear. Cette approche innovante simplifie non seulement le LLM mais facilite également la récupération des connaissances structurelles. Le cœur de l’élagage structurel consiste à supprimer ou à réduire des composants spécifiques de l’architecture du réseau neuronal afin d’optimiser l’efficacité, la compacité et les exigences de calcul.

LoRAShear de Microsoft utilise la technologie LHSPG pour prendre en charge l'élagage structuré progressif. Cette approche permet de transférer de manière transparente les connaissances entre les modules LoRA et intègre également une étape dynamique de récupération des connaissances. Le processus de réglage fin est similaire à la pré-formation et au réglage fin guidé pour garantir que le LLM reste à jour et pertinent

Réécrit comme suit : Tirant parti de l'analyse des graphes de dépendances, LoRAShear peut être étendu au LLM général, en particulier avec le support de le module LoRA. Cette méthode utilise les modules LLM et LoRA originaux pour créer un graphe de dépendance et introduit un algorithme d'optimisation de parcimonie structuré qui utilise les informations des modules LoRA pour améliorer la préservation des connaissances pendant le processus de mise à jour du poids

Dans l'article, il s'agit également d'une technique intégrée appelé LoRAPrune est mentionné, qui combine LoRA avec un élagage structuré itératif pour obtenir un réglage fin efficace des paramètres et une accélération matérielle directe. Cette méthode d'économie de mémoire repose entièrement sur les poids et les gradients de LoRA pour les critères d'élagage. Le processus spécifique comprend la construction d'un graphique de suivi, la détermination des groupes de nœuds qui doivent être compressés, la division des variables pouvant être entraînées et enfin leur renvoi à LLM

L'article prouve l'efficacité de LoRAShear grâce à la mise en œuvre sur l'open source LLAMAv1. Notamment, LLAMAv1 avec un élagage de 20 % ne subit qu'une perte de performances de 1 %, tandis que le modèle avec un élagage de 50 % conserve 82 % des performances sur le benchmark d'évaluation.

LoRAShear représente une avancée majeure dans le domaine de l'intelligence artificielle. Cela simplifie non seulement la façon dont le LLM est utilisé, le rendant plus efficace, mais garantit également la préservation des connaissances critiques. Il permet aux applications basées sur l'IA de suivre le rythme de l'évolution de l'environnement informationnel tout en optimisant les ressources informatiques. Alors que les organisations s'appuient de plus en plus sur l'intelligence artificielle pour le traitement des données et la récupération des connaissances, des solutions telles que LoRAShear joueront un rôle clé sur le marché, en assurant efficacité et résilience des connaissances.

Adresse papier : https://arxiv.org/abs/2310.18356

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Que signifie l'intelligence artificielle Python ?

- Classification de l'intelligence artificielle

- Les deux domaines de recherche de l'intelligence artificielle sont

- Quelles sont les quatre caractéristiques majeures de l'intelligence artificielle du futur ?

- Quelles sont les caractéristiques d'application de la technologie de l'intelligence artificielle dans l'armée ?