Maison >Périphériques technologiques >IA >Prix papier ICCV'23 'Combat des Dieux' ! Meta Divide Everything et ControlNet ont été sélectionnés conjointement, et un autre article a surpris les juges.

Prix papier ICCV'23 'Combat des Dieux' ! Meta Divide Everything et ControlNet ont été sélectionnés conjointement, et un autre article a surpris les juges.

- 王林avant

- 2023-10-04 20:37:011562parcourir

ICCV 2023, la plus grande conférence sur la vision par ordinateur qui s'est tenue à Paris, en France, vient de se terminer !

Le prix du meilleur article de cette année est tout simplement un « combat entre dieux ».

Par exemple, les deux articles qui ont remporté le prix du meilleur article incluent le travail qui a bouleversé le domaine de l'IA vincentienne - ControlNet.

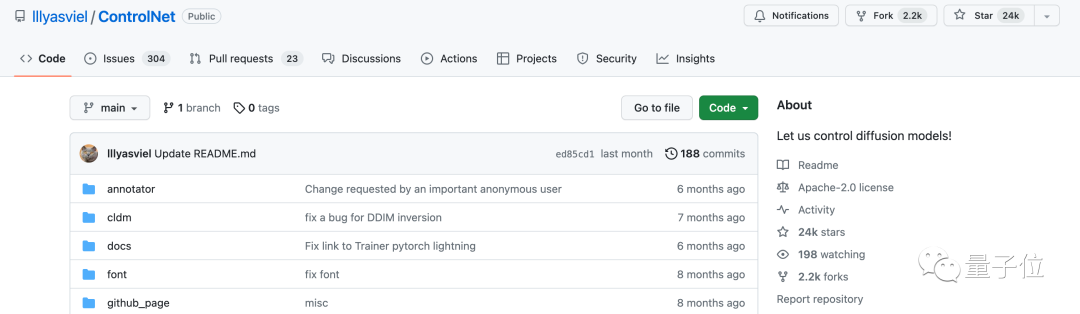

Depuis l'open source, ControlNet a reçu 24 000 étoiles sur GitHub. Que ce soit pour le modèle de diffusion ou pour l'ensemble du domaine de la vision par ordinateur, le prix de cet article est bien mérité

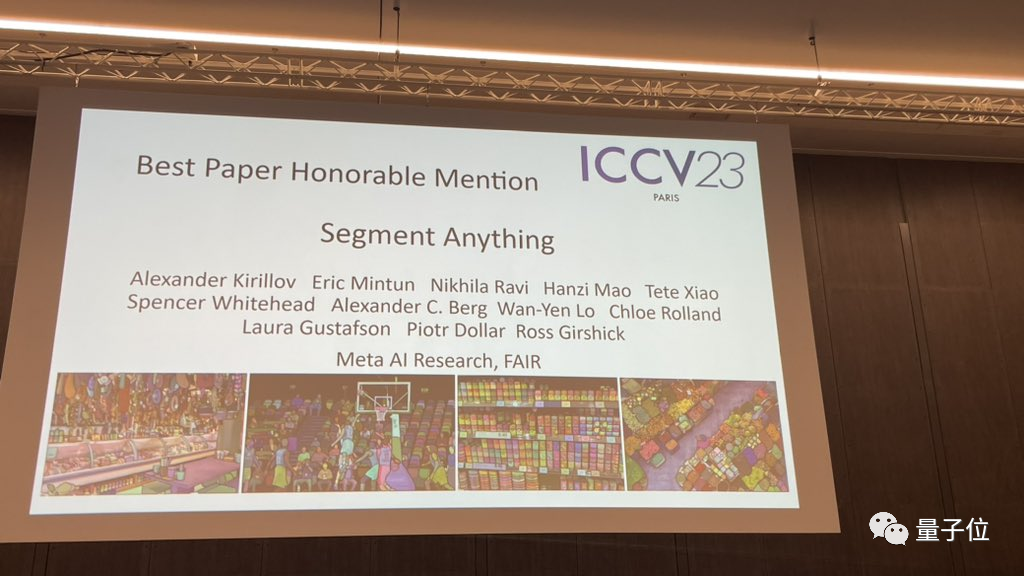

La mention honorable pour le Best Paper Award a été décernée à un autre article tout aussi célèbre, Meta's « Split Everything » modèle SAM.

Depuis son lancement, « Segment Everything » est devenu la « référence » pour divers modèles d'IA de segmentation d'images, dont de nombreux FastSAM, LISA et SegGPT venus de derrière, qui l'utilisent tous comme référence de référence pour les tests d'efficacité.

Les nominations papier sont toutes si lourdes. À quel point la concurrence est-elle féroce dans cet ICCV 2023 ?

L'ICCV 2023 a soumis un total de 8 068 articles, mais seulement environ un quart, soit 2 160 articles ont été acceptés.

Près de 10 % des articles provenaient de Chine. En plus des universités, il existe également de nombreuses institutions industrielles, telles que. SenseTime 49 articles issus de la science et de la technologie et de laboratoires communs ont été sélectionnés pour l'ICCV 2023, et 14 articles de Megvii ont été sélectionnés.

Jetons un coup d'œil aux articles qui ont remporté les prix de l'ICCV 2023

ControlNet a remporté le meilleur article de l'ICCV

Jetons d'abord un coup d'œil aux deux articles qui ont remporté le prix du meilleur article (Marr Award) cette année

Meilleur article ICCV Également connu sous le nom de Marr Prize (Marr Prize), sélectionné tous les deux ans et est connu comme l'une des plus hautes distinctions dans le domaine de la vision par ordinateur.

Ce prix porte le nom de David Marr, pionnier dans le domaine de la vision par ordinateur et fondateur des neurosciences computationnelles

Le premier lauréat du prix du meilleur article est "Adding Conditional Control for Text-to-Image Diffusion Models" de Stanford

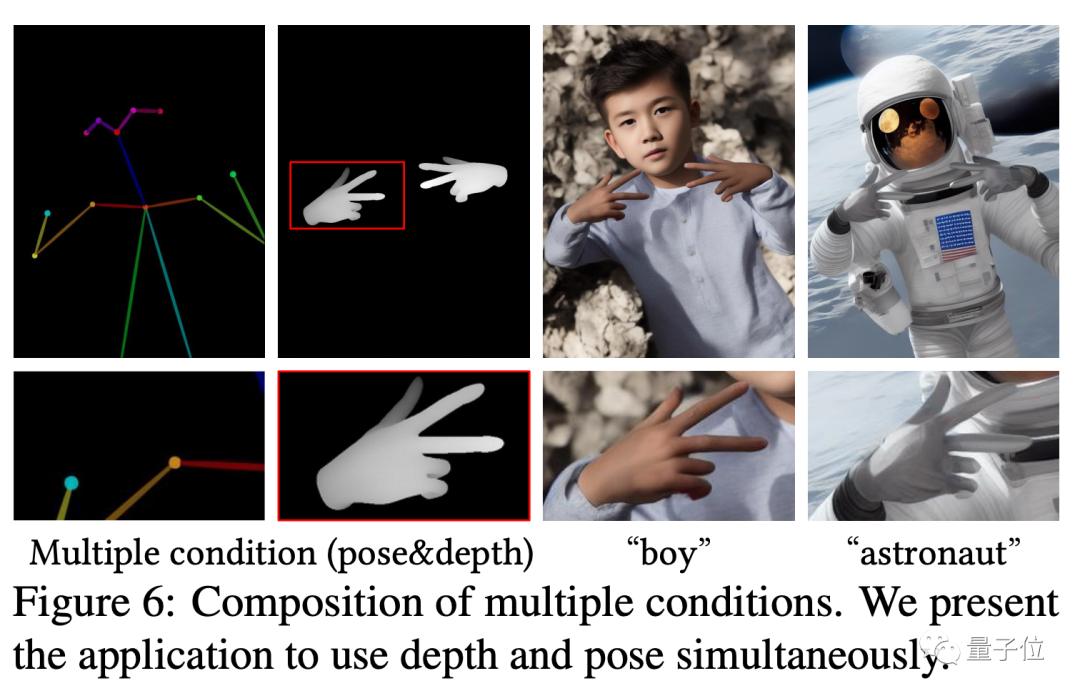

Cet article propose un modèle appelé ControlNet, qui peut contrôler les détails de sa génération en ajoutant simplement une entrée supplémentaire au modèle de diffusion pré-entraîné.

Les entrées ici peuvent être de différents types, notamment des croquis, des images de contour, des images de segmentation sémantique, des caractéristiques des points clés du corps humain, des lignes droites de détection de transformation de Hough, des cartes de profondeur, des os humains, etc. Ce qu'on appelle « l'IA peut dessiner des mains ", le noyau La technologie vient de cet article.

Son idée et son architecture sont les suivantes :

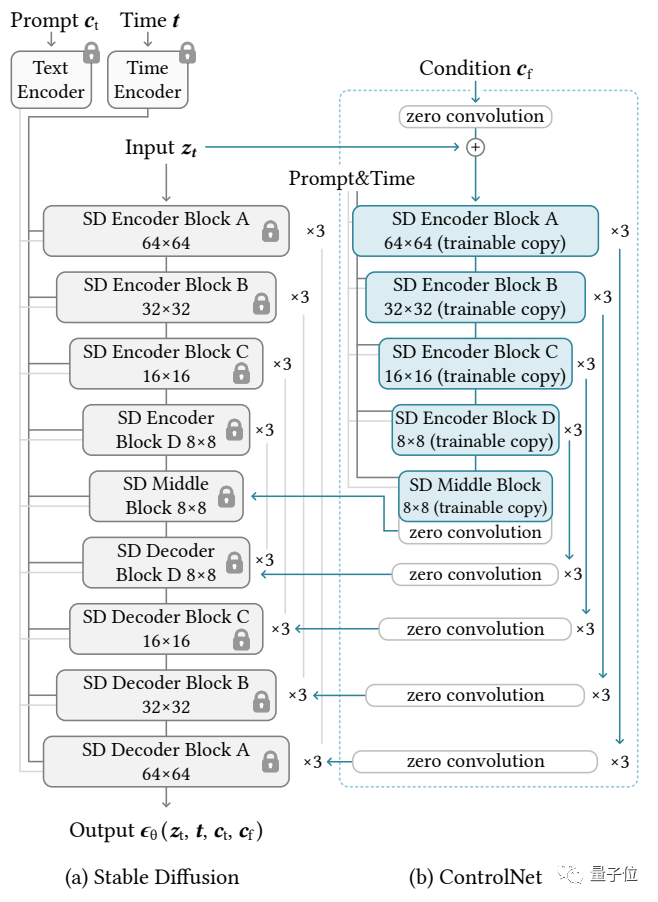

Le réseau de contrôle copie d'abord les poids du modèle de diffusion pour obtenir une "copie entraînable"

En revanche, le modèle de diffusion original a été pré-entraîné sur des milliards de images , donc les paramètres sont "verrouillés". Et cette « copie entraînable » n'a besoin que d'être entraînée sur un petit ensemble de données d'une tâche spécifique pour apprendre le contrôle conditionnel.

Même si la quantité de données est très faible (pas plus de 50 000 images), le contrôle conditionnel généré par le modèle après entraînement est très bon.

Connectés via une couche convolutive 1×1, le « modèle verrouillé » et la « copie entraînable » forment une structure appelée « couche convolutive 0 ». Les poids et biais de cette couche convolutive 0 sont initialisés à 0, de sorte qu'une vitesse très rapide puisse être obtenue pendant le processus d'entraînement, proche de la vitesse de réglage fin du modèle de diffusion, et peut même être entraînée sur des appareils personnels

Par exemple, si vous utilisez 200 000 données d'image pour entraîner une NVIDIA RTX 3090TI, cela ne prendra que moins d'une semaine

Zhang Lingmin est le premier auteur de l'article ControlNet et est actuellement doctorant à l'Université de Stanford. En plus de ControlNet, il a également créé des œuvres célèbres telles que Style2Paints et Fooocus

Adresse papier : https://arxiv.org/abs/2302.05543

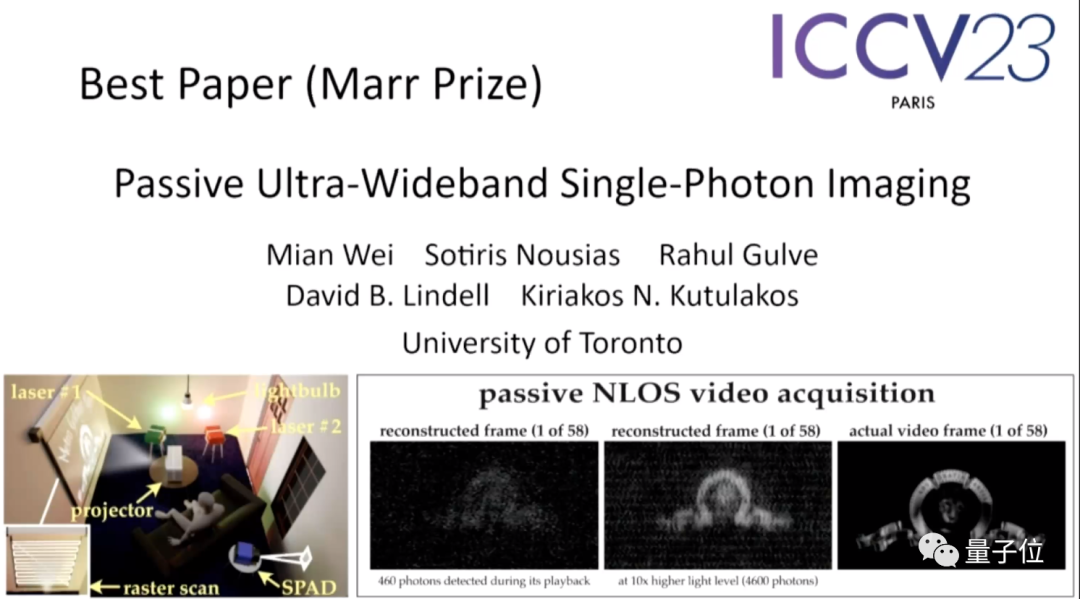

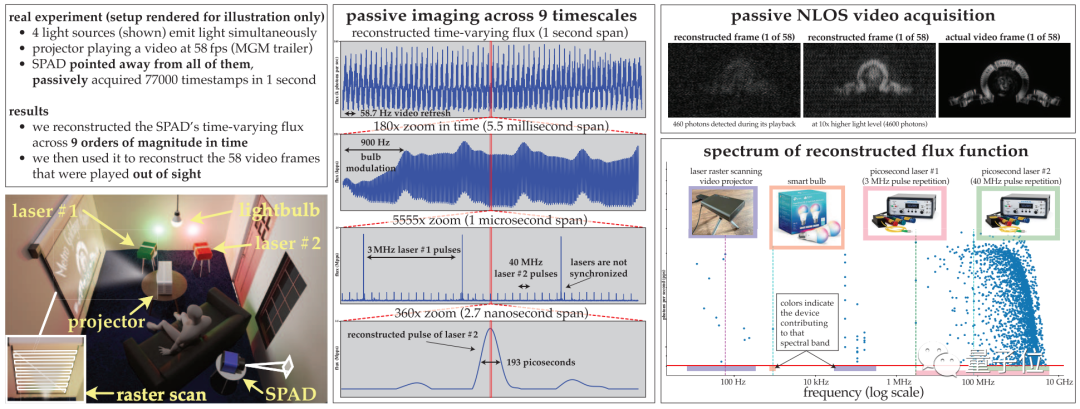

Le deuxième article "Passive Ultra-Wideband Single-Photon lmaging", de Université de Toronto.

Cet article a été qualifié de "l'article le plus surprenant sur le sujet" par le comité de sélection, à tel point que l'un des juges a déclaré "qu'il lui était presque impossible de penser à essayer une telle chose".

Le résumé de l'article est le suivant :

Cet article explique comment imager simultanément des scènes dynamiques à des échelles de temps extrêmes (de quelques secondes à picosecondes) tout en nécessitant une imagerie passive (sans envoyer activement de grandes quantités de signaux lumineux) et est effectué dans des conditions de très faible luminosité et ne repose sur aucun signal de synchronisation provenant de la source lumineuse.

Étant donné que les techniques existantes d'estimation du flux optique pour les caméras à photon unique échouent dans cette plage, cet article développe une théorie de détection du flux optique qui s'appuie sur l'idée du calcul stochastique pour partir de temps de détection de photons à augmentation monotone. pixels reconstruits dans le flux poke.

Basé sur cette théorie, l'article fait principalement trois choses :

(1) Montre que dans des conditions de faible flux optique, une caméra passive à détection de longueur d'onde à photon unique à fonctionnement libre a une bande passante de fréquence réalisable s'étendant de DC à 31 GHz sur l'ensemble spectre de la plage ;

(2) dériver un nouvel algorithme de reconstruction de flux optique dans le domaine de Fourier pour analyser les données d'horodatage pour des fréquences avec un support statistiquement significatif

(3) garantir que le modèle de bruit de l'algorithme est toujours efficace avec un faible nombre de photons ou non ; temps morts négligeables.

Les auteurs ont démontré expérimentalement le potentiel de cette méthode d'imagerie asynchrone, y compris des capacités sans précédent :

(1) Traitement d'images à différentes vitesses sans synchronisation (par exemple, ampoules, projecteurs, lasers multi-impulsions) Imagerie de la scène éclairée par une lumière courante sources en même temps ;

(2) Collection vidéo passive sans visibilité directe ;

(3) Enregistrement de vidéo ultra-large bande, qui peut être lue à une fréquence de 30 Hz, montrant le mouvement quotidien, mais peut également être relu au milliardième de seconde pour montrer comment la lumière se déplace.

Mian Wei, le premier auteur de l'article, est étudiant au doctorat à l'Université de Toronto. Son domaine de recherche est la photographie computationnelle. Son intérêt actuel en matière de recherche réside dans l'amélioration des algorithmes de vision par ordinateur basés sur la technologie d'imagerie par illumination active.

Veuillez cliquer sur le lien suivant pour consulter l'article : https://openaccess.thecvf.com/content/ICCV2023/papers/Wei_Passive_Ultra-Wideband_Single-Photon_Imaging_ICCV_2023_paper.pdf

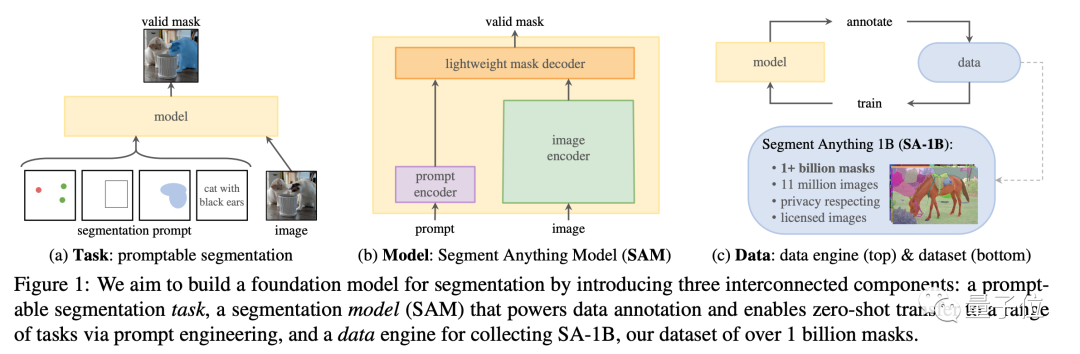

"Dividing Everything" a reçu une mention honorable

à cette conférence, en plus du très attendu ControNet, le modèle "Split Everything" de Meta a également reçu une mention honorable pour le Best Paper Award, devenant ainsi un sujet très attendu à l'époque. Cet article proposait non seulement l'un des plus grands courants L'image. L'ensemble de données de segmentation contient plus d'un milliard de masques sur 11 millions d'images, et un modèle SAM a été formé à cet effet, qui peut segmenter rapidement les images invisibles.

Par rapport aux modèles de segmentation d'images fragmentées précédents, on peut dire que SAM a « unifié » les fonctions de cette série de modèles et a montré de bonnes performances dans diverses tâches.

Ce modèle open source compte actuellement 38,8k étoiles sur GitHub, ce qui peut être considéré comme la "référence" dans le domaine de la segmentation sémantique

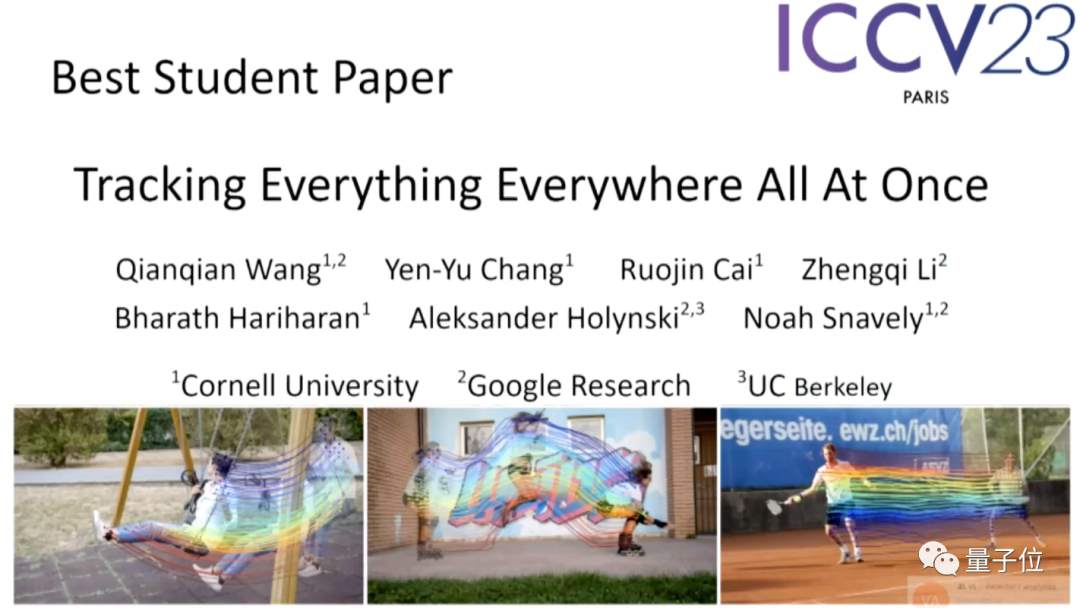

Dans les travaux des étudiants, le modèle « suivre tout » de Google se démarque

Tout comme le titre de l'article, ce modèle peut suivre simultanément des objets dans des images à n'importe quel endroit Suivi au niveau des pixels de n'importe quel (plusieurs)

Le premier auteur de ce projet est Qianqian Wang, un docteur chinois de l'Université Cornell, qui effectue actuellement des recherches postdoctorales à l'UCB.

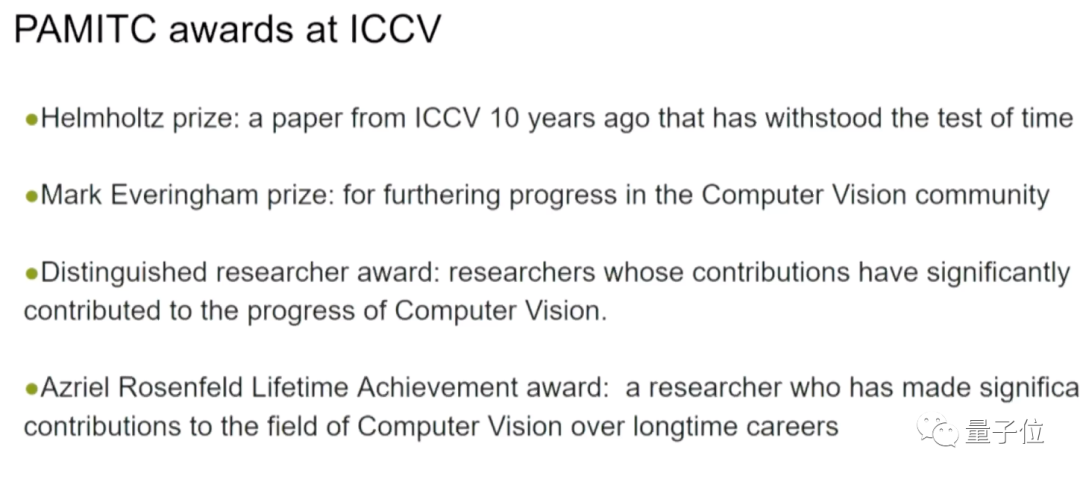

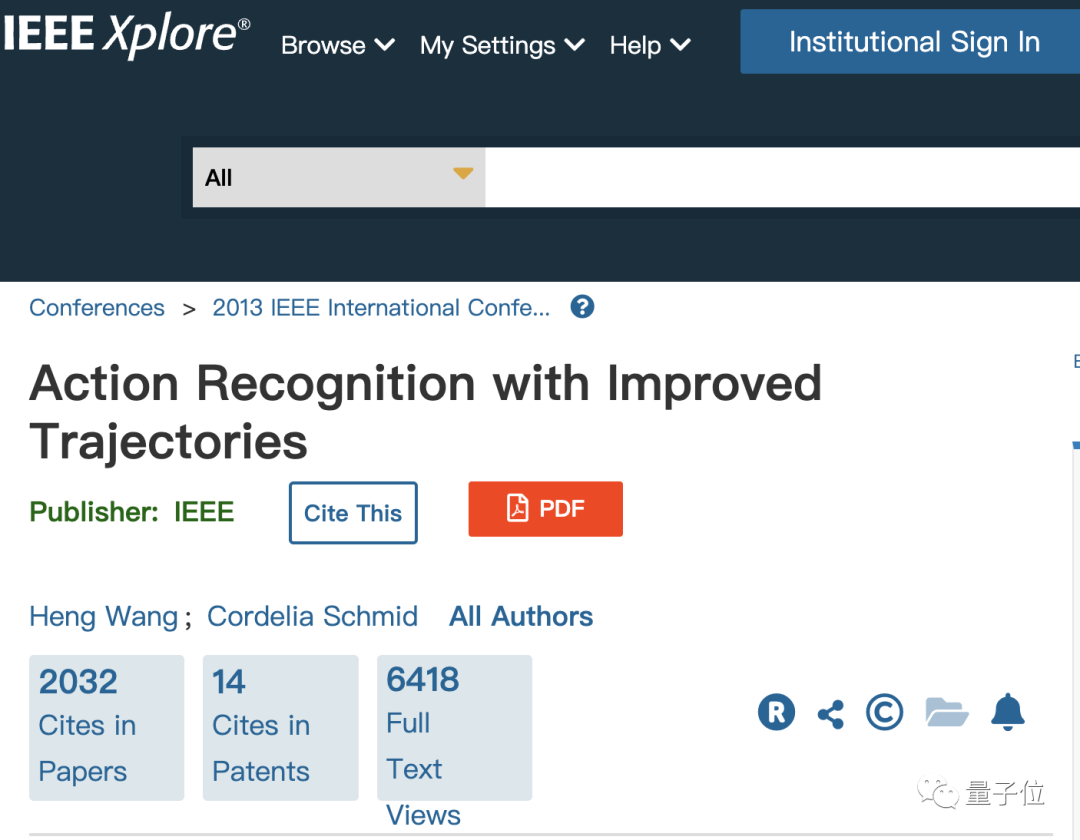

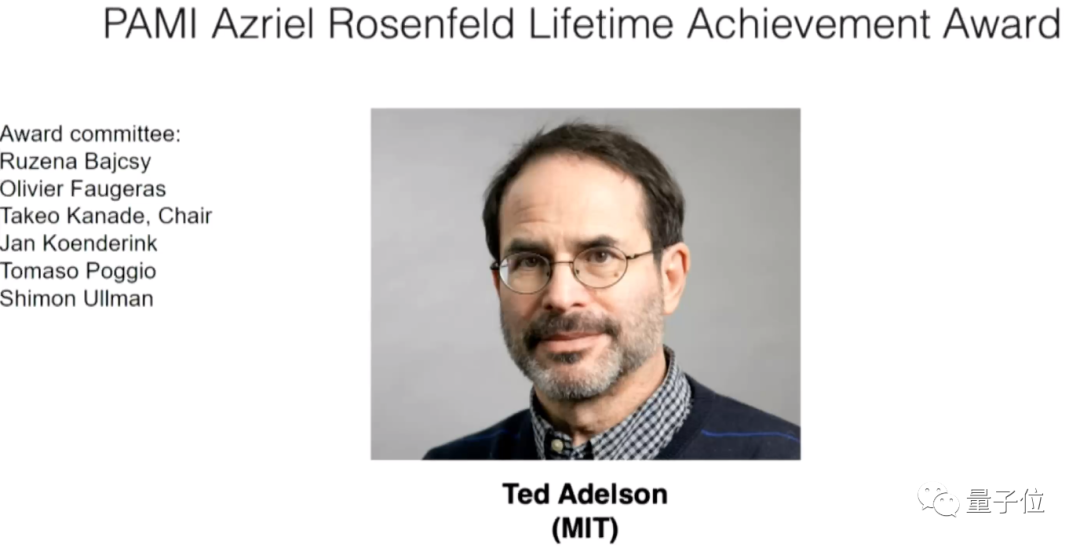

Lors de la cérémonie d'ouverture, des prix spéciaux offerts par les membres du comité PAMITC ont également été annoncés, qui ont également décerné des prix pour deux conférences sur le domaine de la vision par ordinateur, CVPR et WACV. Les quatre prix suivants ont été inclus : Les scientifiques qui ont remporté le prix Helmholtz sont le scientifique chinois Heng Wang et Cordelia Schmid de Google, qui sont membres de Meta AI Ils ont remporté le prix pour un article publié en 2013 sur la reconnaissance de l'action. À cette époque, tous deux travaillaient au laboratoire Lear de l'Institut national de l'informatique et de l'automatisation (INRIA), et Schmid était à l'époque le responsable du laboratoire. Veuillez cliquer sur le lien suivant pour consulter l'article : https://ieeexplore.ieee.org/document/6751553 Le prix Everingham a été décerné à deux équipes Le gagnant du premier groupe est Samer de Google Agarwal, Keir Mierle et leur équipe Les deux gagnants sont respectivement diplômés de l'Université de Washington et de l'Université de Toronto. Leur réussite est de développer un projet de bibliothèque C++ open source Ceres Solver largement utilisé. dans le domaine de la vision par ordinateur. Lien vers la page d'accueil : http://ceres-solver.org/ Un autre résultat primé est l'ensemble de données COCO, qui contient un grand nombre d'images et d'annotations, a un contenu et des tâches riches. , et constituent des données importantes pour tester l'ensemble de modèles de vision par ordinateur. Cet ensemble de données a été proposé par Microsoft. Le premier auteur de l'article concerné est le scientifique chinois Tsung-Yi Lin. Il est diplômé de l'Université Cornell et travaille maintenant comme chercheur aux NVIDIA Labs. Adresse papier : https://arxiv.org/abs/1405.0312 Celui qui a remporté l'honneur de chercheur exceptionnel était le Les professeurs allemands Max Planck Michael Black de l'Institut et Rama Chellappa de l'Université Johns Hopkins. Le professeur Ted Adelson du MIT a remporté le Lifetime Achievement Award Votre article a-t-il été accepté par l'ICCV 2023 ? Que pensez-vous de la sélection des prix de cette année ?

Page d'accueil du projet : https://cocodataset.org/

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Quelles sont les propriétés du modèle de boîte en CSS ? Introduction aux propriétés liées au modèle de boîte CSS

- Quels sont les trois types de modèles de données de base de données ?

- Qu'est-ce qu'un modèle de développement logiciel et quels sont les modèles de développement logiciels courants ?

- Quel est le modèle OSI