Maison >Périphériques technologiques >IA >Open Interpreter : un outil open source qui permet à de grands modèles de langage d'exécuter du code localement

Open Interpreter : un outil open source qui permet à de grands modèles de langage d'exécuter du code localement

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-09-27 10:21:131048parcourir

J'ai récemment découvert un artefact en parcourant Github, appelé Open Interpreter, qui est principalement utilisé pour interagir localement avec de grands modèles de langage. Il convertit le langage naturel en code de script via le grand modèle de langage, puis l'exécute localement.

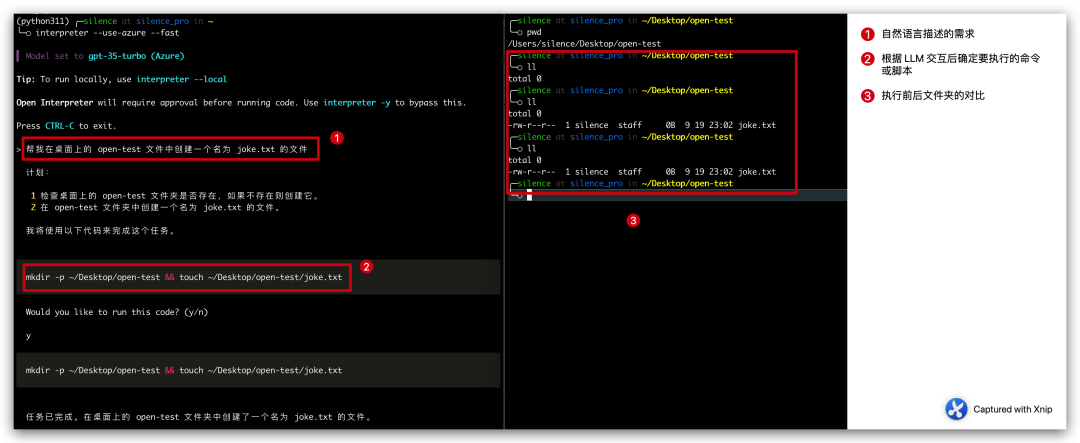

En bref, si vous souhaitez créer un fichier nommé joke.txt sur votre bureau, vous n'avez pas besoin de le créer manuellement, mais vous pouvez le dire à Open Interpreter en langage naturel et le laisser nous aider à générer un script pour créer le fichier, puis Exécuter localement pour générer un fichier joke.txt

Tout ce que nous avons à faire est de lui dire quels sont nos besoins et de lui permettre d'exécuter le code localement.

Veuillez réécrire le contenu en chinois sans changer le sens original. Il n'est pas nécessaire d'afficher la phrase originale

image

image

L'ensemble du processus du cas ci-dessus est divisé en trois étapes :

- Nous décrivons une exigence en langage naturel : Aidez-moi à créer un fichier nommé blague dans le fichier open-test sur le bureau. fichier txt

- Open Interpreter démontera nos besoins et listera son plan d'exécution et les commandes à exécuter.

计划: 1 检查桌面上的 open-test 文件夹是否存在,如果不存在则创建它。 2 在 open-test 文件夹中创建一个名为 joke.txt 的文件。我将使用以下代码来完成这个任务。mkdir -p ~/Desktop/open-test && touch ~/Desktop/open-test/joke.txt

- a été exécuté après notre confirmation manuelle, et le fichier a finalement été créé avec succès.

Ce projet vient de démarrer, et ce cas est également très simple, mais il faut savoir que cela semble ouvrir une autre porte à l'avenir, tant que les fonctions qui peuvent être réalisées grâce au code, nous pouvons les implémenter. à travers le langage naturel. Pensez-y. C'était excitant (et effrayant).

Introduction officielle : cet outil peut être utilisé pour éditer des vidéos et envoyer des e-mails, ce qui ne peut être que très prometteur.

Installation et configuration

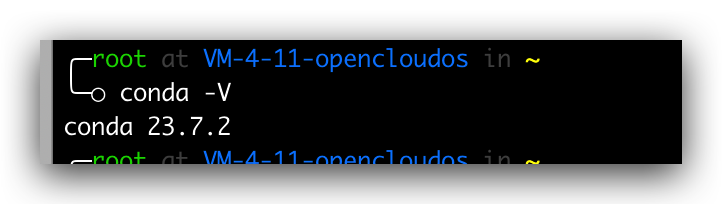

Installer conda

L'installation de ce projet est très simple. Normalement, il suffit d'exécuter pip install open-interpreter sur la ligne de commande. Cependant, afin d'assurer la stabilité de l'environnement, nous allons utiliser conda pour l'isolation de l'environnement. Par conséquent, nous devons d'abord installer conda et exécuter les commandes suivantes dans l'ordre

# 获取脚本wget https://repo.anaconda.com/archive/Anaconda3-2023.07-2-Linux-x86_64.sh# 增加可执行权限chmod +x Anaconda3-2023.07-2-Linux-x86_64.sh# 运行安装脚本./Anaconda3-2023.07-2-Linux-x86_64.sh# 查询版本conda -V

Si le numéro de version peut être affiché normalement, cela signifie que l'installation est réussie. Si la commande d'invite n'existe pas, nous devons alors configurer les variables d'environnement. , dans

vim .bash_profile# 加入下面一行PATH=$PATH:$HOME/bin:$NODE_PATH/bin:/root/anaconda3/bin# 再次执行conda -V

Picture

Picture

Créer un environnement d'isolation

Une fois l'installation de conda terminée, nous créons un environnement d'isolation pour la version Python spécifiée via la commande suivante

conda create -n python311 pythnotallow=3.11

La signification de cette ligne de code. consiste à créer un environnement d'isolation nommé python311 via conda create Isolation La version python de l'environnement est spécifiée comme 3.11. Une fois la création terminée, nous pouvons interroger la liste des environnements d'isolation via la commande suivante.

conda env list

Images

Images

Installez open-interpreter

Ensuite, nous entrons dans l'environnement d'isolement et installons l'interpréteur ouvert dans l'environnement d'isolement. La commande est la suivante

conda activate python311pip install open-interpreter

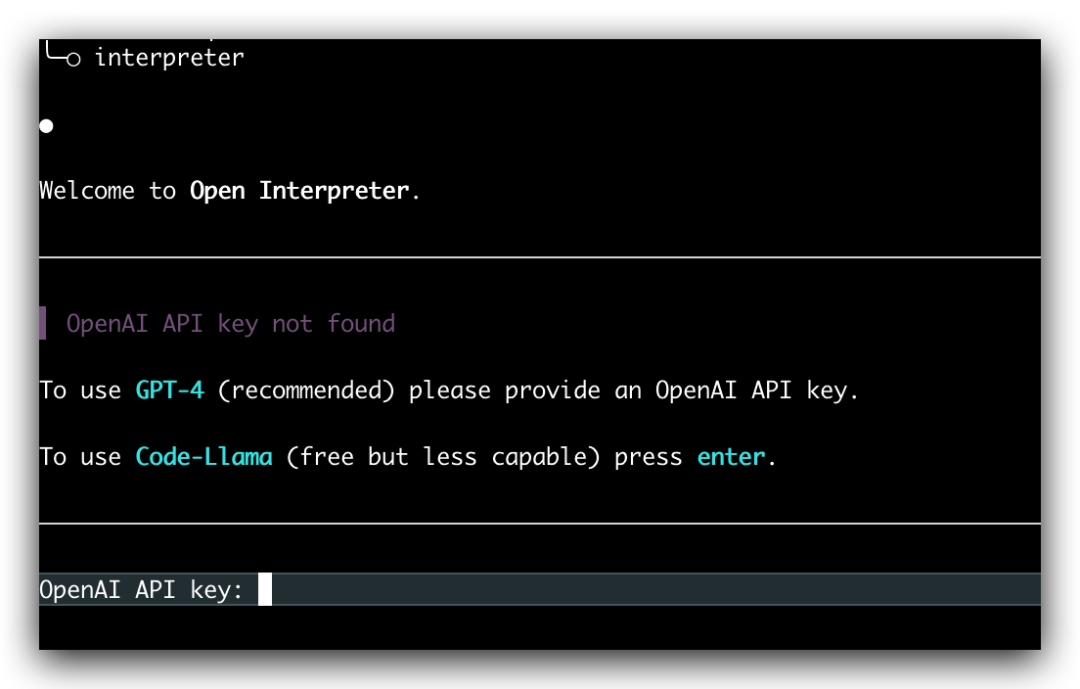

Attendez un moment et l'installation réussira après. l'installation est réussie, entrez la commande suivante, vous pouvez démarrer l'interaction du grand modèle de langage local.

interpreter

Image

Image

Pas besoin de changer le sens original, le contenu qui doit être réécrit est : Lorsque nous entrons directement dans la commande "interprète", il nous sera demandé de saisir notre clé API OpenAI. À l'heure actuelle, le modèle GPT-4 est utilisé par défaut, mais nous pouvons utiliser le modèle GPT-3.5 en ajoutant le paramètre "--fast"

interpreter --fast

Ici, nous devons remplir manuellement la clé API OpenAI à chaque fois. exécuté. C'est gênant, mais il peut être configuré. Définissez les variables d'environnement

export OPENAI_API_KEY=skxxxx

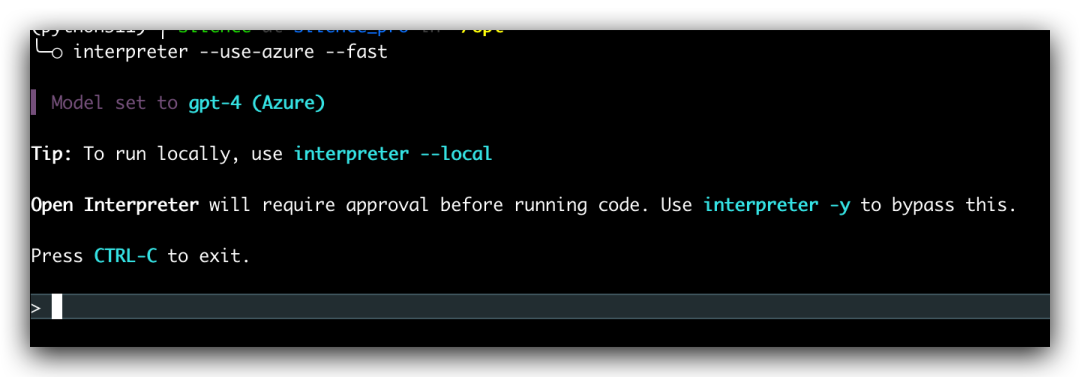

afin que nous n'ayons pas à remplir manuellement la clé API d'OpenAI pour les exécutions ultérieures. Si vous souhaitez utiliser Azure OpenAI de Microsoft, il est également pris en charge. Configurez simplement les variables d'environnement suivantes, puis ajoutez --use au démarrage Le paramètre -azure est suffisant

export AZURE_API_KEY=export AZURE_API_BASE=export AZURE_API_VERSION=export AZURE_DEPLOYMENT_NAME=

interpreter --use-azure

images

images

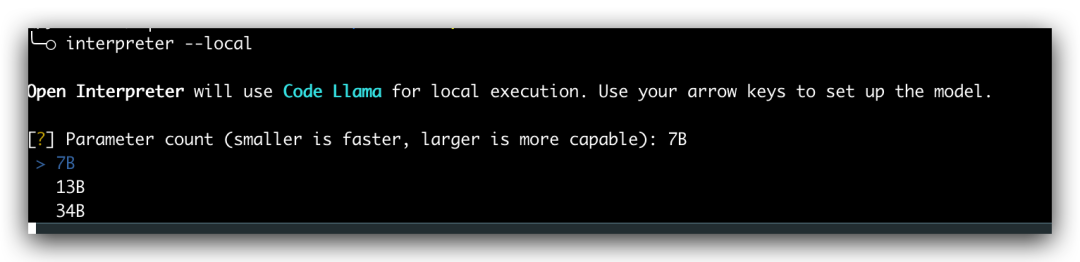

Démarrer localement

Toutes les opérations nécessitent que nous ayons la clé API OpenAI correspondante ou le point de terminaison OpenAI de Azuré. En fait, Open Interpreter prend également en charge l'exécution locale, ajoutez simplement le paramètre --local lors du démarrage, puis sélectionnez le modèle correspondant. Cependant, le fonctionnement local nécessite notre prise en charge de la configuration informatique. Les amis que cela intéresse peuvent se référer à la documentation officielle pour s'entraîner, mais ma configuration ne le permet pas

Photos

Photos

Résumé

Aujourd'hui, je vous ai présenté la méthode d'installation et le gameplay simple de l'interpréteur Open. Ce projet est actuellement en cours d’itération rapide et je pense qu’il entraînera une révolution dans un avenir proche. Il faut dire que l’ère de l’intelligence artificielle est véritablement arrivée et que les prochaines années seront une période de développement vigoureux des produits d’intelligence artificielle. En tant que programmeurs, nous devons suivre notre époque et ne pas prendre de retard

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!