Maison >Périphériques technologiques >IA >Le site officiel de WPS AI est en ligne : vous pouvez postuler pour des qualifications d'officier expérimenté et prendre en charge les téléchargements Windows et Android.

Le site officiel de WPS AI est en ligne : vous pouvez postuler pour des qualifications d'officier expérimenté et prendre en charge les téléchargements Windows et Android.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-07-11 15:09:101827parcourir

Photo 1

Photo 1

▲Capture d'écran du site officiel de WPS AI

Le 6 juillet, Kingsoft Office a officiellement annoncé aujourd'hui que le Site officiel de WPS AIest officiellement lancé. Les utilisateurs individuels et professionnels peuvent postuler pour le poste d'agent d'expérience. qualifications, support Téléchargez et installez sur Windows et Android, iOS n'est pas encore disponible.

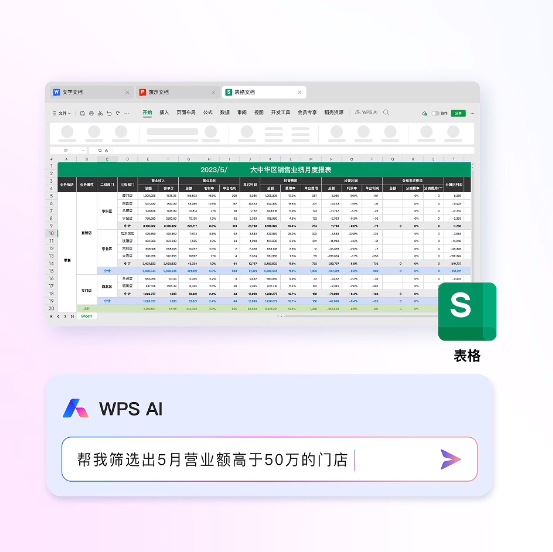

IT House a appris du compte officiel de Kingsoft Office que WPS AI prend en charge des fonctions telles que la génération de contenu et la génération de formules. Les utilisateurs peuvent saisir des sujets pour générer du contenu textuel et créer des PPT en un seul clic, analyser les données de tableaux pour générer des rapports, générer automatiquement des formules complexes, etc. Combinés à la fonction de prise de vue occasionnelle, ils peuvent numériser, identifier et analyser des fichiers, ainsi que le terminal mobile. prend en charge les opérations vocales.

Image 1

Image 1

▲ Boîte de conversation WPS AI

Actuellement, le texte, la présentation, le formulaire, le document intelligent PDF, le formulaire intelligent et le formulaire intelligent prennent tous en charge la fonction WPS AI Les capacités du produit dans chaque composant seront. L'expérience d'application est ouverte progressivement.

Photo 1

Photo 1

Photo 1

Photo 1

▲ Démonstration WPS AI

Selon les rapports précédents d'IT House, WPS AI a été officiellement publié en avril de cette année Selon les rapports, WPS AI est. a Les applications d'intelligence artificielle générative à grande échelle sous modèles de langage peuvent aider à générer des documents, prendre en charge plusieurs cycles de dialogue et traiter les documents existants.

Au début du mois, WPS AI Kingsoft Office a annoncé sa coopération avec l'équipe NVIDIA pour améliorer l'efficacité de l'inférence de la reconnaissance et de la compréhension des documents image via le GPU NVIDIA Tensor Core et TensorRT avec le déploiement du serveur d'inférence NVIDIA Triton, il a réussi à optimiser l'utilisation du GPU ; et a fourni une quantité de débit d'inférence élevée. Par rapport au processeur, son temps de pipeline est réduit de 84 % ; grâce au déploiement du serveur d'inférence NVIDIA Triton, son coût de déploiement est économisé de 23 %.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI