Maison >Périphériques technologiques >IA >Que l'IA soit partout ! Intel lance un nouveau VPU : l'efficacité énergétique ultra-élevée écrase le GPU

Que l'IA soit partout ! Intel lance un nouveau VPU : l'efficacité énergétique ultra-élevée écrase le GPU

- 王林avant

- 2023-06-06 08:06:091276parcourir

IA, intelligence artificielle, ce truc n'est en fait pas nouveau du tout.

Depuis les travaux de science-fiction des premières années jusqu'à leur mise en œuvre progressive plus tard, du super ordinateur IBM "Deep Blue" battant le maître d'échecs Kasparov en 1997 jusqu'à Google AlphaGo battant le champion de Go Lee Sedol en 2016, l'IA a toujours Cela fait des progrès et évolue tout le temps.

Cependant, en raison de diverses limitations dans les algorithmes de puissance de calcul, les capacités techniques, les scénarios d'application, etc., l'IA a toujours eu l'impression d'être un château en l'air.

Ce n'est qu'avec l'émergence de ChatGPT que l'IA a vraiment suscité l'enthousiasme des gens ordinaires. Nous avons découvert que l'IA est si puissante et si facilement disponible, ce qui rend de nombreux individus et entreprises enthousiasmés et fous.

Comme nous le savons tous, un matériel et des algorithmes suffisamment puissants et raisonnables sont les deux pierres angulaires d'une IA efficace et pratique. Dans cet engouement pour l'IA, NVIDIA est si fière de son succès dans le domaine du calcul haute performance. d'aménagement et de culture intensive, il est très approprié pour le développement d'IA cloud à très grande échelle.

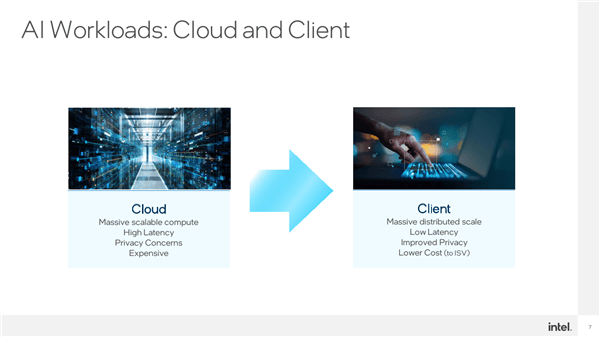

Bien entendu, l'IA est diversifiée en termes de méthodes de mise en œuvre et de scénarios d'application, tant du côté du cloud que du côté des appareils.

NVIDIA se concentre sur l'IA côté cloud et générative, Intel s'attaque à la fois au jugement génératif côté cloud et côté appareil. À mesure que de plus en plus d'IA s'exécutent sur l'appareil, elle se rapproche des gens ordinaires. Les améliorations apportées par l'expérience quotidienne des utilisateurs deviennent de plus en plus évidentes, et Intel a beaucoup à faire.

L'IA côté appareil possède plusieurs fonctionnalités exceptionnelles :

Premièrement, la base d'utilisateurs est énorme et les scénarios d'application sont de plus en plus étendus

;La seconde est que la latence est très faible. Après tout, il n'est pas nécessaire de compter sur le réseau pour transmettre les instructions et les données au cloud pour les traiter puis les renvoyer

;Le troisième est la confidentialité et la sécurité, vous n'avez pas à vous soucier de la fuite d'informations personnelles, de secrets d'affaires, etc. après leur téléchargement

;Quatrièmement, le coût est inférieur. Il ne nécessite pas de serveurs ni de calculs à grande échelle et peut être complété avec uniquement un équipement local.

L'IA sur appareil peut vous sembler étrange, mais en fait, les gens sont habitués au flou d'arrière-plan, à l'embellissement visuel, à l'embellissement sonore (réduction du bruit audio), à la réduction du bruit vidéo, à la segmentation d'image, etc., sont tous des scénarios d’application typiques de l’IA de bout en bout, et l’IA travaille dur en coulisses.

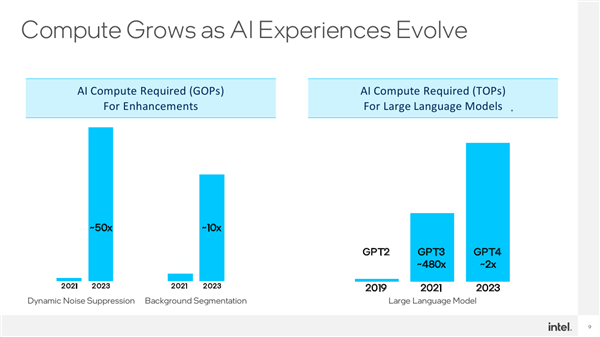

Pour obtenir de meilleurs résultats, ces applications nécessitent des modèles de réseau plus complets et plus complexes, et la demande en puissance de calcul augmente naturellement rapidement.

Par exemple, la suppression du bruit nécessite 50 fois plus de puissance de calcul qu'il y a deux ans, et la segmentation en arrière-plan a également augmenté de plus de 10 fois.

Sans oublier qu'après l'émergence des modèles d'IA génératifs, la demande de puissance de calcul a augmenté à pas de géant, augmentant directement de plusieurs ordres de grandeur. Qu'il s'agisse de diffusion stable ou de GTP basé sur le langage, les paramètres du modèle sont. très exagéré.

Par exemple, le nombre de paramètres de GPT3 a atteint environ 175 milliards, soit près de 500 fois plus que celui de GPT2 qui devrait atteindre le niveau de mille milliards.

Ceux-ci mettent tous en avant des exigences plus strictes en matière de matériel et d'algorithmes.

Intel a naturellement commencé à prêter attention et à investir dans l'IA depuis longtemps. Qu'il s'agisse de Xeon au niveau du serveur ou de Core au niveau du consommateur, ils participent à l'IA de diverses manières. processeur" vient en grande partie de l'IA.

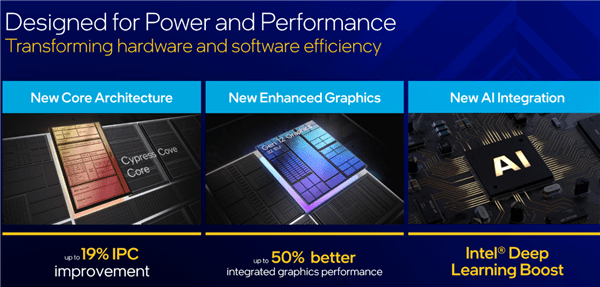

Avant cela, les solutions Intel AI s'accéléraient principalement au niveau de l'architecture et du jeu d'instructions du CPU et du GPU.

Par exemple, DL Boost basé sur l'apprentissage profond ajouté à partir du Core de 10e génération et du Xeon évolutif de deuxième génération, y compris les instructions de réseau neuronal vectoriel VNNI, l'accélération BF16/INT8, etc.

Par exemple, le Gaussian Network Accelerator GNA 2.0 ajouté au Core de 11e génération est équivalent au rôle de NPU. Il ne consomme que très peu de ressources et peut effectuer efficacement des calculs d'inférence neuronale.

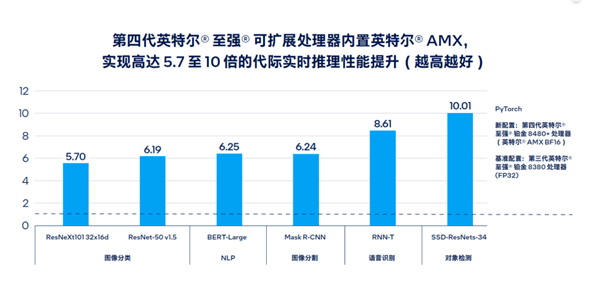

Par exemple, l'AMX Advanced Matrix Extension sur le Xeon évolutif de quatrième génération, nom de code Sapphire Rapids, améliore jusqu'à 10 fois les performances de raisonnement et d'entraînement en temps réel de l'IA, et augmente la vitesse de traitement des grands modèles de langage. Elle est 20 fois plus efficace, et le développement de logiciels et d'outils de support est également plus complet et abondant.

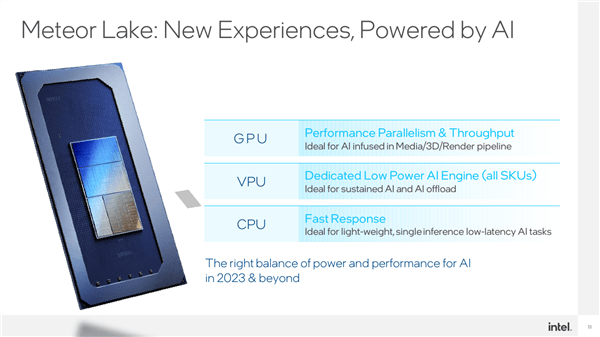

De l'avis d'Intel, aucune architecture matérielle n'est adaptée à tous les scénarios d'IA. Différents matériels ont leurs propres caractéristiques , certains ont une puissance de calcul puissante, certains ont une latence ultra-faible et d'autres le sont. polyvalents, certains s'y spécialisent.

En tant qu'infrastructure, l'IA a également diverses applications et exigences de scénarios, avec des charges et des délais différents , par exemple, le traitement de la voix et des images en temps réel ne nécessite pas trop de puissance de calcul, mais très sensible à la latence.

À l'heure actuelle, la stratégie XPU d'Intel présente des avantages très spécifiques. Le processeur est adapté au traitement de l'IA léger et sensible aux délais, et le GPU est adapté aux applications d'IA lourdes et hautement parallèles.

Un autre avantage inégalé d'Intel est son écosystème x86 stable et énorme, qui dispose d'une large base de masse, quelle que soit l'application ou le développement.

Maintenant, Intel dispose à nouveau de VPU.

Meteor Lake, qui sortira plus tard cette année, intégrera pour la première fois une unité VPU indépendante, et elle sera standard sur tous les modèles, qui pourra effectuer des opérations d'IA spécifiques plus efficacement.

La source technique de l'unité Intel VPU provient de la start-up d'IA Movidius acquise par Intel en 2017. L'architecture VPU qu'elle a conçue est révolutionnaire. Elle ne nécessite que 1,5 W de consommation électrique pour atteindre une puissance de calcul puissante. de 4TOPS. Le rapport d'efficacité énergétique est simplement inverse. Tian, a d'abord été utilisé pour éviter les obstacles des drones, etc., et maintenant il est entré dans le processeur, travaillant en conjonction avec le CPU et le GPU.

VPU est essentiellement une nouvelle architecture conçue pour l'IA. Il peut effectuer efficacement certaines opérations matricielles et est particulièrement efficace pour le traitement clairsemé. Sa consommation d'énergie ultra-faible et son efficacité énergétique ultra-élevée conviennent très bien à certaines. Scénarios qui doivent être ouverts et exécutés pendant une longue période, tels que le flou d'arrière-plan et la suppression lors de la vidéoconférence, comme le contrôle gestuel des médias en streaming.

La raison pour laquelle Intel a besoin de créer un VPU alors qu'il existe déjà un CPU et un GPU est que de nombreuses applications finales sont désormais exécutées sur des ordinateurs portables, qui sont très sensibles à la durée de vie de la batterie. utilisé dans Mobile est exactement ce qu'il vous faut.

Un autre facteur est que le CPU et le GPU, en tant que plates-formes informatiques générales, ont eux-mêmes des tâches lourdes. Si une grande quantité de charge d'IA leur est ajoutée, l'efficacité d'exécution sera considérablement réduite.

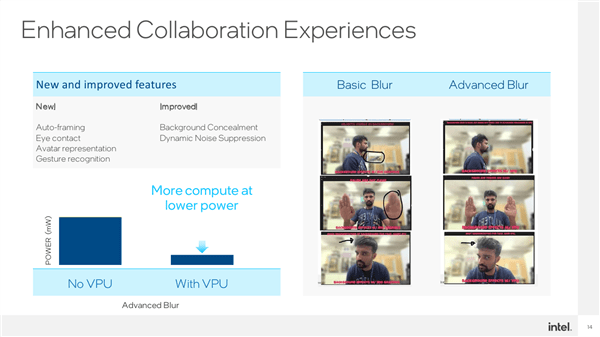

Spécifique aux scénarios d'application, le VPU est également très large, comme la vidéoconférence. Le CPU AI actuel peut déjà implémenter la composition automatique (Auto-Framing), le suivi oculaire, les avatars/portraits virtuels, la reconnaissance gestuelle, etc.

Après avoir ajouté un VPU avec une faible consommation d'énergie et une puissance de calcul élevée, vous pouvez également renforcer le flou d'arrière-plan, la réduction dynamique du bruit et d'autres traitements pour rendre l'effet plus précis. Par exemple, les objets en arrière-plan seront plus précis. flous alors qu'ils devraient l'être, et les mains humaines seront floues / Les cheveux, etc. qui ne devraient pas être flous ne le sont plus.

Avec un matériel efficace et des scénarios adaptés, un logiciel tout aussi efficace est nécessaire pour libérer toute sa puissance et obtenir les meilleurs résultats. Ce n'est vraiment pas un problème pour Intel, qui compte des dizaines de milliers de développeurs de logiciels.

Meteor Lake n'a pas encore été officiellement publié. Intel a déjà coopéré avec de nombreux partenaires écologiques sur l'adaptation du VPU, et les développeurs de logiciels indépendants sont également très actifs.

Par exemple, Adobe, de nombreux filtres, traitements automatisés, découpes intelligentes, etc., peuvent être exécutés sur VPU.

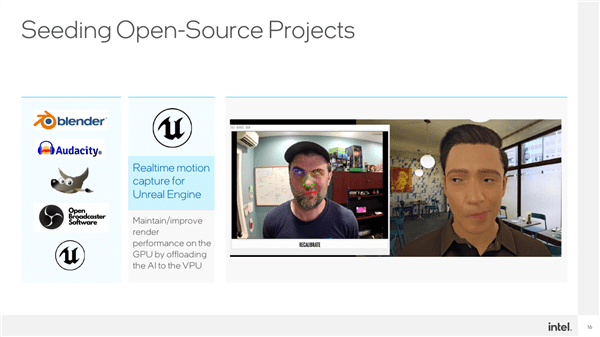

Par exemple, les personnes numériques d'Unreal Engine, telles que les ancres virtuelles, peuvent être capturées et restituées en temps réel par VPU.

Blender, Audacity, OBS, GIMP... la liste peut être longue et elle ne cesse de s'allonger.

Plus important encore, CPU, GPU et VPU ne font pas leur propre travail, mais peuvent être combinés pour tirer pleinement parti de leurs avantages respectifs afin d'obtenir la meilleure expérience d'IA.

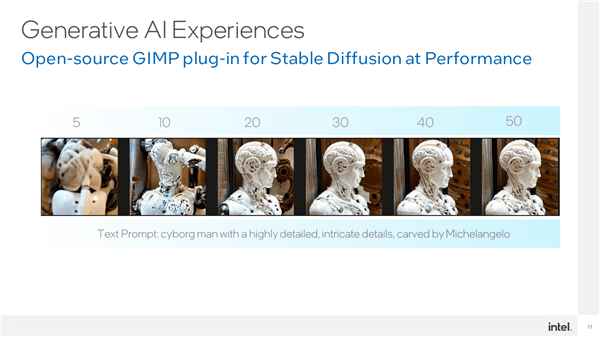

Par exemple, il existe un plug-in basé sur Stable Diffusion dans GIMP, qui peut abaisser considérablement le seuil permettant aux utilisateurs ordinaires d'utiliser l'IA générative. Il peut mobiliser pleinement les capacités d'accélération du CPU, du GPU et du VPU, et. dispersez l'ensemble du modèle sur différentes IP et coopérez entre elles pour obtenir les meilleures performances.

Parmi eux, le VPU peut héberger le module VNET à exécuter et le GPU est utilisé pour exécuter le module d'encodeur. Grâce à une telle coopération, il ne faut qu'environ 20 secondes pour générer une image complexe.

Parmi eux, le VPU a la consommation d'énergie la plus faible, suivi du CPU, et le GPU a la consommation d'énergie la plus élevée.

Intel a pleinement compris l'importance de l'IA dans l'amélioration de l'expérience PC. Afin de relever ce défi, Intel déploie tous ses efforts pour promouvoir le développement et la vulgarisation de l'IA, tant au niveau matériel que logiciel, établissant ainsi une base solide pour. le développement et la vulgarisation de l’IA côté appareil.

Au niveau matériel, CPU, GPU et VPU formeront une plateforme sous-jacente omniprésente ; au niveau logiciel, divers logiciels de développement standardisés tels qu'OpenVINO favoriseront grandement l'exploration de scénarios d'application.

À l'avenir, les ordinateurs portables fins et légers équipés de la plateforme Meteor Lake pourront facilement exécuter de grands modèles tels que Stable Diffusion pour réaliser des graphiques vincentiens, abaissant considérablement le seuil d'application de l'IA, et à la fois la prise de décision et l’IA générative peut être mise en œuvre de manière efficace, permettant ainsi d’obtenir une véritable IA partout.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI