Maison >Périphériques technologiques >IA >OpenAI et Google jouent avec leur double standard : former de grands modèles en utilisant les données d'autres personnes, mais sans jamais laisser leurs propres données s'échapper.

OpenAI et Google jouent avec leur double standard : former de grands modèles en utilisant les données d'autres personnes, mais sans jamais laisser leurs propres données s'échapper.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-06-05 15:03:391078parcourir

Dans la nouvelle ère de l’IA générative, les grandes entreprises technologiques poursuivent une stratégie « faites ce que je dis, ne faites pas ce que je fais » lorsqu’il s’agit de consommer du contenu en ligne. Dans une certaine mesure, cette stratégie peut être considérée comme un double standard et un abus du droit de parole.

Dans le même temps, alors que les grands modèles de langage (LLM) deviennent la tendance dominante dans le développement de l'IA, les grandes entreprises et les start-ups n'épargnent aucun effort pour développer leurs propres grands modèles. Parmi eux, les données de formation sont une condition préalable importante à la capacité des grands modèles.

Récemment, selon un rapport d'Insider, OpenAI soutenu par Microsoft, Google et Anthropic soutenus utilisent le contenu en ligne d'autres sites Web ou d'entreprises pour former leurs modèles d'IA générative depuis des années. Tout cela a été réalisé sans demander d’autorisation spécifique et fera partie d’une bataille juridique en cours pour déterminer l’avenir du Web et la manière dont la loi sur le droit d’auteur sera appliquée dans cette nouvelle ère.

Ces grandes entreprises technologiques peuvent prétendre qu'elles font un usage équitable, mais la question de savoir si c'est vraiment le cas est discutable. Mais ils ne laisseront pas leur contenu être utilisé pour former d’autres modèles d’IA. Nous ne pouvons donc pas nous empêcher de nous demander pourquoi ces grandes entreprises technologiques peuvent-elles utiliser le contenu en ligne d’autres entreprises lors de la formation de grands modèles ?

Ces entreprises sont intelligentes, mais aussi très hypocrites

Existe-t-il des preuves solides de l'affirmation selon laquelle les grandes entreprises technologiques utilisent le contenu en ligne d'autres personnes mais ne permettent pas aux autres d'utiliser le leur ? de service et d'utilisation de certains de leurs produits Voir les indices.

Premièrement, regardons Claude, un assistant IA similaire à ChatGPT lancé par Anthropic. Le système peut effectuer des tâches telles que la synthèse, la recherche, l'aide à la création, les questions et réponses et le codage. Il a été à nouveau mis à niveau il y a quelque temps et le jeton de contexte a été étendu à 100 000, ce qui a considérablement accéléré la vitesse de traitement.

Les conditions d'utilisation de Claude sont les suivantes. Vous ne pouvez pas accéder ou utiliser le Service des manières suivantes (dont certaines sont répertoriées ici). Si l'une de ces restrictions est incompatible ou peu claire avec la Politique d'utilisation acceptable, cette dernière prévaudra :

- Développée en collaboration avec notre Tout produit ou service avec lequel le Service est en concurrence, y compris le développement ou la formation de tout algorithme ou modèle d'IA ou d'apprentissage automatique

- Gratter, gratter ou obtenir de toute autre manière des données ou des informations de nos Services sans être autorisé par les Conditions

Adresse des conditions d'utilisation de Claude : https://vault.pactsafe.io/s/9f502c93-cb5c-4571-b205-1e479da61794/legal.html#terms

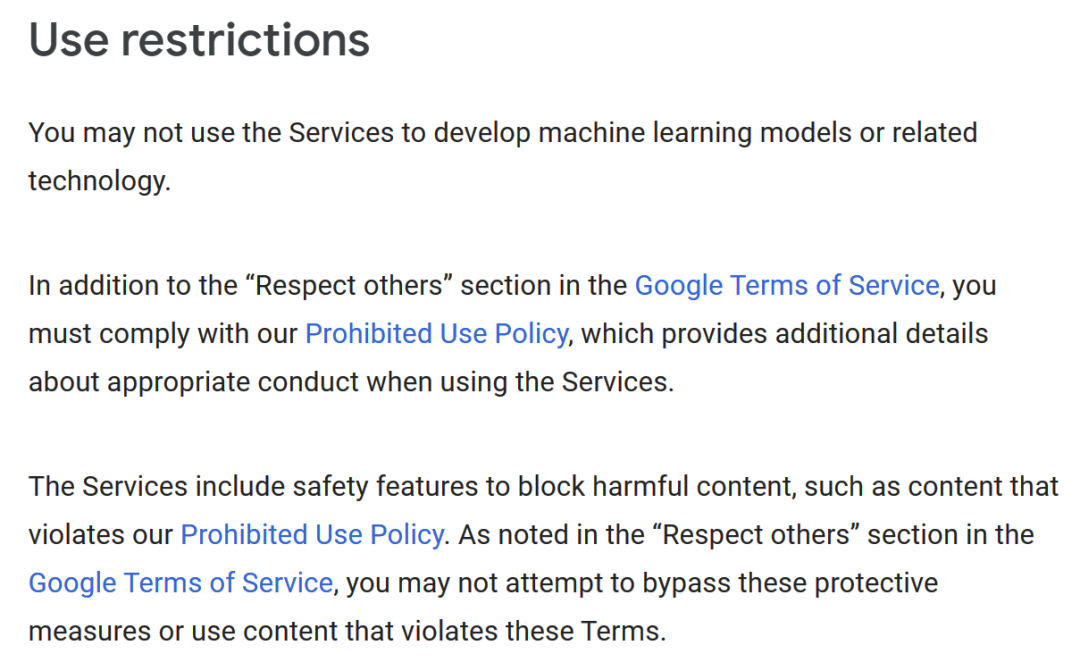

De même, l'IA générative de Google utilise Il en va de même pour les conditions : "Vous ne pouvez pas utiliser le Service pour développer des modèles d'apprentissage automatique ou des technologies associées." com/terms/ Generative-ai

Qu'en est-il des conditions d'utilisation d'OpenAI ? Semblable à Google, "Vous ne pouvez pas utiliser les résultats de ce service pour développer des modèles qui concurrencent OpenAI." -d'utilisation

Qu'en est-il des conditions d'utilisation d'OpenAI ? Semblable à Google, "Vous ne pouvez pas utiliser les résultats de ce service pour développer des modèles qui concurrencent OpenAI." -d'utilisation

Ces entreprises sont intelligentes, elles savent qu'un contenu de haute qualité est essentiel pour former de nouveaux modèles d'IA, il est donc logique de ne pas permettre à d'autres d'utiliser leurs résultats de cette manière. Mais ils n’ont aucun scrupule à utiliser les données d’autres personnes pour former leurs propres modèles. Comment expliquer cela ?

OpenAI, Google et Anthropic ont décliné les demandes de commentaires d'Insider et n'ont pas répondu.

Reddit, Twitter et autres : Assez, c'est assez

En fait, d'autres entreprises n'étaient pas contentes lorsqu'elles ont réalisé ce qui se passait. En avril, Reddit, utilisé depuis des années pour former des modèles d'IA, prévoit de commencer à facturer l'accès à ses données.

Le PDG de Reddit, Steve Huffman, a déclaré : "Le corpus de données de Reddit est très précieux, nous ne pouvons donc pas fournir cette valeur gratuitement aux plus grandes entreprises du monde."

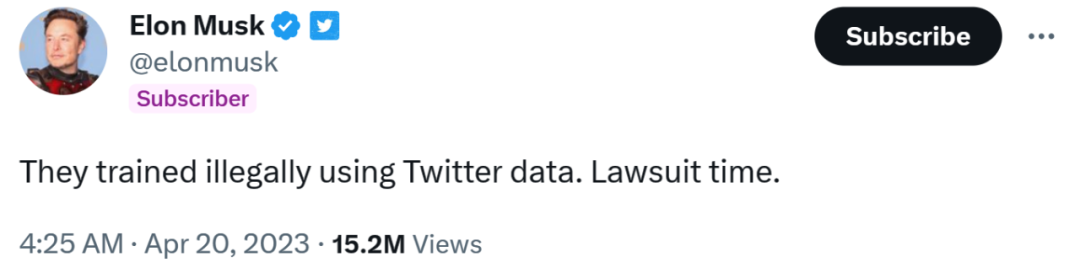

En avril de cette année également, Musk a accusé OpenAI Microsoft, l'un des principaux bailleurs de fonds du procès, a utilisé illégalement les données de Twitter pour former des modèles d'IA. "C'est l'heure du procès", a-t-il tweeté.

Cependant, en réponse au commentaire d'Insider, Microsoft a déclaré qu '"il y a tellement d'erreurs dans cette prémisse que je ne sais même pas par où commencer."

Le PDG d'OpenAI, Sam Altman, a essayé d'explorer. Un nouveau modèle d'IA qui respecte les droits d'auteur pour approfondir ce problème. Selon Axios, il a récemment déclaré : "Nous essayons de développer un nouveau modèle. Si le système d'IA utilise votre contenu ou votre style, vous serez payé pour cela

Sam Altman."

Les éditeurs (y compris les Insiders) auront tous des intérêts particuliers. De plus, certains éditeurs, dont U.S. News Corp., font déjà pression pour que les entreprises technologiques paient pour utiliser leur contenu afin de former des modèles d’IA.

La méthode actuelle de formation des modèles d'IA a "cassé" le réseau

Un ancien cadre de Microsoft a déclaré qu'il devait y avoir un problème avec cela. Steven Sinofsky, vétéran de Microsoft et développeur de logiciels bien connu, estime que la méthode actuelle de formation des modèles d'IA « casse » le réseau.

Steven Sinofsky

Il a écrit sur Twitter : "Dans le passé, les données d'exploration étaient utilisées en échange de taux de clics. Mais maintenant, elles ne sont utilisées que pour former un modèle et n'est pas donné. Les créateurs et les titulaires de droits d'auteur apportent une quelconque valeur. "

Peut-être qu'à mesure que de plus en plus d'entreprises se réveillent, cette utilisation inégale des données à l'ère de l'IA générative sera bientôt modifiée.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI