Maison >Périphériques technologiques >IA >La fraude par échange de visage par IA a escroqué 4,3 millions de yuans. Les experts en matière de consommation recommandent immédiatement trois mesures défensives.

La fraude par échange de visage par IA a escroqué 4,3 millions de yuans. Les experts en matière de consommation recommandent immédiatement trois mesures défensives.

- 王林avant

- 2023-05-28 18:54:261606parcourir

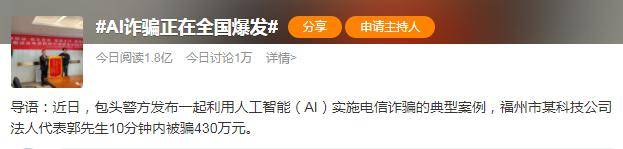

Récemment, le bureau de la sécurité publique de la ville de Baotou a annoncé le cas de M. Guo, le représentant légal d'une entreprise technologique à Fuzhou, qui a été victime d'une escroquerie de 4,3 millions de yuans en 10 minutes grâce au changement de visage de l'IA, déclenchant de nombreuses discussions animées sur la sécurité de l’intelligence artificielle.

Concernant les risques potentiels posés par l'IA, le « Parrain de l'IA » Hinton a déclaré un jour dans une interview au New York Times : « Par rapport au changement climatique, L'IA pourrait constituer une menace « plus urgente » pour l'humanité.

Basée sur la réalité, cette affirmation n’est pas « alarmiste ». Le « mal » dans la boîte de Pandore émerge progressivement. Dans le même temps, l'AIGC fait rapidement passer le développement de l'IA à une nouvelle étape.Attention aux « maux » de la technologie : voir ce n'est pas forcément croire

Selon le compte public WeChat « Safe Baotou », le bureau d'enquête sur la cybercriminalité dans les télécommunications du bureau de sécurité publique de la ville de Baotou a annoncé un cas de fraude dans les télécommunications, M. Guo, le représentant légal d'une entreprise technologique à Fuzhou, a été escroqué de 4,3 millions de yuans. En 10 minutes, Lucky De plus, 3,3684 millions de yuans de fonds frauduleux ont été interceptés et « une technologie intelligente de changement de visage et d'onomatopées » a été utilisée.

Comment ont-ils fait ?

Il s'agit d'un processus compliqué. D'après les informations elles-mêmes, du point de vue de la victime, M. Guo, il a été principalement trompé par la technologie de changement de visage et la technologie des onomatopées. Cependant, il peut y avoir d'autres conditions derrière l'incident, comme la question de savoir si. le criminel est par quels canaux il a établi le contact avec la victime, comment obtenir le compte de logiciel social approprié, comment savoir qui il devait usurper l'identité, comment obtenir les images et les éléments sonores correspondants et comment sélectionner la victime.Si nous nous concentrons sur les deux problèmes clés de la technologie de changement de visage et de la technologie des onomatopées, les principaux problèmes sont l'obtention de données de base, un cadre de formation et un rendu en temps réel

. Au niveau des données, les informations audio et vidéo de l'usurpateur peuvent être obtenues à partir de bibliothèques d'ingénierie sociale telles que les médias sociaux, ou elles peuvent être extraites de l'album photo et de l'historique de discussion d'un téléphone noir perdu. En termes de cadre de formation, les logiciels de montage de plusieurs plates-formes de courtes vidéos nationales grand public prennent actuellement en charge les effets spéciaux de changement de visage sans messages d'avertissement. Il existe plus de 30 méthodes de synthèse dans des cadres open source étrangers. En termes de rendu en temps réel, un rendu détourné peut également être obtenu via des opérations d'attaque telles que le flashage du téléphone et l'installation de logiciels intrusifs.Par conséquent, "Voir n'est pas nécessairement croire"

Il y a toujours un "mal" délibéré derrière la technologie, contre lequel il faut se prémunir.Étoignez-le dans l'œuf et battez la « magie » avec la « 魔

méthode »

Les risques sont inévitables, alors comment pouvons-nous utiliser la « magie » pour vaincre la « magie » ?Actuellement, de nombreuses institutions financières ont déjà mis en œuvre des mesures pertinentes et des applications technologiques associées. Par exemple, La lutte contre la contrefaçon in vivo, l'identification des intermédiaires et d'autres technologies ont également été appliquées dans des scénarios commerciaux financiers. "La fonction principale de la lutte contre la contrefaçon en direct, de l'identification intermédiaire et d'autres technologies est d'éviter les défauts inhérents à la reconnaissance faciale

et d'identifier efficacement les photos, vidéos, masques, modèles de simulation, etc., en particulier les changements de visage et les voix. changer la fraude survenue lors de cet incident "Feng Yue, un expert de base intelligent au MaMaConsumer Artificial Intelligence Research Institute, a déclaré:" Sur la base d'une telle innovation technologique, MaMaConsumer Finance est actuellement en mesure de bloquer 99% des attaques de fraude par lots, empêchant efficacement les informations falsifiées, les intermédiaires et la contrefaçon. Risques tels que les demandes, les prêts à long terme et la fraude dans les télécommunications.Par rapport aux institutions financières, à la fin du processus global, les logiciels sociaux sont obligés d'introduire des mécanismes de contrefaçon et de fournir des rappels d'authentification d'appel en temps réel aux utilisateurs pour indiquer si l'utilisateur homologue a un comportement anormal, une falsification d'image anormale ou une fausse voix anormale. exception. Des informations d’avertissement de risque plus précoces peuvent prévenir plus efficacement l’apparition de résultats de risque.

En plus de la mise en œuvre liée à la plate-forme, le public peut également prendre certaines mesures d'auto-assistance. Actuellement, il existe un type de technologie qui peut protéger les données des utilisateurs contre l'utilisation de ce type de technologie. s'appelle Adversarial Sample Technology. En prenant comme exemple les images de visages humains, la technologie de changement de visage peut être rendue inefficace en mélangeant à l’image un masque de perturbation adverse invisible à l’œil nu. Les utilisateurs peuvent utiliser ce type de technologie pour protéger leurs informations médiatiques telles que les images et les voix sur les réseaux sociaux avant de les rendre publiques.

Enfin, la « conscience de précaution » est la pierre angulaire de toute « magie », et le public doit également renforcer la protection de la sécurité des effets personnels et des informations.

"Ne cliquez pas sur des liens de messages texte inconnus, des liens de courrier électronique, etc., ne scannez pas de codes QR provenant de sources inconnues, ne téléchargez pas d'applications, ne fournissez pas facilement votre visage et d'autres informations biométriques personnelles à d'autres, ne le faites pas facilement. révélez votre carte d'identité, votre carte bancaire, votre code de vérification et d'autres informations, ne divulguez pas et ne partagez pas trop d'images animées, de vidéos, etc. », a suggéré Feng Yue. "Il n'y a aucune garantie que les téléphones mobiles et autres appareils mobiles ne seront pas perdus. Vous pouvez régulièrement effacer les enregistrements de chat WeChat, masquer les traces pertinentes avec les personnes avec lesquelles vous entretenez des relations étroites, crypter les albums photo de votre téléphone portable ou activer la fonction de protection des données de votre téléphone portable. Ces comportements quotidiens peuvent conduire à des fraudes interceptées à l'extérieur.

Il faut beaucoup de temps pour réussir, étape par étape. La prévention du « mauvais usage » de la technologie de l’intelligence artificielle restera une question centrale à l’ère numérique.Source : Informations sur le secteur financier

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI