Maison >Périphériques technologiques >IA >Multi-chemin, multi-domaine, tout compris ! Google AI publie le modèle général d'apprentissage multi-domaines MDL

Multi-chemin, multi-domaine, tout compris ! Google AI publie le modèle général d'apprentissage multi-domaines MDL

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-05-28 14:12:441319parcourir

Les modèles d'apprentissage profond pour les tâches visuelles (telles que la classification d'images) sont généralement formés de bout en bout avec des données provenant d'un seul domaine visuel (telles que des images naturelles ou des images générées par ordinateur).

Généralement, une application qui effectue des tâches visuelles pour plusieurs champs doit créer plusieurs modèles pour chaque champ distinct et les former indépendamment. Les données ne sont pas partagées entre différents champs. Lors de l'inférence, les données d'entrée spécifiques à chaque champ de modèle seront traitées. .

Même s'ils sont orientés vers des domaines différents, certaines caractéristiques des premières couches entre ces modèles sont similaires, donc la formation conjointe de ces modèles est plus efficace. Cela réduit la latence et la consommation d'énergie, ainsi que le coût de la mémoire lié au stockage de chaque paramètre du modèle. Cette approche est appelée apprentissage multidomaine (MDL).

De plus, les modèles MDL peuvent également être meilleurs que les modèles à domaine unique. Une formation supplémentaire dans un domaine peut améliorer les performances du modèle dans un autre domaine, mais cela peut également produire des résultats négatifs. effets sur le transfert de connaissances, qui dépendent de la méthode de formation et de la combinaison de domaines spécifique. Bien que des travaux antérieurs sur MDL aient démontré l’efficacité des tâches d’apprentissage conjoint inter-domaines, ils impliquent une architecture de modèle élaborée à la main qui est inefficace lorsqu’elle est appliquée à d’autres travaux.

Lien papier : https://arxiv.org/pdf/2010.04904.pdf

Afin de résoudre ce problème, dans "Réseaux de neurones multi-chemins pour les réseaux multi-chemins sur appareil -domain Dans l'article "Visual Classification", les chercheurs de Google ont proposé un modèle MDL général.

L'article indique que ce modèle peut efficacement atteindre une grande précision, réduire le transfert de connaissances négatif, apprendre à améliorer le transfert de connaissances positif et optimiser efficacement le modèle conjoint face à des difficultés dans divers domaines spécifiques.

À cette fin, les chercheurs ont proposé une méthode de recherche d'architecture neuronale multi-chemins (MPNAS) pour construire un modèle unifié avec une architecture de réseau hétérogène pour plusieurs domaines.

Cette méthode étend la méthode efficace de recherche d'architecture neuronale (NAS) de la recherche à chemin unique à la recherche à chemins multiples pour trouver conjointement un chemin optimal pour chaque champ. Une nouvelle fonction de perte est également introduite, appelée Adaptive Balanced Domain Prioritization (ABDP), qui s'adapte aux difficultés spécifiques au domaine pour aider à entraîner efficacement les modèles. L’approche MPNAS qui en résulte est efficace et évolutive.

Tout en ne conservant aucune dégradation des performances, le nouveau modèle réduit la taille du modèle et les FLOPS de 78 % et 32 % respectivement par rapport aux méthodes à domaine unique.

Recherche de structure neuronale multi-chemins

Afin de promouvoir le transfert positif de connaissances et d'éviter le transfert négatif, la solution traditionnelle consiste à construire un modèle MDL afin que chaque domaine partage la plupart des couches et apprenne les caractéristiques communes de chaque domaine. (appelé extraction de fonctionnalités), puis créez des couches spécifiques au domaine par-dessus. Cependant, cette méthode d’extraction de caractéristiques ne peut pas gérer des domaines présentant des caractéristiques significativement différentes (tels que les objets dans des images naturelles et des peintures artistiques). D’un autre côté, construire une structure hétérogène unifiée pour chaque modèle MDL prend du temps et nécessite des connaissances spécifiques au domaine.

Cadre d'architecture de recherche neuronale multi-chemins NAS est un paradigme puissant pour la conception automatique d'architectures d'apprentissage en profondeur. Il définit un espace de recherche composé de divers éléments de base potentiels qui peuvent faire partie du modèle final.

L'algorithme de recherche trouve la meilleure architecture candidate dans l'espace de recherche pour optimiser les objectifs du modèle tels que la précision de la classification. Les méthodes NAS récentes telles que TuNAS améliorent l'efficacité de la recherche en utilisant un échantillonnage de chemin de bout en bout.

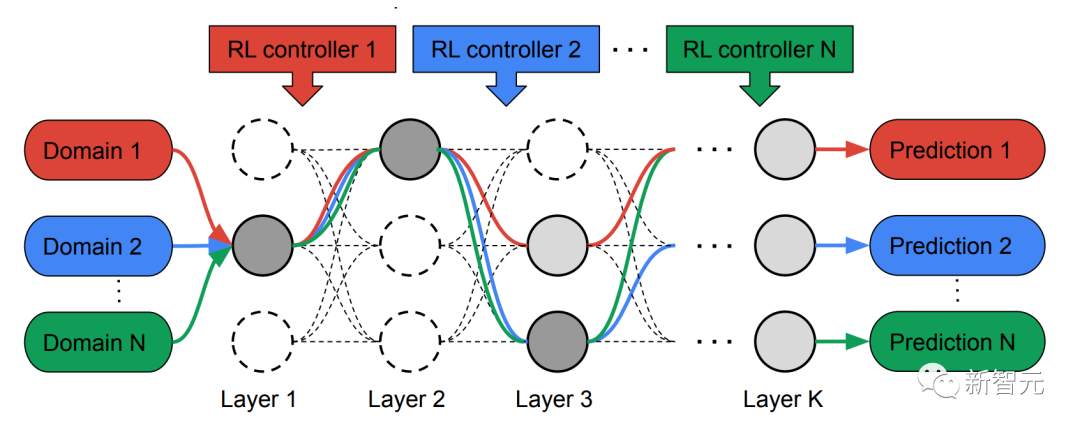

Inspiré de TuNAS, MPNAS construit l'architecture du modèle MDL en deux étapes : recherche et formation.

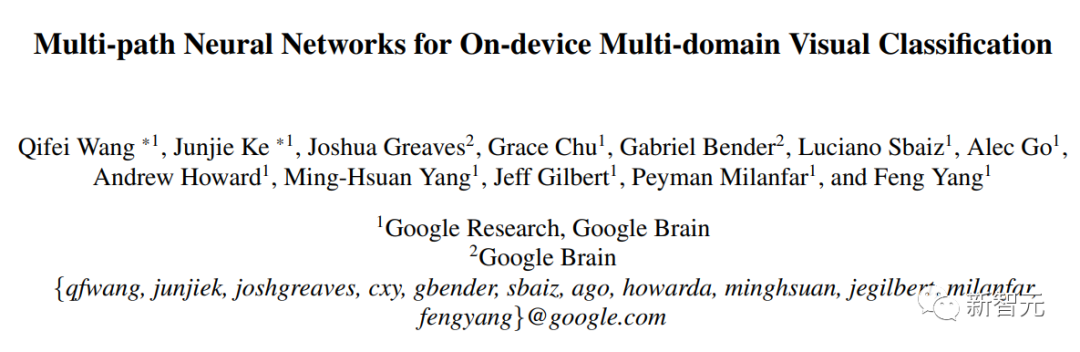

Dans la phase de recherche, afin de trouver conjointement un chemin optimal pour chaque domaine, MPNAS crée un contrôleur d'apprentissage par renforcement (RL) distinct pour chaque domaine, qui est tiré du super réseau (c'est-à-dire par la recherche Échantillonne des chemins de bout en bout (de la couche d'entrée à la couche de sortie) dans un sur-ensemble spatialement défini de tous les sous-réseaux possibles entre les nœuds candidats.

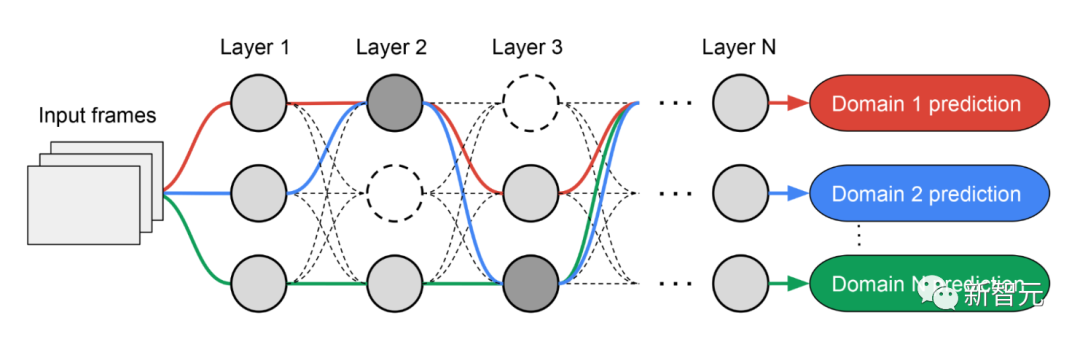

Au fil de plusieurs itérations, tous les contrôleurs RL mettent à jour les chemins pour optimiser les récompenses RL dans tous les domaines. A la fin de la phase de recherche, nous obtenons un sous-réseau pour chaque domaine. Enfin, tous les sous-réseaux sont combinés pour créer une structure hétérogène pour le modèle MDL, comme le montre la figure ci-dessous.

En raison des sous-titres de chacun domaine Le réseau est recherché indépendamment, de sorte que les éléments constitutifs de chaque couche peuvent être partagés par plusieurs domaines (c'est-à-dire des nœuds gris foncé), utilisés par un seul domaine (c'est-à-dire des nœuds gris clair) ou n'être utilisés par aucun sous-réseau (c'est-à-dire nœuds ponctuels).

Le chemin de chaque domaine peut également ignorer n'importe quelle couche pendant le processus de recherche. Le réseau de sortie est à la fois hétérogène et efficace, étant donné que les sous-réseaux sont libres de choisir les blocs à utiliser en cours de route de manière à optimiser les performances.

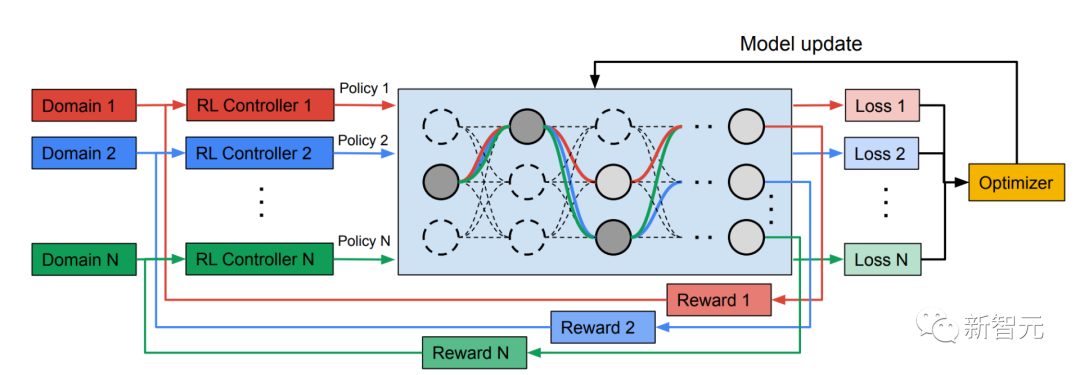

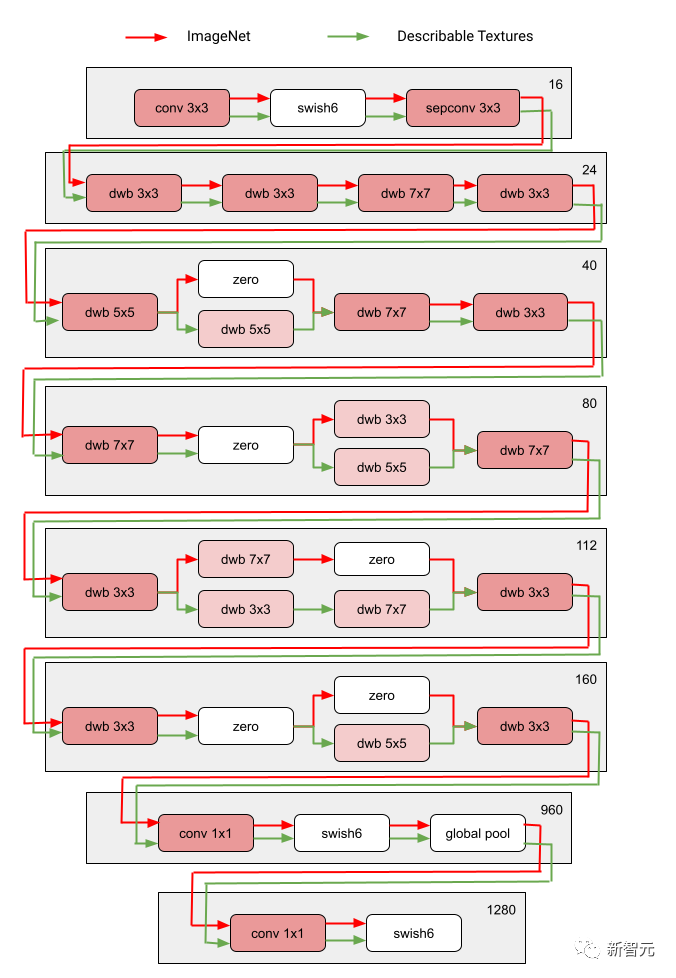

La figure suivante montre l'architecture de recherche de deux domaines de Visual Domain Decathlon.

Visual Domain Decathlon est CVPR 201 7 Dans le cadre du PASCAL in Detail Workshop Challenge, la capacité des algorithmes de reconnaissance visuelle à gérer (ou exploiter) de nombreux domaines visuels différents a été testée. Comme on peut le constater, les sous-réseaux de ces deux domaines hautement liés (l’un rouge, l’autre vert) partagent la plupart des éléments constitutifs de leurs chemins qui se chevauchent, mais il existe encore des différences entre eux.

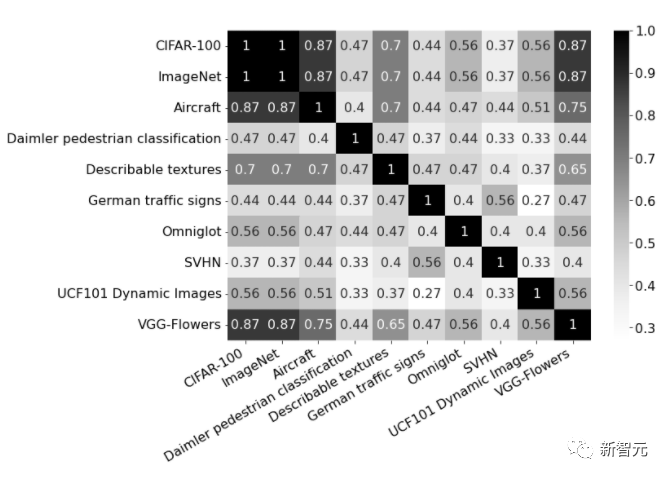

Les chemins rouges et verts sur la figure représentent respectivement les sous-réseaux d'ImageNet et des textures descriptibles, Les nœuds rose foncé représentent les blocs partagés par plusieurs domaines, et les nœuds rose clair représentent les blocs utilisés par chaque chemin. Le bloc « dwb » dans le diagramme représente le bloc dwbottleneck. Le bloc Zéro dans la figure indique que le sous-réseau ignore le bloc La figure ci-dessous montre la similarité des chemins dans les deux champs mentionnés ci-dessus. La similarité est mesurée par le score de similarité Jaccard entre les sous-réseaux pour chaque domaine, où plus élevé signifie plus de chemins similaires.

La photo montre le score de similarité Jaccard entre les chemins des dix domaines matrice de confusion. Le score varie de 0 à 1. Plus le score est élevé, plus les deux chemins partagent de nœuds.

Formation de modèles multi-domaines hétérogènes

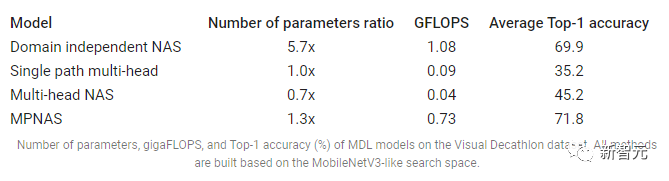

Dans la deuxième phase, les modèles générés par MPNAS seront formés à partir de zéro pour tous les domaines. Pour ce faire, il est nécessaire de définir une fonction objectif unifiée pour tous les domaines. Pour gérer avec succès une grande variété de domaines, les chercheurs ont conçu un algorithme qui s'ajuste tout au long du processus d'apprentissage pour équilibrer les pertes entre les domaines, appelé Adaptive Balanced Domain Prioritization (ABDP). Ci-dessous montre la précision, la taille du modèle et les FLOPS des modèles formés dans différents paramètres. Nous comparons MPNAS avec trois autres méthodes : NAS indépendant du domaine : les modèles sont recherchés et formés séparément pour chaque domaine.

Multi-tête à chemin unique : utilisez un modèle pré-entraîné comme épine dorsale partagée pour tous les domaines, avec des têtes de classification distinctes pour chaque domaine.

NAS multi-têtes : recherchez une architecture de base unifiée pour tous les domaines, avec des têtes de classification distinctes pour chaque domaine.

D'après les résultats, nous pouvons observer que le NAS doit construire un ensemble de modèles pour chaque domaine, ce qui entraîne des modèles volumineux. Bien que les NAS multi-têtes et multi-têtes à chemin unique puissent réduire considérablement la taille du modèle et les FLOPS, forcer les domaines à partager le même backbone introduit un transfert de connaissances négatif, réduisant ainsi la précision globale.

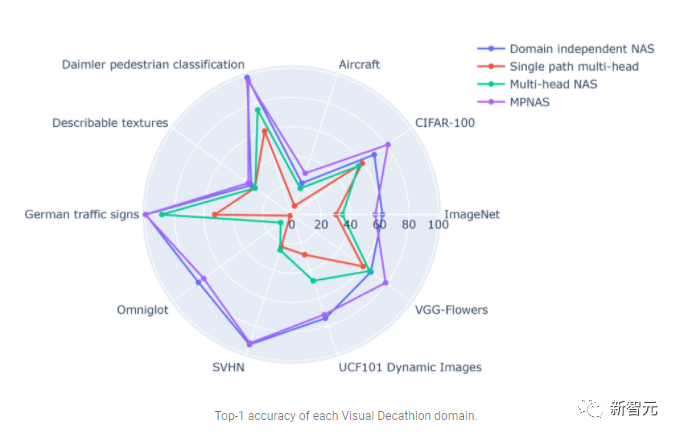

En revanche, MPNAS peut créer des modèles petits et efficaces tout en conservant une précision globale élevée. La précision moyenne du MPNAS est même 1,9 % supérieure à celle de la méthode NAS indépendante du domaine, car le modèle est capable de réaliser un transfert actif de connaissances. La figure ci-dessous compare la meilleure précision par domaine de ces méthodes.

L'évaluation montre qu'en utilisant l'ABDP dans le cadre des étapes de recherche et de formation, la précision du top 1 passe de 69,96 % à 71,78 % (incrément : +1,81 %).

Future Directions

MPNAS est une solution efficace pour créer des réseaux hétérogènes afin de remédier au déséquilibre des données, à la diversité des domaines, à la migration négative, à l'évolutivité du domaine et au grand espace de recherche pour d'éventuelles stratégies de partage de paramètres dans MDL. En utilisant un espace de recherche de type MobileNet, le modèle généré est également adapté aux appareils mobiles. Pour les tâches incompatibles avec les algorithmes de recherche existants, les chercheurs continuent d'étendre MPNAS pour l'apprentissage multitâche et espèrent utiliser MPNAS pour créer des modèles multidomaines unifiés.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI