Maison >Périphériques technologiques >IA >La couverture de AI Stefanie Sun est devenue un succès, grâce à ce projet open source ! Guangxi Old Watch prend les devants dans la création et un guide pour démarrer a été publié

La couverture de AI Stefanie Sun est devenue un succès, grâce à ce projet open source ! Guangxi Old Watch prend les devants dans la création et un guide pour démarrer a été publié

- 王林avant

- 2023-05-12 14:07:061013parcourir

AI Stefanie Sun a repris tant de chansons si rapidement, comment a-t-elle réussi à y parvenir ?

La clé réside dans un projet open source .

Récemment, cette vague de tendances de reprises d'IA est devenue populaire, pas seulement les chansons chantées par L'IA Stefanie Sun devient de plus en plus populaire. À mesure que le nombre augmente, le champ des chanteurs IA s'élargit également et même des tutoriels de production apparaissent les uns après les autres.

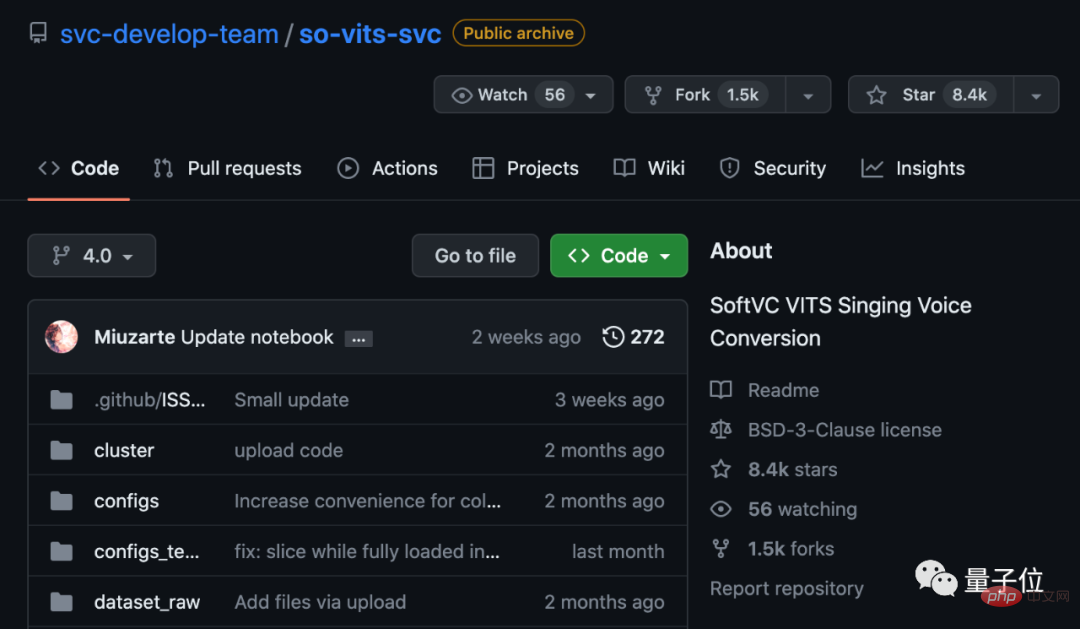

Et si vous parcourez les principaux tutoriels, vous constaterez que le secret clé réside dans un projet open source appelé so-vits-svc .

Il fournit un moyen de remplacer les sons. Le projet est sorti en mars de cette année.

La plupart des membres contributeurs devraient provenir de Chine, et celui avec la contribution la plus élevée est un vétéran du Guangxi qui joue aux Arknights.

Maintenant, le projet a cessé de se mettre à jour, mais le nombre d'étoiles continue d'augmenter, atteignant actuellement 8,4 k.

Alors, quelles technologies a-t-elle mises en œuvre pour faire exploser cette tendance ?

Jetons un coup d'oeil.

Grâce à un projet open source

Ce projet s'appelle SoftVC VITS Singing Voice Conversion (conversion de voix chantée).

Il fournit un algorithme de conversion de timbre qui utilise l'encodeur de contenu SoftVC pour extraire les caractéristiques vocales de l'audio source, puis entre directement le vecteur dans VITS sans le convertir en texte au milieu, conservant ainsi le hauteur et intonation.

De plus, le vocodeur est remplacé par NSF HiFiGAN, ce qui peut résoudre le problème de l'interruption du son.

est divisé en étapes suivantes :

- Modèle de pré-formation

- Préparer l'ensemble de données #🎜🎜 #Traitement pré-formation

- Training

- Inference

UVR_v5.5.0.

Le blogueur Twitter @Guizang a déclaré qu'il est préférable de convertir le format sonore au format WAV avant le traitement, car So-VITS-SVC 4.0 ne reconnaît ce format que pour faciliter le traitement ultérieur. Si vous souhaitez de meilleurs résultats, vous devez traiter le son de fond deux fois, avec des réglages différents à chaque fois, ce qui peut maximiser la qualité du son sec. Après avoir obtenu l'audio traité, certaines opérations de prétraitement sont nécessaires. Par exemple, si l'audio est trop long, la mémoire vidéo sera facilement saturée. L'audio doit donc être découpé. Il est recommandé de prendre 5 à 15 secondes ou plus. Ensuite, rééchantillonnez à 44100 Hz et mono, et divisez automatiquement l'ensemble de données en un ensemble d'entraînement et un ensemble de validation pour générer un fichier de configuration. Régénérez Hubert et f0. Ensuite, vous pouvez commencer la formation et l'inférence. Pour des étapes spécifiques, vous pouvez accéder à la page du projet GitHub pour voir(fin de l'article du guide) .

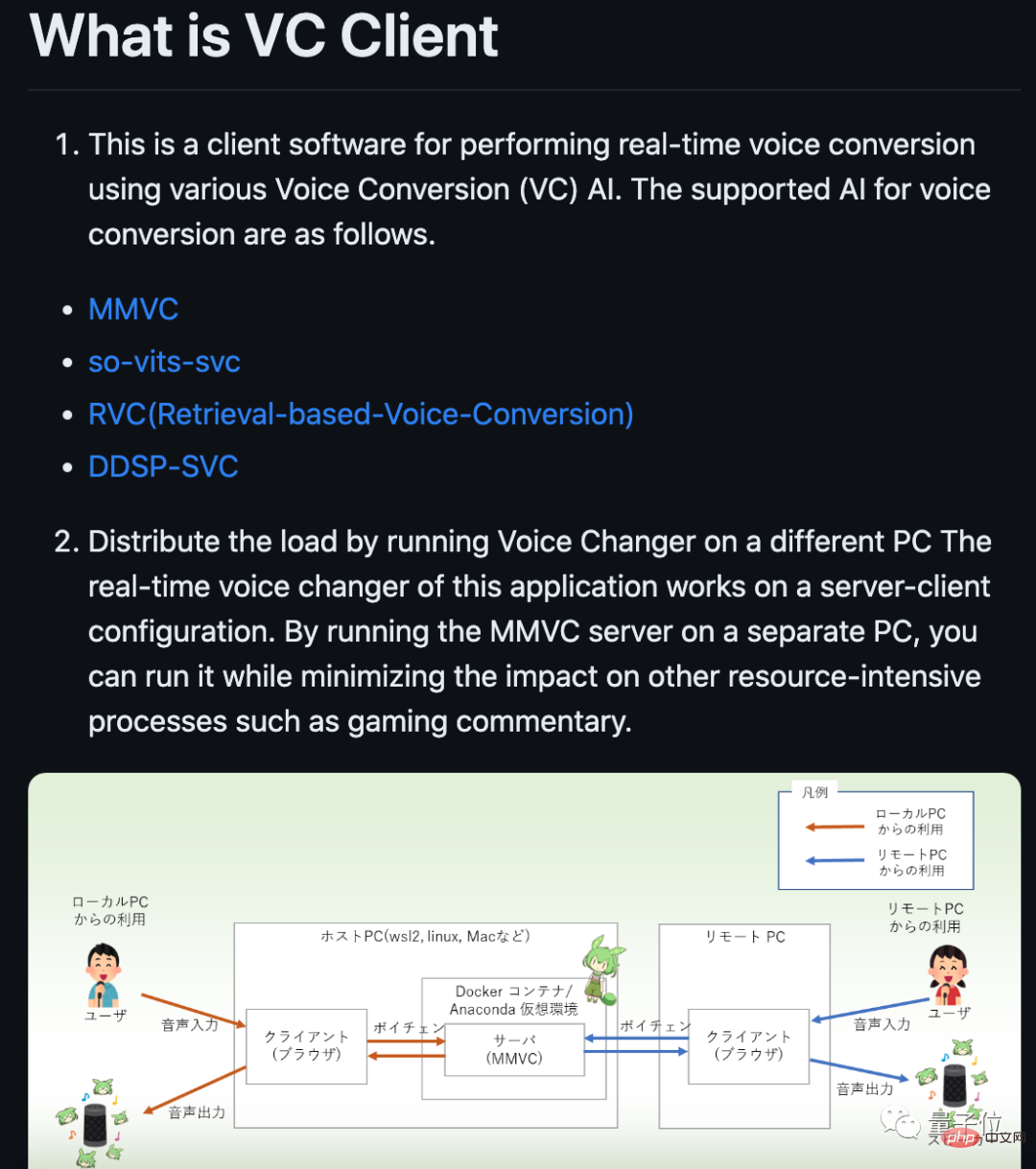

Il est à noter que ce projet a été lancé en mars de cette année et compte actuellement 25 contributeurs. À en juger par les profils des utilisateurs contributeurs, beaucoup devraient provenir de Chine. On dit que lorsque le projet a été lancé pour la première fois, il y avait de nombreuses failles et une programmation nécessaire. Cependant, les gens le mettaient à jour et le corrigeaient presque tous les jours, et maintenant le seuil d'utilisation a été considérablement abaissé. . Actuellement, le projet a cessé de se mettre à jour, mais certains développeurs ont quand même créé de nouvelles branches. Par exemple, certaines personnes ont créé un client qui prend en charge la conversion en temps réel.

Miuzarte, de l'introduction Le jugement d'adresse devrait provenir du Guangxi.

(. https://www.bilibili.com/read/cv22375562).

Il convient de noter que la formation du modèle nécessite des cartes graphiques relativement élevées, et divers problèmes peuvent survenir si la mémoire graphique est inférieure à 6 Go.

Jack-Cui a recommandé d'utiliser la carte N. Il a utilisé une RTX 2060 S et il a fallu environ 14 heures pour entraîner son modèle.

Les données d'entraînement sont également essentielles. Plus l'audio est de haute qualité, meilleur est l'effet final.

Je m'inquiète toujours des problèmes de droits d'auteur

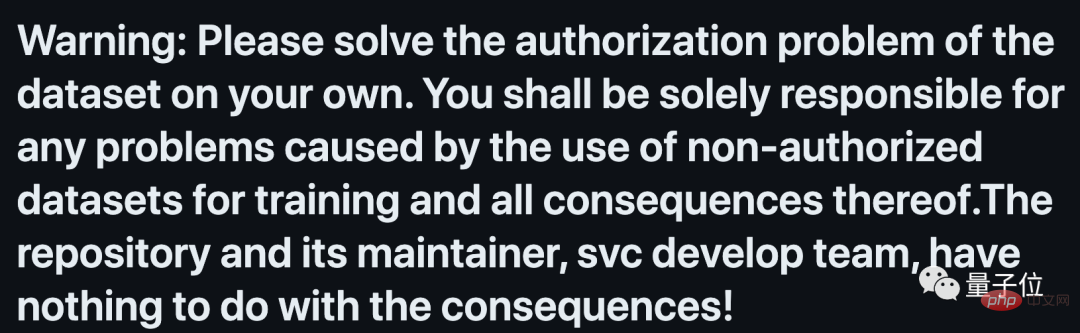

Il convient de mentionner que sur la page d'accueil du projet de so-vits-svc, les problèmes de droits d'auteur sont soulignés.

Attention : Veuillez résoudre vous-même le problème d'autorisation des données définies. Vous êtes seul responsable de tout problème résultant de l’utilisation d’ensembles de données non autorisés à des fins de formation et de toutes les conséquences qui en découlent. Le référentiel, ses responsables et l'équipe de développement svc n'ont rien à voir avec les résultats générés

C'est un peu similaire à l'époque où la peinture IA est devenue populaire !

Étant donné que les données initiales du contenu généré par l'IA sont basées sur des œuvres humaines, il existe des différends sans fin sur le droit d'auteur.

Et avec la popularité des œuvres d'IA, certains titulaires de droits d'auteur ont pris des mesures pour supprimer des vidéos de la plateforme.

Il est entendu qu'une chanson synthétisée par l'IA "Heart on My Sleeve" est devenue populaire sur Tik Tok. Elle synthétisait la version chantée par Drake et Weekend.

Mais ensuite, la maison de disques de Drake et Weekend, Universal Music, a retiré la vidéo de la plateforme et a demandé aux contrefacteurs potentiels dans une déclaration : « Devrions-nous nous tenir du côté des artistes, des fans et de l'expression créative humaine, ou devrions-nous nous tenir du côté des artistes, des fans et de l'expression créative humaine ? Du côté des artistes, des fans et de l’expression créative humaine ? Du côté des deepfakes, de la fraude et du refus de payer une compensation aux artistes ?

De plus, le chanteur Drake a exprimé son mécontentement à l’égard des reprises générées par l’IA.

D'un autre côté, il y a aussi des gens qui choisissent d'adopter cette technologie.

La chanteuse canadienne Grimes a déclaré qu'elle était prête à laisser les autres utiliser sa voix pour synthétiser des chansons, mais qu'elle devait payer la moitié des redevances.

Adresse GitHub : https://github.com/svc-develop-team/so-vits-svc

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI