Maison >Périphériques technologiques >IA >GPT-4 a commencé les tests internes de la version de longueur d'entrée 32 000 ! Avez-vous reçu l'invitation?

GPT-4 a commencé les tests internes de la version de longueur d'entrée 32 000 ! Avez-vous reçu l'invitation?

- PHPzavant

- 2023-05-11 09:58:051006parcourir

Xi Xiaoyao Technology Talk Original

Auteur | Xiaoxi, ZenMoore

Quel est le plus gros problème avec GPT-4 actuellement ? Peut-être qu'à part l'hallucination temporaire de la machine contre laquelle il ne pouvait rien faire, c'était la longueur d'entrée bloquée. Bien que la longueur de contexte d'environ 8 000 de la version ordinaire actuelle de GPT-4 puisse être plus que suffisante dans les scénarios généraux de conversation et de recherche, la version de base actuelle de GPT-4 est encore quelque peu étendue dans des aspects tels que la génération de contenu et la lecture intelligente.

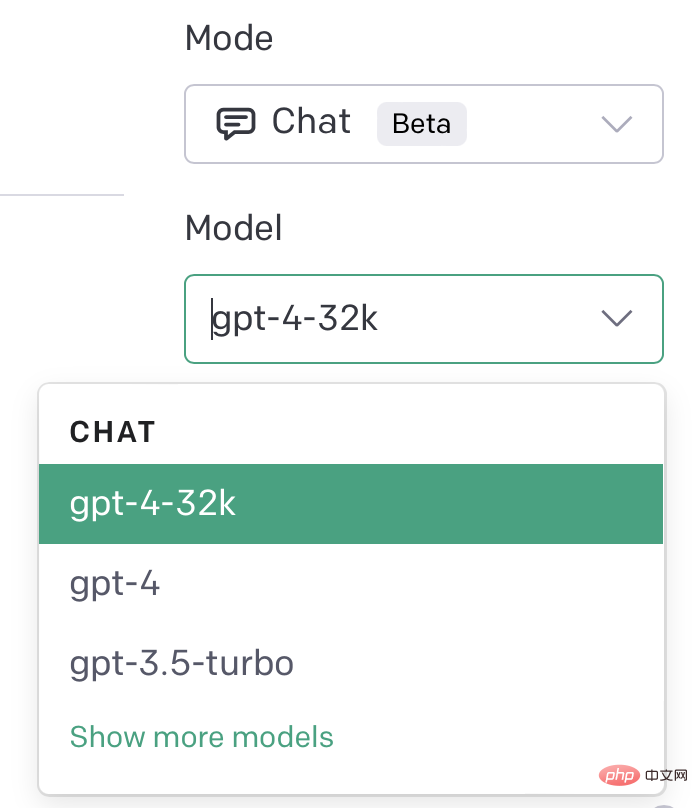

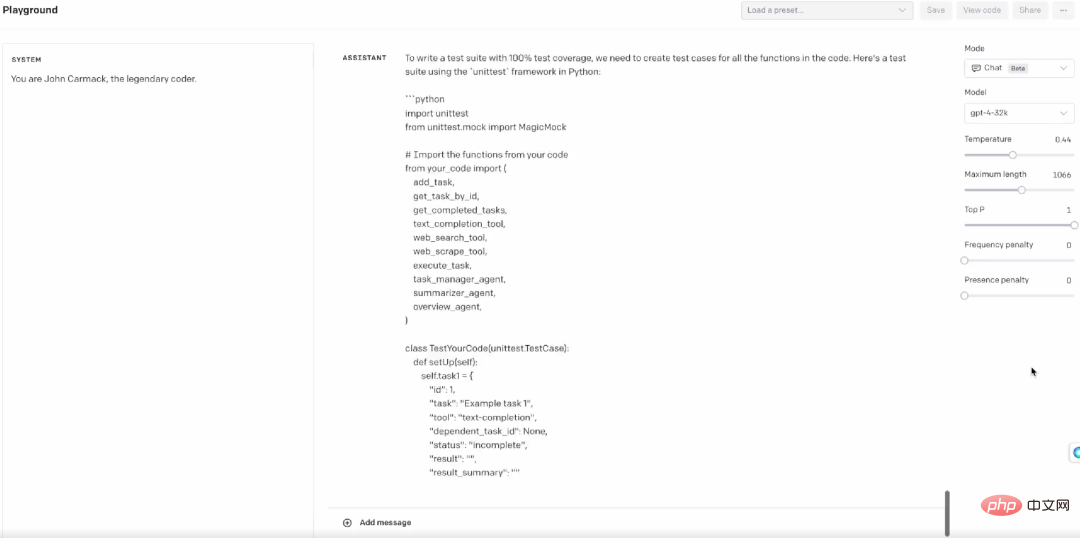

Cependant, il a également été mentionné lors de la conférence de presse GPT-4 qu'en fait GPT-4 prend en charge 32 768 longueurs de jetons, mais il n'a pas encore été entièrement publié, mais sera automatiquement mis à jour les uns après les autres. Au cours des deux derniers jours, l’aube du 32k GPT-4 semble bientôt arriver ! De nombreux utilisateurs de GPT-4 peuvent déjà voir l'option GPT-4 32k sur leur PlayGround.

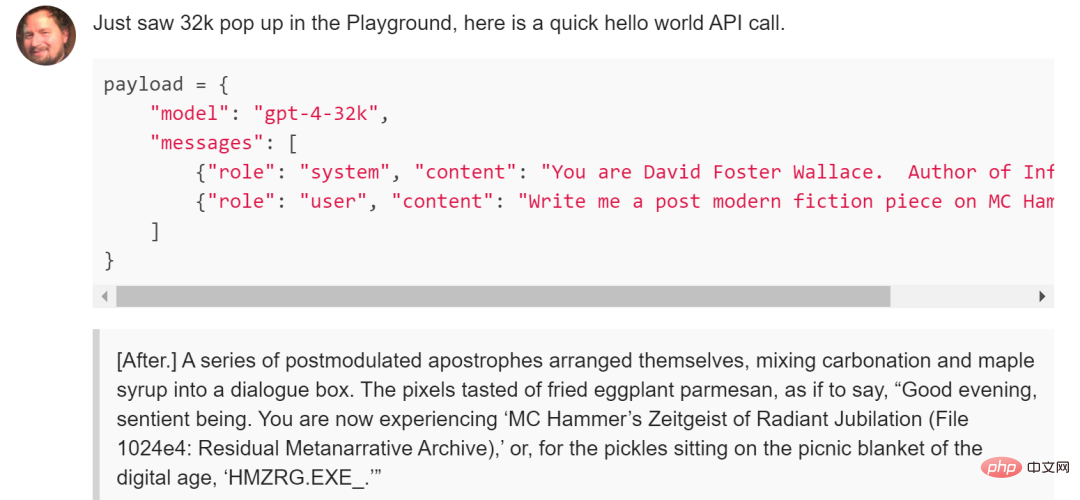

Dans l'API, vous pouvez également appeler la version mise à niveau en spécifiant le modèle de GPT-4-32K

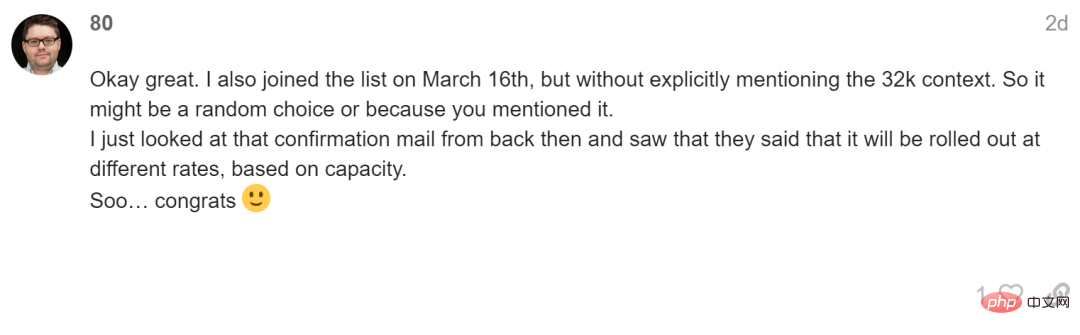

Cependant, cela devrait encore être un test interne de GPT-4 pour certains utilisateurs, et cela ne devrait pas être Le quota de test interne est libéré en fonction du moment de la candidature à la liste d'attente. Les utilisateurs qui ont reçu la version 32k du test interne ont rejoint la liste d'attente le 16 mars, mais il y a aussi des utilisateurs qui l'ont rejoint en même temps et l'ont fait. pas débloquer la version 32k. Une raison possible est que les utilisateurs qui ont reçu la version bêta fermée ont souligné leur grand intérêt pour le 32k GPT-4 lors de leur inscription.

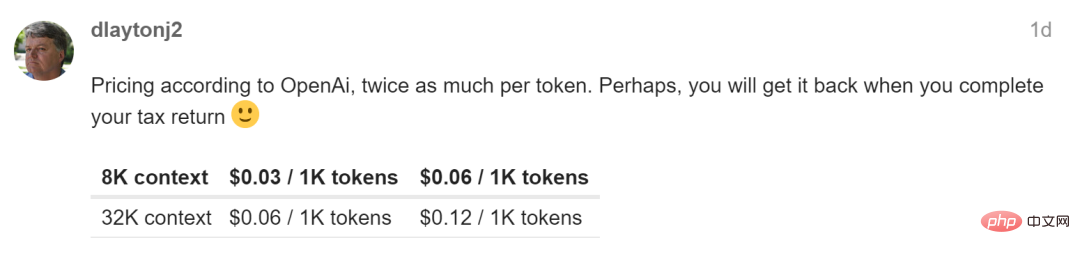

Bien sûr, quoi qu'il arrive, le 32k GPT-4 semble se rapprocher de nous, alors quel genre de changements imaginatifs le 32k GPT-4 apportera-t-il ? Après tout, elle est deux fois plus chère que la version 8k de GPT-4, et peut avoir un temps de réponse plus lent...

Un exemple est un robot conversationnel lorsque la longueur du contexte est étendue à 50 pages, alors. Cela peut grandement éviter les problèmes d'intégration complexes causés par le glissement hors de la fenêtre 8k. Un autre exemple est l'extraction et l'interprétation d'une grande quantité d'informations complexes telles que des articles et des rapports de recherche. Actuellement, les données doivent être divisées et extraites étape par étape via des méthodes structurées. Cependant, la longueur du contexte de 32 Ko peut éviter ces problèmes en un seul. est tombé d’un seul coup. Un autre exemple est un petit test réalisé par le blogueur Twitter Matt Shumer, en fournissant à GPT-4 32k un exemple de code, il a réalisé un ensemble complet de cas de test en quelques secondes, ce qui est également très utile pour l'ingénierie.

En plus d'OpenAI, il existe également des modèles open source qui ouvrent des modèles de langage à grande échelle avec des longueurs de contexte encore plus grandes. Ce MPT-7B (également connu sous le nom de Llongboi) est sorti le 5 de ce mois. Le plus gros point fort de Llongboi, dont la formation a coûté 200 000 dollars américains, est qu'il prend en charge le contexte 64k et peut servir une variété de scénarios tels que la génération de contenu. et discuter.

Adresse du blog : https://www.php.cn/link/894a200a66c2b57205af564d6883882a

Lien du projet : https://www.php.cn/link/18fe8ebf5d52c8992581f 43 9ba783aa3

Bien sûr, ouvert projets sources Les performances et la stabilité ne sont certainement pas comparables à celles de GPT-4. Maintenant que certaines personnes ont commencé à recevoir des invitations pour 32k GPT-4, je pense que cela nous rencontrera certainement bientôt, alors "J'espère que cela accélérera". Bar!

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI