Maison >Périphériques technologiques >IA >Interprétation du dernier article HuggingGPT de Microsoft, qu'avez-vous appris ?

Interprétation du dernier article HuggingGPT de Microsoft, qu'avez-vous appris ?

- WBOYavant

- 2023-04-29 19:40:051004parcourir

Microsoft a récemment publié un article sur HuggingGPT. Adresse d'origine : HuggingGPT : Résoudre les tâches d'IA avec ChatGPT et ses amis dans Hugging Face[1]. Cet article est une interprétation de l’article.

HuggingGPT : résoudre des tâches d'IA avec ChatGPT et ses amis en Hugging Face Traduit en chinois : HuggingGPT : résoudre des tâches d'IA avec ChatGPT et ses amis en Hugging Face.

Quels sont ses amis ? Après avoir lu l'article, il devrait s'agir du grand modèle de langage représenté par GPT4 et de divers modèles experts. Le modèle expert évoqué dans cet article est relatif au modèle général et est un modèle dans un domaine précis, comme un modèle dans le domaine médical, un modèle dans le domaine financier, etc.

Hugging Face est une communauté et une plateforme d'apprentissage automatique open source.

Vous pouvez rapidement comprendre le contenu principal de l'article en répondant aux questions suivantes.

- Quelle est l'idée derrière HuggingGPT et comment ça marche ?

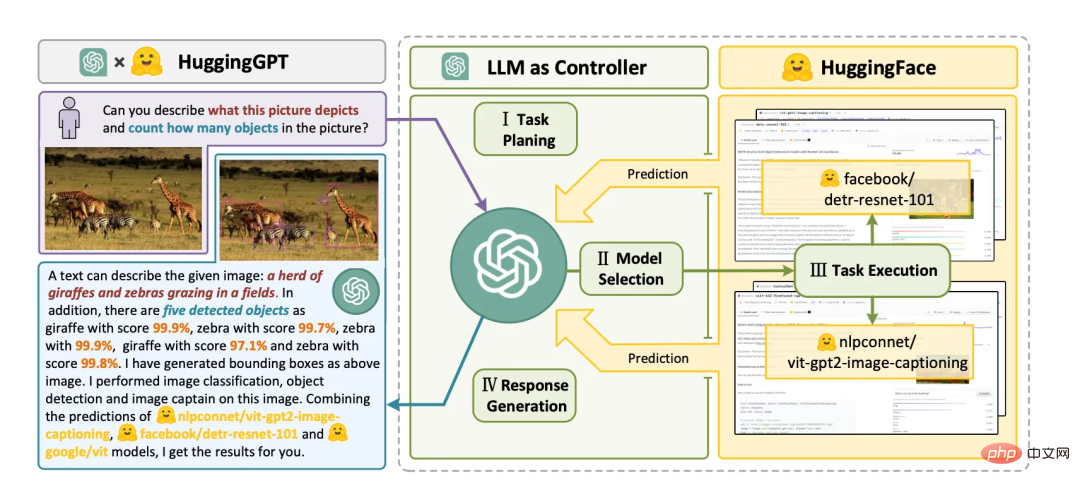

- L'idée derrière HuggingGPT est d'utiliser de grands modèles de langage (LLM) comme contrôleurs pour gérer les modèles d'IA et résoudre des tâches d'IA complexes. HuggingGPT fonctionne en tirant parti des atouts de LLM en matière de compréhension et de raisonnement pour disséquer les demandes des utilisateurs et les décomposer en plusieurs sous-tâches. Ensuite, sur la base de la description du modèle expert, HuggingGPT attribue le modèle le plus adapté à chaque tâche et intègre les résultats des différents modèles. Le flux de travail de HuggingGPT comprend quatre étapes : la planification des tâches, la sélection du modèle, l'exécution des tâches et la génération de réponses. Vous pouvez trouver plus d’informations aux pages 4 et 16 du fichier PDF.

- Quelle est l'idée derrière HuggingGPT et comment ça marche ?

- L'idée derrière HuggingGPT est d'utiliser de grands modèles de langage (LLM) comme contrôleurs pour gérer les modèles d'IA et résoudre des tâches d'IA complexes. Le principe de fonctionnement de HuggingGPT est de profiter des avantages de LLM en matière de compréhension et de raisonnement pour analyser les intentions des utilisateurs et décomposer les tâches en plusieurs sous-tâches. Ensuite, sur la base de la description du modèle expert, HuggingGPT attribue le modèle le plus adapté à chaque tâche et intègre les résultats des différents modèles. Le flux de travail de HuggingGPT comprend quatre étapes : la planification des tâches, la sélection du modèle, l'exécution des tâches et la génération de réponses. Vous pouvez trouver plus d’informations aux pages 4 et 16 du fichier PDF.

- Comment HuggingGPT utilise-t-il le langage comme interface commune pour améliorer les modèles d'IA ?

- HuggingGPT utilise le langage comme interface commune pour améliorer les modèles d'IA en utilisant un grand modèle de langage (LLM) comme contrôleur pour gérer l'IA modèle. LLM peut comprendre et raisonner les demandes en langage naturel des utilisateurs, puis décomposer la tâche en plusieurs sous-tâches. Sur la base de la description du modèle expert, HuggingGPT attribue le modèle le plus adapté à chaque sous-tâche et intègre les résultats des différents modèles. Cette approche permet à HuggingGPT de couvrir des tâches d'IA complexes dans de nombreuses modalités et domaines différents, notamment le langage, la vision, la parole et d'autres tâches difficiles. Vous pouvez trouver plus d’informations aux pages 1 et 16 du fichier PDF.

- Comment HuggingGPT utilise-t-il de grands modèles de langage pour gérer les modèles d'IA existants ?

- HuggingGPT utilise de grands modèles de langage comme interfaces pour acheminer les demandes des utilisateurs vers des modèles experts, combinant efficacement les capacités de compréhension linguistique des grands modèles de langage et d'autres expertises de modèles experts. Le grand modèle de langage agit comme le cerveau de la planification et de la prise de décision, tandis que le petit modèle agit comme l'exécuteur de chaque tâche spécifique. Ce protocole de collaboration entre modèles offre de nouvelles façons de concevoir des modèles généraux d’IA. (Page 3-4)

- Quels types de tâches d'IA complexes HuggingGPT peut-il résoudre ?

- HuggingGPT peut résoudre un large éventail de tâches couvrant diverses modalités telles que le langage, l'image, l'audio et la vidéo, y compris la détection, la génération, Diverses formes de tâches telles que la classification et les questions et réponses. Des exemples de 24 tâches que HuggingGPT peut résoudre incluent la classification de texte, la détection d'objets, la segmentation sémantique, la génération d'images, la réponse aux questions, la synthèse vocale et la synthèse texte-vidéo. (Page 3)

- HuggingGPT peut-il être utilisé avec différents types de modèles d'IA, ou est-il limité à des modèles spécifiques ?

- HuggingGPT n'est pas limité à des modèles d'IA ou à des tâches de perception visuelle spécifiques ? Il peut résoudre des tâches dans n'importe quelle modalité ou domaine en organisant la coopération entre les modèles via de grands modèles de langage. Grâce à la planification de grands modèles de langage, les processus de tâches peuvent être spécifiés efficacement et des problèmes plus complexes peuvent être résolus. HuggingGPT adopte une approche plus ouverte, en attribuant et en organisant les tâches selon les descriptions de modèles. (Page 4)

peut être compris par analogie avec le concept d'architecture de microservices et d'architecture cloud native, qui sont très populaires actuellement. HuggingGPT est le contrôleur, qui peut être implémenté avec GPT4 et est responsable du traitement des entrées et de la décomposition du langage naturel. , planification et planification. Ce que l'on appelle la planification signifie la planification pour les travailleurs, c'est-à-dire d'autres grands modèles de langage (LLM) et des modèles experts (modèles de domaine spécifiques). Enfin, le travailleur renvoie les résultats du traitement au contrôleur et au contrôleur. intègre les résultats, les convertit en langage naturel et les restitue à l'utilisateur.

Le flux de travail de HuggingGPT se compose de quatre étapes :

- Planification des tâches : utilisez ChatGPT pour analyser les demandes des utilisateurs, comprendre leurs intentions et les décomposer en tâches résolubles.

- Sélection de modèles : pour résoudre les tâches planifiées, ChatGPT sélectionne les modèles d'IA hébergés sur Hugging Face en fonction de leurs descriptions.

- Exécution de la tâche : appelez et exécutez chaque modèle sélectionné et renvoyez les résultats à ChatGPT.

- Générer une réponse : Enfin, utilisez ChatGPT pour intégrer les prédictions de tous les modèles et générer une réponse.

Lien de citation

[1] HuggingGPT : Résoudre les tâches d'IA avec ChatGPT et ses amis dans Hugging Face : https://arxiv.org/pdf/2104.06674.pdf

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI