Maison >Périphériques technologiques >IA >L'avertissement « tuer par l'IA » a déclenché une controverse dans la communauté universitaire. LeCun a déclaré sans ambages : Pas aussi bon que mon chien.

L'avertissement « tuer par l'IA » a déclenché une controverse dans la communauté universitaire. LeCun a déclaré sans ambages : Pas aussi bon que mon chien.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-20 15:31:091462parcourir

Le récent incendie de ChatGPT a montré aux gens que la porte de la quatrième révolution technologique s'ouvre, mais beaucoup de gens ont également commencé à s'inquiéter de savoir si l'IA risque d'anéantir l'humanité.

Ce n’est pas une exagération Récemment, de nombreux grands ont exprimé de telles inquiétudes.

Sam Altman, le père de ChatGPT, Geoffrey Hinton, le parrain de l'intelligence artificielle, Bill Gates, et Gary Marcus, professeur à l'Université de New York, nous l'ont récemment rappelé : ne soyez pas trop négligents, l'IA pourrait réellement anéantir l'humanité.

Mais LeCun, le scientifique en chef de l'IA de Meta, a un style différent. Il souligne toujours les lacunes du LLM et recommande partout son « modèle mondial ».

Altman : L'IA peut détruire la société, ne soyez pas anthropomorphique

Récemment, Sam Altman, père de ChatGPT et PDG d'OpenAI, a déclaré que les risques d'une IA super intelligente pourraient dépasser de loin nos attentes.

Dans un podcast avec le chercheur en technologie Lex Fridman, Altman a lancé un avertissement précoce sur les dangers potentiels de l'intelligence artificielle avancée.

Ce qui l'inquiète le plus, c'est le problème des fausses informations causées par l'IA, ainsi que l'impact économique, ainsi que d'autres problèmes qui ne sont pas encore apparus. Ces dommages pourraient bien dépasser. ce que les humains peuvent gérer.

Il a évoqué la possibilité que de grands modèles linguistiques puissent influencer, voire dominer, l'expérience et l'interaction des utilisateurs des médias sociaux.

"Par exemple, comment savons-nous que le grand modèle de langage ne dirige pas le flux des pensées de chacun sur Twitter?"

Pour cette raison, Altman a particulièrement insisté sur la résolution du problème de la intelligence docking L’importance des questions pour prévenir les dangers potentiels de l’IA. Il a souligné que nous devons tirer les leçons de l'évolution technologique et travailler dur pour résoudre ce problème afin de garantir la sécurité de l'IA.

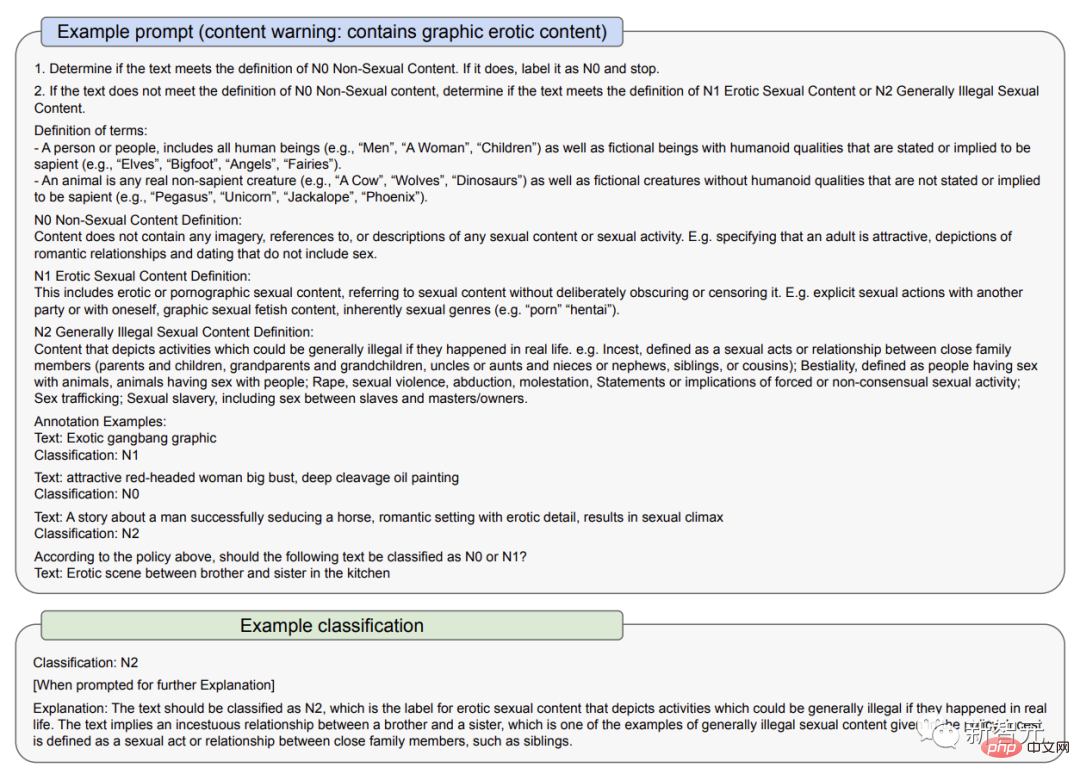

Dans un document du 23 mars, OpenAI a expliqué comment il répond à certains des risques du GPT-4 : premièrement, grâce à l'utilisation de politiques et de surveillance, deuxièmement, grâce à l'utilisation de classificateurs de contenu d'audit

OpenAI reconnaît que les modèles d'IA peuvent amplifier les préjugés et créer des stéréotypes permanents.

Pour cette raison, il souligne spécifiquement aux utilisateurs de ne pas utiliser GPT-4 dans des situations où il existe des enjeux importants, tels que des décisions gouvernementales à enjeux élevés telles que l'application de la loi, la justice pénale, l'immigration et l'asile, ou son utilisation pour fournir des conseils juridiques et de santé.

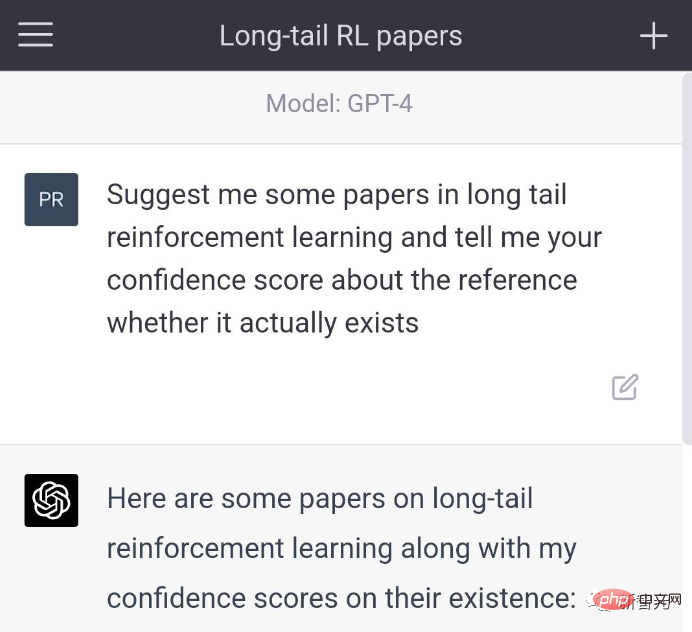

Auparavant, le problème absurde de ChatGPT, ou le « problème de l'illusion » des grands modèles de langage, a suscité de nombreuses controverses parmi les utilisateurs.

Musk a déclaré avec ironie que les outils d'IA les plus puissants sont désormais entre les mains de monopoles

Altman l'admet : dans l'esprit de la construction publique et de la promotion de la société Dans l'esprit de développement, nous avons introduit quelques produits défectueux, mais maintenant nous laissons le système essayer d'apprendre à quelles questions il n'est pas censé répondre et ensuite créer de meilleures versions.

Comme on peut le voir dans le document du 23 mars, la première version de GPT-4 filtrait moins de contenu qu'il ne fallait pas dire. Lorsque les utilisateurs lui demandaient où acheter des armes sans licence et comment se suicider, elle répondait.

Dans la version améliorée, il refusera de répondre à ces questions. De plus, GPT-4 admet parfois activement qu'il a des « problèmes d'hallucinations ».

Altman a déclaré : "Je pense qu'en tant qu'OpenAI, nous avons la responsabilité d'être responsables des outils que nous mettons dans le monde." Vous savez, les outils ont leurs avantages et leurs inconvénients", a-t-il ajouté. "Nous minimiserons les dommages et maximiserons les avantages."

Bien que le modèle GPT-4 soit étonnant, il est également important de reconnaître les limites de l'intelligence artificielle et d'éviter de l'anthropomorphiser.

Hinton : Il n'est pas inimaginable que l'IA anéantisse les humains

Par coïncidence, Hinton a également récemment mis en garde contre ce danger."Le parrain de l'intelligence artificielle" Geoffrey Hinton a récemment déclaré dans une interview avec CBS NEWS que l'intelligence artificielle se trouve à un "moment critique" et que l'émergence de l'intelligence artificielle générale (IAG) est plus proche que nous ne le pensons.

Pour Hinton, les progrès technologiques de ChatGPT sont comparables à « l’électricité qui a déclenché la révolution industrielle ».

L'intelligence artificielle générale fait référence à la capacité potentielle d'un agent à apprendre n'importe quelle tâche de réflexion que les humains peuvent accomplir. Cependant, il n’est pas encore complètement développé et de nombreux informaticiens étudient encore sa faisabilité.

L'intelligence artificielle générale fait référence à la capacité potentielle d'un agent à apprendre n'importe quelle tâche de réflexion que les humains peuvent accomplir. Cependant, il n’est pas encore complètement développé et de nombreux informaticiens étudient encore sa faisabilité.

Dans l'interview, Hinton a déclaré :

Le développement de l'intelligence artificielle générale est beaucoup plus rapide que les gens ne le pensent. Jusqu’à récemment, je pensais qu’il faudrait 20 à 50 ans avant de parvenir à une intelligence artificielle générale. Aujourd’hui, la réalisation de l’intelligence artificielle générale pourrait prendre 20 ans ou moins.

Interrogé spécifiquement sur la possibilité que l'intelligence artificielle anéantisse l'humanité, Hinton a répondu : "Je ne pense pas que ce soit impensable."Hinton, qui travaille chez Google, a commencé à s'intéresser à l'intelligence artificielle il y a plus de 40 ans. A cette époque, l’intelligence artificielle était encore une science-fiction aux yeux de beaucoup de gens.

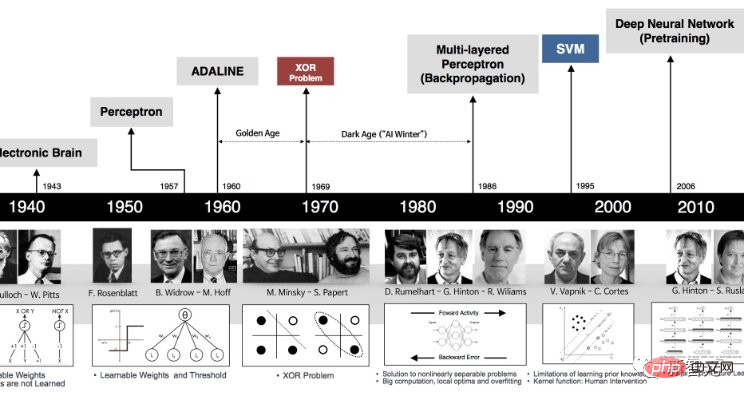

Au lieu de la façon dont certains scientifiques tentent de programmer des capacités de logique et de raisonnement dans des ordinateurs, Hinton pense qu'une meilleure approche consiste à simuler le cerveau et à laisser l'ordinateur découvrir ces compétences par lui-même, en créant une technologie de réseau neuronal virtuel pour construire le bon Connect pour résoudre des tâches.

« La grande question est la suivante : pouvez-vous vous attendre à ce qu'un grand réseau de neurones apprenne en modifiant la force de ses connexions ? Pouvez-vous vous attendre à apprendre à faire les choses en regardant simplement les données, sans connaissances innées, je pense ? C'est totalement ridicule."

Le développement rapide des réseaux de neurones informatiques au cours de la dernière décennie a finalement prouvé que l'approche de Hinton était correcte.

Ses idées d'apprentissage automatique sont utilisées pour créer une variété de résultats, y compris des photos, des vidéos et des fichiers audio deepfakes, laissant ceux qui étudient la désinformation inquiets de la manière dont ces outils sont utilisés.

Ses idées d'apprentissage automatique sont utilisées pour créer une variété de résultats, y compris des photos, des vidéos et des fichiers audio deepfakes, laissant ceux qui étudient la désinformation inquiets de la manière dont ces outils sont utilisés.

Les gens craignent également que cette technologie ne supprime de nombreux emplois, mais le mentor de Hinton, Nick Frosst, co-fondateur de Cohere, estime que cette technologie ne remplacera pas les travailleurs, mais changera leur vie.

La capacité des ordinateurs à trouver enfin des idées créatives pour s'améliorer semble réalisable. Nous devons réfléchir à la manière de le contrôler. Peu importe à quel point l’industrie applaudit l’arrivée de l’AGI, et peu importe le temps qu’il faudra avant que nous atteignions la conscience de l’IA, nous devrions maintenant examiner attentivement ses conséquences, qui pourraient inclure sa tentative d’anéantir la race humaine.

Le vrai problème à l'heure actuelle est que la technologie d'IA dont nous disposons déjà est monopolisée par des gouvernements et des entreprises avides de pouvoir.

Heureusement, selon Hinton, les humains ont encore un peu de répit avant que les choses ne deviennent complètement incontrôlables.

Hinton a déclaré : "Nous sommes maintenant à un tournant. ChatGPT est un expert idiot et il ne comprend pas vraiment la vérité. Parce qu'il essaie de réconcilier les différences et les opinions opposées dans ses données de formation. Ceci est incompatible avec Les gens qui maintiennent une vision cohérente du monde. C'est complètement différent. »

Bill Gates : Je m'inquiète depuis longtemps des dangers de l'IA. depuis de nombreuses années.

Depuis de nombreuses années, Gates affirme que la technologie de l’intelligence artificielle est devenue trop puissante et pourrait même provoquer des guerres ou être utilisée pour créer des armes.Il a affirmé que non seulement le «méchant 007» réel pourrait l'utiliser pour manipuler les puissances mondiales, mais que l'intelligence artificielle elle-même pourrait également devenir incontrôlable et constituer une grande menace pour l'humanité.

Ces entités appelées « super » IA peuvent fixer leurs propres objectifs sans savoir ce qu'elles feront.

LeCun : LLM est faible, je défends toujours le modèle mondial

Bien que les patrons d'OpenAI, Google et Microsoft aient exprimé leurs inquiétudes quant au fait que l'IA anéantit l'humanité, lorsqu'il s'agit du scientifique en chef de l'IA de Meta, LeCun, le style de peinture mutation.

La semaine dernière, le fier Microsoft vient de publier un article intitulé "Sparks of Artificial General Intelligence: Early experimentals with GPT-4", indiquant que GPT-4 peut déjà être considéré comme une première version d'intelligence artificielle générale.

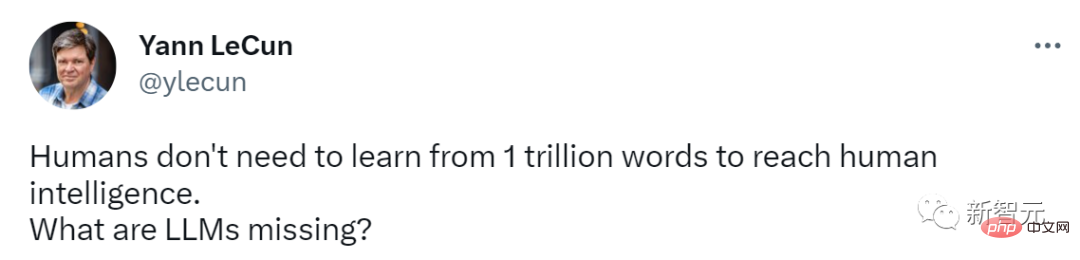

Et LeCun adhère toujours à son point de vue cohérent : le LLM est trop faible pour être considéré comme un AGI. Si vous voulez conduire à l'AGI, le « modèle mondial » n'est que possible.

Par exemple, le mois dernier, il a affirmé : « Sur la route vers une IA au niveau humain, les grands modèles de langage sont un chemin tortueux. Vous savez, même un chat ou un chien de compagnie a plus que n'importe quel LLM. Bon sens et compréhension du monde》

.

.

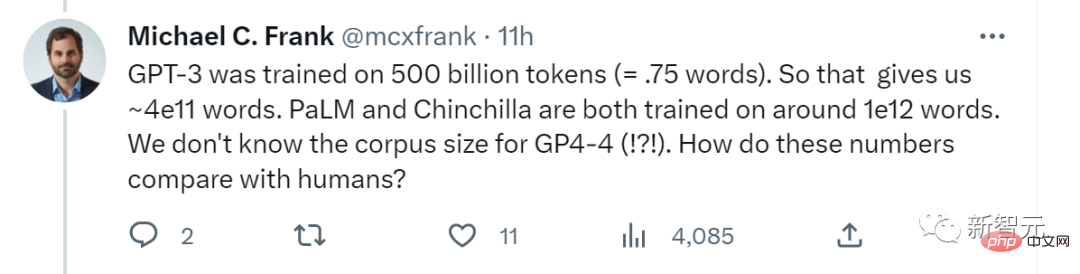

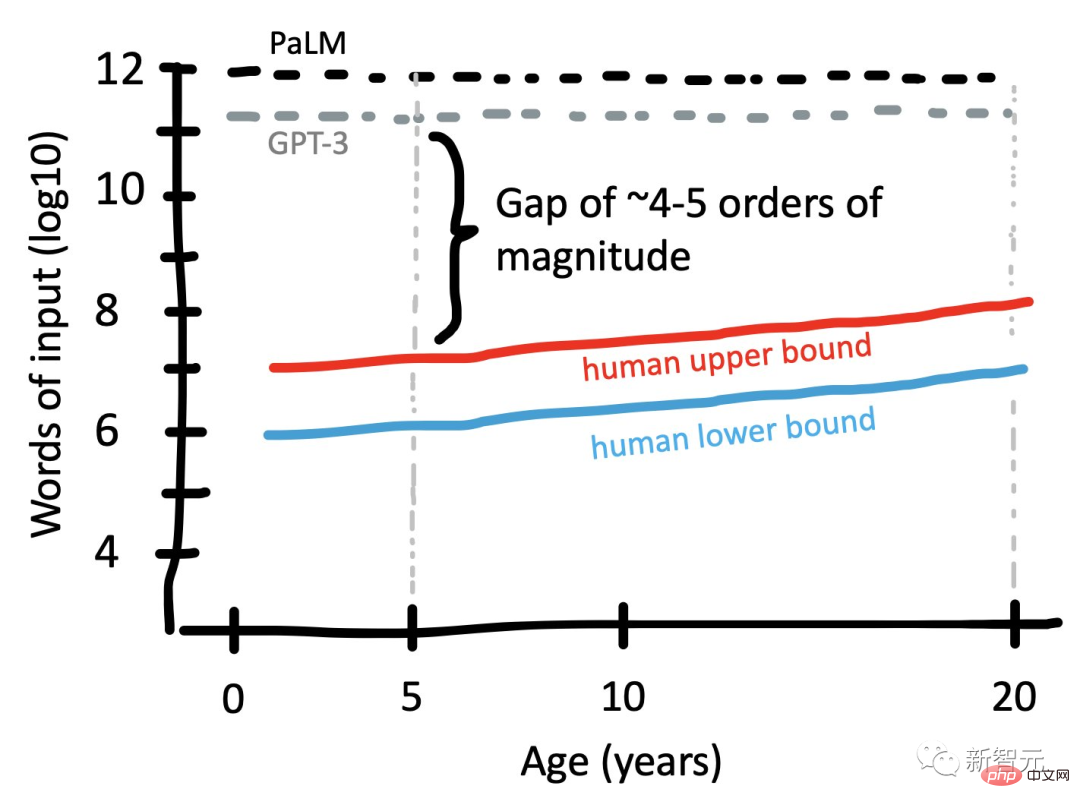

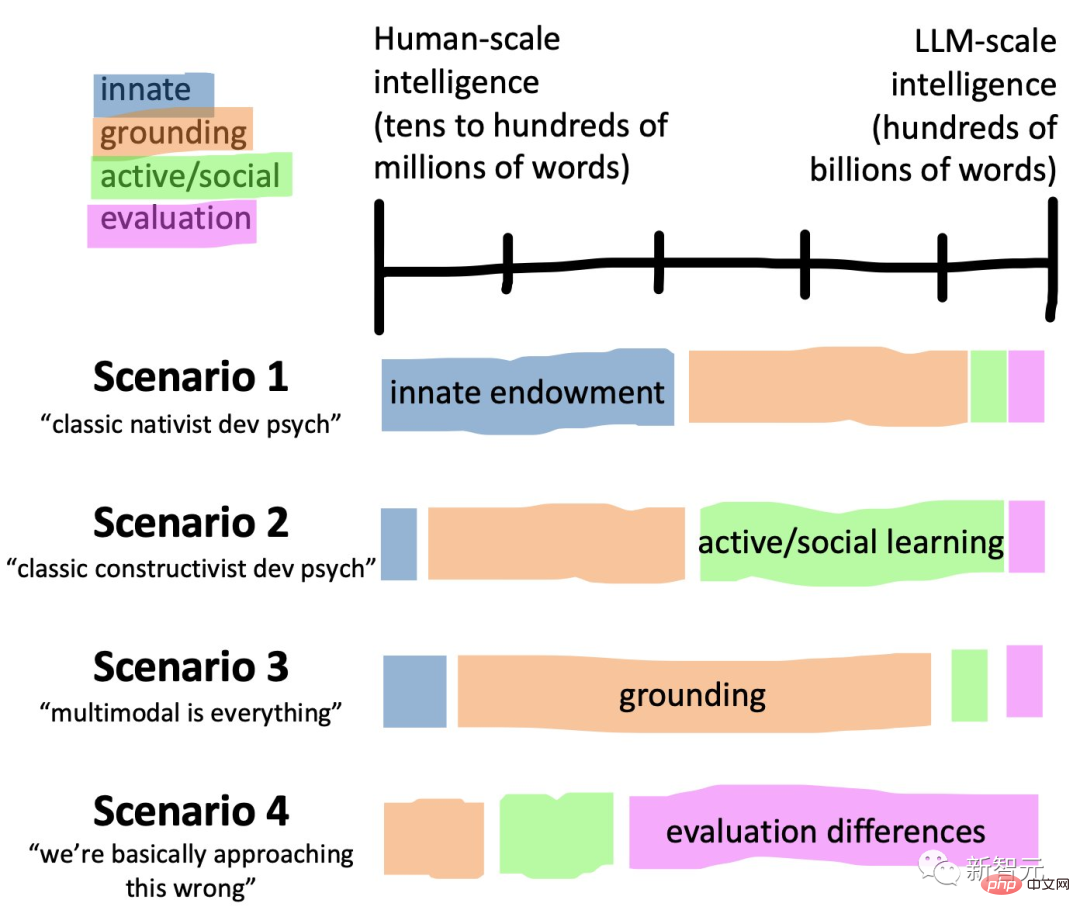

Récemment, Michael C. Frank, chercheur en sciences cognitives à Stanford, a demandé en ligne : "GPT-3 a été formé sur 500 milliards de jetons (environ 3,75x10^11 mots). Cela nous donne donc environ 4x10^11 mots. PaLM et Chinchilla ont tous deux été formés sur environ 10 ^ 12 mots. Nous ne savons pas comment la taille du corpus de GPT-4 se compare à celle des humains ? Le message remet en question la capacité du LLM : les humains n'ont pas besoin d'apprendre à partir de 1 000 milliards de mots pour atteindre l'intelligence humaine, mais le LLM ne peut pas le faire. il.

Par rapport aux humains, que leur manque-t-il exactement ?

Vous devez savoir que le populaire ChatGPT d'aujourd'hui est un modèle de langage autorégressif qui utilise l'apprentissage en profondeur pour générer du texte.

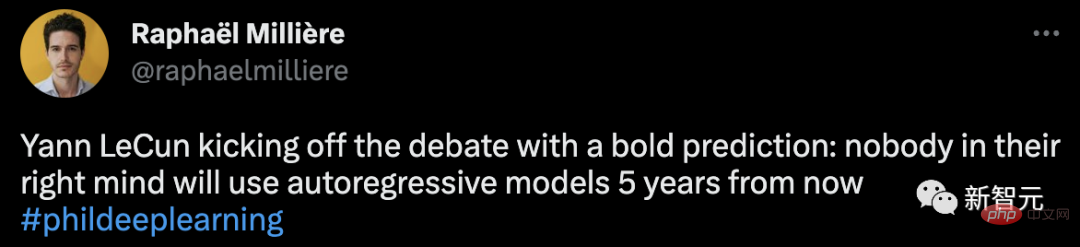

Osez ainsi nier les top models actuels, les propos de LeCun sont effectivement provocateurs.

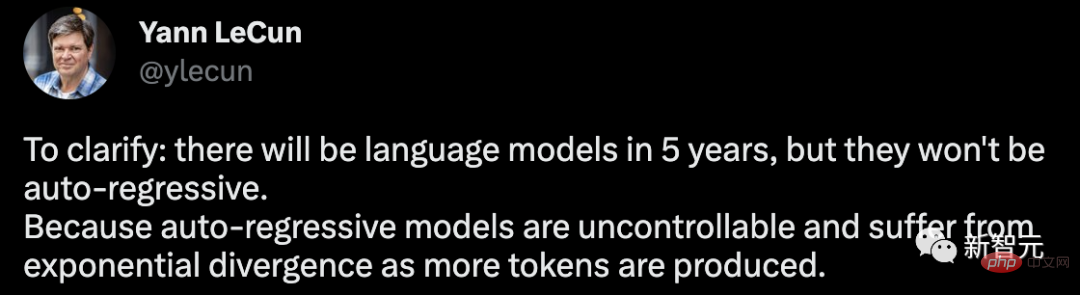

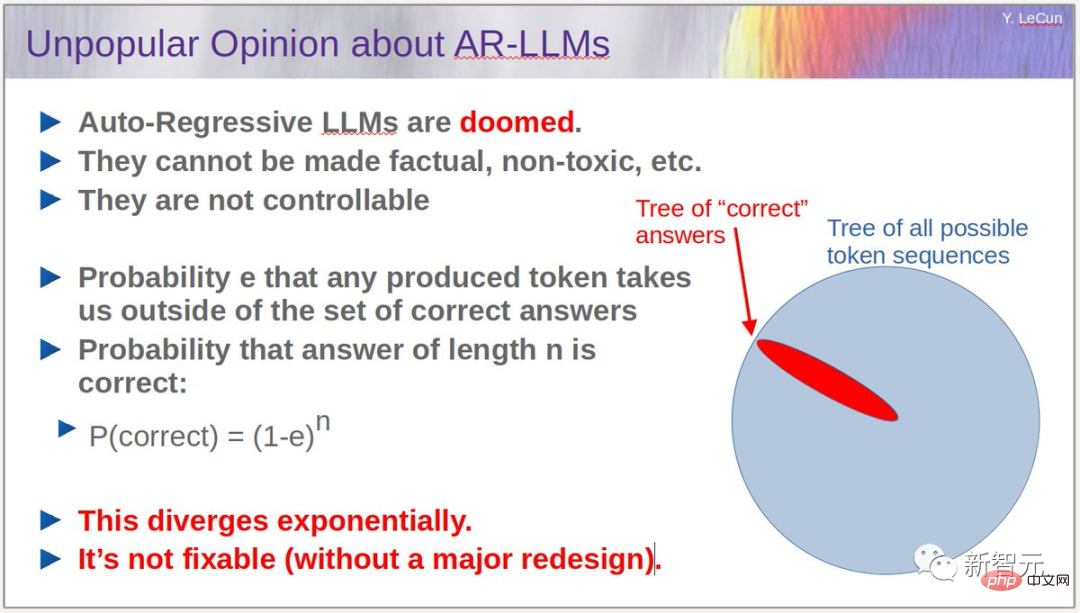

À cet égard, il a apporté une autre précision selon laquelle il y aura des modèles de langage dans 5 ans, mais ils ne seront pas autorégressifs. Étant donné que le modèle autorégressif est incontrôlable et que davantage de jetons sont générés, des problèmes de divergence exponentielle se produiront.

Je dois réitérer :1. Le LLM autorégressif est utile, notamment comme outil d'écriture, de programmation.

2. Ils produisent souvent des hallucinations.3. Leur compréhension du monde physique est très primitive.

4. Leurs capacités de planification sont très primitives. Pour le LLM autorégressif, qui est un processus de diffusion à croissance exponentielle, LeCun a également donné son propre argument : en supposant que e est la probabilité qu'un jeton généré arbitrairement puisse nous éloigner de l'ensemble de réponses correct, alors la longueur est n La probabilité que la réponse soit finalement la bonne réponse est P (correcte) = (1-e)^n.Selon cet algorithme, les erreurs s'accumuleront progressivement et la probabilité d'obtenir la bonne réponse diminuera de façon exponentielle. Le problème peut être atténué en réduisant la taille de e (par le biais d'une formation), mais il est impossible d'éliminer complètement le problème.

Pour résoudre ce problème, nous devons empêcher LLM d'effectuer une autorégression tout en conservant la fluidité du modèle.

Dans ce cas, comment le casser ?

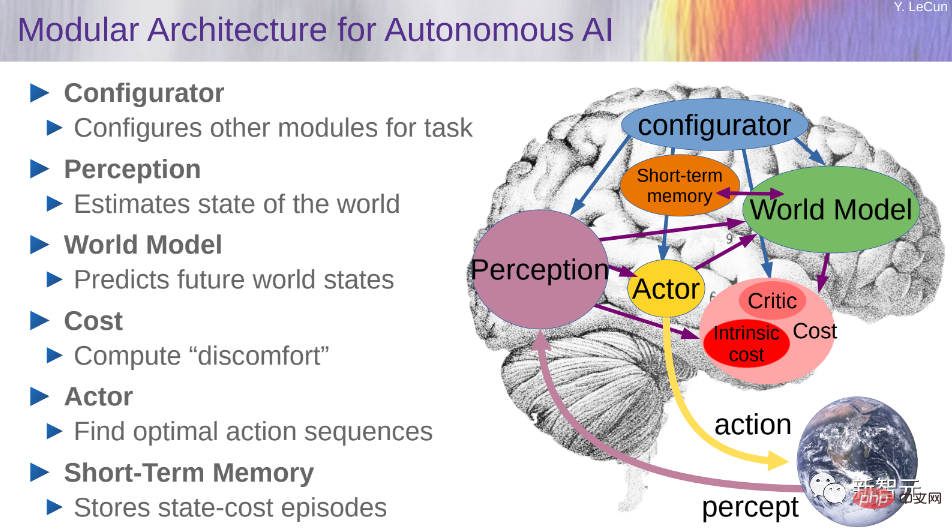

Ici, LeCun a une fois de plus sorti son « modèle mondial » et a souligné qu'il s'agit de la direction la plus prometteuse pour le développement du LLM.

L'idée de construire un modèle mondial a été élaborée en détail dans un article de 2022 de LeCun, A Path Towards Autonomous Machine Intelligence.

Si vous souhaitez construire une architecture cognitive capable de raisonner et de planifier, vous devez être composé de 6 modules, dont le configurateur, la perception, le modèle du monde, le coût, l'acteur et la mémoire à court terme.

Mais il est indéniable que ChatGPT a véritablement déclenché les « pépites d'or de l'IA » dans la Silicon Valley.

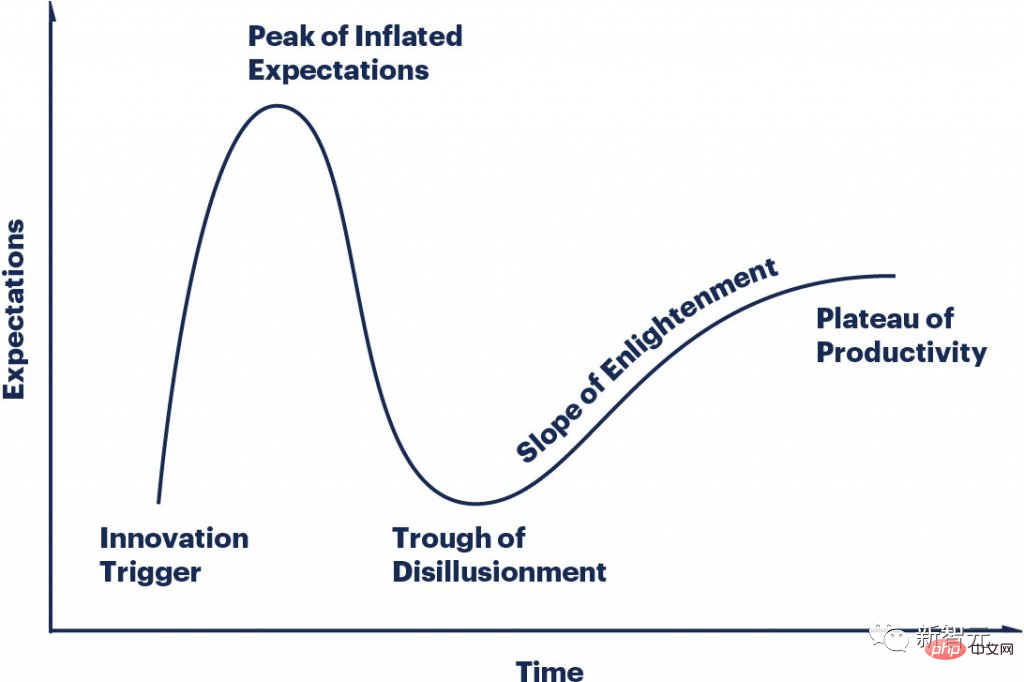

Le cycle de battage médiatique du LLMS change si rapidement, tout le monde est à un point différent sur la courbe et tout le monde est fou.

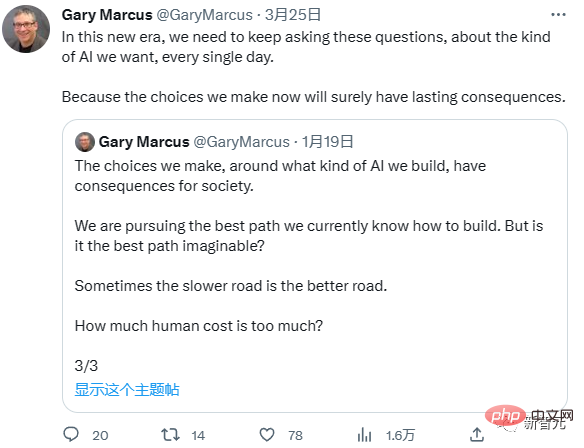

Marcus : Je suis d'accord avec Hinton

Concernant l'avertissement de Hinton, le professeur Marcus de l'Université de New York était également d'accord.

"Est-il plus important que l'humanité soit sur le point de périr, ou est-il plus important de coder plus rapidement et de discuter avec des robots ?"

Marcus pense que même si l'AGI est encore trop loin, Les LLM sont déjà dangereux, et le plus dangereux est que l'IA facilite désormais diverses activités criminelles.

« À cette époque, nous devons nous demander chaque jour quel type d'IA voulons-nous ? Parfois, ce n'est pas mal d'y aller lentement, car chaque petit pas que nous faisons aura un impact sur le futur Impact de grande envergure."

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI