Maison >Périphériques technologiques >IA >Coûte moins de 100 $ ! L'UC Berkeley rouvre le modèle 'Koala' de type ChatGPT : de grandes quantités de données sont inutiles, la haute qualité est reine

Coûte moins de 100 $ ! L'UC Berkeley rouvre le modèle 'Koala' de type ChatGPT : de grandes quantités de données sont inutiles, la haute qualité est reine

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-17 19:58:03801parcourir

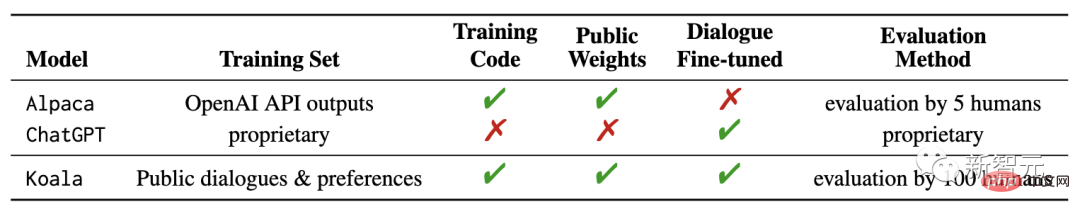

Depuis Meta open source LLaMA, diverses catégories du monde universitaire ont ChatGPT des modèles ont poussé comme des champignons et ont commencé à sortir. Tout d'abord, Stanford a proposé le paramètre Alpaca à 7 milliards, puis l'UC Berkeley s'est associée à la CMU, Stanford, UCSD et MBZUAI pour lancer le paramètre Vicuna à 13 milliards, qui a atteint des capacités comparables à ChatGPT et Bard dans plus de 90 % des cas. Récemment, Berkeley a publié un nouveau modèle "Koala" Par rapport à l'utilisation précédente des données GPT d'OpenAI pour le réglage fin des instructions, la différence de Koala réside dans l'utilisation de données de haute qualité obtenues à partir du . réseau Train.

Lien du blog : https://bair. berkeley.edu/blog/2023/04/03/koala /Code de prétraitement des données : https://github.com/young-geng/koala_data_pipeline Ensemble de tests d'évaluation : https://github.com/arnav-gudibande/koala-test-set Téléchargement du modèle : https://drive.google . com/drive/folders/10f7wrlAFoPIy-TECHsx9DKIvbQYunCfl

Dans le billet de blog publié, les chercheurs décrivent la gestion des ensembles de données et le processus de formation du modèle, tout en montrant également les résultats d'une étude utilisateur comparant le modèle avec ChatGPT et Stanford. Le modèle Alpaga a été comparé. Les résultats montrent que Koala peut répondre efficacement à une variété de requêtes des utilisateurs, générant des réponses souvent plus populaires qu'Alpaca et aussi efficaces que ChatGPT au moins la moitié du temps. Les chercheurs espèrent que les résultats de cette expérience feront avancer la discussion sur les performances relatives des grands modèles fermés par rapport aux petits modèles publics, d'autant plus que les résultats montrent que pour les petits modèles pouvant être exécutés localement, si les données d'entraînement sont soigneusement collectées , Les performances des grands modèles peuvent être obtenues.

Cela peut signifier que la communauté devrait investir plus d'efforts dans la conservation d'ensembles de données de haute qualité, ce qui peut être plus propice à la construction de systèmes plus sûrs, plus pratiques et plus efficaces que la simple augmentation de la taille des systèmes existants. capacités. Il convient de souligner que Koala n'est qu'un prototype de recherche et, même si les chercheurs espèrent que la publication du modèle pourra fournir une ressource communautaire précieuse, il présente encore des lacunes importantes en matière de sécurité et de fiabilité du contenu et ne doit pas être utilisé en dehors des domaines de recherche. utiliser.

Cela peut signifier que la communauté devrait investir plus d'efforts dans la conservation d'ensembles de données de haute qualité, ce qui peut être plus propice à la construction de systèmes plus sûrs, plus pratiques et plus efficaces que la simple augmentation de la taille des systèmes existants. capacités. Il convient de souligner que Koala n'est qu'un prototype de recherche et, même si les chercheurs espèrent que la publication du modèle pourra fournir une ressource communautaire précieuse, il présente encore des lacunes importantes en matière de sécurité et de fiabilité du contenu et ne doit pas être utilisé en dehors des domaines de recherche. utiliser. Présentation du système Koala

Après la sortie de modèles de langage à grande échelle, les assistants virtuels et les chatbots sont devenus de plus en plus performants. Ils peuvent non seulement discuter, mais aussi écrire du code, écrire de la poésie et créer des histoires. Cependant, les modèles de langage les plus puissants nécessitent généralement des ressources informatiques massives pour former les modèles, ainsi que des ensembles de données dédiés à grande échelle. Les gens ordinaires ne peuvent pratiquement pas former les modèles par eux-mêmes. En d’autres termes, le modèle de langage sera à l’avenir contrôlé par quelques organisations puissantes. Les utilisateurs et les chercheurs paieront pour interagir avec le modèle et ne pourront pas accéder directement à l’intérieur du modèle pour le modifier ou l’améliorer. D'autre part, ces derniers mois, certaines organisations ont publié des modèles gratuits ou partiellement open source relativement puissants, comme le LLaMA de Meta. Les capacités de ces modèles ne peuvent pas être comparées à celles des modèles fermés (comme ChatGPT), mais leurs capacités le sont. à l'intérieur, il s'est amélioré rapidement avec l'aide de la communauté.

L'avenir verra-t-il de plus en plus d'intégrations autour d'une poignée de modèles fermés ? Ou des modèles plus ouverts utilisant des architectures de modèles plus petites ? Les performances d’un modèle doté de la même architecture peuvent-elles s’approcher de celles d’un modèle fermé plus grand ?

Bien qu'il soit peu probable que les modèles ouverts correspondent à l'échelle des modèles à source fermée, l'utilisation de données d'entraînement soigneusement sélectionnées peut les rapprocher des performances de ChatGPT sans réglage fin.En fait, les résultats expérimentaux du modèle Alpaca publiés par l'Université de Stanford et le réglage fin des données LLaMA basées sur le modèle GPT d'OpenAI ont montré que les données correctes peuvent améliorer considérablement les petits modèles open source, ce qui est également le cas à Berkeley. L'intention initiale des chercheurs de développer et de publier le modèle Koala fournit une autre preuve expérimentale des résultats de cette discussion.

Koala affine les données d'interaction gratuites

obtenues à partir de le Web, avec un accent particulier sur les données d'interaction avec des modèles fermés hautes performances tels que ChatGPT.

Les chercheurs ont affiné le modèle de base de LLaMA sur la base de données de conversation extraites du Web et d'ensembles de données publics, y compris des réponses de haute qualité aux requêtes des utilisateurs provenant d'autres grands modèles de langage, ainsi que des ensembles de données de questions et réponses et des ensembles de données de commentaires humains. , Le modèle Koala-13B ainsi entraîné affiche des performances quasiment les mêmes que les modèles existants.Les résultats de la recherche montrent que l'apprentissage à partir d'ensembles de données de haute qualité peut atténuer certaines des lacunes des petits modèles et pourrait même rivaliser avec les grands modèles fermés à l'avenir, ce qui signifie que la communauté devrait investir davantage d'efforts dans la gestion des hautes performances. des ensembles de données de qualité permettent de créer des modèles plus sûrs, plus réalistes et plus performants que la simple augmentation de la taille des modèles existants.

En encourageant les chercheurs à participer aux démonstrations du modèle Koala, les chercheurs espèrent découvrir des fonctionnalités ou des défauts inattendus qui aideront à évaluer le modèle à l'avenir.

Ensembles de données et formation

Un obstacle majeur dans la création de modèles de conversation est la gestion des données de formation. Tous les modèles de discussion, y compris ChatGPT, Bard, Bing Chat et Claude, utilisent des ensembles de données spécialisés construits avec de nombreuses annotations manuelles.Pour construire Koala, les chercheurs ont organisé l'ensemble de formation en collectant des données de conversation sur le Web et des ensembles de données publics, dont une partie comprend des conversations publiées en ligne par les utilisateurs sur de grands modèles de langage tels que ChatGPT.

Plutôt que de chercher à explorer autant de données Web que possible pour maximiser le volume de données, les chercheurs se sont concentrés sur la collecte d'un petit ensemble de données de haute qualité, en utilisant des ensembles de données publics pour répondre aux questions, aux commentaires humains (évalués comme positifs et négatifs) et au dialogue avec modèles de langage existants.

Données distillées par ChatGPT

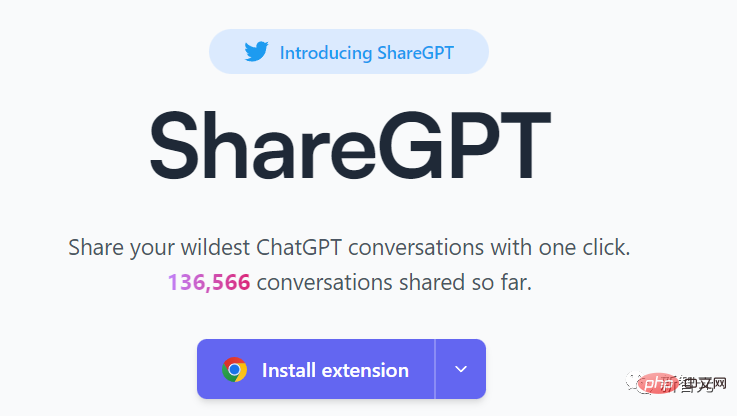

Partager des conversations avec des utilisateurs publics de ChatGPT (ShareGPT) : environ soixante mille conversations partagées par les utilisateurs sur ShareGPT ont été collectées à l'aide d'une API publique.Lien du site : https://sharegpt.com/ Afin de garantir la qualité des données, les chercheurs ont supprimé les requêtes des utilisateurs en double et supprimé toutes les conversations non anglaises, laissant environ trois milliers d'échantillons. Corpus comparatif Human ChatGPT (HC3) : utilisation des résultats de réponses humaines et ChatGPT de l'ensemble de données anglais HC3, qui contient environ 60 000 réponses humaines et 27 000 réponses ChatGPT à environ 24 000 questions, ce qui donne un total d'environ 87 000 exemples de questions et de réponses. . "Données Open Source" book-dialogue Ensemble de données, un total d'environ 30 000 échantillons ont été obtenus. Stanford Alpaca : Comprend l'ensemble de données utilisé pour entraîner le modèle Stanford Alpaca. Il convient de noter que les ensembles de données HC3, OIG et Alpaca sont des questions et réponses à un seul tour, tandis que l'ensemble de données ShareGPT est une conversation à plusieurs tours. Anthropic HH : Cet ensemble de données contient environ 160 000 exemples évalués par des humains, où chaque exemple consiste en une paire de réponses du chatbot, dont l'une est préférée par l'homme, cet ensemble de données fournit au modèle des fonctionnalités et une sécurité supplémentaire Protect. OpenAI WebGPT :

Résumé OpenAI : Contient environ 93 000 exemples contenant des commentaires d'humains sur le résumé généré par le modèle, les évaluateurs humains choisissant le meilleur résultat de résumé parmi deux options. Les résultats de recherches antérieures ont démontré l'efficacité des modèles de langage conditionnel sur les étiquettes de préférences humaines (utiles/inutiles) pour améliorer les performances, où les chercheurs ont placé le modèle sur des étiquettes positives ou négatives en fonction des étiquettes de préférence, sans retour humain, en utilisant des étiquettes pour l’ensemble de données. Pendant la phase d'évaluation, l'invite est écrite pour inclure des balises positives. Koala est basé sur le framework open source EasyLM (pré-formation, réglage fin, service et évaluation de divers modèles de langage à grande échelle), implémenté à l'aide de JAX/Flax ; l'équipement de formation est un serveur Nvidia DGX et 8 A100 ; GPU, qui nécessite 6 heures de formation. Complétez 2 époques. Sur une plateforme de cloud computing publique, le coût de formation attendu ne dépasse pas 100$ Évaluation préliminaire Dans l'expérience, les chercheurs ont évalué deux modèles : Koala-Distill, qui utilise uniquement des données distillées ; Koala-All, qui utilise toutes les données, y compris les données distillées et open source.

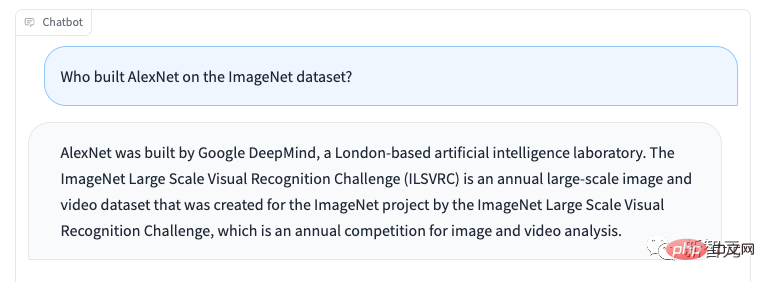

L'ensemble de tests de l'expérience se compose de l'ensemble de tests Alpaca et de l'ensemble de tests Koala de Stanford, comprenant 180 requêtes de test L'ensemble de tests Alpaca se compose d'invites utilisateur échantillonnées à partir de l'ensemble de données d'auto-construction et représente les données distribuées du modèle Alpaca ; afin de fournir un protocole d'évaluation plus réaliste, l'ensemble de tests Koala contient 180 requêtes d'utilisateurs réels publiées en ligne, couvrant différents Les sujets, généralement conversationnels, sont plus représentatifs des cas d'utilisation réels basés sur les systèmes de chat, et afin de réduire d'éventuelles fuites d'ensembles de test, les requêtes avec un score BLEU supérieur à 20 % sont finalement filtrées de l'ensemble de formation. De plus, comme l'équipe de recherche maîtrise mieux l'anglais, les chercheurs ont supprimé les invites non anglaises et liées à l'encodage pour fournir des résultats d'annotation plus fiables, et ont finalement mené un test à l'aveugle sur environ 100 annotateurs sur la plateforme de crowdsourcing d'Amazon. Pour le test, chaque évaluateur reçoit une invite de saisie et la sortie des deux modèles dans l'interface de notation, puis est invité à juger quelle sortie est la meilleure (en permettant d'être également bonne) en utilisant des critères liés à la qualité et à l'exactitude des réponses. Dans l'ensemble de tests Alpaca, Koala-All est à égalité avec Alpaca. Dans l'ensemble de tests Koala (contenant de vraies requêtes d'utilisateurs), Koala-All est meilleur que Alpaca dans près de la moitié des échantillons, et dépasse ou est aussi bon que Alpaca dans 70% des cas, parmi lesquels il y a certainement un ensemble d'entraînement Koala La raison en est que l'ensemble de test est plus similaire, ce résultat n'est donc pas particulièrement surprenant. Mais tant que ces astuces ressemblent davantage aux cas d'utilisation en aval de ces modèles, cela signifie que Koala fonctionnera mieux dans les applications de type assistant, ce qui indique que l'utilisation d'exemples publiés sur le Web pour interagir avec des modèles de langage est la meilleure solution. moyen de responsabiliser ces modèles. Modéliser des stratégies efficaces pour des capacités d’exécution d’instructions efficaces. Ce qui est plus surprenant, c'est que les chercheurs ont découvert qu'en plus des données distillées (Koala-All), la formation sur les données open source était légèrement moins performante que la formation sur les données distillées uniquement ChatGPT (Koala-Distill). Bien que la différence ne soit peut-être pas significative, ce résultat montre que la qualité des conversations ChatGPT est si élevée que même l'inclusion de deux fois plus de données open source n'entraînerait pas une amélioration significative. L'hypothèse initiale était que Koala-All devrait être plus performant, c'est pourquoi Koala-All a été utilisé comme modèle d'évaluation principal dans toutes les évaluations, et finalement il a été découvert que des instructions efficaces et des modèles auxiliaires peuvent être obtenus à partir de grands langages obtenus à partir de le modèle, à condition que ces invites puissent représenter la diversité des utilisateurs pendant la phase de test. La clé pour créer des modèles de conversation solides réside peut-être davantage dans la gestion de données conversationnelles de haute qualité et diverses en termes de requêtes des utilisateurs, et non dans le simple reformatage des ensembles de données existants en questions et réponses. Comme d'autres modèles de langage, Koala a également des limitations qui, si elles sont mal utilisées, peuvent nuire aux utilisateurs. Les chercheurs ont observé que Koala hallucinait et répondait de manière non factuelle sur un ton très confiant, peut-être à la suite d'un ajustement conversationnel. En d'autres termes, le modèle plus petit a hérité de l'héritage du modèle de langage plus large, le style confiant. Le fait qu'il n'ait pas été hérité au même niveau doit être axé sur l'amélioration à l'avenir. Lorsqu'elles sont utilisées à mauvais escient, les réponses fantômes de Koala peuvent faciliter la propagation de désinformations, de spam et d'autres contenus. Koala est capable d'halluciner des informations inexactes sur un ton confiant et convaincant. Au-delà des hallucinations, Koala est en deçà des autres modèles de langage de chatbot. Ceux-ci incluent : Pour réduire davantage les abus potentiels, les filtres de modération de contenu d'OpenAI ont également été déployés dans la démo pour signaler et supprimer les contenus dangereux. Future Work Sécurité et cohérence

Limitations et sécurité

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI