Maison >Périphériques technologiques >IA >Yann LeCun : Au-delà des normes sociales, ChatGPT est loin d'être de vraies personnes

Yann LeCun : Au-delà des normes sociales, ChatGPT est loin d'être de vraies personnes

- WBOYavant

- 2023-04-15 10:25:021396parcourir

OpenAI a lancé ChatGPT fin 2022, et sa popularité se poursuit encore aujourd'hui. Ce modèle est simplement un trafic ambulant, et il provoquera certainement une frénésie de discussions partout où il passera.

Les grandes entreprises technologiques, les institutions et même les particuliers ont intensifié leurs efforts pour développer des produits de type ChatGPT. Dans le même temps, Microsoft a connecté ChatGPT à Bing et Google a publié Bard pour alimenter le moteur de recherche. Le PDG de NVIDIA, Jensen Huang, a donné à ChatGPT une évaluation élevée. Il a déclaré que ChatGPT était le moment iPhone dans le domaine de l'intelligence artificielle et l'une des plus grandes technologies de l'histoire de l'informatique.

Beaucoup de gens sont convaincus que l’IA conversationnelle est arrivée, mais ces modèles sont-ils vraiment parfaits ? Pas nécessairement, il y aura toujours des moments étranges, comme faire des remarques décomplexées à volonté ou discuter de projets de conquête du monde.

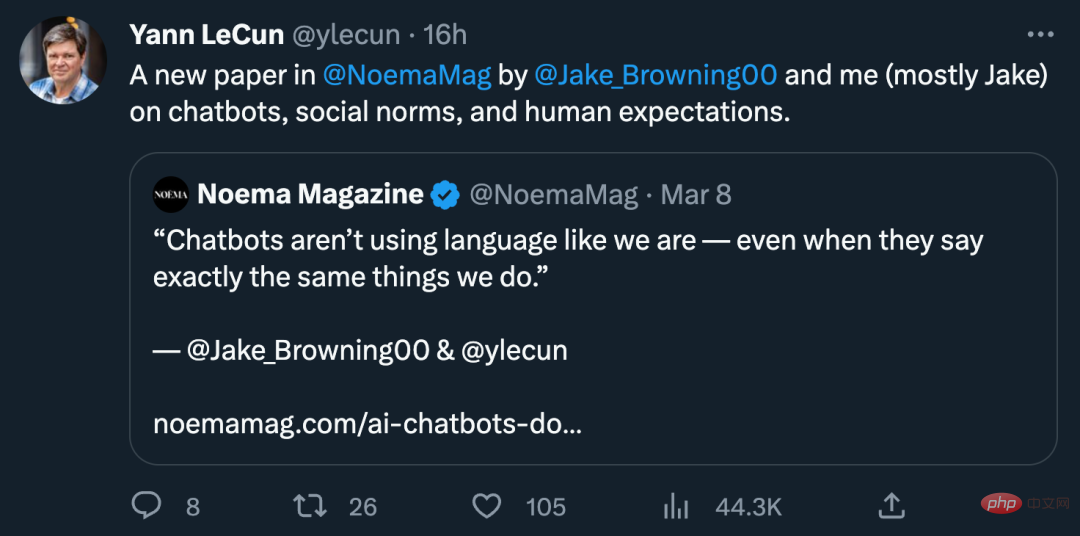

Afin de comprendre ces moments absurdes de l'IA conversationnelle, Yann LeCun, l'un des trois géants du deep learning, et Jacob Browning, chercheur postdoctoral au Département d'informatique de l'Université de New York, ont écrit conjointement un article « AI Chatbots Ne vous souciez pas de vos normes sociales", qui aborde trois aspects de l'IA conversationnelle : les chatbots, les normes sociales et les attentes humaines.

L'article mentionnait que les êtres humains sont très doués pour éviter les lapsus et s'empêcher de commettre des erreurs et des paroles et des actes irrespectueux. En revanche, les chatbots font souvent des erreurs. Ainsi, comprendre pourquoi les humains sont si doués pour éviter les erreurs peut mieux nous aider à comprendre pourquoi on ne peut actuellement pas faire confiance aux chatbots.

Le chatbot ajoute des commentaires humains pour empêcher le modèle de dire la mauvaise chose

Pour GPT-3, les façons de commettre des erreurs incluent des statistiques de modèle inexactes. GPT-3 s'appuie davantage sur les invites des utilisateurs. Sa compréhension du contexte, de la situation, etc. se concentre uniquement sur ce qui peut être obtenu à partir des invites des utilisateurs. Il en va de même pour ChatGPT, mais légèrement modifié d'une manière nouvelle et intéressante. Outre les statistiques, les réponses du modèle ont également été renforcées par des évaluateurs humains. Pour le résultat du système, les évaluateurs humains le renforceront afin qu'il produise de bonnes réponses. Le résultat final est que le système dit non seulement quelque chose de plausible, mais (idéalement) dit aussi quelque chose qu'un humain jugerait approprié - même si le modèle dit quelque chose de faux, au moins cela n'offensera pas les autres.

Mais cette méthode semble trop mécanique. Il existe d’innombrables façons de dire quelque chose de mal dans une conversation humaine : nous pouvons dire quelque chose d’inapproprié, de malhonnête, de déroutant ou tout simplement de stupide. On nous reproche même de dire le mauvais ton ou la mauvaise intonation alors que nous disons les bonnes choses. Dans le processus de relations avec les autres, nous traverserons d'innombrables « champs de mines de conversation ». S'empêcher de dire des choses erronées n'est pas seulement une partie importante d'une conversation, c'est souvent plus important que la conversation elle-même. Parfois, garder la bouche fermée peut être la seule bonne solution.

Cela nous amène à deux questions : comment pouvons-nous contrôler la situation dangereuse du modèle qui ne dit pas la mauvaise chose ? Et pourquoi les chatbots ne peuvent-ils pas efficacement s’empêcher de dire des choses erronées ?

Comment la conversation doit-elle se dérouler ?

Les conversations humaines peuvent porter sur n'importe quel sujet, comme si elles étaient scénarisées : commande de restaurant, bavardage, excuses pour être en retard, etc. Cependant, ce ne sont pas des scripts écrits et sont pleins d’improvisation, ce modèle de conversation humaine est donc un modèle plus général et les règles ne sont pas si strictes.

Ce discours et ce comportement scénarisés des humains ne sont pas limités par des mots. Même si vous ne comprenez pas la langue, le même scénario peut fonctionner, comme faire un geste pour savoir ce que veut l'autre personne. Les normes sociales régissent ces scénarios et nous aident à naviguer dans la vie. Ces codes dictent la manière dont chacun doit se comporter dans certaines situations, attribuent des rôles à chaque personne et donnent des indications générales sur la manière d'agir. Suivre des normes est utile : cela simplifie nos interactions en les standardisant et en les rationalisant, ce qui permet à chacun de prédire plus facilement les intentions de chacun.

Les humains ont développé des routines et des normes qui régissent tous les aspects de notre vie sociale, depuis les fourchettes à utiliser jusqu'au temps d'attente avant de klaxonner. Ceci est crucial pour la survie dans un monde de milliards d’habitants, où la plupart des personnes que nous rencontrons sont de parfaits inconnus dont les croyances ne correspondent peut-être pas aux nôtres. La mise en place de ces normes communes rendra non seulement les conversations possibles, mais également fructueuses, en définissant ce dont nous devrions parler – et tout ce dont nous ne devrions pas parler.

Le revers des normes

Les humains ont tendance à sanctionner ceux qui violent les normes, parfois ouvertement et parfois secrètement. Les normes sociales permettent d'évaluer très facilement un étranger, par exemple lors d'un premier rendez-vous. Grâce à des conversations et des questions, les deux parties évalueront mutuellement leur comportement et si l'autre personne viole l'une des normes - par exemple, si elle se comporte de manière inappropriée. Impoli ou inapproprié – nous les jugeons souvent et rejetons le deuxième rendez-vous.

Pour les humains, ces jugements ne sont pas seulement basés sur une analyse calme, mais également sur notre réponse émotionnelle au monde. Une partie de notre éducation en tant qu'enfant est un entraînement émotionnel pour garantir que nous donnons la bonne émotion au bon moment dans une conversation : colère lorsque quelqu'un viole les normes de l'étiquette, dégoût lorsque quelqu'un dit quelque chose d'offensant, dégoût lorsque nous mentons et avons honte. Notre conscience morale nous permet de réagir rapidement à tout ce qui est inapproprié dans une conversation et d’anticiper la réaction des autres à nos paroles.

Mais plus que cela, une personne qui enfreint des normes simples verra tout son caractère remis en question. S’il mentait sur une chose, mentirait-il sur d’autres choses ? La divulgation vise donc à faire honte à l’autre personne et, ce faisant, à la forcer à s’excuser (ou au moins à défendre) son comportement. Les normes ont également été renforcées.

En bref, les humains doivent respecter strictement les normes sociales, sinon le risque est élevé de dire quelque chose. Nous sommes responsables de tout ce que nous disons, alors choisissez soigneusement ce que nous disons et attendez-vous à ce que ceux qui nous entourent fassent de même.

Chatbots non connectés

Les enjeux élevés des conversations humaines révèlent ce qui rend les chatbots si dérangeants. En prédisant simplement le déroulement d’une conversation, ils finissent par adhérer vaguement aux normes humaines, mais ils ne sont pas liés par ces normes. Lorsque nous discutons occasionnellement avec des chatbots ou testons leur capacité à résoudre des énigmes linguistiques, ils donnent souvent des réponses plausibles et se comportent comme des humains normaux. Quelqu’un pourrait même confondre un chatbot avec un humain.

Cependant, si nous modifions légèrement l'invite ou utilisons un script différent, le chatbot lancera soudainement des théories du complot, des tirades racistes ou des absurdités. Cela peut être dû au fait qu’ils sont formés sur du contenu écrit par des théoriciens du complot, des trolls, etc. sur Reddit et d’autres plateformes.

N'importe lequel d'entre nous peut dire quelque chose comme un troll, mais nous ne devrions pas le faire car les mots des trolls sont pleins d'absurdités, de remarques offensantes, de cruauté et de malhonnêteté. La plupart d’entre nous ne disent pas ces choses parce que nous n’y croyons pas. Les normes de décence ont relégué les comportements offensants aux marges de la société, de sorte que la plupart d’entre nous n’oseraient pas le dire.

En revanche, les chatbots ne réalisent pas qu’il y a des choses qu’ils ne devraient pas dire, aussi probables soient-elles statistiquement. Ils ignorent les normes sociales qui définissent les frontières entre ce qui est dit et ce qui n’est pas dit, et ignorent les profondes pressions sociales qui influencent notre utilisation du langage. Même lorsque les chatbots admettent avoir commis une erreur et s’excusent, ils ne comprennent pas pourquoi. Si nous leur signalons qu'ils ont tort, le chatbot s'excusera même pour obtenir la bonne réponse.

Cela met en lumière un problème plus profond : nous attendons des locuteurs humains qu'ils soient fidèles à ce qu'ils disent et qu'ils en soient tenus responsables. Nous n’avons pas besoin d’examiner leur cerveau ou de comprendre quoi que ce soit en psychologie pour ce faire, nous avons juste besoin de savoir qu’ils sont toujours fiables, qu’ils suivent les règles et se comportent avec respect afin de leur faire confiance. Le problème des chatbots n’est pas qu’ils sont des « boîtes noires » ou peu familiers avec la technologie, mais qu’ils sont peu fiables et rebutants depuis longtemps, et qu’aucun effort n’a été fait pour les améliorer ou même se rendre compte qu’il y avait un problème. .

Les développeurs sont certainement conscients de ces problèmes. Eux, ainsi que les entreprises qui souhaitent que leur technologie d'IA soit largement utilisée, s'inquiètent de la réputation de leurs chatbots et passent beaucoup de temps à restructurer le système pour éviter les conversations difficiles ou éliminer les réponses inappropriées. Bien que cela contribue à rendre les chatbots plus sécurisés, les développeurs doivent travailler dur pour rester face aux personnes qui tentent de les pirater. En conséquence, l'approche des développeurs est réactive et toujours en retard : il y a trop de façons de se tromper pour prédire.

Intelligent mais impersonnel

Cela ne devrait pas nous rendre complaisant quant à l'intelligence des humains et à la stupidité des chatbots. Leur capacité à parler de n’importe quoi révèle plutôt une compréhension profonde (ou superficielle) de la vie sociale humaine et du monde en général. Les chatbots sont suffisamment intelligents pour au moins réussir les tests ou fournir des informations utiles. La panique provoquée par les chatbots parmi les enseignants en dit long sur leur impressionnante capacité à apprendre grâce aux livres.

Mais le problème est que les chatbots s’en moquent. Ils n’ont pas d’objectifs intrinsèques qu’ils souhaitent atteindre par le dialogue et ne sont pas motivés par les pensées ou les réactions des autres. Ils ne se sentent pas mal de mentir et leur honnêteté n’est pas récompensée. Ils sont sans vergogne, à un point tel que même Trump se soucie suffisamment de sa réputation pour au moins prétendre être honnête.

Ainsi, les conversations avec les chatbots n’ont aucun sens. Pour les humains, la conversation est un moyen d’obtenir ce que nous voulons, comme établir une connexion, obtenir de l’aide sur un projet, passer le temps ou apprendre quelque chose. La conversation nécessite que nous nous intéressions et, idéalement, que nous nous souciions de la personne à qui nous parlons.

Même si nous ne nous soucions pas de la personne à qui nous parlons, au moins nous nous soucions de ce que l’autre pense de nous. Nous comprenons profondément que le succès dans la vie (comme avoir des relations étroites, faire du bon travail, etc.) dépend d'une bonne réputation. Si notre statut social baisse, nous risquons de tout perdre. Les conversations façonnent la façon dont les autres nous voient, et beaucoup d’entre nous utilisent des monologues internes pour façonner notre perception de nous-mêmes.

Mais les chatbots n’ont pas leur propre histoire à raconter ni leur propre réputation à défendre, et ils ne ressentent pas la même envie d’agir de manière responsable que nous. Les chatbots peuvent et sont utiles dans de nombreuses situations hautement scénarisées, qu'il s'agisse de jouer à Dungeon Master, de rédiger des textes sensés ou d'aider les auteurs à explorer des idées, pour n'en nommer que quelques-unes. Mais ils n’ont pas les connaissances nécessaires sur eux-mêmes ou sur les autres pour devenir des agents sociaux dignes de confiance, le genre de personnes à qui nous souhaitons parler la plupart du temps.

Si vous ne comprenez pas les normes d’honnêteté et de décence et que vous ne vous souciez pas de votre réputation, les chatbots sont d’une utilité limitée et compter sur eux comporte de réels dangers.

Conversations étranges

Par conséquent, les chatbots ne conversent pas comme le font les humains, et ils ne pourront jamais atteindre leurs objectifs en conversant simplement d'une manière qui semble statistiquement crédible. Sans une réelle compréhension du monde social, ces systèmes d’IA ne sont que des bavards ennuyeux, aussi spirituels ou éloquents soient-ils.

Cela permet de comprendre pourquoi ces systèmes d’IA ne sont que des outils très intéressants et pourquoi les humains ne devraient pas les anthropomorphiser. Les humains ne sont pas seulement des penseurs ou des orateurs impartiaux, mais sont essentiellement des créatures respectueuses des normes, émotionnellement connectées les unes aux autres par le biais d’attentes partagées et imposées. La pensée et la parole humaines proviennent de leur propre nature sociale.

Le dialogue pur est séparé de la participation mondiale étendue et n'a rien de commun avec les êtres humains. Les chatbots n’utilisent pas un langage comme nous, même s’ils parlent parfois exactement comme nous. Mais en dernière analyse, il est évident qu’ils ne comprennent pas pourquoi nous parlons ainsi.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- La vraie création 3D est là, vous devez utiliser vos mains pour faire des gestes ! L'IA ne peut pas prendre mon travail cette fois, n'est-ce pas ?

- L'IA aide Microsoft à rivaliser avec Google dans le domaine des recherches : le trafic Bing a augmenté de 15,8 %

- ChatGPT contre GPT-3 contre GPT-4 n'est qu'un combat interne entre les familles de chatbots

- Comment l'intelligence artificielle et l'apprentissage automatique changent le secteur de la construction