Maison >Périphériques technologiques >IA >Pourquoi l'autosurveillance est-elle efficace ? La thèse de doctorat de Princeton de 243 pages « Comprendre l'apprentissage par représentation auto-supervisé » explique de manière exhaustive les trois types de méthodes : l'apprentissage contrastif, la modélisation du langage et l'auto-prédiction.

Pourquoi l'autosurveillance est-elle efficace ? La thèse de doctorat de Princeton de 243 pages « Comprendre l'apprentissage par représentation auto-supervisé » explique de manière exhaustive les trois types de méthodes : l'apprentissage contrastif, la modélisation du langage et l'auto-prédiction.

- PHPzavant

- 2023-04-15 08:13:021056parcourir

La pré-formation est apparue comme un paradigme alternatif et efficace pour surmonter ces lacunes, dans lequel les modèles sont d'abord formés à l'aide de données facilement disponibles, puis utilisés pour résoudre des tâches d'intérêt en aval, avec beaucoup moins de données étiquetées que l'apprentissage supervisé.

L'utilisation de données non étiquetées pour la pré-formation, c'est-à-dire l'apprentissage auto-supervisé, est particulièrement révolutionnaire et a fait ses preuves dans différents domaines : texte, vision, parole, etc.

Cela soulève une question intéressante et stimulante : Pourquoi la pré-formation sur des données non étiquetées devrait-elle aider à des tâches en aval apparemment sans rapport ? Adresse papier : https://dataspace.princeton ? .edu/handle/88435/dsp01t435gh21h

Cet article présente quelques travaux, propose et établit un cadre théorique pour étudier pourquoi l'apprentissage auto-supervisé est bénéfique pour les tâches en aval.

Cet article présente quelques travaux, propose et établit un cadre théorique pour étudier pourquoi l'apprentissage auto-supervisé est bénéfique pour les tâches en aval.

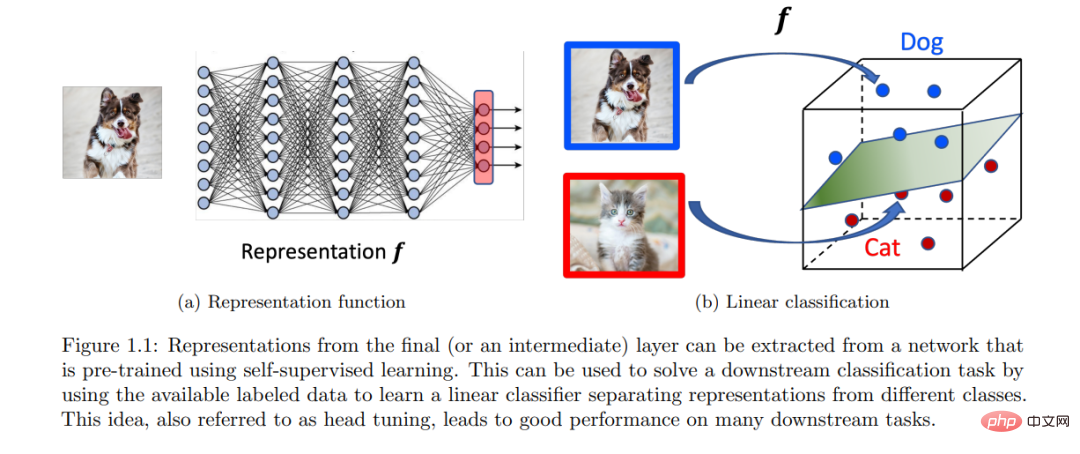

Ce cadre convient à l'apprentissage contrastif, à la modélisation autorégressive du langage et aux méthodes basées sur l'auto-prédiction. L'idée centrale de ce cadre est que la pré-formation aide à apprendre une représentation de faible dimension des données, qui aide ensuite à résoudre les tâches d'intérêt en aval avec des classificateurs linéaires, nécessitant moins de données étiquetées.

Un sujet courant est la formalisation des propriétés idéales des distributions de données non étiquetées pour la création de tâches d'apprentissage auto-supervisées. Avec une formalisation appropriée, il peut être montré qu'en minimisant approximativement l'objectif de pré-entraînement correct, on peut extraire des signaux en aval implicitement codés dans des distributions de données non étiquetées.

Enfin, nous montrons que ce signal peut être décodé à partir de la représentation apprise à l'aide d'un classificateur linéaire, fournissant ainsi une formalisation pour le transfert de « compétences et connaissances » entre les tâches.

INTRODUCTION

Les domaines de l'apprentissage automatique et de l'intelligence artificielle ont fait d'énormes progrès au cours de la dernière décennie dans la quête de conception d'agents et de solutions aux problèmes basées sur les données. Avec le succès initial sur des benchmarks d'apprentissage supervisé exigeants tels qu'ImageNet [Deng et al., 2009], les innovations en matière d'apprentissage profond ont ensuite conduit à des modèles dotés de performances surhumaines sur de nombreux benchmarks de ce type dans différents domaines. La formation de tels modèles spécifiques à des tâches est certainement impressionnante et présente une énorme valeur pratique. Cependant, il présente une limite importante dans la mesure où il nécessite de grands ensembles de données étiquetés ou annotés, ce qui est souvent coûteux. De plus, du point de vue de l'intelligence, on espère avoir des modèles plus généraux qui, comme les humains [Ahn et Brewer, 1993], peuvent apprendre des expériences antérieures, les résumer en compétences ou concepts et utiliser ces compétences ou concepts pour résoudre de nouvelles tâches avec peu ou pas de démonstration. Après tout, les bébés apprennent beaucoup grâce à l’observation et à l’interaction sans supervision explicite. Ces limitations ont inspiré un paradigme alternatif pour la pré-formation.

Bien que l’apprentissage auto-supervisé ait connu un succès empirique et continue de se montrer très prometteur, au-delà d’une intuition approximative, une bonne compréhension théorique de son fonctionnement fait encore défaut. Ces succès impressionnants soulèvent des questions intéressantes car on ne sait pas a priori pourquoi un modèle formé sur une tâche devrait aider sur une autre tâche apparemment sans rapport, c'est-à-dire pourquoi une formation sur la tâche a devrait aider la tâche b. Même si une compréhension théorique complète du SSL (et de l’apprentissage profond en général) est difficile et insaisissable, comprendre ce phénomène à n’importe quel niveau d’abstraction peut aider à développer des algorithmes plus fondés sur des principes. La motivation de recherche de cet article est la suivante :

Pourquoi la formation sur des tâches d'apprentissage auto-supervisées (utilisant de grandes quantités de données non étiquetées) aide à résoudre des tâches en aval manquant de données. Comment formaliser le transfert de « connaissances et compétences » ?

Bien qu'il existe une abondante littérature sur l'apprentissage supervisé, la généralisation à partir d'une tâche SSL → tâche en aval est fondamentalement différente de la généralisation à partir d'un ensemble de formation → un ensemble de tests dans l'apprentissage supervisé. Pour l'apprentissage supervisé pour les tâches de classification en aval, par exemple, un modèle formé sur un ensemble d'entraînement de paires entrée-étiquette échantillonnées à partir d'une distribution inconnue peut être directement utilisé pour une évaluation sur un ensemble de tests invisible échantillonné à partir de la même distribution. Cette distribution de base établit la connexion entre l'ensemble d'entraînement et l'ensemble de test. Cependant, la connexion conceptuelle entre la tâche SSL et la tâche en aval est moins claire car les données non étiquetées utilisées dans la tâche SSL n'ont aucun signal clair sur les étiquettes en aval. Cela signifie qu'un modèle pré-entraîné sur une tâche SSL (par exemple, prédire une partie de l'entrée à partir du reste) ne peut pas être directement utilisé sur des tâches en aval (par exemple, prédire une étiquette de classe à partir de l'entrée). Ainsi, le transfert de « connaissances et compétences » nécessite une étape de formation supplémentaire utilisant certaines données labellisées, idéalement inférieure à ce qui est requis pour un apprentissage supervisé à partir de zéro. Toute compréhension théorique de la tâche SSL → généralisation des tâches en aval doit répondre à ces questions : « Quel est le rôle intrinsèque des données non étiquetées ? et « Comment utiliser des modèles pré-entraînés pour les tâches en aval ? » Cet article cible les tâches de classification en aval, en Faites des hypothèses de distribution sur des données non étiquetées et utilisez l'idée d'apprentissage de la représentation pour étudier ces problèmes :

(a) (hypothèse de distribution) La distribution de données non étiquetées contient implicitement des informations sur la tâche de classification en aval qui vous intéresse.

(b) (Apprentissage par représentation) Un modèle pré-entraîné sur une tâche SSL appropriée peut coder ce signal via des représentations apprises, qui peuvent ensuite être utilisées pour résoudre des tâches de classification en aval avec des classificateurs linéaires.

Le point (a) montre que certaines propriétés structurelles qui ne sont pas étiquetées nous fournissent implicitement des indications sur les tâches ultérieures en aval, et l'apprentissage auto-supervisé peut aider à extraire ce signal des données. Le point (b) propose un moyen simple et empiriquement efficace d’utiliser des modèles pré-entraînés, en tirant parti des représentations apprises du modèle. Cet article identifie et quantifie mathématiquement les propriétés distributionnelles des données non étiquetées, démontrant que de bonnes représentations peuvent être apprises pour différentes méthodes SSL telles que l'apprentissage contrastif, la modélisation du langage et l'auto-prédiction. Dans la section suivante, nous approfondissons l'idée de l'apprentissage par représentation et expliquons formellement pourquoi l'apprentissage auto-supervisé aide les tâches en aval.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI