Maison >Périphériques technologiques >IA >Google et le MIT proposent un cadre unifié MAGE : l'apprentissage des représentations dépasse le MAE et la génération d'images non supervisée surpasse la diffusion latente

Google et le MIT proposent un cadre unifié MAGE : l'apprentissage des représentations dépasse le MAE et la génération d'images non supervisée surpasse la diffusion latente

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-14 20:28:011290parcourir

La reconnaissance et la génération sont les deux tâches essentielles dans le domaine de l'intelligence artificielle. Si elles peuvent être fusionnées en un système unifié, ces deux tâches devraient être complémentaires. En fait, dans le traitement du langage naturel, des modèles comme BERT [1] sont non seulement capables de générer un texte de haute qualité, mais également d'en extraire des fonctionnalités.

Cependant, dans le domaine de la vision par ordinateur, la plupart des modèles de génération d'images et de reconnaissance actuels sont formés séparément, sans utiliser pleinement la synergie de ces deux tâches. Cela est principalement dû au fait que les modèles de génération d'images et de reconnaissance d'images présentent généralement des différences structurelles essentielles : l'entrée de la génération d'images est constituée de caractéristiques ou de bruit de faible dimension, et la sortie est une image originale de haute dimension, en revanche ; l'entrée de la reconnaissance d'image est une image originale de haute dimension, tandis que la sortie est constituée de caractéristiques de basse dimension.

Récemment, des chercheurs du MIT et de Google Research ont proposé une méthode d'apprentissage des représentations basée sur le masquage sémantique des images, qui a permis pour la première fois de générer des images et d'apprendre des représentations dans un cadre unifié, et a bien fonctionné sur plusieurs ensembles de données. A atteint des performances SOTA. Le document de recherche a été accepté par le CVPR 2023, et le code et le modèle pré-entraînés pertinents sont open source.

- Adresse papier : https://arxiv.org/abs/2211.09117

- Adresse code : https://github.com/LTH14/mage

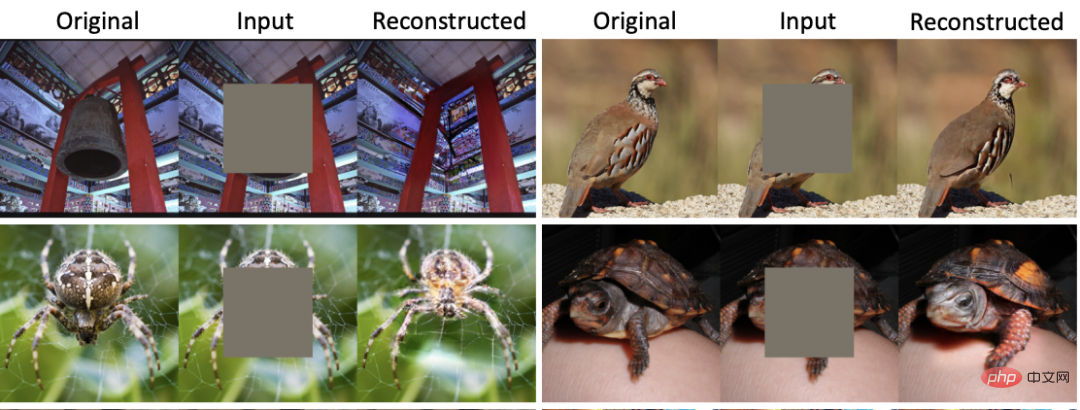

Au CVPR 2022, MAE [2] a proposé une méthode d'apprentissage des représentations basée sur des masques d'image (MIM) et a obtenu de très bons résultats sur plusieurs sous-tâches. Avec un taux de masquage allant jusqu'à 75 %, MAE peut reconstruire une image qui correspond étroitement à la sémantique de l'image originale, permettant ainsi au réseau d'apprendre de manière auto-supervisée les caractéristiques de l'image. Cependant, comme le montre la figure 1, bien que l'image reconstruite par MAE ait des informations sémantiques similaires à celles de l'image originale, de sérieux problèmes de flou et de distorsion surviennent. Des problèmes similaires se posent dans toutes les méthodes d’apprentissage des représentations basées sur MIM. Dans le même temps, les modèles génératifs actuels, qu’il s’agisse de modèles de diffusion ou de GAN, n’ont pas la capacité d’extraire des caractéristiques d’image de haute qualité.

Figure 1 : Comparaison des reconstructions MAE et MAGE

Aperçu des méthodes

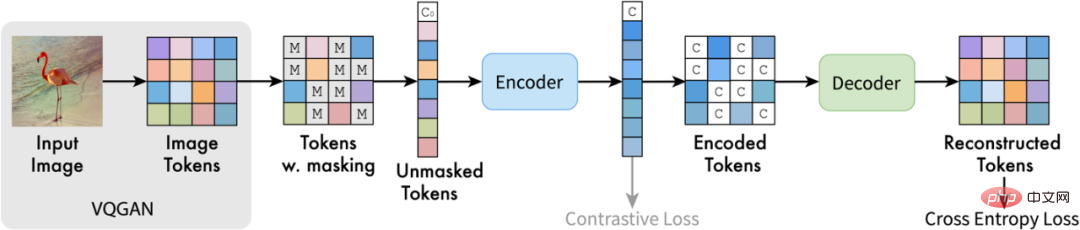

En réponse aux problèmes ci-dessus, l'auteur de cet article a proposé MAGE (Masked Generative Encoder) , qui a permis d'obtenir des modèles unifiés de génération d'images et d'extraction de fonctionnalités. Différent de la méthode de masquage où MIM agit directement sur l'image, MAGE propose une méthode de modélisation de jetons d'image masquée basée sur des symboles sémantiques d'image. Comme le montre la figure, MAGE utilise d'abord l'encodeur VQGAN [3] pour convertir l'image originale en symboles sémantiques discrets. Après cela, MAGE le masque de manière aléatoire et utilise la structure codeur-décodeur basée sur un transformateur pour reconstruire le masque. Les symboles sémantiques reconstruits peuvent être utilisés pour générer l'image originale via le décodeur VQGAN. En utilisant différents taux de masquage lors de la formation, MAGE peut former à la fois des modèles génératifs (taux de masquage de près de 100 %) et l'apprentissage des représentations (taux de masquage de 50 % à 80 %). Comme le montre la figure 1, l'image reconstruite par MAGE possède non seulement des informations sémantiques cohérentes avec l'image originale, mais peut également garantir la diversité et l'authenticité de l'image générée.

Figure 2 : Diagramme de structure MAGE

Résultats expérimentaux

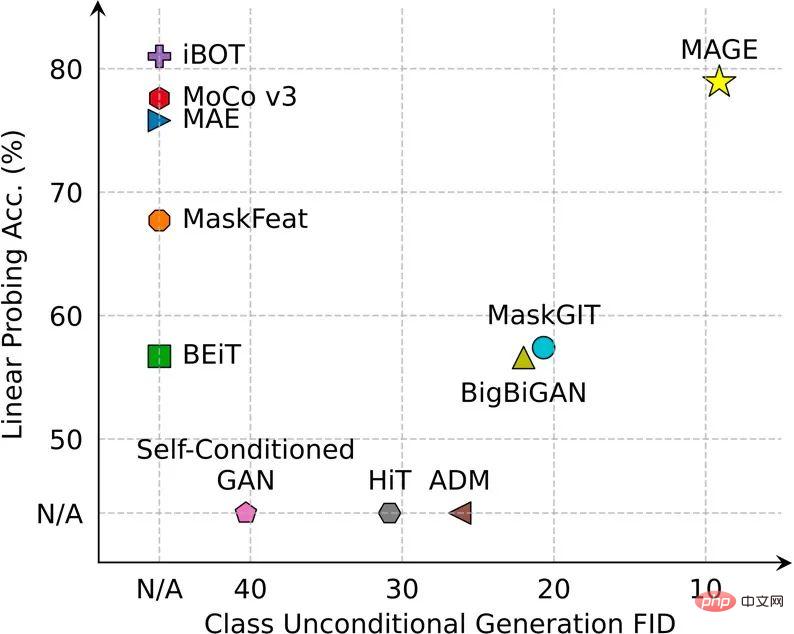

MAGE a atteint ou dépassé SOTA sur plusieurs tâches de génération et de reconnaissance d'images.

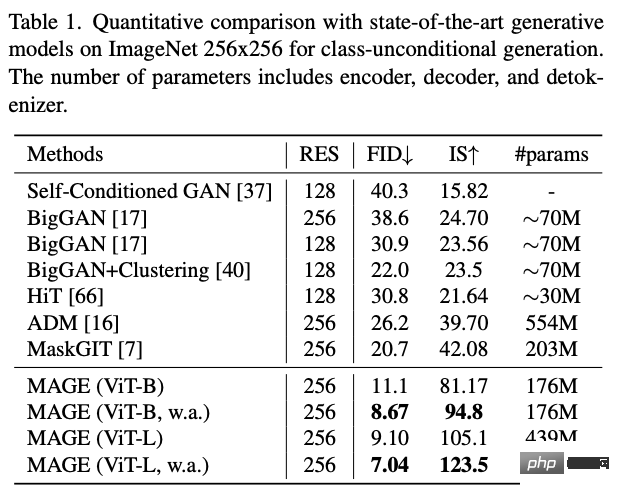

Dans la tâche de génération d'images non supervisée d'ImageNet, le FID de MAGE est passé du précédent > 20 à 7,04, atteignant même le niveau de génération d'images supervisée (le FID de diffusion latente supervisée sur ImageNet est de 3,60) :

Figure 3 : Exemple de génération d'images non supervisée MAGE

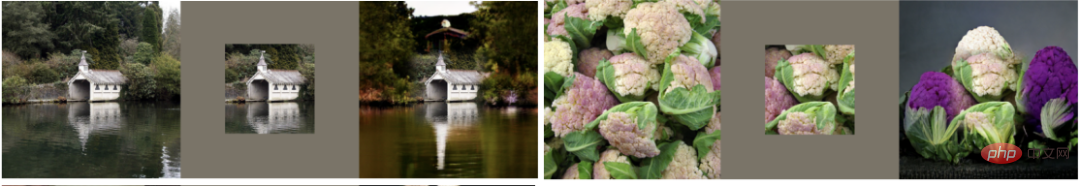

MAGE peut également effectuer diverses tâches d'édition d'images, notamment l'inpainting, l'outpainting et le dérognage :

Figure 4 : Exemple d'édition d'images MAGE

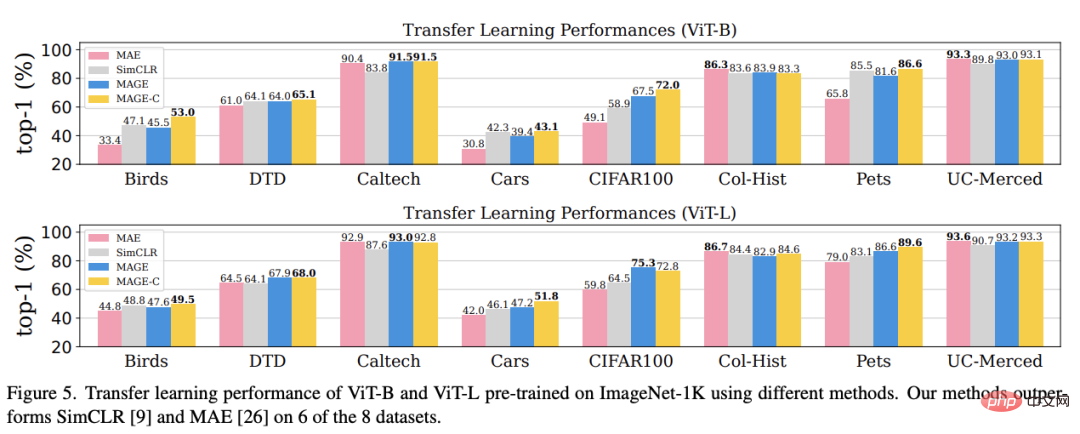

En termes d'apprentissage des représentations, MAGE excelle dans Sondage linéaire ImageNet et tâches In à quelques échantillons Comme l'apprentissage et l'apprentissage par transfert, il a été grandement amélioré par rapport à la méthode MIM actuelle et peut atteindre ou dépasser le niveau de la méthode d'apprentissage auto-supervisée optimale actuelle.

Conclusion

Cet article vise à unifier la génération d'images et l'apprentissage de la représentation. A cette fin, l'auteur de cet article propose MAGE, un cadre d'apprentissage auto-supervisé basé sur le masquage sémantique d'images. Ce cadre est simple et efficace et, pour la première fois, atteint ou dépasse les performances SOTA en matière de génération d'images et d'apprentissage de représentation. Les lecteurs intéressés peuvent consulter le texte original de l’article pour en savoir plus sur la recherche.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI