Maison >Périphériques technologiques >IA >Réflexions sur la sécurité des réseaux IA suscitées par la popularité de ChatGPT

Réflexions sur la sécurité des réseaux IA suscitées par la popularité de ChatGPT

- 王林avant

- 2023-04-14 17:37:03816parcourir

1. Piste de développement de l'intelligence artificielle

Avant que le concept d'intelligence artificielle (Aritificial Intelligene) ne soit proposé pour la première fois par John McCarthy lors du séminaire universitaire d'été du Darmouth College en 1956, les humains avaient déjà remplacé les humains dans le travail lourd et répétitif par des machines. sur la route.

En février 1882, Nikola Tesla a achevé l'idée du générateur à courant alternatif qui le troublait depuis 5 ans et s'est exclamé avec extase : « À partir de maintenant, les humains ne seront plus esclaves d'un travail manuel pénible et ma machine nous libérera. » , le monde entier sera comme ça.

En 1936, afin de prouver l'existence de propositions indécidables en mathématiques, Alan Turing a proposé l'idée d'une "machine de Turing". En 1948, il a décrit l'essentiel du contenu du connexionnisme dans l'article "MACHINES INTELLIGENTES". suivi en 1950 Il publie "COMPUTING MACHINERY AND INTELLIGENCE" et propose le fameux "Turing Test". La même année, Marvin Minsky et son camarade de classe Dunn Edmund construisent le premier ordinateur à réseau neuronal au monde.

En 1955, von Neumann a accepté l'invitation de donner la conférence Silliman à l'Université de Yale. Le contenu de la conférence a ensuite été compilé dans le livre "L'ORDINATEUR ET LE CERVEAU".

L'intelligence artificielle a connu trois sommets de développement depuis sa proposition en 1956 jusqu'à aujourd'hui.

Le premier point culminant du développement : de 1956 à 1980, le symbolisme (Symbolisme) représenté par les systèmes experts et l'apprentissage automatique classique a dominé. Également connu comme la première génération d'intelligence artificielle, le symbolisme propose un modèle de raisonnement basé sur la connaissance et l'expérience pour simuler les comportements intelligents et rationnels humains, tels que le raisonnement, la planification, la prise de décision, etc. Par conséquent, une base de connaissances et un mécanisme de raisonnement sont établis dans la machine pour simuler le raisonnement et le comportement de pensée humains.

La réalisation la plus représentative du symbolisme est le programme d'échecs d'IBM Deep Blue qui a battu le champion du monde Kasparov en mai 1997. Il y a trois facteurs de succès : le premier facteur est la connaissance et l'expérience. Deep Blue a analysé 700 000 parties jouées par des maîtres humains. Les parties d'échecs et toutes les 5 à 6 finales sont résumées dans les règles des échecs.

Puis à travers le jeu entre le maître et la machine, déboguez les paramètres dans la fonction d'évaluation et absorbez pleinement l'expérience du maître. Le deuxième élément est l'algorithme Deep Blue utilise l'algorithme d'élagage alpha-bêta, qui est très rapide. Le troisième facteur est la puissance de calcul. IBM utilisait à l'époque la machine RS/6000SP2, qui pouvait analyser 200 millions de pas par seconde et prédire 8 à 12 pas en avant par seconde en moyenne.

L'avantage du symbolisme est qu'il peut imiter le processus de raisonnement et de pensée humain, qu'il est cohérent avec le processus de pensée humain et qu'il peut tirer des conclusions à partir d'un exemple, il est donc interprétable. Mais le symbolisme présente également de très graves inconvénients. Premièrement, les connaissances spécialisées sont très rares et coûteuses. Deuxièmement, les connaissances spécialisées doivent être introduites dans la machine par le biais d'une programmation manuelle, ce qui prend beaucoup de temps et de main d'œuvre. des connaissances difficiles à exprimer, comme les experts en médecine traditionnelle chinoise prenant des légumineuses. De telles expériences sont difficiles à exprimer, le champ d'application du symbolisme est donc très limité.

Le deuxième point culminant du développement : 1980~1993, représenté par le symbolisme et le connexionnisme ;

Le troisième point culminant du développement : 1993~1996, l'apprentissage profond a connu un grand succès avec l'aide de la puissance de calcul et des données, le connexionnisme est devenu populaire ; l'apprentissage simule la perception humaine, telle que la vision, l'audition, le toucher, etc., grâce à des modèles de réseaux neuronaux profonds. L'apprentissage profond présente deux avantages : le premier est qu'il ne nécessite pas de connaissances spécialisées dans le domaine et le seuil technique est faible ; le deuxième avantage est que plus l'échelle du réseau mis à niveau est grande, plus les données pouvant être traitées sont volumineuses ;

L'un des exemples les plus typiques d'apprentissage profond est le programme Go. Avant octobre 2015, les programmes de Go réalisés en utilisant le symbolisme, c'est-à-dire des méthodes basées sur la connaissance, pouvaient atteindre le plus haut niveau amateur 5 dan. En octobre 2015, le programme Go a vaincu le champion d'Europe et en mars 2016, il a vaincu le champion du monde. En octobre 2017, AlphaGo a vaincu AlphaGo. AlphaGo a utilisé l'apprentissage profond pour réaliser un triple saut dans le niveau du programme Go, du niveau amateur au niveau professionnel, du niveau professionnel au champion du monde et du champion du monde au champion du monde. champion.

AlphaGo a réalisé un triple bond en deux ans. Son succès vient principalement de trois aspects : le big data, l'algorithme et la puissance de calcul. AlphaGo a appris 30 millions de parties d'échecs existantes et a joué 30 millions de parties supplémentaires avec lui-même, pour un total de 60 millions de parties d'échecs. Il a utilisé la recherche arborescente de Monte Carlo, l'apprentissage par renforcement, l'apprentissage en profondeur et d'autres algorithmes, en utilisant un total de 1 202 processeurs et 280. GPU à calculer.

L'apprentissage profond présente également de grandes limites, comme être ininterprétable, dangereux, difficile à généraliser et nécessiter un grand nombre d'échantillons. Par exemple, une image d'un visage humain peut être reconnue comme celle d'un chien après quelques modifications. La raison pour laquelle cela se produit dépasse la compréhension humaine.

En 2016, le behaviorisme (actionnisme) représenté par l'apprentissage par renforcement a attiré une grande attention après l'émergence d'AlphaZero, et il a été salué comme le seul moyen d'accéder à l'intelligence artificielle générale.

Le symbolisme, représenté par le raisonnement logique, conduit l'intelligence avec la connaissance, et le connexionnisme, représenté par l'apprentissage profond, conduit l'intelligence avec les données. Les deux ont des défauts majeurs et une portée d'application limitée.

Le behaviorisme représenté par l'apprentissage par renforcement utilise de manière exhaustive les quatre éléments de connaissances, de données, d'algorithmes et de puissance de calcul pour introduire des mécanismes tels que le feedback, les connexions latérales, la décharge clairsemée, le mécanisme d'attention, la multimodalité et la mémoire du cerveau humain, et est devrait combler les lacunes des deux premières générations d’intelligence artificielle et bénéficier d’une application plus large.

2. Plusieurs mécanismes du travail du cerveau humain

[Mécanisme de prédiction et de rétroaction]

Le cerveau observe le monde et construit des modèles de mémoire à travers une période de la vie quotidienne, le cerveau compare automatiquement les modèles de mémoire précédents inconsciemment et prédit quoi ; cela arrivera ensuite. Lorsqu’il détecte une situation incompatible avec la prédiction, il provoque un retour d’information du cerveau.

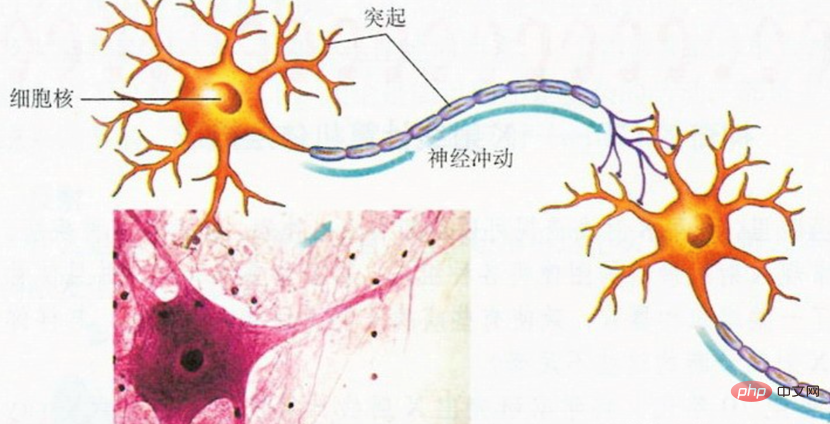

Les cellules du cerveau sont capables de transmettre des informations car elles possèdent des tentacules-dendrites et des axones magiques. Grâce à leurs dendrites courtes, les cellules cérébrales peuvent recevoir des informations d'autres cellules cérébrales, et grâce à leurs axones longs, les cellules cérébrales peuvent transmettre des informations à d'autres cellules cérébrales (comme le montre la figure ci-dessous).

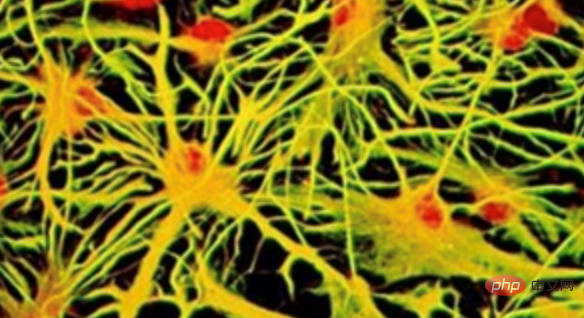

Les informations sont transmises en permanence entre les cellules du cerveau, formant ainsi les sentiments et les pensées humaines. Le cerveau entier est un vaste réseau de cellules cérébrales interconnectées, comme le montre la figure ci-dessous :

Dans le domaine de l'apprentissage automatique, afin d'obtenir un tel réseau neuronal artificiel, tout d'abord, un réseau neuronal doit être défini La structure du réseau, combien de neurones il y a dans le réseau et comment les neurones sont connectés. Ensuite, vous devez définir une fonction d'erreur. La fonction d'erreur est utilisée pour évaluer les performances actuelles du réseau et la manière dont les connexions neuronales doivent être ajustées pour réduire les erreurs. La force synaptique détermine l'activité neuronale, l'activité neuronale détermine la sortie du réseau et la sortie du réseau détermine l'erreur du réseau.

Actuellement, la « rétro-propagation » est l'algorithme de formation de réseaux neuronaux profonds le plus couramment utilisé et le plus efficace dans le domaine de l'apprentissage automatique. Les réseaux formés par rétropropagation occupent une position dominante dans la récente vague d’apprentissage automatique, obtenant de bons résultats en matière de reconnaissance vocale et d’image, de traduction linguistique, etc.

Il favorise également les progrès de l'apprentissage non supervisé, indispensable dans la génération d'images et de parole, la modélisation du langage et certaines tâches de prédiction d'ordre élevé. En coopération avec l'apprentissage par renforcement, la rétropropagation peut résoudre de nombreux problèmes de contrôle (problèmes de contrôle), tels que la maîtrise des jeux Atari et la défaite des meilleurs joueurs humains au Go et au poker.

L'algorithme de rétropropagation envoie des signaux d'erreur dans les connexions de rétroaction pour aider le réseau neuronal à ajuster la force synaptique. Il est très couramment utilisé dans le domaine de l'apprentissage supervisé. Mais les connexions de rétroaction dans le cerveau semblent avoir des fonctions différentes, et une grande partie de l’apprentissage cérébral n’est pas supervisé. Par conséquent, l’algorithme de rétropropagation peut-il expliquer le mécanisme de rétroaction du cerveau ? Il n’y a actuellement aucune réponse définitive.

【Connexions intra-cérébrales】

La méthode de connexion spéciale entre les neurones du cerveau humain est une direction importante dans l'étude du caractère unique du cerveau humain. L'imagerie par résonance magnétique est un outil clé dans cette recherche. Cette technique permet de visualiser les longues fibres qui s'étendent des neurones et relient différentes zones du cerveau sans ouvrir le crâne. Ces connexions agissent comme des fils qui transportent des signaux électriques entre les neurones. Ensemble, ces connexions sont appelées connectome et fournissent des indices sur la manière dont le cerveau traite les informations.

En supposant que chaque cellule nerveuse est connectée à toutes les autres cellules nerveuses, ce groupe de connexion un-à-plusieurs est le plus efficace. Mais ce modèle nécessite beaucoup d’espace et d’énergie pour accueillir toutes les connexions et maintenir leur fonctionnement normal, ce n’est donc certainement pas réalisable. Un autre mode est une connexion un-à-un, dans laquelle chaque neurone est connecté à un seul autre neurone. Ce type de connexion est moins difficile, mais il est aussi moins efficace : l'information doit traverser un grand nombre de cellules nerveuses comme des tremplins pour passer d'un point A à un point B.

« La vraie vie se situe quelque part entre les deux », déclare Yaniv Assaf de l'Université de Tel Aviv, qui a publié une étude des connectomes de 123 espèces de mammifères dans Nature Neuroscience. L’équipe a découvert que le nombre de tremplins nécessaires pour obtenir des informations d’un endroit à un autre est à peu près égal dans le cerveau des différentes espèces et que les connexions utilisées sont similaires. Cependant, il existe des différences dans la manière dont la disposition des connexions dans le cerveau est réalisée entre les différentes espèces. Chez les espèces ayant quelques connexions à longue distance entre les deux hémisphères, il y a généralement des connexions plus courtes dans chaque hémisphère et les régions cérébrales adjacentes au sein de l'hémisphère communiquent fréquemment.

【Mémoire】

Il existe des milliards de cellules nerveuses dans le cerveau humain. Elles interagissent entre elles via des synapses, formant des interconnexions extrêmement complexes. La mémoire est constituée d'appels mutuels entre les cellules nerveuses du cerveau. Certains appels mutuels sont de courte durée, d'autres de longue durée et d'autres se situent quelque part entre les deux.

Il existe quatre formes fondamentales d'interaction entre les neurones du cerveau :

- Excitation simple : Lorsqu'un neurone est excité, il excite un autre neurone connecté.

- Inhibition simple : L'excitation d'un neurone augmente le seuil sensoriel d'un autre neurone connecté.

- Rétroaction positive : L'excitation d'un neurone stimule l'excitation d'un autre neurone connecté, qui à son tour abaisse directement ou indirectement le seuil d'excitation du premier, ou renvoie un signal à la synapse sensorielle du premier.

- Rétroaction négative : L'excitation d'un neurone stimule l'excitation d'un autre neurone connecté, ce qui à son tour augmente directement ou indirectement le seuil d'excitation du premier, entraînant une diminution de l'excitabilité du premier.

Il existe de nombreux types de cellules neuronales ayant des activités différentes dans le cerveau humain, qui sont respectivement responsables de la mémoire à court, moyen et long terme.

Les cellules neuronales actives sont responsables de la mémoire à court terme. Leur nombre est petit et détermine la capacité de réponse à court terme d'une personne. Lorsque ce type de cellule est stimulé par un signal nerveux, son seuil de détection diminue temporairement, mais ses synapses ne prolifèrent généralement pas, et la diminution du seuil de détection ne peut durer que quelques secondes à quelques minutes, puis revient à des niveaux normaux.

Les cellules neuronales neutres sont responsables de la mémoire à moyen terme. Leur nombre est au milieu et détermine l'adaptabilité d'apprentissage d'une personne. Lorsque ce type de cellules est stimulé par une quantité appropriée de signaux nerveux, une prolifération synaptique se produit. Cependant, cette prolifération synaptique est lente et nécessite de multiples stimulations pour former des changements significatifs, et l'état de prolifération ne peut durer que quelques jours, voire plusieurs semaines. à la dégradation.

Les cellules neuronales paresseuses sont responsables de la mémoire à long terme. Leur plus grand nombre détermine la capacité d’une personne à accumuler des connaissances. Ce type de cellule ne subira une prolifération synaptique que lorsqu'elle est stimulée par un grand nombre de signaux nerveux répétés. Cette prolifération synaptique est extrêmement lente et nécessite de nombreuses stimulations répétées pour former des changements significatifs, mais l'état de prolifération peut être maintenu pendant des mois, voire des décennies. , pas facile à dégrader.

Lorsqu'une cellule neuronale du cerveau est stimulée et excitée, ses synapses prolifèrent ou le seuil d'induction diminue. Les cellules neuronales cérébrales qui sont fréquemment stimulées et excitées à plusieurs reprises verront leurs synapses moins stimulées que les autres et les cellules neuronales cérébrales excitées auront un signal plus fort. capacités d'envoi et de réception de signaux.

Lorsque deux cellules neuronales synaptiquement adjacentes l'une à l'autre sont stimulées en même temps et deviennent excitées en même temps, les synapses des deux cellules neuronales prolifèrent en même temps, entraînant l'interaction des paires synaptiques adjacentes. entre elles. Lorsque cette stimulation synchronisée est répétée plusieurs fois, l'interaction entre des paires synaptiques adjacentes de deux cellules neuronales atteint une certaine intensité (atteint ou dépasse un certain seuil), et alors le phénomène de propagation d'excitation se produira entre elles. , lorsque l'une des cellules neuronales est excitée par une stimulation, l'autre cellule neuronale sera excitée, formant ainsi une connexion d'écho mutuelle entre les cellules neuronales, qui est une connexion mémoire.

La mémoire fait donc référence à la mémorisation, qui est déterminée par la fluidité de la connexion entre les cellules neuronales, c'est-à-dire que la force de la connexion entre les cellules neuronales est supérieure au seuil d'induction, formant une connexion explicite entre les cellules neuronales, qui est le cerveau. la mémoire, l'essence de.

【Mécanisme d'attention】

Lorsque le cerveau humain lit, il ne s'agit pas d'un processus de décodage strict, mais proche d'un processus de reconnaissance de formes. Le cerveau ignorera automatiquement les informations de faible possibilité et de faible valeur, et corrigera également automatiquement le contenu lu vers « la version que le cerveau pense être correcte » sur la base des informations contextuelles. C'est ce qu'on appelle l'attention du cerveau humain.

Le « mécanisme d'attention » est une méthode de traitement de données qui simule l'attention du cerveau humain dans l'apprentissage automatique. Il est largement utilisé dans divers types de tâches d'apprentissage automatique telles que le traitement du langage naturel, la reconnaissance d'images et la reconnaissance vocale. Par exemple, la traduction automatique utilise souvent le modèle « LSTM+attention ». LSTM (Long Short Term Memory) est une application du RNN (Recurrent Neural Network). On peut simplement comprendre que chaque neurone possède une porte d’entrée, une porte de sortie et une porte d’oubli. La porte d'entrée et la porte de sortie connectent les neurones LSTM bout à bout, tandis que la porte d'oubli affaiblit ou oublie le contenu dénué de sens. Le « mécanisme d'attention » est appliqué à la porte d'oubli du LSTM, ce qui rend la lecture automatique plus proche des habitudes de lecture humaine et rend également les résultats de traduction pertinents du point de vue contextuel.

【Neurones multimodaux】

Il y a quinze ans, Quiroga et d'autres ont découvert que le cerveau humain possède des neurones multimodaux. Ces neurones répondent à des concepts abstraits entourant un thème de haut niveau plutôt qu'à des caractéristiques visuelles spécifiques. Parmi eux, le plus célèbre est le neurone « Halle Berry », qui ne répond qu'aux photos, croquis et textes de l'actrice américaine « Halle Berry ». Cet exemple a été utilisé dans « Scientific American » et « The New York Times ». " [11].

OpenAI a publié CLIP, qui utilise des neurones multimodaux pour obtenir un système de vision général avec des performances comparables à celles de ResNet-50 sur certains ensembles de données difficiles, CLIP surpasse les systèmes de vision existants.

L'apprentissage automatique introduit les neurones multimodaux, qui font référence à la compréhension sémantique multidimensionnelle profonde des données et informations multimodales telles que le texte, le son, les images, les vidéos, etc., y compris l'intégration de la sémantique des données, de la sémantique des connaissances, la sémantique visuelle, la sémantique de la parole, la sémantique du langage naturel et d'autres technologies de compréhension sémantique. Par exemple, la sémantique visuelle peut permettre aux machines de passer de la vision claire à la compréhension des vidéos et d'extraire des connaissances sémantiques structurées.

3. Composants de base d'un système intelligent

Le système de conduite autonome est un système intelligent typique. La norme américaine de classification de conduite autonome SAE divise les systèmes de conduite autonome en cinq niveaux selon le degré d'automatisation :

Niveau |

Nom |

Définition |

L0 |

Pas d'automatisation |

Le conducteur effectue toutes les tâches opérationnelles telles que le freinage de la direction, , accélération ou décélération, etc. |

L1 |

Driver Assist |

Le conducteur peut toujours gérer toutes les accélérations, les freinages et la surveillance de l'environnement avec l'assistance du système de conduite automatisée du véhicule. |

L2 |

Automatisation partielle |

Les systèmes de conduite automatisée des voitures peuvent assister les fonctions de direction ou d'accélération et permettre aux conducteurs d'être soulagés de certaines de leurs tâches. Le conducteur doit être prêt à prendre le contrôle du véhicule à tout moment et rester responsable de la plupart des fonctions critiques pour la sécurité et de toute la surveillance environnementale. |

L3 |

Automatisation conditionnelle |

Le système de conduite automatisée du véhicule contrôle lui-même toute la surveillance de l'environnement. L'attention du conducteur est toujours importante à ce niveau, mais elle peut être désengagée des fonctions « critiques pour la sécurité » telles que le freinage. |

L4 |

Hautement automatisé |

Le système de conduite autonome du véhicule informera d'abord le conducteur lorsque les conditions sont sûres, puis le conducteur fera passer le véhicule dans ce mode. Il ne peut pas juger entre des situations de conduite plus dynamiques, comme les embouteillages ou l'entrée sur l'autoroute. Les systèmes de véhicules autonomes sont capables de diriger, de freiner, d'accélérer, de surveiller le véhicule et la route, de réagir aux événements, de déterminer quand changer de voie, tourner et utiliser les signaux. |

L5 |

Entièrement automatisé |

Le système de conduite autonome contrôle toutes les tâches critiques, surveille l'environnement et reconnaît les conditions de conduite uniques, telles que les embouteillages, sans nécessiter l'attention du conducteur. |

Nous pouvons voir dans la classification des systèmes de conduite autonome des véhicules que le niveau L0 du système intelligent est une prise de décision entièrement humaine, le niveau L1 ~ L2 est celui où les machines effectuent la collecte et l'analyse des données sur la base de quantités complètes de données, et les humains font inférences, jugements et décisions, qui est ce qu'on appelle le modèle basé sur les données, L3~L4 est une machine qui effectue le tri des données, l'analyse, le raisonnement logique, le jugement et la prise de décision sur la base de toutes les données, mais nécessite une intervention humaine au moment approprié. temps. L5 est une machine complètement intelligente qui ne nécessite aucune intervention humaine, ce qu'on appelle le mode de conduite intelligent.

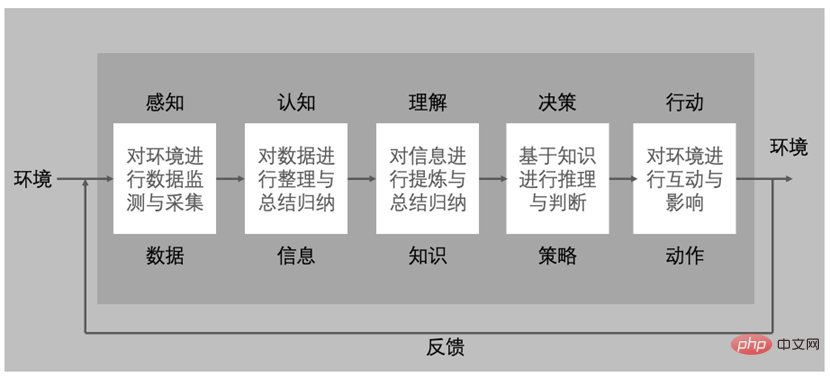

Pour qu'une machine soit intelligente, c'est-à-dire pour qu'une machine devienne un système intelligent, elle doit au moins avoir les composants illustrés dans la figure ci-dessous : perception, cognition, compréhension, prise de décision et action.

Le rôle du composant de détection est de surveiller et de collecter des données de l'environnement, et la sortie est constituée de données. L'essence est de numériser l'espace physique et de mapper complètement l'espace physique à l'espace de données.

Le rôle de la composante cognitive est d'organiser et de résumer les données et d'extraire des informations utiles.

La fonction du composant de compréhension est d'affiner et de résumer davantage les informations extraites pour obtenir des connaissances. Les connaissances comprises par les humains s'expriment en langage naturel, et pour les machines, elles s'expriment dans des « modèles » formés sur des ensembles de données qui représentent l'espace du problème.

Le rôle de la composante décisionnelle est de mener un raisonnement et un jugement basés sur les connaissances. Pour la machine, il s'agit d'utiliser le modèle entraîné pour effectuer un raisonnement et un jugement dans le nouvel espace de données et générer des stratégies pour les tâches cibles.

Le rôle du volet action est d'interagir avec l'environnement en fonction de stratégies et d'avoir un impact sur l'environnement.

La fonction du composant de rétroaction est de former un retour après que l'action agisse sur l'environnement, et le retour encourage le système de perception à percevoir plus de données, acquérant ainsi continuellement plus de connaissances, prenant de meilleures décisions sur les tâches cibles et formant un groupe fermé. boucle d'évolution itérative continue.

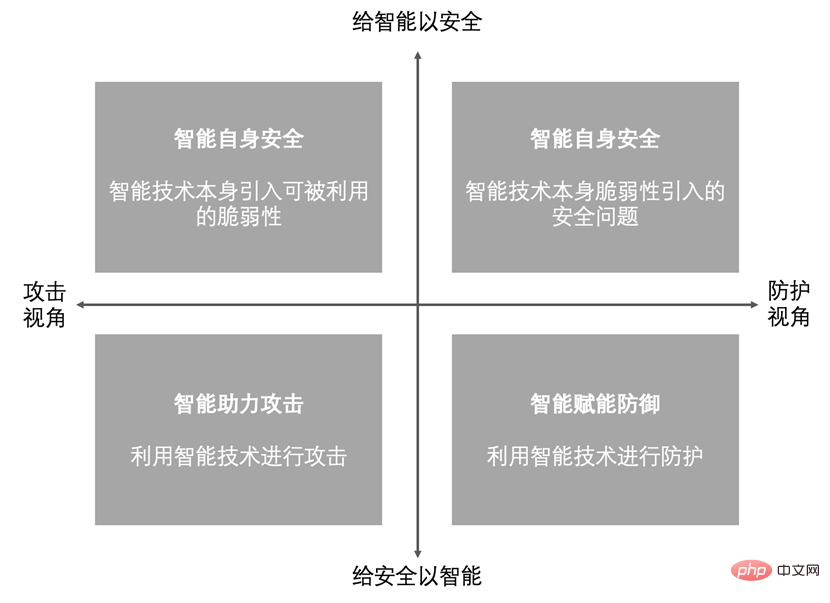

4. Sécurité intelligente

La combinaison de l'intelligence artificielle et de la sécurité des réseaux a toujours deux dimensions, quatre quadrants [9] : verticalement, une extrémité est de fournir de l'intelligence à la sécurité, et l'autre extrémité est de fournir de l'intelligence à la sécurité ; , une extrémité est Il y a une perspective d'attaque et une perspective défensive à une extrémité. Comme le montre la figure ci-dessous, les quatre quadrants représentent les quatre effets de la combinaison des deux :

L'autosécurité intelligente comprend les vulnérabilités introduites par la technologie intelligente elle-même qui peuvent être exploitées et les problèmes de sécurité introduits par le vulnérabilité de la technologie intelligente elle-même. Inclut principalement la sécurité de l'entreprise, la sécurité des modèles d'algorithmes, la sécurité des données, la sécurité des plates-formes, etc. en utilisant l'intelligence artificielle.

Les problèmes de sécurité des modèles d'algorithmes incluent principalement les menaces à l'intégrité de la formation des modèles, les menaces à l'intégrité des tests, le manque de robustesse du modèle, les menaces de biais du modèle, etc., telles que les attaques de contournement (manipulation des décisions et des résultats du modèle via des échantillons contradictoires) et les attaques d'empoisonnement (injection de logiciels malveillants). données pour réduire la fiabilité et la précision du modèle), attaques par inférence (déduisant si des données spécifiques ont été utilisées pour la formation du modèle), attaques d'extraction de modèle (exposant les détails de l'algorithme via des commandes de requête malveillantes), attaques d'inversion de modèle (déduisant des données d'entrée via des données de sortie), attaques de reprogrammation (modification des modèles d'IA à des fins illégales), attaques par inférence d'attribution, attaques de chevaux de Troie, attaques par porte dérobée, etc. La sécurité des données comprend principalement les fuites de données basées sur la sortie du modèle et les fuites de données basées sur les mises à jour progressives de la plate-forme ; la sécurité des périphériques matériels et les problèmes de sécurité des systèmes et des logiciels.

Les technologies de défense pour ces problèmes d'insécurité de l'intelligence artificielle comprennent principalement l'amélioration de l'auto-sécurité des modèles d'algorithmes, la sécurité des données de l'IA et la défense contre les fuites de confidentialité, ainsi que la défense de la sécurité du système d'IA. Les technologies d'amélioration de l'auto-sécurité des modèles d'algorithmes incluent la formation de défenses orientées données (telles que la formation contradictoire, le masquage de gradient, le blocage de la transférabilité, la compression des données, la randomisation des données, etc.), les défenses orientées modèle (telles que la régularisation, la distillation défensive, l'encombrement des fonctionnalités, etc.) compression, rétrécissement profond du réseau, défense de masquage, etc.), défense spécifique, amélioration de la robustesse, amélioration de l'interprétabilité, etc. Les technologies de sécurité des données de l'IA et de défense contre les fuites de confidentialité comprennent principalement la défense de la structure du modèle, la défense contre la confusion des informations, la défense contre le contrôle des requêtes, etc.

Donner de la sécurité au renseignement fait référence aux nouvelles vulnérabilités apportées par la technologie du renseignement elle-même, qui peuvent être exploitées par des attaquants et peuvent introduire de nouveaux risques de sécurité pour les défenseurs.

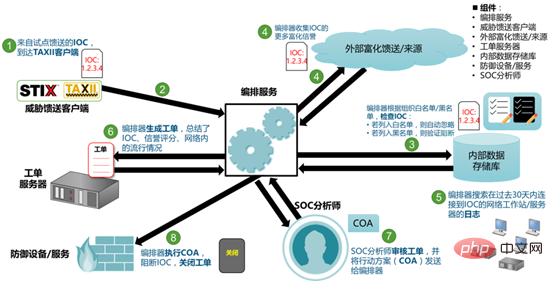

Donnez des renseignements sur la sécurité, ce qui signifie que les attaquants peuvent utiliser une technologie intelligente pour mener des attaques, et que les défenseurs peuvent utiliser une technologie intelligente pour améliorer les capacités de protection de la sécurité. Cela se reflète principalement dans l’automatisation des réponses de sécurité et l’autonomie de prise de décision en matière de sécurité. Il existe actuellement deux méthodes courantes pour améliorer l'automatisation des réponses de sécurité :

- SOAR, Security Orchestration, Automation and Response, orchestration de sécurité, automatisation et réponse

- OODA, Observe-Orient-Decide-Act, observation-ajustement-décision-action ; , IACD (Integrated Adaptive Network Defense Framework) est basé sur OODA comme cadre.

L'image ci-dessous est un diagramme schématique d'un flux de travail de réponse automatique centré sur SOAR :

En 1994, le spécialiste des sciences cognitives Steven Pinker a écrit dans "The Language Instinct" que "pour l'intelligence artificielle, les problèmes difficiles sont faciles à résoudre, et les problèmes simples sont difficiles à résoudre". « Problème simple et complexe » signifie que l'espace du problème est fermé, mais que le problème lui-même est très complexe. Par exemple, jouer à Go est un problème simple et complexe. « Problème simple complexe » signifie que l'espace du problème est infiniment ouvert, mais que le problème lui-même n'est pas très complexe.

Par exemple, les problèmes de sécurité des réseaux sont des problèmes complexes et simples. Parce que la technologie et les méthodes d'attaques de sécurité évoluent constamment, il est impossible d'être exhaustif. Cependant, lorsqu'il s'agit d'une attaque de réseau spécifique, il y a souvent des traces. à suivre.

La technologie intelligente d'aujourd'hui est souvent plus forte que les humains dans le domaine des « problèmes simples et complexes », mais pour les « problèmes simples et complexes », l'intelligence artificielle échoue souvent en raison de l'explosion spatiale provoquée par les limites de généralisation.

Malheureusement, les problèmes de cybersécurité sont des problèmes simples et complexes, et l'application de l'intelligence artificielle dans l'espace des problèmes de cybersécurité est confrontée à des défis. Surtout le paradoxe de Moravec (un phénomène découvert par les spécialistes de l'intelligence artificielle et de la robotique qui est contraire au bon sens.

Contrairement aux hypothèses traditionnelles, les capacités d'intelligence de haut niveau propres aux humains ne nécessitent que très peu de puissance de calcul, comme le raisonnement, mais des compétences inconscientes. et l'intuition nécessitent beaucoup de puissance de calcul) est encore plus évident dans le domaine de la cybersécurité.

L'application de la technologie de l'intelligence artificielle à la sécurité des réseaux présente les défis suivants : l'espace des problèmes n'est pas fermé, l'espace des échantillons est asymétrique, les résultats d'inférence sont inexacts ou ininterprétables, la capacité de généralisation des modèles diminue et les défis d'intégration de la pensée inter-domaines.

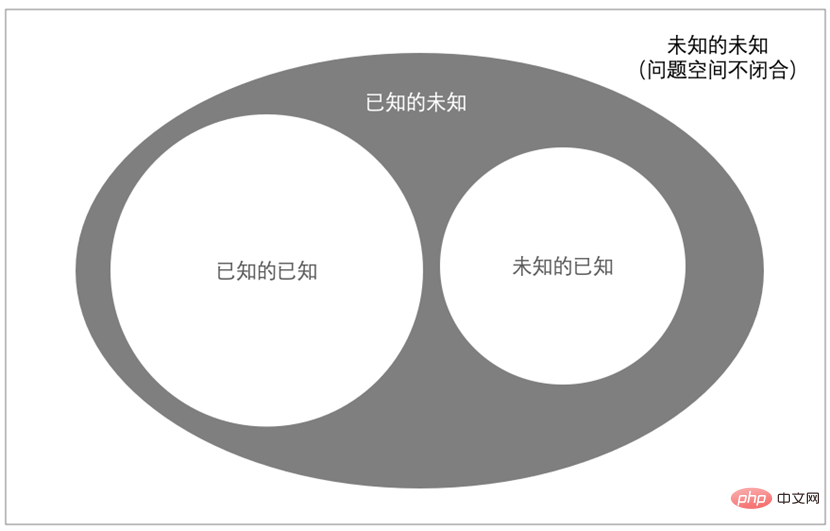

1. L'espace problématique n'est pas fermé

Comme le montre la figure ci-dessus, l'espace problématique de la sécurité réseau comprend les connus et les inconnus. Le connu comprend les connus connus, comme une vulnérabilité connue, et l'inconnu connu, comme une vulnérabilité de sécurité connue et exposée qui n'a pas encore été découverte ; l'inconnu comprend les inconnues connues, comme les systèmes logiciels qui doivent exister une certaine vulnérabilité de sécurité ; , inconnu inconnu, comme simplement ne pas savoir quels risques ou menaces il y aura.

2. Asymétrie de l'espace d'échantillonnage

L'inconnu inconnu est un dilemme inévitable en matière de sécurité des réseaux, qui rend l'espace des problèmes de sécurité des réseaux non fermé, ce qui conduit à un grave manque de données négatives (telles que les données d'attaque, les données de risque, etc. ), ce qui entraîne une asymétrie de l'espace des fonctionnalités, ce qui empêche l'espace des fonctionnalités de représenter véritablement l'espace du problème. Un modèle est une hypothèse sur le monde dans un espace de données existant et est utilisé pour faire des inférences dans un nouvel espace de données. La technologie d'intelligence artificielle actuelle peut très bien résoudre la relation complexe non linéaire entre l'entrée et la sortie, mais elle est sérieusement asymétrique pour l'espace du problème où l'espace échantillon est relativement ouvert.

3. Ininterprétabilité des résultats du raisonnement

Les applications d'intelligence artificielle visent à produire des jugements décisionnels. L’explicabilité fait référence à la mesure dans laquelle les humains peuvent comprendre les raisons des décisions. Plus un modèle d’IA est explicable, plus il est facile pour les gens de comprendre pourquoi certaines décisions ou prédictions ont été prises. L'interprétabilité du modèle fait référence à la compréhension des mécanismes internes du modèle et à la compréhension des résultats du modèle. En phase de modélisation, il aide les développeurs à comprendre le modèle, compare et sélectionne les modèles, et optimise et ajuste le modèle si nécessaire ; en phase opérationnelle, il explique le mécanisme interne du modèle au décideur et explique les résultats du modèle. .

Au stade de la modélisation, la technologie de l'intelligence artificielle présente une contradiction entre l'exactitude des décisions et l'interprétabilité des décisions. Les réseaux de neurones ont une précision de décision élevée mais une interprétabilité médiocre, et les arbres de décision ont une forte interprétabilité mais une faible précision. Bien sûr, il existe déjà des moyens de combiner les deux, pour parvenir dans une certaine mesure à un équilibre entre les deux.

En phase d'exploitation, expliquer au décideur le mécanisme interne du modèle et l'interprétation des résultats de la prise de décision, impliquant des dilemmes éthiques en matière de confidentialité des données, de sécurité du modèle, etc.

4. Déclin de la capacité de généralisation

Dans les années 1960, le modèle de sécurité Bell-LaPadula soulignait que « seulement si le système démarre dans un état sûr et ne tombe jamais dans un état dangereux, il est sûr ».

La technologie de l'intelligence artificielle utilise des modèles pour représenter les espaces problématiques, mais comme l'essence de la sécurité est la confrontation entre les ressources et l'intelligence, l'espace problématique de sécurité n'est jamais fermé. Un modèle qui fonctionne bien sur l'ensemble de formation peut être utilisé à grande échelle. environnements du monde réel. Dès qu'il est mis en ligne, il y a une confrontation constante, puis il continue de tomber dans un état d'échec et la capacité de généralisation du modèle diminue.

5. Modèle d'autonomie de sécurité intelligente

La connaissance et le raisonnement sont la base de l'intelligence humaine. Pour réaliser le raisonnement et la prise de décision, les ordinateurs doivent résoudre trois problèmes : la représentation des connaissances et la forme du raisonnement, la représentation et le raisonnement des connaissances en matière d'incertitude et le bon sens. représentation et raisonnement.

Le jeu de cartes est un jeu d'informations incomplètes. Il est beaucoup plus difficile pour un ordinateur de jouer aux cartes que de jouer aux échecs. En 2017, l'intelligence artificielle a vaincu les humains au poker Texas Hold'em no-limit à 6 joueurs. Les jeux de cartes sont des problèmes probabilistes et déterministes, et l'environnement réel est complètement incertain, voire conflictuel. Par conséquent, la prise de décision autonome dans des environnements complexes est très difficile.

Les défis de la prise de décision autonome dans des scénarios contradictoires proviennent principalement de deux aspects : la dynamique de l'environnement et la complexité de la tâche. La dynamique de l'environnement comprend des conditions incertaines, des informations incomplètes, des changements dynamiques de situations et des jeux en temps réel ; la complexité des tâches comprend la collecte d'informations, l'offensive, la défense, la reconnaissance, le harcèlement, etc.

La prise de décision autonome dans des scénarios de confrontation utilise généralement le bon sens et la déduction logique pour compenser les informations incomplètes, puis génère des plans en intégrant les connaissances du domaine humain et les résultats de l'apprentissage par renforcement pour aider à prendre les bonnes décisions.

La prise de décision autonome dans des environnements complexes doit également résoudre le problème de l'adaptation aux changements environnementaux et apporter des changements décisionnels en conséquence. Par exemple, la conduite autonome peut construire un modèle après avoir identifié des objets et planifier la conduite en temps réel sur cette base, mais il est difficile de faire face aux urgences. Par conséquent, la conduite autonome nécessite également des connaissances et une expérience de conduite, et ces connaissances expérientielles doivent être acquises dans le processus d'interaction continue avec l'environnement, c'est-à-dire l'apprentissage par renforcement.

Par conséquent, la capacité de prise de décision autonome en matière de détection des menaces et de protection d'un système de sécurité intelligemment habilité est l'un des indicateurs clés pour mesurer son intelligence. En se référant à la classification des systèmes de conduite autonome, un modèle intelligent d’autonomie en matière de sécurité peut être construit. Non Autonome

| L1 | Des experts en sécurité assistent | Le système de protection détecte et défend contre les attaques et les menaces connues, optimise le taux de précision, le taux de faux négatifs et le taux de faux positifs, la recherche et le traçage des menaces, etc. les besoins des experts en sécurité le font manuellement. |

| L2 | Partiellement Autonome | Le système de protection détecte et protège les attaques et menaces connues, et peut également percevoir les menaces inconnues. Cependant, l'optimisation du taux de précision, du taux de faux négatifs et de faux positifs, l'analyse des menaces et le traçage des sources, etc. nécessitent un travail manuel de la part de la sécurité. experts. |

L3 |

Autonome conditionnel |

Le système de protection détecte et protège contre les attaques et menaces connues et inconnues, et peut également optimiser en permanence le taux de précision, le taux de faux négatifs et le taux de faux positifs pour lutter contre autonomie Apprentissage et mise à niveau, mais l'analyse des menaces, la recherche des sources, la réponse et d'autres tâches nécessitent un travail manuel de la part d'experts en sécurité. |

L4 |

Très autonome |

Le système de protection complète la détection, la prise de décision, la protection, la recherche et le jugement, la traçabilité, etc. de toutes les attaques et menaces, avec un faible niveau d'intervention et la réponse des experts en sécurité dans le processus. |

L5 |

Complètement autonome |

Le système de protection complète de manière indépendante toutes les attaques et menaces, détection, prise de décision, protection, recherche et jugement, traçabilité, etc., sans l'intervention et la réponse de la sécurité experts tout au long du processus. |

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI